近年来,大型语言模型(LLMs)在处理复杂问题方面展现出惊人潜力,尤其是在“链式思考”(Chain-of-Thought, CoT)推理模式的加持下。这种方法旨在模拟人类的多步骤逻辑思维,让模型逐步分解并解决难题。然而,伴随其快速发展,业界和学术界对LLMs是否真正具备逻辑理解能力,抑或仅仅是巧妙地模仿推理过程,疑虑渐生。

近期来自亚利桑那州立大学的研究人员发布了一项预印本论文,其核心观点直指LLMs的推理能力可能并非其宣称的那般强大,而更像是一种“模拟推理”的“脆弱海市蜃楼”。这项研究深入探讨了当LLMs面临训练数据之外的“域外”(out-of-domain)逻辑问题时,其链式思考推理的表现如何。研究结果令人深思:模型的性能会显著下降,即便只是面对中等程度的数据分布偏移,其“推理”能力也会变得异常脆弱,极易崩溃。

探究LLM的泛化困境

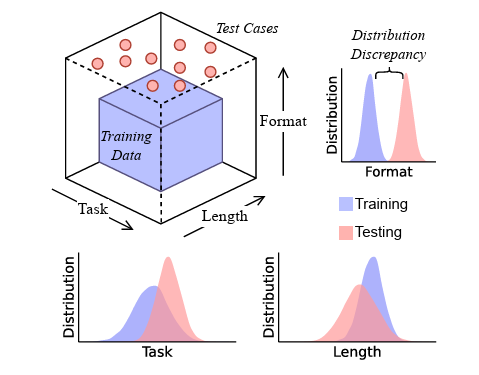

为了客观且可量化地评估LLM的泛化推理能力,研究团队构建了一个名为DataAlchemy的受控训练环境。这个环境允许他们创建小型模型,并对其进行简单文本转换的示例训练,例如ROT密码(一种简单的字母替换密码)和循环移位(将文本字符按顺序移动)。随后,研究人员通过不同顺序和组合的这些转换,进一步训练模型,旨在模拟多种逻辑操作。

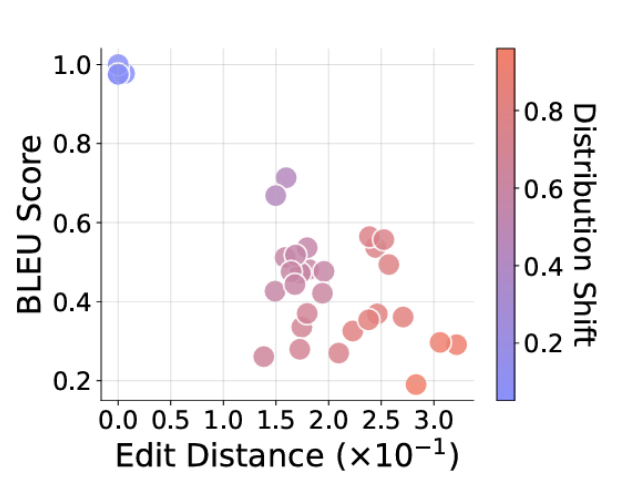

这些经过简化的模型在多类任务中接受了严格测试。部分任务与训练数据中的函数模式精确匹配或高度相似,而另一些则要求模型执行“域外”的函数组合,即那些在训练数据中从未直接出现过的逻辑模式。举例来说,一个模型可能只见过两次循环移位的训练数据,但却被要求执行两次ROT移位,而它仅对单个移位示例有基本认知。研究人员通过BLEU分数和Levenshtein距离等客观指标,对模型的最终答案和推理步骤进行量化评估,以衡量其准确性。

“表象式”推理的瓦解

实验结果验证了研究人员的假设:当这些基础模型被要求泛化执行训练数据中未直接展示的全新转换序列时,它们的性能会灾难性地失败。值得注意的是,模型常常会尝试根据训练数据中相似模式来推断新的逻辑规则,但这种尝试往往导致模型输出“正确的推理路径,但答案却是错误的”。更有甚者,有时LLM会偶然得出正确答案,但其背后却是“不忠实的推理路径”,即逻辑上并不连贯的思考过程。

这进一步印证了研究团队的观点:“在任务转换下,CoT推理似乎反映的是对训练期间所学模式的复制,而非对文本的真正理解。”这种现象表明,LLMs在处理新颖或未曾见过的逻辑组合时,缺乏深层的抽象推理能力,更多地依赖于对现有模式的浅层匹配与复制。

研究还发现,即使输入文本字符串的长度略微偏离训练数据,或者任务所需的函数链长度与训练数据不同,模型的准确性也会“随着差异的增加而下降”,这清晰地指明了模型泛化能力的缺失。此外,测试任务格式中哪怕是微小且不为模型所熟悉的差异(例如引入训练数据中未出现的字母或符号),也会导致模型性能“急剧下降”,并“影响”其响应的正确性。这些细微的扰动足以揭示LLM在逻辑推理方面的脆弱性。

超越“流畅的胡言乱语”:对真实理解的追求

尽管通过监督微调(SFT)引入少量相关数据通常能显著改善这种“域外”模型性能,但研究人员强调,这种修补策略“不应被误认为是实现了真正的泛化能力”。他们指出,依赖SFT来弥补每一个“域外”失败,是一种不可持续且被动的策略,未能解决核心问题:模型缺乏抽象推理能力。这提醒我们,SFT更多是提高模型在特定新任务上的表现,而非赋予其普遍的逻辑推理能力。

这些链式思考模型,与其说是具备了广义逻辑推理能力,不如说是“一种复杂的结构化模式匹配形式”。当其被稍微推离训练数据分布时,性能便会“显著下降”。更令人担忧的是,这些模型生成“流畅的胡言乱语”的能力,在缺乏仔细审计的情况下,很容易营造出一种“虚假的可靠性光环”。这种流畅但不准确的输出,尤其在高风险领域如医疗、金融或法律分析中,可能带来严重后果。

因此,研究人员强烈警告,不要将链式思考风格的输出等同于人类思维,尤其是在那些关键且容错率极低的领域。他们呼吁,当前的测试和基准应优先关注那些超出任何训练数据集的任务,以深入探测这类错误。展望未来,大语言模型需要超越“表面层面的模式识别”,才能真正展现出更深层次的推理能力。这要求研究者们探索全新的架构和训练范式,以期达到真正的认知理解和泛化能力,而非仅仅是其巧妙的模拟。