AI智能体:驱动未来商业变革的核心引擎

当前,人工智能正经历着前所未有的发展浪潮,其中AI智能体作为一种能够自主感知、决策并执行任务的智能系统,正逐渐成为重塑各行各业的关键力量。它们不再仅仅是静态的算法或模型,而是具备独立行动能力、能够与环境交互并不断学习进化的实体。从智能客服到自动化运营,从个性化推荐到复杂的供应链优化,AI智能体以其高效、精准的特性,为企业带来了颠覆性的增长机遇。然而,随着智能体应用场景的日益广泛和复杂,如何确保这些智能体的行为符合预期、保障其运行安全并符合伦理规范,已成为摆在所有企业面前的严峻挑战。构建一个可信赖的AI智能体生态,是释放其巨大潜力的前提。

构建信任的基石:AI智能体为何需要“安全蓝图”?

如同任何强大的技术,AI智能体在带来便利的同时,也伴随着潜在的风险。这些风险不仅限于技术层面,更涵盖了伦理、社会和法律等多重维度。一个不受控或设计缺陷的智能体,可能导致数据泄露、决策偏颇、系统漏洞,甚至引发难以预料的社会负面影响。因此,企业在部署AI智能体之前,必须有一套周密且系统的“安全蓝图”,将安全性、可靠性和可治理性融入到智能体生命周期的每一个环节。

这套蓝图的核心在于建立一个分层、迭代的保障体系,确保智能体从诞生之初到持续运行,始终处于可控和可信的状态。它要求我们超越单一的技术关注点,转而从整体视角审视智能体带来的全面挑战。这不仅仅是技术部门的职责,更是需要跨部门协作、高层领导重视的企业级战略。

安全为先:从数据到模型的全链路防护策略

AI智能体的安全防护是一个多层次、全方位的系统工程,涵盖了从数据输入、模型训练、部署到运行的整个流程。

1. 数据安全与隐私保护

AI智能体的智能来源于数据,因此数据是其安全的基石。企业必须确保训练和运行时数据的机密性、完整性和可用性。这意味着要实施严格的数据访问控制、数据加密、匿名化和去标识化技术,以防止敏感信息泄露。同时,应建立健全的数据溯源机制,确保数据的来源合法合规,并能有效应对数据投毒等恶意攻击,防止智能体因输入虚假或被篡改的数据而产生错误或有害行为。

2. 模型安全与弹性

AI模型是智能体的“大脑”,其安全性直接决定了智能体的可靠性。模型面临的威胁包括对抗性攻击(如通过微小扰动误导模型决策)、模型窃取、后门攻击和模型漂移(模型性能随时间推移而下降)。为应对这些挑战,企业应采用鲁棒性训练方法增强模型对对抗性攻击的抵抗力;部署模型水印或加密技术保护知识产权;实施持续的模型监控和再训练机制,及时发现并纠正模型性能下降或异常行为,确保其在动态环境中的稳定性和准确性。

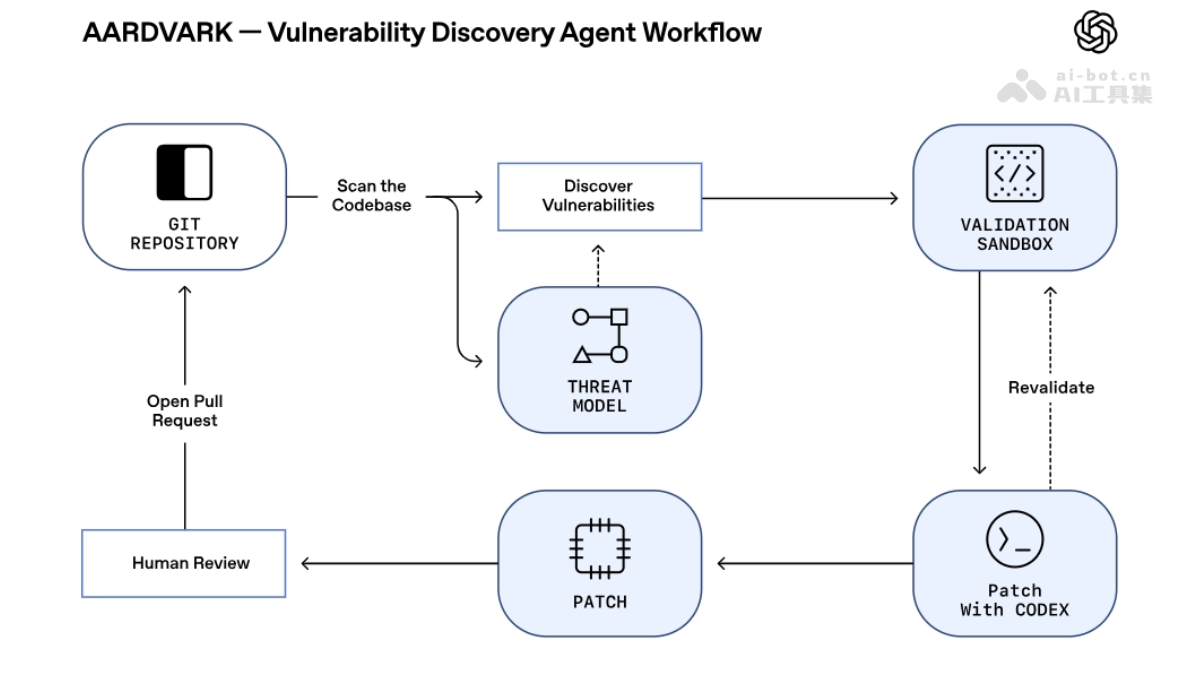

3. 系统集成与基础设施安全

AI智能体通常作为更大系统的一部分运行,其与现有系统、API和云服务的集成点是潜在的攻击面。企业需要确保API接口的认证授权机制健壮,采用最小权限原则,并对智能体的运行环境进行隔离和沙箱化。基础设施层面的安全防护,如网络防火墙、入侵检测系统、漏洞管理和安全补丁更新,也是构建整体安全屏障不可或缺的部分。所有这些措施旨在创建一个多维度、纵深防御的安全体系,有效抵御来自内外部的各种威胁。

伦理与社会影响:不止于技术考量

AI智能体的伦理问题日益凸显,其决策可能对个体和社会产生深远影响。构建可信赖智能体,要求企业将伦理原则深度融入到技术设计与开发中。

1. 公平性与偏见消除

智能体在训练数据中可能学习到人类社会的偏见,导致在招聘、贷款审批、司法判决等关键领域产生歧视性结果。企业必须主动识别和消除数据中的偏见,采用公平性评估工具和算法去偏差技术,确保智能体在不同群体面前都能提供公平、公正的服务。这需要对训练数据进行细致的审计和平衡,并在模型设计阶段引入公平性约束。

2. 透明度与可解释性

“黑箱”式的AI决策模式难以被用户和监管机构接受。企业应努力提升智能体决策的透明度和可解释性,采用XAI(可解释AI)技术,如LIME、SHAP等,帮助用户理解智能体做出特定决策的原因。这不仅能增强用户信任,也有助于在出现问题时进行归因和调试,确保智能体的行为是可理解和可审计的。

3. 社会责任与合规性

企业有责任确保其AI智能体的部署符合所有适用的法律法规(如GDPR、CCPA等)和行业标准。这包括数据隐私保护、用户知情同意、儿童保护以及反歧视等。同时,企业应积极预测并评估智能体可能带来的社会影响,例如对就业市场的影响或滥用风险,并制定相应的缓解策略。建立内部伦理委员会或审查流程,确保智能体的设计和部署始终遵循最高的社会责任标准。

治理框架:实现智能体的有效管理与控制

完善的治理框架是实现AI智能体可信赖运行的保障。它提供了一套系统的规则、流程和责任机制。

1. 全生命周期管理

AI智能体的治理贯穿其整个生命周期:从需求分析、设计、开发、测试、部署、运行到最终退役。每个阶段都应有明确的审查点、风险评估和批准流程。例如,在设计阶段就需考虑安全和伦理要求;在开发阶段实施安全编码规范和版本控制;在部署前进行严格的测试和验证;在运行中进行持续监控和性能评估;在退役时确保数据和模型的妥善处理,防止遗留风险。

2. 风险评估与缓解机制

企业应建立一套动态的AI风险评估框架,识别、分析和量化智能体可能带来的潜在风险,包括技术风险、操作风险、伦理风险和声誉风险。针对识别出的风险,需要制定明确的缓解策略和应急响应预案。这包括建立智能体安全事件报告和响应流程,以及定期的风险审查和审计,确保风险管理措施的有效性和及时性。

3. 合规性与审计

随着AI监管法规的不断出台,企业必须确保其AI智能体完全符合最新的法律法规要求。这需要内部合规团队与外部法律顾问紧密合作,持续跟踪法规变化,并及时调整内部策略。同时,应建立完善的审计追踪能力,记录智能体的所有关键决策、数据流和操作日志,以便在需要时进行内部审计或接受外部监管机构的审查,证明智能体行为的合法性和透明度。

“智能体工厂”模式:企业级实践的范本

为系统性解决上述挑战,领先的企业和技术提供商正在探索和实践“智能体工厂”(Agent Factory)模式。这种模式提供了一个标准化的、可重复的、高度受控的环境,用于设计、构建、测试和部署AI智能体。其核心理念是将智能体开发视为一个工业化流程,通过整合先进的安全、治理和伦理工具,确保每个产出的智能体都符合预设的信任标准。

例如,在“智能体工厂”中,开发者可以访问预配置的安全模块、伦理审查工具和合规性检查列表,确保从编码之初就将信任融入智能体的基因。平台能够提供:

- 标准化的开发流程:通过定义统一的开发规范、代码库和测试框架,降低人为错误和安全漏洞的风险。

- 内置的安全与治理工具:自动化地执行安全扫描、漏洞检测和偏见评估,并在智能体生命周期的关键节点进行强制性的伦理审查。

- 持续的验证与监控:部署实时监控系统,追踪智能体的性能、行为和潜在风险,一旦发现异常,能自动触发告警并启动应对机制。

- 知识共享与协作:建立一个知识库,分享最佳实践、成功案例和教训,促进团队内部在AI安全和治理方面的共同成长。

这种“工厂”模式使得企业能够以更快的速度、更高的质量、更低的风险规模化地构建和部署AI智能体,从而在激烈的市场竞争中保持领先地位,同时坚守负责任创新的承诺。

展望未来:通向更智能、更负责任的AI时代

AI智能体技术的发展永无止境,而构建可信赖的智能体生态也并非一劳永逸的任务。它需要企业保持敏锐的洞察力,持续关注技术前沿、伦理讨论和法规演变,并不断调整优化自身的策略和实践。未来的AI智能体将更加智能、自主,但也对信任和治理提出了更高的要求。我们需积极拥抱人机协作的模式,将人类的伦理判断和监督融入智能体的决策循环中,确保最终控制权始终掌握在人类手中。

通过采纳“智能体工厂”等先进理念,并将其落地为具体的实践,企业不仅能够驾驭AI智能体带来的巨大商业价值,更能在全球范围内树立负责任AI的典范。这是一个充满挑战但也充满机遇的时代,而构建可信赖的AI智能体,正是我们迈向更智能、更公平、更可持续的未来的关键一步。