阿里云Wan2.2-Animate:开源动作生成模型如何定义未来内容创作

一、引言:智能动效的开放新篇章

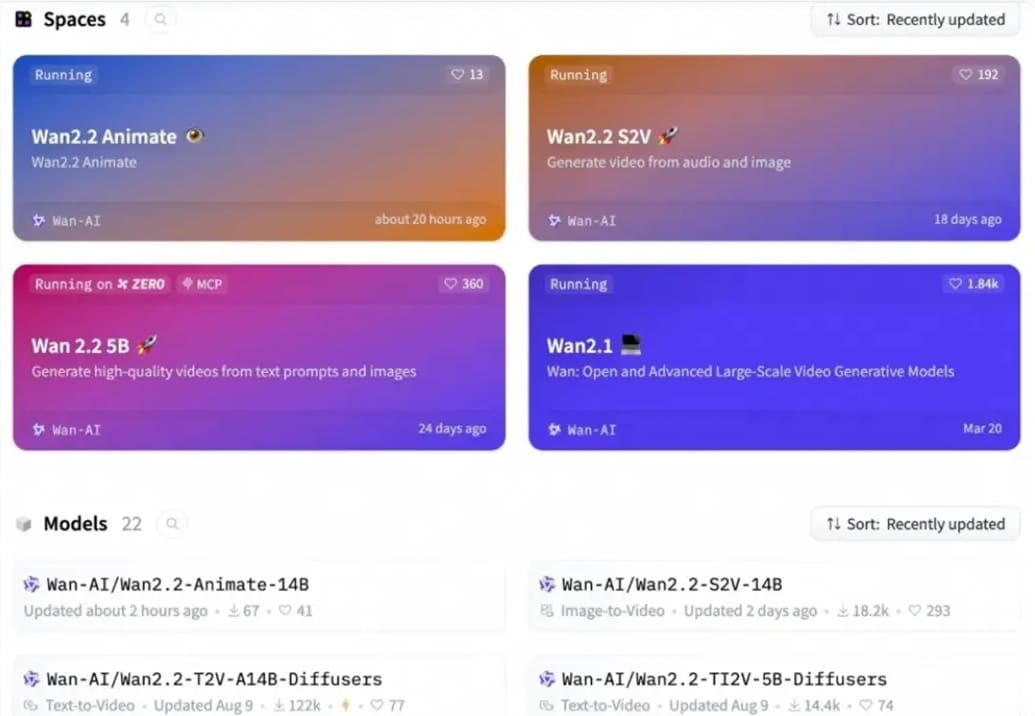

在人工智能飞速发展的时代,内容创作正经历一场由AI驱动的深刻变革。特别是视频内容的生成,其复杂性与对细节的极致要求,一直是技术攻坚的重点。近日,阿里云通义万相团队正式宣布其新一代动作生成模型Wan2.2-Animate全面开源,无疑为这一领域注入了强大的创新活力。这款模型不仅继承并超越了现有技术,更以其卓越的性能和灵活的应用模式,预示着短视频制作、虚拟偶像动效、动漫角色驱动等多个垂直领域即将迎来效率与质量的双重提升。通过GitHub、HuggingFace和魔搭社区的开放访问,以及阿里云百炼平台和通义万相官网的便捷体验,Wan2.2-Animate正逐步成为广大开发者和内容创作者手中的利器,共同书写智能动效的新篇章。

二、技术核心:双模式驱动与精细化生成策略

Wan2.2-Animate模型是在前代Animate Anyone模型基础上进行了一系列深度优化与升级的结晶。其核心技术创新体现在两大应用模式上:动作模仿与角色扮演,以及支撑这些模式的高级生成策略。

2.1 动作模仿:赋予静态图像以动态生命

在动作模仿模式下,用户只需提供一张静态的角色图片和一段参考视频。模型便能精确地捕捉参考视频中角色的肢体动作、面部表情乃至细微神态,并将其无缝地迁移到用户提供的图片角色上。这不仅仅是简单的动作复制,更是对角色形象与动作风格的智能融合,确保新生成的动态内容在视觉上高度协调且富有表现力。这种能力对于快速生成个性化动画、舞蹈视频,甚至为数字人创建复杂行为模式具有革命性意义。它极大地降低了传统动画制作中关键帧设定和骨骼绑定的门槛,使得动态内容的生产变得更加高效与普惠。

2.2 角色扮演:在保持原貌中实现角色替换

角色扮演模式则提供了另一种强大的创作维度。在此模式下,Wan2.2-Animate能够在保持原始视频的动作序列、表情细节及环境背景不变的前提下,将视频中的原角色替换为用户指定的角色。这意味着创作者可以轻松地将自己的虚拟形象或特定角色植入到任何现有的视频场景中,而无需重新拍摄或进行复杂的后期处理。无论是为电影预告片中的角色进行快速试演,还是为教育视频中的讲解员替换为虚拟教师,亦或是为营销广告中的产品代言人进行形象定制,角色扮演模式都展现出巨大的实用价值,为内容的快速迭代与个性化定制提供了前所未有的自由度。

三、深度解析:支撑卓越性能的创新技术栈

Wan2.2-Animate之所以能在人物一致性和生成质量方面取得显著提升,离不开其背后精心设计的一系列技术栈。

3.1 大规模数据集与统一表示学习

通义万相团队为Wan2.2-Animate构建了一个空前规模的人物视频数据集。该数据集全面涵盖了人类日常交流中的各种元素,包括说话时的唇形变化、丰富多样的面部表情以及流畅自然的身体动作。通过利用通义万相自有的图生视频模型进行后续的强化训练,极大地提升了模型对动态行为的理解能力和生成质量。更关键的是,Wan2.2-Animate在设计上实现了角色信息、环境上下文以及动作指令的统一表示格式。这种规范化处理使得模型能够无缝兼容动作模仿和角色扮演这两种推理模式,同时确保了生成内容的内在逻辑与视觉连贯性。

3.2 骨骼信号与隐式特征的精细化融合

为了实现高精度的动作与表情复刻,Wan2.2-Animate采用了分层且精细化的处理机制。针对身体运动,模型巧妙地利用了骨骼信号。骨骼点作为人体结构的关键特征,能够提供清晰且结构化的动作轨迹信息。通过对这些骨骼信号的精确提取与重定向,模型能够确保生成角色的身体动作与参考视频保持高度一致,避免了常见的扭曲或不自然现象。

而对于面部表情的捕捉,模型则侧重于隐式特征的挖掘。面部表情的复杂性远超肢体动作,细微的肌肉运动就能带来截然不同的情感表达。Wan2.2-Animate通过学习和编码这些难以直接量化的隐式特征,结合先进的动作重定向模块,实现了对面部表情的传神复刻,使得生成角色的情绪表达更加生动逼真。这种骨骼信号与隐式特征的结合策略,展现了模型在理解和重构复杂人体动态方面的深厚功力。

3.3 光照融合LoRA:打造真实感视觉体验

在数字内容生成中,光照是决定真实感和沉浸感的关键因素。为了解决生成内容中光照不一致或不自然的问题,Wan2.2-Animate团队特别设计了一个独立的**光照融合LoRA (Low-Rank Adaptation)**模块。这个轻量级但高效的模块,能够在不大幅增加模型复杂度的前提下,对生成角色的光照效果进行精细化调整。它能够智能地分析参考视频或目标环境的光照条件,并将这些光照特性无缝地融入到生成角色上,从而确保角色与背景环境在光影表现上达到完美的统一,极大地增强了视觉的真实感和沉浸式体验。

四、性能卓越:超越现有标杆的创新突破

在严格的性能评估中,Wan2.2-Animate展现出了令人印象深刻的卓越实力。在视频生成质量、主体一致性以及感知损失等一系列关键指标上,它显著超越了诸多业界知名的开源模型,例如StableAnimator和LivePortrait。这意味着在确保生成视频流畅、自然的同时,Wan2.2-Animate能够更好地保持角色的身份特征,减少视觉上的不一致或闪烁感。

尤为值得关注的是,在用户主观评测环节,Wan2.2-Animate的表现甚至超越了某些闭源的顶尖模型,如Runway Act-two。这种用户体验上的领先,无疑证明了Wan2.2-Animate在实际应用场景中的强大竞争力。其能够生成更为逼真、一致且富有表现力的动态内容,为专业内容生产者提供了更为强大的工具,也为普通用户提供了更便捷的创作途径。

五、未来展望:赋能多元化数字内容生态

Wan2.2-Animate的全面开源,不仅仅是技术上的一次飞跃,更是对整个数字内容生态的一次重要赋能。

首先,在短视频和社交媒体领域,创作者可以利用该模型快速生成高质量、个性化的短视频,实现内容创作的自动化和规模化。无论是虚拟网红的舞蹈挑战,还是品牌营销中的定制化动画,都将变得触手可及。

其次,在电影、动漫与游戏制作领域,Wan2.2-Animate有望大幅缩短动画周期,降低制作成本。艺术家可以更专注于创意本身,而将繁琐的动作捕捉与角色驱动交给AI完成,从而加速内容迭代,丰富视觉叙事。

此外,该模型在教育、医疗与虚拟现实等领域也具有广阔的应用前景。例如,在教育场景中,可以创建更具互动性和沉浸感的教学动画;在医疗领域,可以用于康复训练模拟或病理展示;在虚拟现实和元宇宙中,Wan2.2-Animate将能够为虚拟角色提供更加自然、逼真的实时动效,提升用户的沉浸式体验。

六、结论与展望:迈向高效创意的数字未来

阿里云Wan2.2-Animate的开源,是人工智能领域又一里程碑式的事件。它不仅展示了中国AI技术在动作生成领域的领先实力,更通过开放共享的姿态,推动了整个行业的进步。随着更多开发者和研究人员的参与,我们有理由相信,Wan2.2-Animate及其衍生技术将持续演进,不断突破智能动效的边界,最终塑造一个更高效、更富有创意、更具活力的数字内容未来。