近年来,大语言模型(LLM)以其惊人的理解与生成能力,正深刻改变着各行各业。然而,伴随而来的是高昂的计算资源需求和显著的推理延迟,这成为LLM大规模落地和实时应用的主要障碍。为了解决这一核心痛点,业界不断探索创新的加速方案。在这场技术竞赛中,腾讯推出的FastMTP(Fast Multi-Token Prediction)技术,无疑为大语言模型的推理效率提升带来了突破性的解决方案,预示着LLM应用新时代的到来。

FastMTP核心原理:MTP的颠覆式创新

FastMTP的核心在于其对多标记预测(MTP)技术的深刻理解和颠覆性优化。传统的MTP策略通常依赖于多个独立的预测模块并行工作,试图在一次推理中生成多个词元(tokens)。这种方式虽然能提升一定效率,但其内存占用高、模型复杂度增加,且各模块之间缺乏有效的长距离依赖学习,往往导致“草稿”质量不高,降低了整体的接受率。

FastMTP则独辟蹊径,采用了一个共享权重的单一MTP头来递归生成多个标记。这一设计巧妙地将复杂的并行计算简化为连续的、高效的预测过程。通过共享权重,模型被迫学习更通用的、更长距离的依赖关系,显著减少了内存开销,同时也提升了MTP头生成“草稿”的准确性和连贯性。这意味着在主模型验证阶段,接受这些高质量草稿的可能性大大增加,从而实现了端到端推理速度的显著提升。

技术基石:三大支柱构建高效推理

FastMTP的卓越性能并非单一创新所致,而是建立在投机解码(Speculative Decoding)、自蒸馏训练和语言感知词汇压缩这三大核心技术支柱之上,协同作用,共同构建了一个高效、稳定且质量无损的推理加速框架。

1. 投机解码的巧妙应用:预测与验证的并行艺术

投机解码(Speculative Decoding)是近年来LLM推理加速领域的一项重要突破。其基本思想是“草稿模型先行,主模型批量验证”。具体而言,一个更小、更快的“草稿模型”(在FastMTP中即优化的MTP头)会迅速生成一系列预测的词元序列。随后,这些序列被提交给主语言模型进行一次性批量验证。如果草稿模型预测准确,主模型便可一次性接受多个词元,极大地减少了逐字生成的迭代次数。FastMTP将这一机制发挥到极致,通过优化MTP头,确保草稿模型的预测能力足以支撑高接受率,使得并行处理的效率优势得到最大化。

2. 自蒸馏训练:确保质量与效率的完美平衡

任何推理加速技术都必须以不损害输出质量为前提。FastMTP通过引入自蒸馏训练机制,完美解决了这一难题。它利用强大的主模型作为“教师”,生成高质量的训练数据,然后用这些数据来训练轻量级的MTP头作为“学生”。通过采用指数衰减的加权交叉熵损失函数,MTP头被引导优先学习生成与主模型风格、逻辑和表达高度一致的草稿。这种训练方式使得MTP头在生成候选词元时,能够精准地模仿主模型的决策模式,从而在投机解码阶段,主模型能够以更高的概率接受MTP头生成的草稿。这不仅保证了加速后的模型输出质量与原始主模型无异,还在训练过程中强化了MTP头对长距离依赖关系的学习能力。

3. 语言感知词汇压缩:智能筛选,精简计算

在大语言模型中,词汇表(vocabulary)通常非常庞大,这在进行词元预测时需要巨大的计算量。FastMTP引入了语言感知词汇压缩技术,以一种智能且动态的方式优化了这一过程。在草稿生成阶段,MTP头会根据当前的输入语境和语言特性,判断并只计算高频词汇的logits(即预测概率),从而显著减少了不必要的计算。例如,在中文语境下,它会优先考虑常用字词的组合;在特定领域,则会关注该领域的专业词汇。而在最终的验证阶段,主模型仍然会使用完整的词汇表进行精确校对,确保最终输出的准确性不受影响。这种“粗略预测,精确验证”的策略,实现了在不牺牲输出质量的前提下,最大限度地降低了计算负载和内存消耗。

FastMTP带来的变革性优势与深远影响

FastMTP的诞生,不仅仅是简单的速度提升,它为大语言模型的实际部署和广泛应用带来了多维度、变革性的优势。

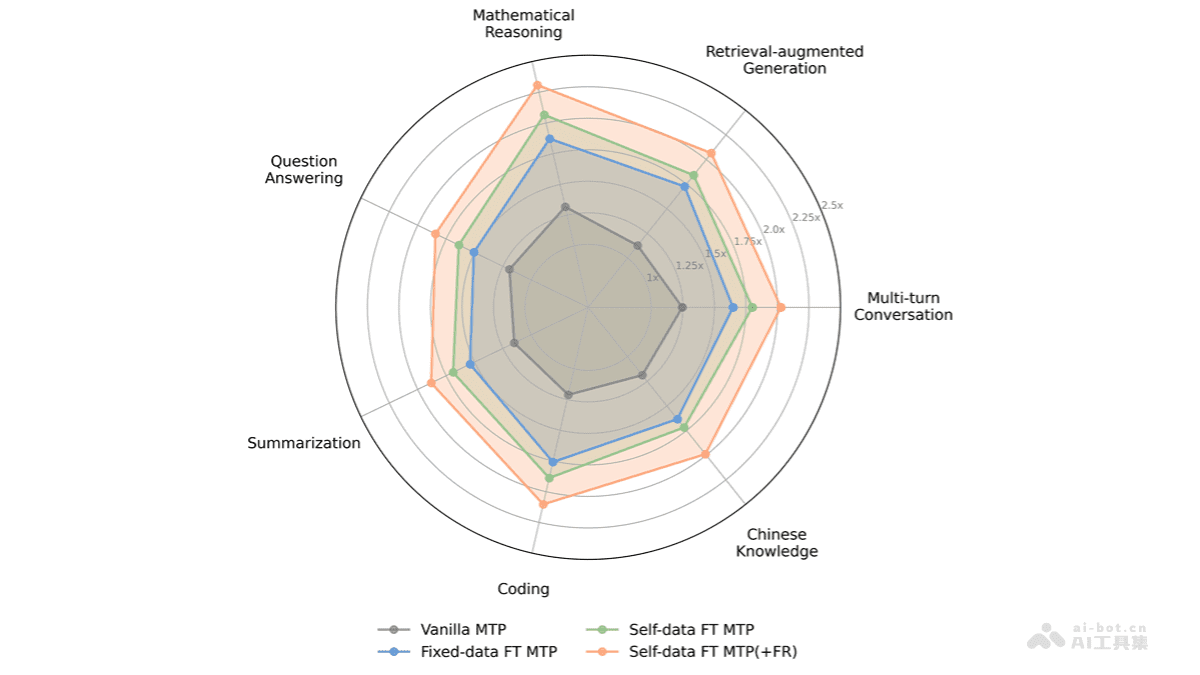

首先,显著加速LLM推理是其最直观的优势。平均2.03倍的提速意味着在相同的硬件条件下,LLM能够处理两倍以上的信息量,或者以更低的延迟响应用户请求。这对于追求实时交互体验的AI应用至关重要,如智能客服、实时内容生成等,极大地提升了用户满意度和系统吞吐量。

其次,保持输出质量无损是FastMTP区别于许多牺牲精度换取速度方案的关键点。通过精密的自蒸馏训练和主模型的最终验证机制,FastMTP确保了加速后的模型输出在准确性、逻辑性和流畅性上与原始主模型保持完全一致,消除了用户对“加速是否会降低智能”的顾虑。

再者,易于集成与部署是FastMTP的一大亮点。它不触及主模型的核心架构,只需微调一个小型MTP模块,即可无缝嵌入到现有的大语言模型推理框架中。这种低耦合、高兼容的特性,大大降低了企业和开发者采用新技术的门槛,加速了创新成果从实验室走向生产环境的进程。

最后,降低硬件资源消耗使得高性能LLM不再是少数巨头的专属。通过共享权重的设计和语言感知词汇压缩,FastMTP有效减少了模型的内存占用和计算量。这意味着即便是消费级GPU也能更高效地运行大型模型,降低了对昂贵专业硬件的依赖,为个人开发者和中小型企业提供了更多使用和部署LLM的可能性,进一步推动了AI技术的普及化。

多元化应用场景的深度拓展

FastMTP的这些优势使其在多个关键应用领域展现出巨大的潜力,正在重塑我们与AI交互的方式:

数学推理与科学计算:在处理复杂的数学问题或科学计算任务时,FastMTP能够以极快的速度生成详尽的解题步骤、推导过程或代码片段。这使得AI辅助教学、科研工具或工程计算软件能够提供更即时、更流畅的交互体验,有效缩短了用户获取解决方案的时间。

智能代码生成与辅助编程:对于软件开发者而言,FastMTP能够显著加速代码补全、错误修复、代码重构以及功能模块生成。无论是集成开发环境(IDE)中的实时建议,还是自动化编程工具的后台支持,FastMTP都能帮助开发者以更快的节奏完成编码工作,大幅提升开发效率和质量。

长文本摘要与信息提取:在处理海量新闻、报告、学术论文或会议纪要等长篇幅文本时,FastMTP可以迅速从复杂的语料中提炼出核心观点、关键信息,生成高质量的摘要。这极大地节省了用户阅读和理解信息的时间,尤其适用于商业智能、新闻聚合和内容分析等领域。

多轮对话系统与智能客服:在聊天机器人、智能客服或虚拟助理等需要高度实时交互的场景中,FastMTP的加速能力尤为关键。它能够实现秒级甚至毫秒级的响应,让对话流程更为自然、流畅,显著提升用户体验,避免因等待造成的交互中断和用户流失。这对于构建高效、人性化的智能交互界面具有里程碑式的意义。

创意内容生成:在广告文案、营销邮件、剧本创作等创意领域,FastMTP能够更快速地迭代生成多种风格和内容的草稿,为创作者提供丰富的灵感和素材,极大地缩短了创作周期。

展望未来:FastMTP如何定义LLM推理新范式

FastMTP的出现,不仅是腾讯在LLM领域技术实力的体现,更是对整个AI生态的一次重要贡献。它清晰地表明,大语言模型的高效运行并非遥不可及,通过精妙的算法设计和系统优化,我们可以在不牺牲模型智能的前提下,实现性能的飞跃。随着FastMTP这样的加速技术不断成熟和普及,未来的大语言模型将不再受限于云端高性能计算集群,而是能够更广泛地部署到边缘设备、个人电脑乃至移动终端上,让AI的强大能力触手可及。

可以预见,FastMTP及其同类技术将推动LLM从“可用”走向“普惠”。它将赋能更多的创新应用,让AI真正融入人们的日常生活和工作中,成为提升生产力、激发创造力的强大引擎。我们期待看到FastMTP在未来的发展中,能够与其他前沿技术(如模型量化、硬件加速器设计)相结合,共同开创大语言模型推理效率的新纪元,解锁AI技术的无限可能。