即便英伟达的市值已突破四万亿美元大关,我们对它的战略深度和长期野心,可能仍存在显著的低估。这家公司早已不再仅仅是那个提供“核弹级”GPU的硬件制造商,其在人工智能时代构筑云平台的宏伟蓝图,正以一种更为隐蔽却深刻的方式悄然展开。

DGX Cloud的崛起与战略性退场

2023年,英伟达高调推出了DGX Cloud,一台实例配备八块H100,月租高达36999美元,其定价策略直指行业天花板,被外界解读为英伟达向AWS、Azure等老牌云服务商发起直接挑战的信号。在当时的“GPU荒”背景下,企业对高端算力需求迫切,DGX Cloud一度炙手可热,推动英伟达软件与服务收入在2024年底达到20亿美元的年化水平。

然而,市场环境的变化使得DGX Cloud的初期优势逐渐消退。2024年下半年,随着GPU供应的逐步缓解,亚马逊AWS等云厂商迅速调整策略,将H100和A100实例的租赁价格大幅下调,降幅高达45%,使得DGX Cloud高昂的租赁费用失去了市场竞争力。对于寻求成本效益的客户而言,DGX Cloud的“紧缺溢价”不复存在。

更深层次的问题在于渠道冲突。亚马逊、微软和谷歌不仅是英伟达GPU最大的采购方,也是其营收的重要支柱。DGX Cloud的直接客户模式,意味着英伟达在与这些至关重要的合作伙伴争夺市场,每一份DGX Cloud的合同,都可能直接挤压AWS、Azure或GCP的潜在收入。这种直接竞争不可避免地引发了合作伙伴的担忧,并促使它们加大对自研AI芯片(如AWS的Trainium、谷歌的TPU)的投入,以降低对英伟达的结构性依赖,长远来看可能对英伟达的芯片销售构成威胁。

此外,DGX Cloud在短时间内难以建立起稳定的客户黏性。部分企业将其视为应急方案,在项目启动初期或算力紧缺时段租赁数月,一旦产能恢复或项目过渡,便会选择迁回其长期合作的云平台。这种模式限制了DGX Cloud作为核心云服务产品的发展潜力。

综合考量这些因素,英伟达在最新的财报披露中,不再将巨额的云支出承诺明确归于DGX Cloud。这项服务虽然仍在收入类别中,但其定位已明显转向内部基础设施与研发用途,不再是面向企业市场的主打产品。这意味着DGX Cloud并非完全消失,而是从一个对外竞争的产品,策略性地退居幕后,成为英伟达内部研发和优化的支撑力量。这标志着英伟达在云计算领域的战略重心发生了显著转移,从直接提供云服务转向构建更为广阔的生态系统。

独特的“朋友圈”与生态构建

DGX Cloud的策略调整,绝不意味着英伟达放弃了在云计算领域的雄心。相反,它选择了另一种更为巧妙的路径:通过构建一个紧密的云服务商“朋友圈”,实现间接但更深远的控制。在过去两年里,英伟达采取了一种看似“匪夷所思”的操作模式——它不仅将GPU出售给云伙伴,甚至再从这些伙伴那里租赁回算力。

以CoreWeave为例,英伟达在2023年对其投资1亿美元,并优先为其供货H100 GPU。在GPU供不应求的时期,这使得CoreWeave成为少数能够大规模提供英伟达GPU的云服务商。令人称奇的是,英伟达随后又反过来从CoreWeave租赁这些GPU。这种策略同样复制到了Lambda等规模较小的GPU云服务提供商身上。例如,2025年9月,英伟达与Lambda签订了一份价值15亿美元、为期四年的租赁协议,其中包括租回1万台搭载自家顶级GPU服务器,总价值约13亿美元。通过这笔交易,英伟达成为了Lambda最大的客户,而这些租赁回来的GPU主要用于其内部研发团队的模型训练。

这种操作模式展现了英伟达在财务工程上的精妙之处:芯片售出的那一刻,收入立即计入英伟达的账面,确保了财报的亮眼和股东的满意;而租赁支出则后置,租金在未来几年内慢慢摊销,转化为运营成本。与此同时,英伟达无需自建庞大的数据中心,最大限度地降低了资产压力。对于其合作伙伴而言,英伟达成了最大的“甲方”,算力与现金流的绑定,极大强化了它们与英伟达生态的黏性。更重要的是,这种回租行为相当于为AI算力市场行情进行了一次强有力的“背书”,锚定了价格预期,稳定了市场心理,可谓一石三鸟。

通过这种“卖芯片-投资客户-租回服务-再次卖芯片”的自循环模式,英伟达成功构建了一个强大的AI芯片生态资金链。此外,英伟达还通过旗下的风险投资部门Nventures,在更广泛的AI生态中进行战略布局,投资了众多模型开发和应用层的初创公司。这些投资的逻辑高度一致:通过资本绑定潜在客户和未来生态,确保这些初创公司一旦成长壮大,其算力需求最终都会转化为对英伟达芯片的采购。可以说,英伟达不仅是在销售芯片,更像是在运营一个庞大的AI创业孵化器,精心打造一套以英伟达为核心的云生态系统。

Lepton:AI算力的“App Store”构想

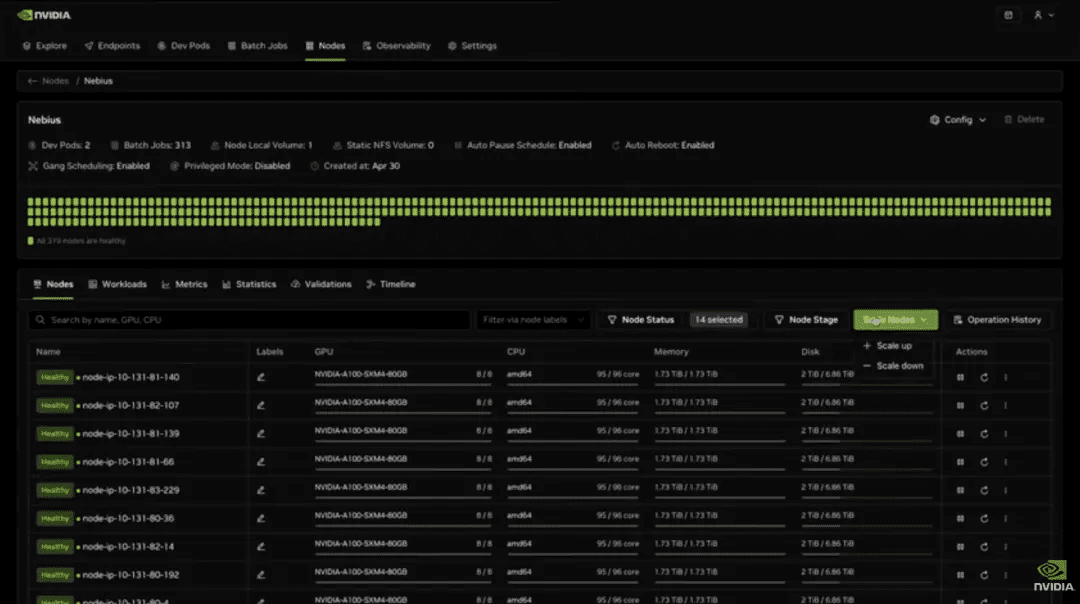

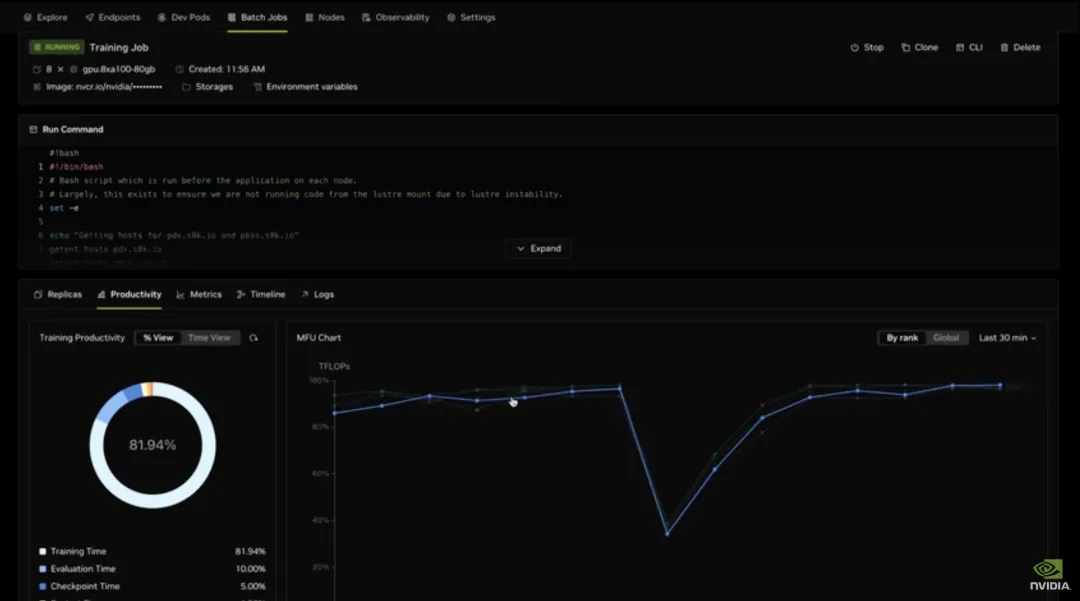

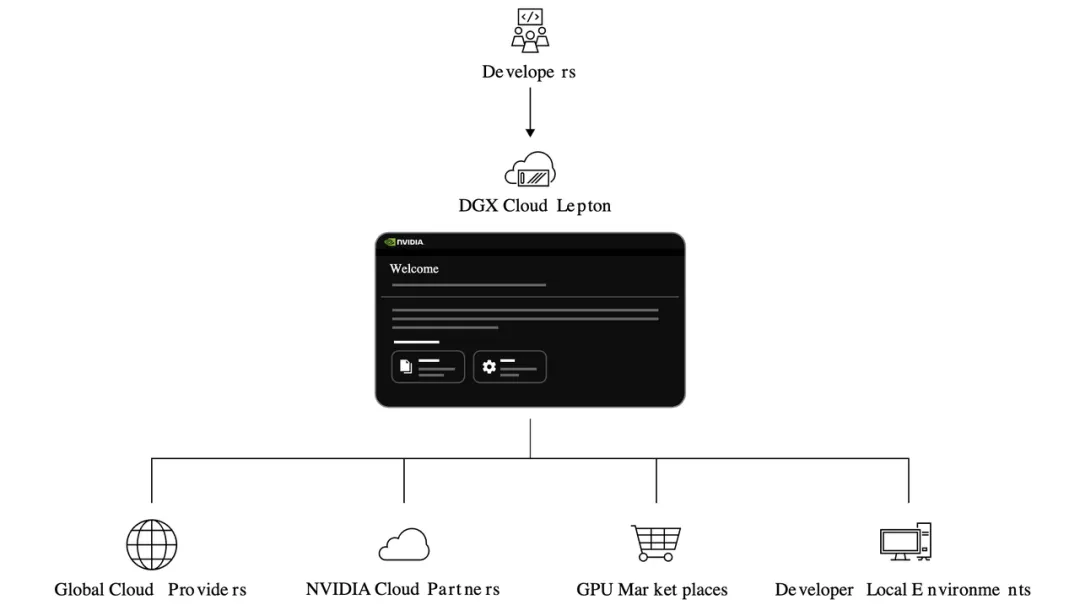

在DGX Cloud战略性退场后,英伟达将外部注意力引向了其2025年5月发布的新平台——Lepton。与DGX Cloud直接出租英伟达自有算力不同,Lepton扮演的角色更像是一个算力市场的“做市商”和“流量调度者”。它不直接持有GPU库存,而是负责将客户的算力需求,智能分发给其生态合作伙伴的数据中心,这包括AWS、Azure等主流云服务商,以及英伟达一手扶持的CoreWeave和Lambda等。

Lepton的本质是一个算力市场,用户只需在该平台提交具体需求,Lepton便能自动匹配并分配到可用的H100或Blackwell GPU资源。这些硬件资源可能分布在不同的云服务商机房,但Lepton通过整合,为开发者提供了统一的开发体验和环境,所有GPU云资源都在英伟达的软件栈(如NIM微服务和NeMo框架)之下运行,开发者无需关心底层硬件的具体提供商。

Lepton策略的关键在于,它巧妙化解了英伟达与云巨头之间的直接竞争。在这种模式下,英伟达不再是AWS、Azure的直接竞争对手,而是转变为一个中立的算力调度平台。AWS和微软等公司也乐于加入Lepton,因为通过这个市场,它们能够接触到额外的算力需求,扩大自身的客户基础。对于英伟达而言,与合作伙伴正面冲突的风险巨大,不如退居幕后,专注于成为算力市场的调度者和掌控者。这正是典型的“退一步,海阔天空”策略,既避免了冒犯合作伙伴,又通过掌控生态入口,确保无论客户选择哪家云服务商,最终都离不开英伟达的GPU硬件和软件栈。

放弃直接构建“英伟达云”,并非软弱的表现,Lepton对英伟达而言是一个鱼与熊掌兼得的策略。它看似只是一个GPU聚合市场,实则旨在成为全球AI算力世界的控制面板。通过Lepton,英伟达掌握了算力订单的分配权,决定了谁能接到业务,谁能在市场中生存。更长远的收益体现在数据和感知层面。Lepton在跨云调度过程中,能够天然地观察到哪类任务最活跃、哪些地域算力更为紧张、哪一代GPU使用频率最高、价格弹性如何等关键市场信息,这些宝贵的数据将反过来辅助英伟达的商业决策和产品迭代。

英伟达试图通过Lepton,实现如同苹果通过App Store掌控移动互联网生态的壮举,只不过其对象从应用程序转换为了算力。对开发者来说,“在哪里算”变得次要,而“能不能算、多久能算、成本如何”才是核心,Lepton正是致力于统一并优化这些体验层面。英伟达不再需要拥有实体云服务,它只需要拥有核心的算力栈和需求入口。只要全球AI训练与推理依然以其GPU为核心,无论算力最终由亚马逊AWS、微软Azure、谷歌GCP,还是CoreWeave、Lambda提供,无论客户最终选择哪家,只要英伟达掌控了价值链的核心环节,它就能持续获得巨大的价值。

从AI芯片的硬件优势,到DGX Cloud的初期尝试,再到如今Lepton平台的推出,英伟达的战略已然从单纯的硬件销售,逐步演进到对“算力”和“平台”的全面控制阶段。任何一家市值突破四万亿美元、其产品已然成为AI时代核心生产资料的公司,其野心绝不可能止步于此。英伟达正通过这种精巧的布局,稳固并扩张其在未来AI世界的霸主地位,其对整个行业的影响力,我们可能才刚刚开始领会其深远程度。