在人工智能技术快速发展的今天,边缘计算与AI的结合正成为行业关注的焦点。LiquidAI近期发布的Liquid Nanos系列轻量级AI模型,正是这一趋势的重要体现。这一系列专为边缘设备设计的模型,为开发者提供了在资源受限环境下实现复杂AI功能的新可能。

边缘计算与AI的完美融合

边缘计算作为云计算的重要补充,将计算能力下沉到数据产生的源头,具有低延迟、高隐私保护、带宽节省等优势。然而,边缘设备通常计算资源有限,如何高效部署AI模型一直是行业面临的挑战。Liquid Nanos系列模型的出现,正是为了解决这一痛点。

Liquid Nanos系列模型专为树莓派等小型设备设计,能够在资源受限的环境中高效运行。这一突破意味着,未来的智能设备将不再依赖云端处理,而是能够在本地完成复杂的AI任务,从而实现真正的边缘智能。

多样化的应用场景覆盖

Liquid Nanos系列模型涵盖了五大核心应用场景,为不同需求的开发者提供了灵活的选择:

- 翻译模型:提供高质量的跨语言翻译能力,支持多种语言对之间的实时翻译。

- 抽取模型:能够从非结构化数据中提取关键信息,适用于信息检索和数据处理场景。

- RAG模型:结合检索增强生成技术,提高AI回答的准确性和可靠性。

- 工具调用模型:使AI系统能够调用外部工具和API,扩展功能边界。

- 数学推理模型:提供强大的数学计算和逻辑推理能力,适用于科学计算和复杂问题求解。

技术规格与性能优势

Liquid Nanos系列提供两种参数版本:350M和1.2B。这种设计旨在平衡模型性能与资源消耗,满足不同场景的需求。所有模型均支持GGUF量化格式,这一技术显著提高了模型在边缘设备上的运行效率。

GGUF量化格式的采用是Liquid Nanos系列模型的一大亮点。通过量化技术,模型在保持较高性能的同时大幅降低了计算资源需求,使得在树莓派等小型设备上运行复杂AI模型成为可能。这种优化不仅提高了资源利用率,还降低了能耗,符合当前绿色计算的发展趋势。

丰富的模型生态系统

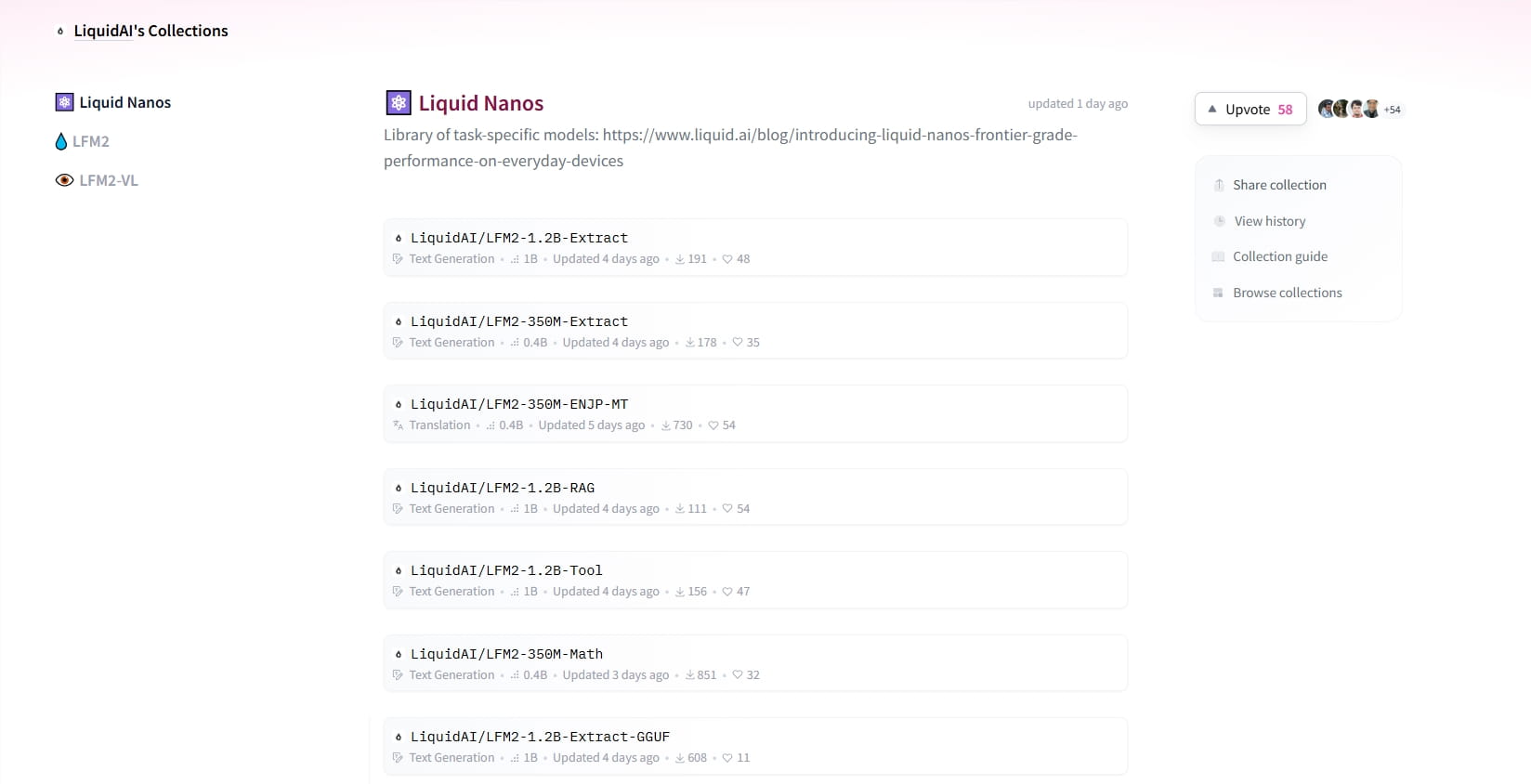

LiquidAI首次推出的12款任务专用模型已在Hugging Face平台上线,形成了完整的模型生态系统。这些模型包括:

- LFM2-350M-ENJP-MT:专业的日英翻译模型

- LFM2-350M/1.2B-Extract:抽取模型,提供信息提取能力

- LFM2-1.2B-RAG:检索增强生成模型

- LFM2-1.2B-Tool:工具调用模型

- LFM2-350M-Math:数学推理模型

这些模型的上线不仅丰富了开发者的工具箱,也为各种实际应用场景提供了强有力的支持。开发者可以根据具体需求选择合适的模型,快速构建AI应用原型。

对边缘计算生态的影响

Liquid Nanos系列的推出标志着边缘计算在AI应用中的进一步发展。其轻量级特性和高效能使其成为开发者和企业进行AI创新的重要工具。具体影响体现在以下几个方面:

1. 降低AI应用门槛

传统上,复杂的AI应用需要强大的计算资源支持,限制了其在边缘设备上的应用。Liquid Nanos系列模型通过优化设计,使得在资源受限的边缘设备上运行AI成为可能,大大降低了AI应用的技术门槛。

2. 促进边缘智能发展

随着物联网设备的普及,边缘智能的需求日益增长。Liquid Nanos系列模型为边缘设备提供了本地AI处理能力,减少了数据传输需求,提高了响应速度,同时增强了数据隐私保护。

3. 推动行业数字化转型

Liquid Nanos系列模型可以应用于多个行业,如智能家居、工业自动化、医疗健康等。通过在边缘设备上部署AI模型,企业可以实现更智能的决策和控制,推动各行业的数字化转型。

实际应用案例分析

智能家居场景

在智能家居系统中,Liquid Nanos的翻译模型可以实现多语言语音助手,让不同语言背景的用户都能自然交互;抽取模型可以从传感器数据中提取关键信息,实现智能环境控制;数学推理模型则可以优化能源使用,提高系统效率。

工业自动化场景

在工业环境中,Liquid Nanos的RAG模型可以结合设备运行数据,提供实时故障诊断和建议;工具调用模型可以与工业设备API集成,实现自动化控制;抽取模型可以从生产日志中提取关键指标,优化生产流程。

医疗健康场景

在医疗健康领域,Liquid Nanos的抽取模型可以从医疗记录中提取关键信息,辅助诊断;数学推理模型可以进行药物相互作用分析,提高用药安全性;翻译模型则可以促进跨国医疗合作,共享医疗知识。

技术创新与未来展望

Liquid Nanos系列模型的技术创新主要体现在以下几个方面:

1. 模型压缩与优化技术

Liquid Nanos系列采用了先进的模型压缩和优化技术,在保持模型性能的同时大幅减小模型体积。这些技术包括知识蒸馏、参数量化、剪枝等,使得模型能够在资源受限的边缘设备上高效运行。

2. 任务专用设计

与通用大模型不同,Liquid Nanos系列模型采用任务专用设计,针对特定应用场景进行优化。这种设计不仅提高了模型在特定任务上的性能,还降低了计算资源需求。

3. 量化格式支持

GGUF量化格式的支持是Liquid Nanos系列模型的一大特色。量化技术通过减少模型参数的精度,大幅降低模型大小和计算复杂度,同时保持较高的性能。这一技术对于边缘计算尤为重要,因为它使得在计算资源有限的设备上运行复杂AI模型成为可能。

开发者生态与社区支持

LiquidAI在Hugging Face平台上开放了Liquid Nanos系列模型,为开发者提供了丰富的资源和工具。开发者可以通过Hugging Face平台轻松访问这些模型,获取模型文档、示例代码和技术支持。这种开放策略有助于快速构建开发者社区,促进技术创新和应用落地。

1. 开发资源

LiquidAI提供了详细的模型文档、API参考和示例代码,帮助开发者快速上手。这些资源涵盖了模型安装、配置、使用和优化等方面,为开发者提供了全方位的支持。

2. 社区互动

通过Hugging Face平台,开发者可以分享使用经验、交流技术问题、提出改进建议。这种社区互动不仅促进了技术交流,还加速了模型迭代和优化。

3. 持续更新

LiquidAI承诺对Liquid Nanos系列模型进行持续更新和优化,根据用户反馈和技术发展不断改进模型性能和功能。这种持续更新的策略确保了模型的长期可用性和竞争力。

行业影响与竞争格局

Liquid Nanos系列的推出对AI边缘计算领域产生了深远影响,改变了行业竞争格局。

1. 技术路线竞争

在边缘AI计算领域,主要存在两种技术路线:一种是基于专用AI芯片的硬件优化,另一种是软件层面的模型优化。Liquid Nanos系列代表了软件优化路线的先进成果,证明了通过模型优化可以在通用硬件上实现高效的边缘AI计算。

2. 市场定位差异化

与专注于云端大模型的AI公司不同,LiquidAI选择了边缘计算这一细分市场,通过轻量级模型实现差异化竞争。这种市场定位使LiquidAI能够在竞争激烈的AI市场中找到自己的位置。

3. 产业生态构建

Liquid Nanos系列的推出不仅是技术创新,更是产业生态的构建。通过开放模型和构建开发者社区,LiquidAI正在推动边缘AI计算产业的发展,形成完整的产业链和创新生态。

挑战与机遇并存

尽管Liquid Nanos系列模型带来了诸多优势,但在实际应用中仍面临一些挑战:

1. 模型性能与资源限制的平衡

如何在保持模型性能的同时进一步降低资源需求,是Liquid Nanos系列模型面临的主要挑战。随着应用场景的复杂化,对模型性能的要求也在不断提高,这需要在模型大小和性能之间找到更好的平衡点。

2. 多样化硬件支持

边缘设备种类繁多,硬件架构各异,如何确保Liquid Nanos系列模型能在不同硬件上高效运行,是一个需要解决的问题。这需要针对不同硬件平台进行优化,提供更广泛的硬件支持。

3. 安全与隐私保护

在边缘设备上运行AI模型,安全与隐私保护尤为重要。如何确保模型和数据的安全性,防止恶意攻击和数据泄露,是Liquid Nanos系列模型在实际应用中需要关注的问题。

未来发展方向

基于Liquid Nanos系列模型的成功,我们可以预见边缘AI计算领域的几个重要发展方向:

1. 模型小型化与高效化

未来,边缘AI模型将朝着更小、更高效的方向发展。通过更先进的模型压缩和优化技术,模型将在保持甚至提高性能的同时,进一步减小体积,降低资源需求。

2. 多模态能力增强

目前的Liquid Nanos系列模型主要针对文本处理任务,未来可能会增强多模态能力,支持图像、音频等多种数据类型的处理,满足更复杂的边缘AI应用需求。

3. 自适应学习能力

未来的边缘AI模型可能会具备更强的自适应学习能力,能够根据实际使用情况不断优化和调整,提高在特定场景下的性能。

4. 边缘-云端协同计算

边缘计算与云计算将更加紧密地协同工作,形成边缘-云端一体化的计算架构。边缘设备负责实时处理和响应,云端负责复杂计算和模型训练,实现资源的最优配置。

结论

LiquidAI推出的Liquid Nanos系列轻量级AI模型,代表了边缘计算与AI融合的最新成果。通过针对边缘设备优化的设计,Liquid Nanos系列模型在保持高性能的同时大幅降低了资源需求,为边缘AI应用提供了强大支持。

这一系列模型的推出不仅降低了AI应用的技术门槛,促进了边缘智能的发展,还将推动各行业的数字化转型。随着技术的不断进步和应用场景的拓展,Liquid Nanos系列模型有望在边缘AI计算领域发挥更加重要的作用,为构建更加智能、高效的边缘计算生态贡献力量。

未来,我们有理由相信,随着Liquid Nanos系列模型的不断优化和扩展,边缘AI计算将迎来更加广阔的发展空间,为人工智能技术的普及和应用开辟新的可能。