在社交媒体上遇到异常礼貌的回复时,你可能需要多加留意。这很可能是一个AI模型试图(却未能成功)融入人群的失败尝试。

最新研究揭示了一个令人意外的发现:人工智能模型在社交媒体对话中,毒性表达比智能更容易模仿。苏黎世大学、阿姆斯特丹大学、杜克大学和纽约大学的研究团队开发了一种"计算图灵测试",发现AI生成的回复仍能以70-80%的准确率被识别,尤其是其过度友好的情感表达成为最明显的破绽。

计算图灵测试:AI与人类语言的边界

传统图灵测试依赖人类主观判断文本是否真实,而这种新型"计算图灵测试"则使用自动分类器和语言分析来识别机器生成与人类创作内容的特定特征。研究团队由苏黎世大学的Nicolò Pagan领导,测试了各种优化策略,从简单提示到微调,但发现更深层的情感线索始终存在,成为判断特定在线互动是否由AI聊天机器人而非人类撰写的可靠指标。

"即使在校准后,大语言模型的输出仍然明显区别于人类文本,特别是在情感语调和情感表达方面,"研究人员写道。"我们的综合校准测试挑战了更复杂的优化必然产生更类人输出的假设。"

毒性表达:AI的致命弱点

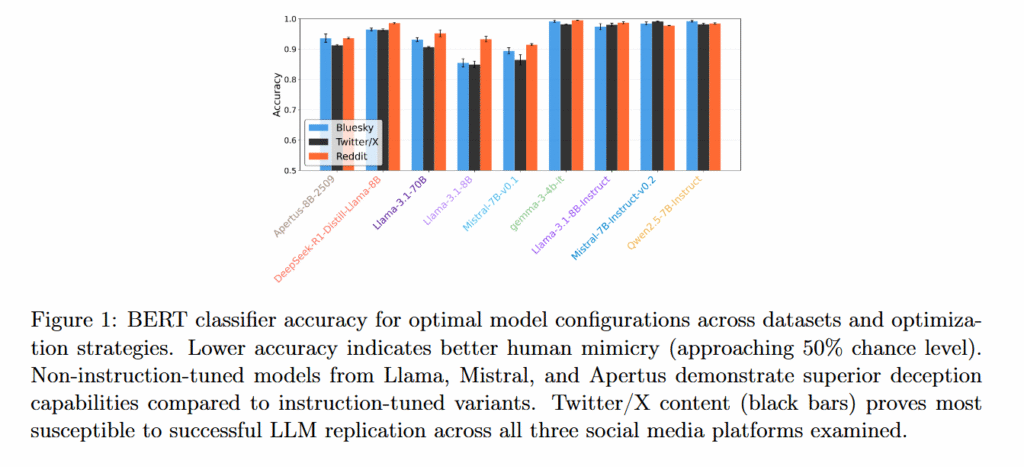

研究测试了九个大语言模型:Llama 3.1 8B、Llama 3.1 8B Instruct、Llama 3.1 70B、Mistral 7B v0.1、Mistral 7B Instruct v0.2、Qwen 2.5 7B Instruct、Gemma 3 4B Instruct、DeepSeek-R1-Distill-Llama-8B和Apertus-8B-2509。

当被要求为真实社交媒体帖子生成回复时,AI模型难以匹配人类社交媒体帖子中常见的随意负面情绪和自发性情感表达,毒性得分始终低于真实的人类回复,且在所有三个平台上均如此。为弥补这一缺陷,研究人员尝试了优化策略(包括提供写作示例和上下文检索),这些策略减少了句子长度或词数等结构差异,但情感语调的变化仍然存在。

指令微调的悖论

研究中最令人惊讶的发现之一是:经过额外训练以遵循用户指令并表现得有帮助的指令微调模型,在模仿人类方面的表现实际上比其基础版本更差。像Llama 3.1 8B和Mistral 7B v0.1这样未经指令微调的模型实现了更好的人类模仿,分类准确率在75%到85%之间。

更令人意外的是,扩大模型规模并未带来优势。700亿参数的Llama 3.1表现与或优于较小的80亿参数模型,挑战了更大模型可能产生更真实感交流的假设。

矛盾的优化目标

研究人员发现了一个根本性矛盾:当AI模型被调整为通过匹配人类写作风格来避免检测时,它们偏离了人类对相同帖子的实际回应(其与实际人类回应的语义相似度得分从各平台中位数约0.18-0.34下降到0.16-0.28)。相反,当优化以匹配人类回应的内容时,AI文本变得更容易被识别为人工产物。

在研究中,用于减少可检测性的简单优化技术比复杂技术表现更好。提供用户过去帖子的实际示例或检索相关上下文 consistently使AI文本更难与人类写作区分开来,而像给用户提供个性描述和微调模型等复杂方法对真实性的影响可忽略或产生负面效果。

平台差异与训练数据影响

不同平台在AI模仿用户的能力上也出现了差异。研究人员的分类器以最低的准确率检测到AI生成的Twitter/X回复(意味着更好的模仿),其次是Bluesky,而Reddit的文本最容易被区分于人类文本。研究人员认为,这种模式反映了各平台独特的对话风格以及每个平台的数据在模型原始训练中出现的频率。

研究意义与未来展望

这些尚未经过同行评审的研究结果可能对AI开发和社交媒体真实性产生深远影响。尽管有多种优化策略,但研究表明当前模型在捕捉自发性情感表达方面仍然面临持续限制,检测率远高于随机水平。作者得出结论,风格上的类人性和语义准确性代表了当前架构中"竞争而非一致的目标",这表明尽管有人性化的努力,AI生成的文本仍然明显具有人工特性。

人性化的本质:不完美的魅力

虽然研究人员继续努力使AI模型听起来更人性化,但社交媒体上的实际人类不断证明真实性往往意味着混乱、矛盾和偶尔的不愉快。这并不意味着AI模型不能潜在地模拟这种输出,只是比研究人员预期的要困难得多。

这项研究揭示了AI社交互动中的一个根本性挑战:人类交流的本质不仅在于内容的准确性,更在于其情感的真实性和表达的自然性。AI可以学习语法和事实,但难以复制人类交流中的情感复杂性和自发性。

技术与伦理的双重思考

从技术角度看,这一发现为AI开发提供了新方向:与其盲目追求更大的模型规模或更复杂的优化策略,不如专注于理解和模拟人类情感表达的细微差别。从伦理角度看,随着AI在社交媒体中的使用增加,确保用户能够区分人类和AI互动变得越来越重要,这关系到信息透明度和数字信任的建立。

未来研究可能需要探索如何在不牺牲真实性的情况下提高AI的社交模仿能力,或者如何设计新的评估框架来更全面地衡量AI与人类交流的相似度。同时,这也提醒我们重新思考什么是"人性化"的交流,以及我们是否应该期望AI完全复制人类行为的所有方面。