在互联网产品的坟场里,很少有APP能在被判"死刑"后还能重新杀回舞台中央。然而,多闪做到了。11月18日,极客公园注意到,在App Store中国区免费榜的前六名应用中,有五款来自字节跳动,分别是豆包、红果短剧、抖音商城、多闪和汽水音乐。除豆包外,其余四个应用都属于抖音旗下。

这其中,多闪可能是一个令人意想不到的名字,很多人可能并不熟悉这款社交应用。对于大多数用户而言,"多闪"这个名字属于2019年的那个冬天。彼时,它作为字节跳动首款独立社交产品,带着"围剿微信"的使命高调诞生,却在短暂的高光后迅速陨落,甚至一度被传停止研发。

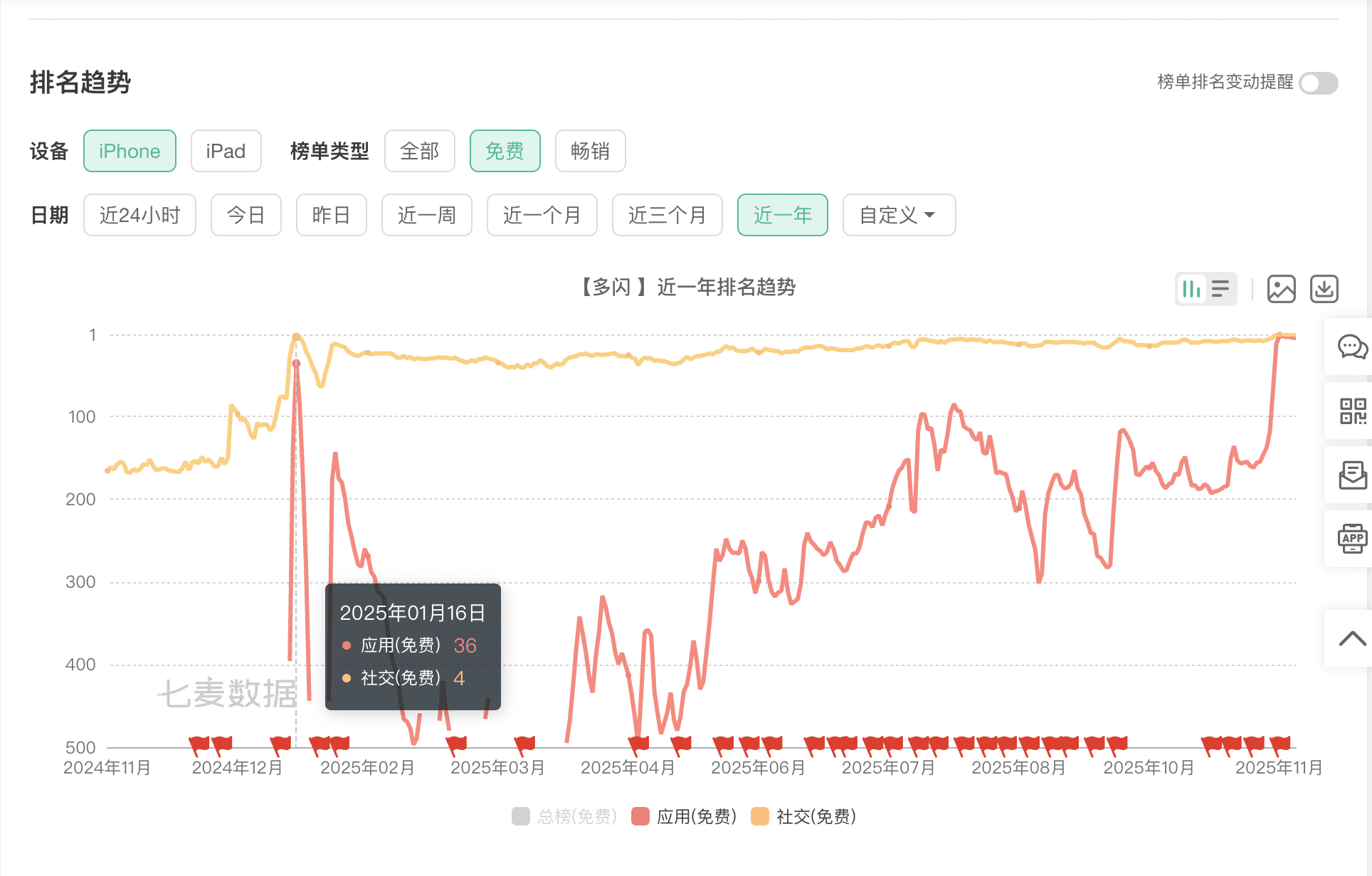

但现在,这样一款并没有活跃在大众视线里的社交产品,不仅没有消失,反而在一众新贵的夹击下悄然冲榜——在免费总榜单中位列第五名,同时还冲到了App Store社交榜第一名。

多闪的"诈尸"回春,背后或许是字节跳动面对流量见顶时的焦虑,以及在AI时代重构社交版图的野心。本文将深入剖析这一现象背后的商业逻辑与战略考量。

一、 褪去光环的"幸存者":从挑战微信到成为抖音的"影子"

多闪的「诈尸」是从什么时候开始的?七麦数据显示,多闪在今年年初时,就曾在社交榜冲到第四名,此后一直在这个位置上下徘徊。但在免费总榜里,年初最好的排名也就是36名,而后处于大幅上下波动中,11月的这波「起飞」,看起来始于11月11日左右,从第162名一路直升到第五名左右。

回溯到2019年,多闪主打"视频社交",张一鸣曾在字节跳动七周年庆典上为其站台,称对多闪的预期是"不断想办法突破"。那时的多闪,试图用"随拍"、"72小时消失"等Snapchat式的玩法,去挑战微信沉重的社交压力。但现实是残酷的,随着补贴退潮,多闪下载量曾经历断崖式下跌。

而后多闪经历过三次大的改版:2022年探索相机社交,2023年重新定位为"抖音聊天官方应用"。去年12月坊间一度传出其已停止研发、仅保持维护的消息,且iOS端曾近一年未更新,但从7个月前,多闪已悄然恢复了每月小幅优化的节奏,这一个月以来更是密集优化了5次。就在5天前,多闪又更新了36.6.0版本,重点补齐了更多聊天实用功能,越来越像一个"抖音版微信"。

从"几近消失"到重回榜首,应该是抖音在幕后重新发力,将多闪推向了前台。这种变化或许折射出了字节跳动社交思路的变化:不再试图凭空造一个新社交网络,而是承认抖音才是真正的流量黑洞,多闪必须依附于抖音存在。

目前的"多闪",更像是一个被剥离了短视频广场、专注于即时通讯的"配套工具"。它老老实实地做抖音生态的"Messenger",不再寻求成为年轻人的"Snapchat"。但这种"降级"反而让它在抖音庞大的用户基数下找到了生存空间——只要抖音用户有聊天需求,多闪就有存在的价值。

二、 醉翁之意不在"聊"

如果仅仅是为了聊天,抖音内置的私信功能似乎已经足够。为何字节跳动还要死磕"多闪"这个独立App?答案或许藏在抖音急剧扩张的商业版图中。

近年来,抖音在本地生活和电商业务上攻城略地,但在私域流量的沉淀上始终是短板。互联网进入存量博弈阶段,单纯的社区内容消费与人际社交关系链有着本质区别。微信之所以难以撼动,是因为它掌握了核心关系链。

多闪的「复活」或许可以跟字节跳动最新的一则组织架构调整联动来看。11月17日,有报道称字节跳动将中国电商、生活服务、中国广告的技术团队深度整合,正式成立"中国交易与广告"部门,由原抖音生活服务技术负责人王奉坤挂帅。

这意味着,在字节的战略棋盘中,广告流量与交易场景(电商、本地生活)将被彻底打通。在这个新的"交易+广告"庞大架构下,多闪也许能发挥的作用是:

- 私域沉淀:商家需要一个更纯粹的场域来维护客户关系,而不是在充斥着短视频流的抖音主App里。

- 弥补算法缺陷:社交推荐能有效弥补算法推荐的弊端,增加用户粘性。

多闪的任务可能已经从"进攻"转为"防守"。它不需要打败微信,只需要作为抖音生态的一个"后花园",接住那些在抖音上产生的社交关系火花,防止它们流失到微信中去。

三、 字节跳动社交战略的演进与未来

字节对社交的执念应该永远也不会消失。除了「复活」的多闪,猫箱则是字节flow部门推出的AI社交产品,主打人与虚拟角色的互动,提供一种"伴聊"的情绪价值,刚推出的时候活跃度很高,但随着国内产品在9月迎来了一波停服潮,曾经是头部产品的「猫箱」相较巅峰时期下载量已跌去9成以上。

从2019年的高调宣战,到如今的低调霸榜,多闪的浮沉录也是字节跳动产品哲学的进化史。它更加务实地服务于超级APP的生态需求,而不是像过去一样盲目追求颠覆。

多闪有没有"死"并不重要,重要的是打败微信的绝不会是另一个微信。这场关于社交的战争,或许并未结束,只是进入了新的阶段。

字节跳动社交战略的三个阶段

- 挑战期(2019-2020):以多闪为代表,试图通过差异化功能直接挑战微信的社交霸主地位。

- 蛰伏期(2021-2023):多闪逐渐边缘化,转为维护状态,字节开始探索其他社交可能性。

- 整合期(2024至今):多闪重新定位为抖音生态的即时通讯工具,服务于字节整体的电商和生活服务战略。

多闪"复活"的关键因素

- 抖音生态的成熟:抖音已经成为超级APP,拥有庞大的用户基础和丰富的场景需求。

- 商业战略的调整:字节需要打通电商、广告和社交,形成完整的商业闭环。

- 产品定位的清晰化:从"挑战者"转为"服务者",更符合字节的实际能力。

四、 行业启示与未来展望

多闪的案例为整个互联网行业提供了重要启示:在流量见顶的背景下,单纯的用户增长已经不足以支撑产品的长期发展,如何构建生态协同效应成为关键。

对于字节跳动而言,多闪的"复活"标志着其社交战略的成熟。它不再试图颠覆现有格局,而是通过差异化定位,在现有生态中寻找价值点。这种务实的态度,或许是字节能够在激烈竞争中保持领先的重要原因。

未来,随着AI技术的深入发展,社交产品将迎来新的变革。多闪是否会引入更多AI功能,成为字节AI战略的重要一环?抖音、多闪和其他字节系产品之间将如何形成更紧密的协同?这些问题的答案,将决定字节跳动在社交领域的未来地位。

从更宏观的角度看,多闪的"复活"也反映了互联网行业从"颠覆式创新"向"生态式创新"的转变。在存量时代,如何通过整合现有资源,创造新的价值,将成为所有互联网企业需要思考的问题。

结语

多闪的故事,是一部关于互联网产品生存与进化的教科书。它告诉我们,在瞬息万变的互联网世界,没有永远的失败者,也没有永远的胜利者。关键在于能否根据市场变化,及时调整战略,找到自己的生态位。

字节跳动通过多闪的"复活",展示了一个成熟互联网公司的战略眼光和执行能力。它不再盲目追求颠覆,而是通过精准定位和生态协同,在看似饱和的市场中开辟新的空间。

这场关于社交的战争或许没有结束,但规则已经改变。未来的社交产品,将不再只是功能的竞争,而是生态的竞争、体验的竞争,以及对用户需求的深刻理解和满足能力的竞争。

多闪的"复活"只是一个开始,它预示着互联网行业将进入一个更加注重生态协同和用户体验的新阶段。在这个阶段,那些能够真正理解用户需求,并构建完整生态的企业,将最终赢得这场持久战。