在科技行业的浪潮中,每一次重大创新都会重新定义人与设备的交互方式。2025年12月,字节跳动旗下的豆包团队发布了一款革命性的产品——豆包手机助手技术预览版。这款与中兴合作打造的工程样机nubia M153,不仅是一款硬件设备,更是对移动互联网交互逻辑的一次根本性重构。

从对话到行动:AI助手的新进化

过去两年,我们见证了Chatbot技术的飞速发展,从写诗作画到回答问题,AI的能力边界不断拓展。然而,对于普通用户而言,手机上最普遍的痛点始终是那些繁琐的操作流程——截图、退出应用、打开新应用、重复输入信息等。豆包手机助手的最大突破,在于它成功实现了从"对话"到"行动"的跨越。

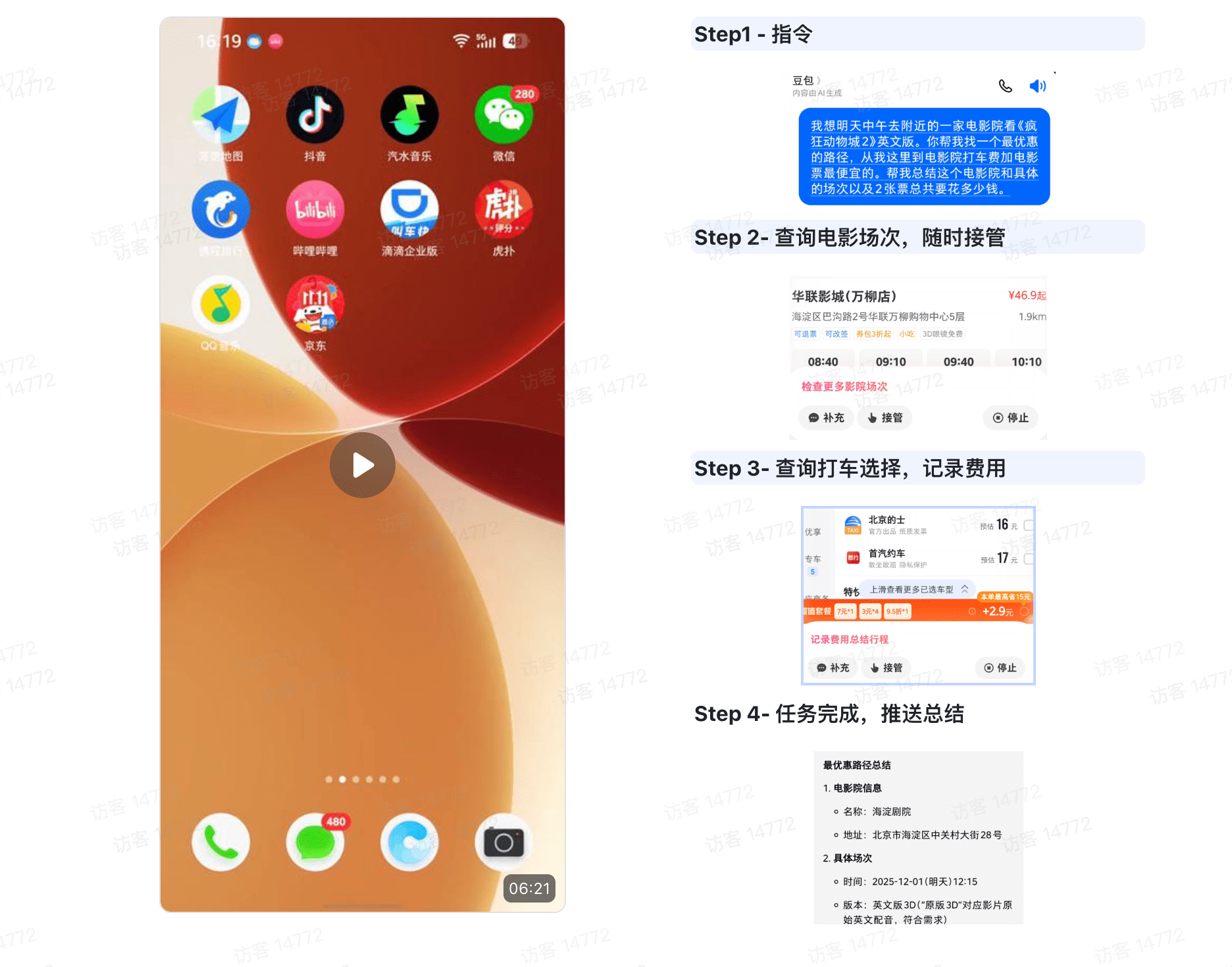

在技术预览版的演示中,豆包展示了令人印象深刻的能力:它能像人类一样"看懂"屏幕内容,并直接模拟点击操作。这种"看懂屏幕"并执行操作的能力,源于豆包大模型在多模态技术上的深厚积累。官方资料显示,该模型在视觉理解、推理以及图像创作等维度的性能已处于国际第一梯队。

"豆包会根据意图自动判断是否调用AI Agent能力,"官方文档解释道,"若用户对话开头包含'帮我操作手机',则会100%通过AI操作手机完成任务。"

这种能力在实际场景中的应用尤为引人注目。想象一下,当你在社交媒体上被种草一款商品,传统流程需要你截图、退出应用、打开电商平台、搜索、比价。而在豆包的演示中,你只需说一句"帮我在全平台比价下单",AI就能自动跨应用跳转,搜索同款、对比价格规格、领优惠券,甚至帮你选好最低价的商品填入购物车。

豆包手机助手跨应用操作演示

更令人惊叹的是,豆包能够处理复杂的多重指令。在官方演示的旅行规划场景中,当用户提出"下个月去巴黎,帮我把收藏的餐厅标在地图上,看看哪天有展并订票"这样一句包含多重意图的指令时,AI能够迅速将需求拆解为6个子任务:从查询社交媒体收藏、到高德地图标记、再到携程订票,最后整理进备忘录。

这种跨应用、多步骤的"任务链"执行能力,标志着AI从"玩具"向"工具"转变的关键分水岭。它不仅提高了效率,更重新定义了人与设备之间的交互方式。

系统级整合:AI与手机的深度融合

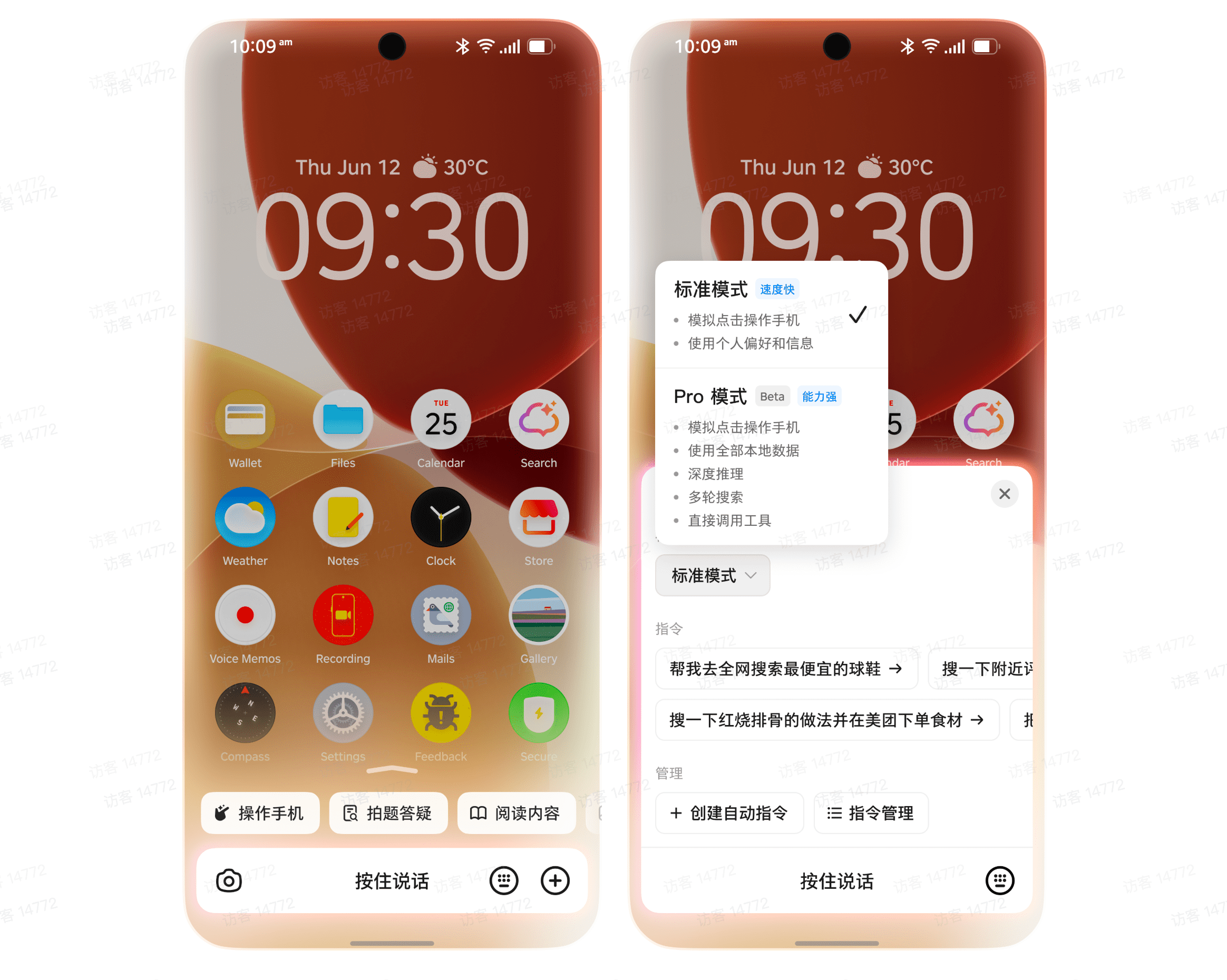

为了实现这种"类人"的交互体验,豆包团队采取了系统级的整合策略。在操作系统层面,豆包手机为AI能力设计了多种交互方式:用户可以通过侧边键、语音甚至耳机唤醒它;在相册里,它能直接听懂"把路人P掉"的指令并执行。

豆包手机助手多场景应用示例

在更复杂的"Pro模式"下,豆包还能调用系统工具,结合记忆功能,直接完成"推荐礼物并放入购物车"这种需要多步推理的复杂任务。这种深度整合使AI不再是运行在应用层的一个独立程序,而是成为操作系统的一部分,能够无缝访问各种系统资源和应用数据。

豆包手机助手Pro模式复杂任务执行

当然,将屏幕控制权和个人偏好交给AI,隐私安全始终是绕不开的话题。豆包团队强调,这一功能支持按需开启,并承诺严格保护数据隐私。作为"技术预览版",团队也在视频结尾特别提示,受限于大模型技术的不确定性,演示中的"丝滑"体验目前还无法百分百复现,产品距离团队的最终预期仍有差距。

这种坦诚的态度反而体现了AI Agent目前最真实的状态:方向极度性感,但落地仍需时间打磨。

第三条路:不造硬件的生态战略

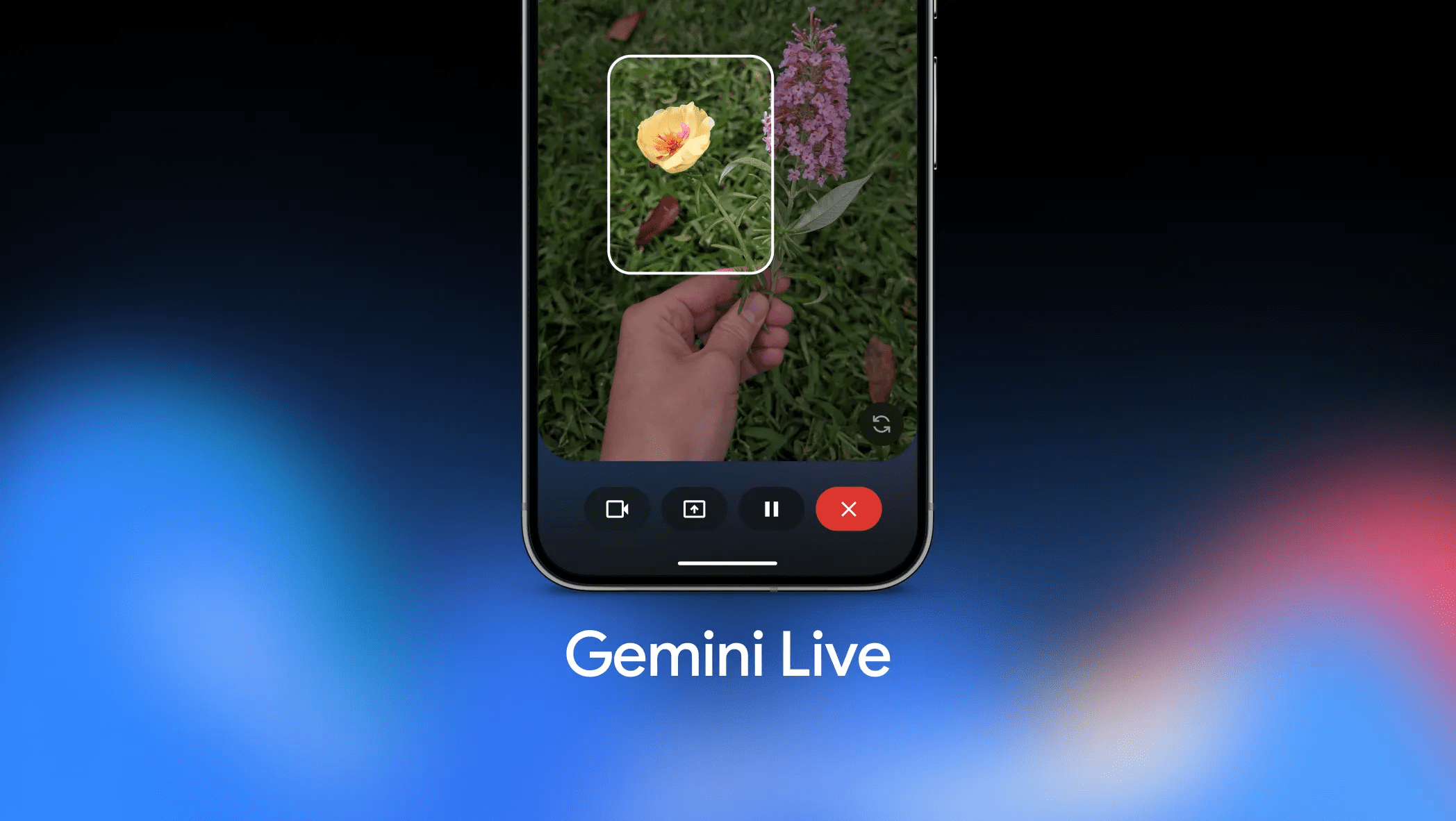

在AI手机的浪潮中,一直存在两种主要流派:一种是像Google/Pixel手机这样,自研模型以及整套AI软件产品体验,并植入自家系统;另一种则是纯软件厂商,试图通过超级APP抢占入口。

Google Pixel手机AI功能示例

豆包选择了第三条路:不做硬件,只做生态。在发布预览版的同时,豆包方面明确表示"没有自研手机计划"。他们的策略非常务实——通过与多家手机厂商洽谈,以"操作系统层面合作"的形式,将豆包的大模型能力植入不同品牌的机型中。

这种"手机厂商+大模型厂商"的深度耦合,正在成为行业的一股新趋势。就像谷歌Gemini与三星的合作一样,"术业有专攻"正逐渐成为行业共识。对于手机厂商而言,从零打造一个具备顶级推理、视觉理解和复杂任务规划能力的模型成本极高;而对于字节跳动这样的互联网巨头,缺乏硬件载体则会让AI始终隔着一层APP的玻璃墙,无法触达用户最核心的数据和场景。

目前的nubia M153工程机只是一个开始。售价3499元的门槛或许更多是面向开发者和极客人群的"邀请函",旨在验证这种跨界合作的技术可行性与用户反馈。业内人士向"极客公园"透露,字节跳动与努比亚为这款工程机的首销备货量达3万台,并为此订购了对应数量的手机关键元器件,显示出公司对该项目的重视程度。

移动互联网交互逻辑的重构

豆包手机助手的出现,本质上或许是一次对移动互联网交互逻辑的重构。

大模型的能力越来越强,单纯做一个APP,在AI时代已经不够了。AI Agent需要接管更复杂的任务、感知更丰富的上下文,发挥一些真实的功能,才有更落地的价值,这意味着它必须走出软件的围墙,向下沉淀,与操作系统的底层权限和硬件能力进行深度整合。

豆包手机外观设计

过往,字节跳动一直是一支强大的"空军"——拥有极致的算法和庞大的应用生态,但在操作系统和终端硬件上,相比拥有Android的谷歌或拥有全场景终端的华为,字节始终缺少一块落地的"阵地"。在移动互联网时代,这或许不是问题,但在AI需要深度介入用户场景的当下,缺乏硬件载体可能意味着丧失对场景的感知力。

豆包手机助手的推出,像是字节在当下阶段抛出的一次探索。从Pico到Ola Friend,再到如今深入手机OS层的助手,字节正在小心补齐"硬件触点"这块短板。

这或许并不是未来两三年行业的最终形态,但至少可以确认的是:字节已经意识到,想要让AI真正跑通,必须迈出"软硬结合"的这关键一步。

市场定位与用户群体分析

首销备货3万台,售价3499元——这些数字揭示了豆包手机助手的市场定位。这款工程机显然不是面向大众消费市场的产品,而是针对开发者和科技爱好者的"技术预览版"。

从价格策略来看,3499元的定价明显高于同配置的普通智能手机,这表明其目标用户并非价格敏感型消费者,而是对新技术有强烈兴趣、愿意为前沿体验付费的科技早期采用者。

这类用户群体通常具有以下特征:

- 对AI技术有深入了解和浓厚兴趣

- 具备一定的技术背景,能够理解并容忍早期产品的局限性

- 乐于参与产品测试,提供反馈意见

- 在科技社区有一定影响力,能够带动产品口碑传播

通过这一策略,豆包团队可以在控制风险的同时,收集高质量的用户反馈,为后续产品的迭代优化奠定基础。

技术挑战与未来展望

尽管豆包手机助手展示了令人印象深刻的能力,但要实现真正的商业化落地,仍面临诸多技术挑战。

首先是稳定性问题。正如官方所承认的,受限于大模型技术的不确定性,演示中的"丝滑"体验目前还无法百分百复现。AI Agent在执行复杂任务时,可能会遇到理解偏差、操作失误或系统兼容性问题。

其次是隐私与安全问题。AI助手获得如此广泛的系统权限,如何确保用户数据不被滥用,如何防止恶意程序通过AI接口获取敏感信息,这些都是亟待解决的问题。

最后是生态建设问题。要让AI助手真正发挥价值,需要与越来越多的应用和服务建立深度连接。这需要与各应用开发者建立合作,解决API兼容、数据共享等一系列标准化问题。

展望未来,豆包手机助手的发展可能呈现以下几个方向:

- 能力边界的不断拓展:从简单的操作执行到更复杂的决策推理

- 隐私保护技术的加强:在保证功能的同时,让用户对数据有更多控制权

- 生态系统的逐步完善:与更多应用和服务深度整合

- 硬件形态的多样化:除了手机,可能扩展到其他智能设备

行业影响与竞争格局

豆包手机助手的推出,将对整个AI手机行业产生深远影响。

首先,它验证了"手机厂商+大模型厂商"合作模式的可行性,为行业提供了新的发展思路。这种模式既避免了手机厂商自研AI模型的高成本和长周期,又解决了纯软件厂商缺乏硬件载体的问题。

其次,它重新定义了AI手机的标准。未来的AI手机将不再仅仅是集成了一些AI功能的传统手机,而是以AI为核心,重构整个交互逻辑的全新设备。

在竞争格局方面,豆包的加入将进一步加剧AI手机领域的竞争。Google、三星、华为等已布局AI手机的企业将面临更强大的竞争对手,而传统手机厂商则可能被迫加速AI转型。

同时,这也将推动整个AI产业链的发展。从芯片设计到操作系统优化,从应用开发到服务整合,AI手机的兴起将为整个科技生态系统带来新的机遇和挑战。

用户体验的重塑

豆包手机助手最根本的价值,在于它对用户体验的重塑。

在传统智能手机上,用户需要学习各种应用的操作逻辑,记住多个应用的位置和功能。而在豆包手机上,用户只需用自然语言描述需求,AI就能理解并执行相应操作。这种"意图直达"的交互方式,大大降低了用户的使用门槛。

同时,AI助手能够学习用户的偏好和习惯,提供个性化的服务。例如,它可以根据你的购买历史和浏览习惯,在你需要购物时主动推荐可能感兴趣的商品;根据你的日程安排,提前规划出行路线并预订相关服务。

更重要的是,AI助手能够将原本分散在多个应用中的功能整合在一起,提供连贯一致的体验。你不再需要在不同的应用之间切换,而是可以通过一个统一的入口完成各种任务。

这种用户体验的重塑,不仅提高了效率,更让科技真正服务于人,而不是让人去适应科技。

商业模式的创新

豆包手机助手的推出,也带来了商业模式的创新可能性。

首先,它开创了"AI即服务"的新模式。用户购买的不只是硬件设备,更是持续迭代的AI服务。这种模式类似于智能手机时代的应用商店,但层次更高,价值更大。

其次,它为精准营销和个性化服务提供了新渠道。AI助手能够深入了解用户需求,为商家提供精准的用户画像,同时为用户提供更符合其需求的产品和服务。

最后,它可能催生全新的应用生态。随着AI能力的增强,可能出现一些传统应用无法实现的新服务,例如基于AI的个人助理、智能旅行规划师、家庭活动协调员等。

这些创新商业模式,将为科技行业带来新的增长点,同时也带来新的监管挑战。如何在促进创新的同时保护消费者权益,将成为政策制定者面临的重要课题。

社会影响与伦理考量

AI手机的普及,将产生广泛的社会影响,同时也引发一系列伦理问题。

在积极方面,AI手机可以提高信息获取的效率,降低数字鸿沟,让更多人能够享受到科技发展的红利。它还可以帮助老年人、残障人士等特殊群体更便捷地使用智能设备,提高他们的生活质量。

在消极方面,过度依赖AI可能导致人类某些能力的退化。例如,如果AI助手总是帮我们规划路线,我们可能会逐渐丧失方向感;如果AI总是帮我们筛选信息,我们可能会失去独立思考的能力。

隐私保护是另一个重要议题。AI助手需要访问用户的各类数据,包括位置信息、通讯记录、浏览历史等。如何确保这些数据不被滥用,如何平衡个性化服务与隐私保护的关系,需要技术、法律和伦理的多重保障。

此外,AI决策的透明度和可解释性也值得关注。当AI助手做出重要决策时,用户应该有权了解决策的依据,并在必要时能够进行干预或纠正。

结论:AI手机的黎明已至

豆包手机助手的推出,标志着AI手机进入了一个新的发展阶段。它不再是对现有手机功能的简单增强,而是对移动交互逻辑的根本性重构。

从"对话"到"行动",从"应用切换"到"意图直达",从"人适应设备"到"设备服务于人",这些转变预示着移动互联网的未来图景。在这个新图景中,AI将成为设备的核心,自然语言将成为主要的交互方式,而用户体验将得到前所未有的提升。

当然,要实现这一愿景,还有很长的路要走。技术挑战、隐私问题、生态建设、商业模式创新等一系列问题都需要解决。但方向已经明确,道路已经开启。

或许,谁能率先解决"操作手机"的稳定性难题,谁就能定义AI时代的"iPhone时刻"。而豆包手机助手,无疑在这一进程中迈出了重要一步。

正如一位行业观察者所言:"我们正站在AI手机革命的黎明,而豆包,已经点亮了第一缕曙光。"