人工智能时代,开源已成为推动技术创新的重要发展方向。从Meta的Llama到中国的Qwen和DeepSeek,开源模型正在打破闭源垄断,让AI技术更加普惠。随着AI逐步深入现实世界,全新的AI原生硬件设备对连接底层硬件与顶层应用的操作系统提出了新的需求。在这一背景下,vivo历时八年研发的蓝河操作系统(BlueOS)及其核心BlueKernel内核的开源,标志着AI操作系统领域的一次重大突破。

为什么我们需要一个Rust内核?

一个操作系统能走多远,与其使用的语言有密切关系。AI眼镜、机器人等AI原生硬件设备与普通智能设备最大的不同,在于它内置的AI能力,这些能力通常由大模型和AI Agent驱动。要在端侧设备上高效运行AI模型和AI Agent,对操作系统的安全性、轻量化程度和通用性都提出了更为严苛的考验。

传统操作系统的安全困境

以C/C++语言为主的操作系统约70%的严重安全漏洞与内存安全问题有关。近年来,行业里与内存安全相关的事故案例层出不穷,比如工信部的网络安全威胁和漏洞信息共享平台(NVDB)在2025年9月就发布了苹果操作系统(包括Mac OS和iOS)在内存安全方面的高危漏洞。

尤其是对于AI应用,尤其是端侧AI,需要处理和分析海量的、极其敏感的个人数据,例如用户的对话录音、面部图像和健康指标。传统操作系统在内存安全上的缺陷,容易导致灾难性的隐私泄露问题。

Rust语言的安全革命

相比C/C++语言,Rust语言在内存安全上有质的飞跃。它的核心思路是在代码编译时就对常见的内存风险做严格检查,让许多容易埋下隐患的错误无法通过编译。一些在C/C++语言中需要靠开发者自觉规避的错误,在Rust语言中,大多会在写代码时就被编译器直接拦下。

这种优越的安全性能已经被主流操作系统项目实际验证。例如,Android系统底层采用Rust后,相比C/C++时代,内存安全漏洞首次降至总漏洞的20%以下。这一数据充分证明了Rust在系统级软件开发中的巨大潜力。

AI硬件的特殊需求

AI原生硬件设备通常受到严格的资源限制,包括有限的内存、闪存硬盘和电池容量。因此,它们的操作系统必须是极致轻量化的,内核和核心服务占用的系统资源要尽可能小,以便让AI模型和算法更高效地运行。

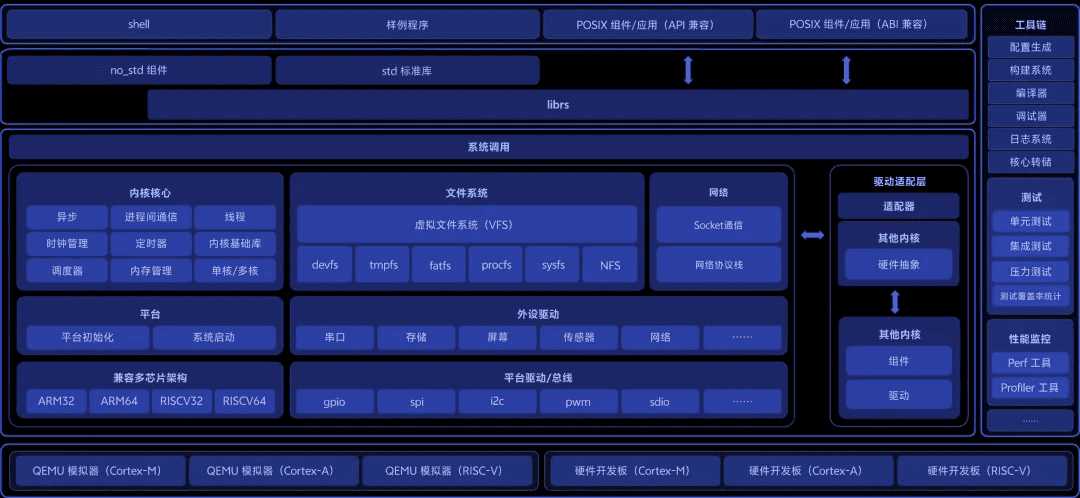

同时,AI原生硬件设备的形态目前还比较多样,其内在也会使用不同芯片架构的AI芯片,这些都对操作系统的通用性提出了高要求。基于Rust语言编写的BlueKernel,在持续提升对CPU架构和驱动的兼容能力,对硬件资源的需求相比传统操作系统内核也显著降低,能够以更低的成本满足各类终端产品的需求。

本质上,Rust是用一套语言规则打通了从底层系统到上层服务,为多硬件平台的长期迭代提供了更稳固的通用底座。而有了更好的语言,才有了更好的操作系统内核。

BlueKernel内核,AIOS的基石

蓝河操作系统本身就是面向智能眼镜、机器人等AI原生硬件设备的智慧操作系统,所以其内核——BlueKernel,也针对AI硬件设备"高安全、低资源、多形态"的痛点进行了原生设计,具备安全、轻量、通用的三大特性,将语言的潜力转化为系统级的核心竞争力。

安全与效率的统一

作为适用于AI原生硬件设备的开源Rust内核,BlueKernel的竞争力首先体现在安全与效率的统一上。

在内存安全方面,BlueKernel使用编译期所有权系统,让内存安全从以往的被动防御进化到现在的主动掌控。开发者不用再为内存安全问题花费更多开发资源,进而能加速AI原生硬件设备在消费者层面的普及,促进整个行业的繁荣。

同时,得益于对基础数据结构高性能低开销的设计,BlueKernel对硬件资源需求低,最小内核内存占用仅13KB。这为AI模型和算法等"资源消耗大户"腾出了宝贵的计算资源,也让那些极度轻量化的AI原生硬件设备,例如智能眼镜(通常只有几十克重)和智能手环,能够利用有限的算力提供足够强的AI能力。

通用性与硬件兼容

BlueKernel兼容RISC-V、ARM等多种芯片架构,也支持兼容POSIX接口的标准库。对于开发者来说,这意味着他们写的程序可以更容易地在各种类型的硬件设备平台上移植。

为保证系统扩展性,BlueKernel通过硬件抽象等一系列方式,提升了对于CPU架构和驱动的兼容能力,支持Rust语言开发驱动,也支持兼容已有的C语言内核的外设驱动。因此,开发者和生态内的厂商既可以继续使用现有的C语言驱动,也可以用Rust语言为新硬件编写新驱动,这种分阶段的投入,降低了整个行业的进入门槛。

从技术到生态的跨越

从内存安全保护、超低的资源消耗到对多芯片架构、多设备形态的灵活适配,BlueKernel通过发挥Rust语言的优良特性,在系统内核层面解决了AI原生硬件设备对高安全性与低资源的诉求。这种兼顾效率与通用性的特性,使它成为AI时代操作系统的新基石。

vivo作为Rust语言的先行者,也承担起责任,将BlueKernel开源,与行业共同构筑越来越繁荣的AI生态。这一决策不仅体现了vivo的技术自信,更展示了中国科技企业在全球开源社区中的责任担当。

BlueKernel的生态机遇与未来

在海外市场,开源的操作系统已经非常有影响力,例如Linux不仅是大部分服务器的底层操作系统,成为全球互联网的基石;引领移动互联网时代的Android操作系统,它的操作系统内核也基于Linux内核。

中国开源生态的新机遇

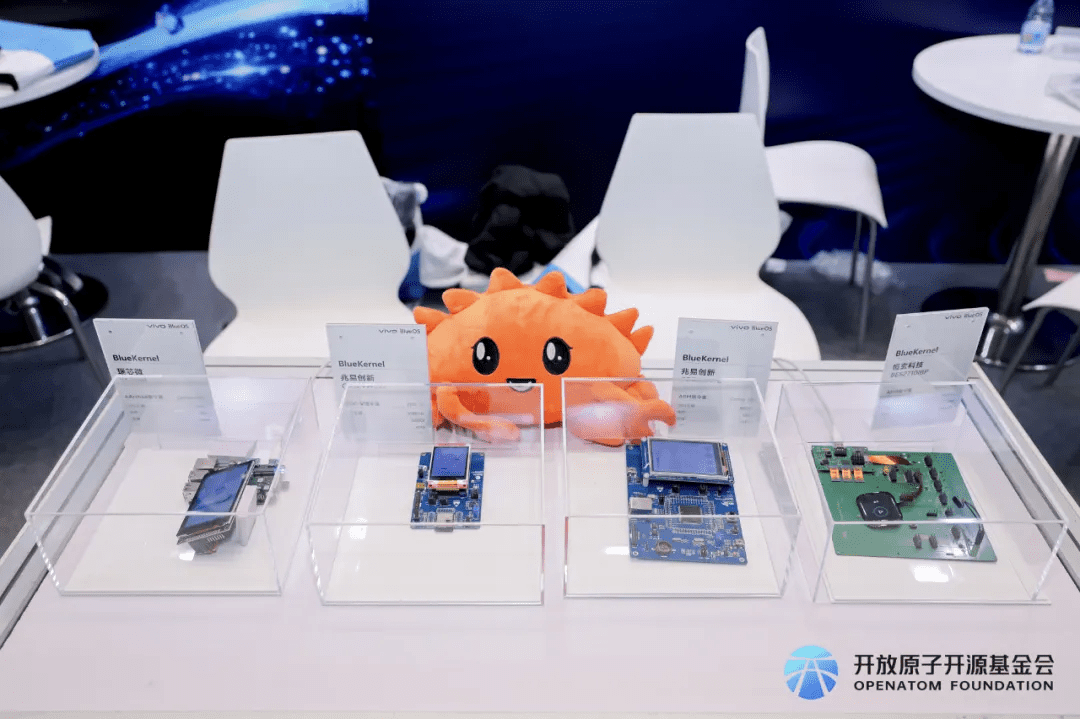

而在中国市场,随着近些年越来越多的企业、高校、研究机构和开发者持续的投入和创新,开源也呈现出了繁荣发展的态势。由此看来,vivo将以Rust语言自研的操作系统内核BlueKernel向行业开源,并捐赠给开放原子开源基金会,既具有诚意,又意义深远。

vivo开源的是操作系统内核,它是操作系统的"心脏",这让底层的硬件厂商、专业的系统开发者、开源社区,都可以基于BlueKernel进行创新,而不仅仅是vivo一家。

务实的生态策略

vivo在构建生态时,具有务实的态度。目前,微软和Linux仍然是操作系统的主流,它们留下了数量庞大的C语言驱动代码(近2000万行)。因此,BlueKernel采取了灵活的"渐进式"迁移策略:它既支持开发者用先进的Rust语言开发原生驱动,也兼容已有的C语言驱动,极大地降低了硬件厂商的适配门槛和开发者的学习成本。

这种务实的生态策略,使得BlueKernel能够在不影响现有系统稳定性的前提下,逐步引入Rust语言的先进特性,为整个行业提供了一个平稳过渡的路径。

AI硬件市场的想象空间

基于安全、通用、轻量化的特性,以及务实的生态策略,BlueKernel为爆发初期的AI原生硬件设备市场提供了巨大的想象空间。随着AI技术的不断成熟和普及,AI眼镜、智能手表、机器人等设备将迎来爆发式增长,而一个安全、高效的操作系统内核将成为这些设备的基础设施。

vivo的贡献不止于开源操作系统内核,它正与开放原子开源基金会携手,通过举办"蓝河操作系统创新赛"等方式,系统性地推广Rust语言。目前,第三届"蓝河操作系统创新赛"正在进行中,设立70万元奖金池,以C2Rust项目级转译工具赛题聚焦攻关Rust生态行业难题。vivo将持续把蓝河创新赛打造为行业最具含金量和影响力的Rust顶尖赛事。

从开源并捐献操作系统内核,到办"创新赛",vivo持续为产业做贡献,不断推动整个行业的繁荣和发展。它开源的操作系统内核BlueKernel,为AI眼镜、机器人等AI原生硬件提供了一个安全、通用的强大"心脏"。

结语:Rust内核开启AI操作系统新篇章

vivo开源BlueKernel的举措,不仅是一次技术贡献,更是对整个AI操作系统生态的战略布局。在AI技术快速发展的今天,一个安全、高效、轻量化的操作系统内核将成为AI原生硬件设备的核心竞争力。

通过将历时八年研发的成果开源,vivo不仅展示了自身的技术实力,也为整个行业提供了一个可信赖的技术基础。随着越来越多的开发者和企业加入BlueKernel的生态,我们有理由相信,Rust语言将在操作系统领域扮演越来越重要的角色,为AI时代的到来奠定坚实的技术基础。

从技术突破到生态构建,vivo的实践为中国科技企业在全球开源社区中树立了新的标杆。未来,随着BlueKernel的不断发展和完善,它将成为连接AI硬件与上层应用的重要桥梁,推动AI技术更好地服务于人类社会。