2025年10月10日-12日,2025上海国际智家生活博览会在上海新国际博览中心盛大启幕。本届博览会由"ACE 2025第七届人工智能应用产业博览会"和"KIB 2025中国国际厨卫家居博览会"战略融合升级而成,以"All in AI"为主题,聚焦"智能、适老、绿色"三大核心方向,呈现了一场智慧家居领域的全景盛宴。

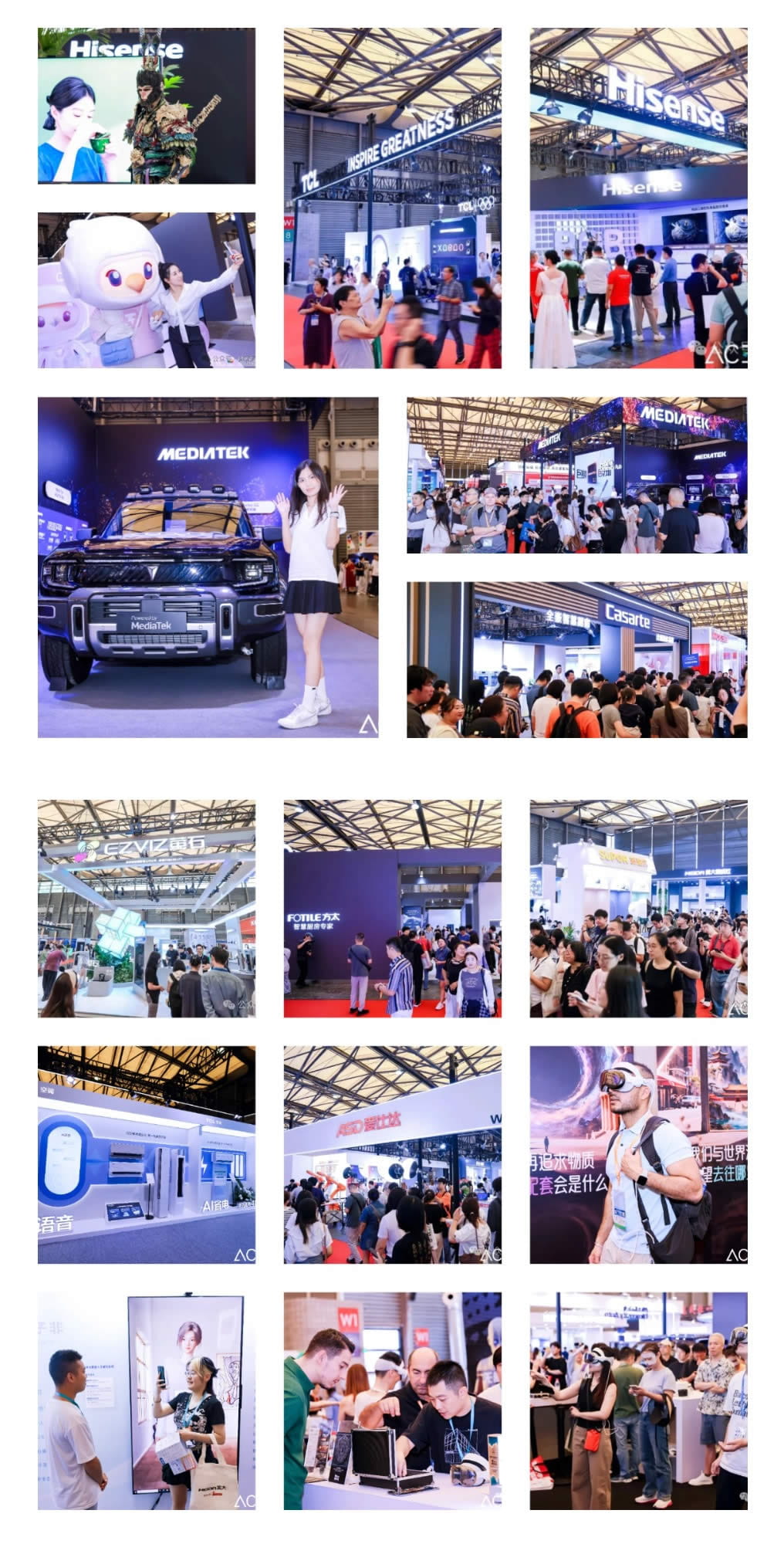

据统计,三天展期共吸引了全球超200家领军企业参展,累计接待来自产业链各环节的专业观众、大众观众、媒体等逾3万人次,人流如织,场面火爆。与ACE2024相比,入场人数增长约20%,充分显示了市场对"智家生活"领域的高度关注。

盛大开幕:精英汇聚,共绘行业新蓝图

2025上海国际智家生活博览会开幕式于10月10日上午隆重举行。中国轻工业联合会会长张崇和先生、中国五金制品协会理事长张东立先生、中国室内装饰协会名誉理事长刘珝先生、中国室内装饰协会理事长张丽女士、中国电子视像行业协会副会长彭健锋先生、嵊州市人民政府副市长王哲峰先生等政府与行业协会领导莅临出席。海信、TCL、海尔、联发科、方太、爱仕达、萤石、飞书、HDMI、德施曼、凯迪仕、亿田、万和、万家乐、鹿客、天马、芯视元、MixWorld、Ellomate、零次元、景秀子非、玩出梦想、元一宇宙、屹境科文等企业领导共同参与开幕盛典。

中国五金制品协会理事长张东立在开幕式上发言致辞,他指出:在当前厨卫产业承压的背景下,展会积极响应国务院"人工智能+"行动,旨在把握AI机遇,推动行业数智化转型。本届展会集中展示从"单品智能"迈向"全屋智能"与"家居家电家装一体化"的成果,旨在引导产业智能化、高端化、绿色化发展,为企业搭建合作平台,更好地满足消费者对智慧生活的需求。

中国室内装饰协会理事长张丽在致辞中指出:当前科技正推动设计与五金厨卫产业携手,共同探索智能化与空间美学的融合。本届展会聚焦"基础技术、生活场景、产业应用",旨在实现设计美学与智能产品的无缝衔接,让技术达成家居环境的自主感知与情感交互,以"小空间"服务"大民生"。

中国电子视像行业协会副会长彭健锋在致辞中指出:随着AI技术加速落地,智能家居产业已迈入"场景融合"发展新阶段。国务院"人工智能+"行动为行业发展明确了方向,据数据显示,2024年该领域市场规模已达6200亿元,预计2025年将突破7000亿元。当前行业不仅在无感交互、生态协同、绿色节能等关键领域实现突破,还同步推动产品的无障碍与适老化升级;此次展会进一步探索"虚拟+实体"联动新链路,助力"全屋智能、全民可享"的行业愿景落地。

开幕式后,部分与会领导嘉宾前往各展区巡馆。在巡馆过程中,嘉宾亲身体验了AI技术在客厅、厨房、卫浴、入户和安防五大生活场景的创新应用,对各参展企业展示的技术成果给予高度评价。

群贤齐聚:四场高端论坛勾勒行业未来

博览会同期举办的系列高端论坛座无虚席,思想碰撞尤为热烈。作为主论坛的2025智家生态大会汇聚了TCL、海信、海尔、方太、萤石等企业高管,重点分享了在自研AI大模型、AI画质芯片及智能厨房生态系统等前沿领域的战略布局,勾勒出AI全面融入家庭生态的技术路径与产业未来。

2025半导体显示年会,则以"技术突破与生态协同"为主线,深入探讨了Mini/Micro LED、AR/VR微显示等下一代显示技术的创新与应用,期中《2025 MLED显示产业白皮书》和《车载Mini LED背光液晶显示屏通用规范》《Mini LED AM驱动通信协议》等四项团体标准也在年会上发布。此外,"数智驱动 链接未来"设计师论坛促进了智能产品与家居美学的融合对话;而首届AI智能锁行业发展峰会则通过发布团体标准与表彰领军产品,为智能锁行业的规范与创新树立了新的标杆。

展商风采:展示智能家居新生态

展期,各大展商纷纷亮出"镇馆之宝",以极具前瞻性的创新解决方案,深度诠释"智家生活"的无限可能。

显示技术:画质与体验的全面革新

海信聚焦高端显示展示了三大创新成果:RGB-Mini LED实现100% BT.2020色域覆盖,较QD-Mini LED、QD-OLED分别高19%、9%,能耗降低40%,结合超高色纯度与广视角实现色彩全面跃迁;163UX Micro LED电视以24mm薄机身贴墙,2488万颗晶芯配合自研技术实现精准控光与深邃画质;激光电视探索X1 Ultra集成IMAX同源技术与影院级音响,重新定义家庭影音标准,彰显其画质、能效与沉浸体验优势。

TCL以"智慧家电+全域物联"为核心参展:显示领域,旗舰SQD-Mini LED电视凭20000+级背光分区、10000nits峰值亮度及AI画质引擎树立标杆;智能家居端,鸿鹄图灵AI平台驱动小蓝翼新风空调、制冰冰箱实现主动服务,赋能AI人脸识别智能门锁通过3D结构光精准辨身份,全面展现影音娱乐、健康生活与安防保障的综合技术实力。

联发科重点展示旗舰5G智能AI芯片天玑9500系列,AI体验为核心升级方向。其端侧AIGC生图能力大幅进化,文生图、图生图均能通过端侧计算快速生成,且突破移动端低分辨率局限,支持4K高清画质输出,双NPU架构更实现性能与能效的双重优化。

作为微显示领军企业,芯视元展出最新硅基微显示芯片,涵盖LCoS、Micro LED等类型,是AR/VR眼镜、车载HUD等近眼设备核心部件。产品以超高亮度(单绿可达百万nit)、高对比度、低功耗为优势,可定制分辨率等参数,为元宇宙入口设备提供清晰视觉基础,强化虚拟场景沉浸感。

天马微电子聚焦商用与消费电子前沿显示,重点展出AMOLED显示屏及Micro LED透明屏。两款产品均具备超高亮度与全彩显示能力,可应对户外强光环境保持画面清晰,适配多元场景需求,展现其在显示技术领域的场景化创新实力。

厨卫智能化:AI赋能烹饪新体验

海尔卡萨帝展出搭载"AI之眼"的智慧厨房套系,通过统一AI视觉平台实现厨电协同。智能油烟机实时监测油温与烟雾自动调风量,联动智能灶识别沸腾状态控火力防溢锅,洗碗机自动匹配洗涤程序,全套系经智慧大屏集中控制,构建主动感知、智能决策的全场景体验;方太展示全链路厨房解决方案:全嵌冰箱凭575mm超薄零嵌设计与氮气保鲜科技延长食材保质期;水槽洗碗机X20 Max用高能气泡洗技术解决重油污问题;油烟机以智能增压技术实现强吸力与低噪平衡,融合嵌入式美学、健康保鲜与洁净科技;老板电器展示松露盐系套装G50,包含数字烟机、灶具、蒸烤炸箱等。核心内置AI中式烹饪算法,可精准复刻名厨火候,智能大屏提供步骤指导,将烹饪从经验主义转化为数据化过程。

智能安防:安全与便捷的完美结合

智能门锁展团规模空前,汇聚了萤石、凯迪仕、德施曼、鹿客科技等超过100个品牌,堪称行业风向标。现场可见,3D人脸识别、指静脉识别、智能猫眼、可视对讲已成为中高端产品的标配。各品牌在安全性、便捷性和智能化联动上展开激烈角逐。

AI元宇宙:虚拟与现实的边界融合

本届展会新增AI元宇宙板块,集中展示了人工智能与虚拟现实技术在各行各业的创新应用。展商类型涵盖光学显示制造、硅基微显示产业链、硬件终端、软件内容、平台运营等全产业链环节,代表性企业包括天马、芯视元、玩出未来、优链时代、屹境科文、Mix World、零次元、Ello Meta、元一宇宙、景秀子非、希盟科技等知名企业,共同打造从技术研发到商业落地的完整生态链,展示了AI元宇宙在文旅体验、教育办公、数字零售等场景中的前沿应用。展区通过互动体验、产品演示、技术讲解等多种形式,为观众提供了沉浸式了解元宇宙技术发展的平台,助力行业实现资源对接与商业增长。

观众齐聚:线上线下联动,打造全域观展体验

海外观众买家方面,来自欧美、东南亚、中东等地区的国际采购商组团到会,占比达观众总数的12%。展会现场特设国际采购对接专区,提供多语种商务服务及定制化对接活动。不少海外买家表示,中国智能家居产品的创新速度与性价比具有明显优势,尤其在AI家电、智能安防等领域采购意向明确,现场达成多项跨境合作意向。

大众消费者参与度空前高涨,占总人流约40%。为提升公众观展体验,展会设置智能家居体验区、新品试用区等互动空间,让消费者直观感受科技为生活带来的便利。许多家庭观众在现场体验后直接下单购买,反映出智能家居产品正从高端消费向大众日常生活渗透的趋势。

本届展会成功组织了多个专业观众团组,涵盖家装公司、设计师事务所、渠道经销商等专业群体。主办方为专业团组提供专属接待、动线规划、商务对接等定制服务,并举办多场闭门交流活动。这些专业观众不仅是产品的采购方,更是智能家居生态链的重要参与者,他们的深度参与为展会注入了强劲的专业活力。

线上传播通过"现场云逛展"和"KOL打卡探店"等形式,有效突破了地域限制。官方联合行业知名KOL,通过抖音、小红书、B站等平台进行多场直播与内容分发,带领线上观众"漫步"云端展厅,零距离、零时差地邂逅了海信、TCL、德施曼、凯迪仕等众多品牌展位。AI家居、AI厨卫、AI安防等智慧生活场景通过镜头徐徐展开,构成一场引人入胜的线上视觉盛宴。本次展会相关内容不仅创造了总观看量突破800万次、话题阅读量超2000万的传播效果,更成功将线上流量反哺线下——众多"云观众"在观看直播后心驰神往,随即亲临现场,续写其探索之旅。这种"线下体验+线上引流"的双轨模式,实现了展会影响力的指数级扩散与商业价值的有效转化。

行业趋势:AI驱动的智能家居新未来

本届2025上海国际智家生活博览会充分展现了智能家居行业的最新发展趋势。从技术层面看,AI大模型、5G芯片、微显示技术等核心技术的突破正在重塑产品形态;从应用层面看,从单品智能向全屋智能、从被动响应向主动服务的转变正在加速;从市场层面看,产品正从高端消费向大众市场渗透,从单一功能向场景化解决方案演进。

特别值得关注的是,"适老化"设计成为行业共识。随着人口老龄化加剧,智能家居企业正积极探索如何让老年群体也能便捷享受科技带来的便利。语音交互简化、大字体显示、远程协助等功能成为产品标配,体现了科技的人文关怀。

同时,"绿色环保"理念贯穿产品设计全流程。从材料选择到能源消耗,从生产工艺到回收利用,智能家居企业正全方位践行可持续发展理念,推出更多节能环保产品,助力实现"双碳"目标。

结语:智慧家居新时代的开启

本届2025上海国际智家生活博览会虽已圆满收官,但其展现的创新活力与广阔前景将持续影响行业发展。随着AI、5G、物联网等技术的深度融合,智能产品正不断突破形态边界,推动产业升级与体验革新,一个更加便捷、舒适与智慧的居家新时代正在我们眼前展开。未来,智能家居将从简单的设备互联走向真正的环境智能,从被动满足需求走向主动预测需求,从单一功能产品走向全场景解决方案,为人类创造更美好的生活体验。