OpenAI最近发布的GPT-5.1模型在AI领域掀起了一股新的讨论浪潮。这款最新版本的旗舰AI模型不仅带来了性能上的提升,更引人注目的是其引入的八种预设个性选项,试图在满足用户多样化需求与确保AI安全之间寻找微妙的平衡点。这一举措反映了OpenAI在AI发展道路上的深思熟虑,也揭示了当前AI技术面临的复杂挑战。

八种个性:满足多样化需求的尝试

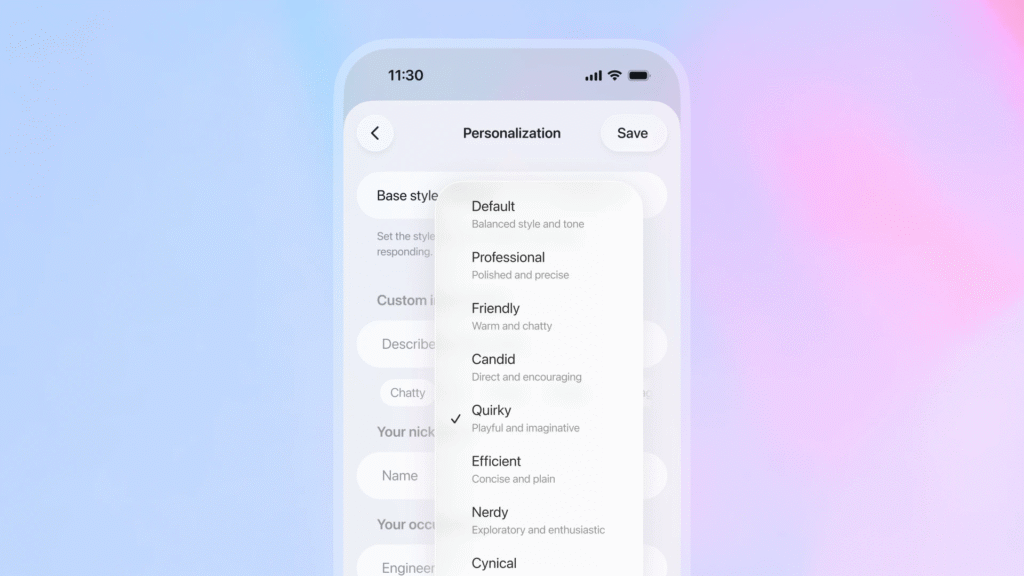

GPT-5.1最显著的变化在于其全新的个性系统。OpenAI为这款AI模型提供了八种预设选项:Professional(专业型)、Friendly(友好型)、Candid(坦率型)、Quirky(古怪型)、Efficient(高效型)、Cynical(愤世嫉俗型)、Nerdy(极客型)以及一个默认设置。这些选项通过向系统提示注入不同的指令来模拟不同的沟通风格,使AI能够根据用户需求调整其回应方式。

这种设计理念源于OpenAI对用户反馈的深刻理解。正如OpenAI应用业务负责人Fidji Simo在博客中所言:"随着超过8亿人使用ChatGPT,我们已经超越了'一刀切'的解决方案。人们以不同的方式体验ChatGPT,有些人想要直接中立的回应,而其他人则偏爱不同的输出模式。"

技术层面上,这些个性选项并不会改变模型的核心能力,而是通过调整系统提示中的指令来影响输出风格。这种设计既保持了AI模型的一致性和可靠性,又为用户提供了更多的个性化选择。

性能提升:技术背后的进步

除了个性系统的创新,GPT-5.1在技术性能上也取得了显著进步。OpenAI声称,新模型在数学和编程等技术基准测试中表现优于今年8月发布的GPT-5。具体而言,GPT-5.1 Instant将作为ChatGpt大多数任务的更快默认选项,而GPT-5.1 Thinking则是一个模拟推理模型,专门处理更复杂的问题解决任务。

特别值得一提的是,GPT-5.1 Instant引入了"自适应推理"功能,使模型能够自主决定在生成输出前花费多少计算时间处理提示。这种动态调整机制使AI能够根据问题的复杂程度灵活分配计算资源,从而在保持响应速度的同时提高输出质量。

OpenAI还计划逐步推出这些模型,首先面向付费用户,然后再扩展到免费用户。同时,公司承诺将明确传达模型淘汰周期,给予用户充分的适应时间。这种负责任的产品发布策略反映了OpenAI在快速迭代与用户需求之间的谨慎平衡。

个性化与安全的两难困境

OpenAI面临的挑战远不止技术层面的优化。在过去的几年中,公司一直在AI个性化与安全性之间寻找平衡点。这一困境在GPT-5.1的设计中表现得尤为明显。

一方面,用户对AI模型的沟通风格有着截然不同的需求。早期的GPT模型因其过度乐观和奉承而受到批评,用户反映这些AI助手表现得"过于积极向上"。然而,当OpenAI调整默认输出风格以回应几起自杀诉讼后,又引发了另一部分用户的不满。

这种两极化的反馈反映了用户群体对AI助手期望的多样性。对于寻求编程帮助或专业建议的用户来说,直接、客观的回应可能更为合适;而对于那些将AI视为虚拟陪伴的用户来说,温暖、个性化的互动则更为重要。

另一方面,过度个性化可能带来潜在的心理健康风险。Simo在博客中警告:"如果个性化只是强化你的世界观或告诉你想听的话,那将没有帮助。"她将过度个性化比作修改伴侣特质使其永远同意你的观点,并指出:"我们生活中最好的人是那些倾听和适应我们,但也挑战我们并帮助我们成长的人。"

心理健康风险的应对

OpenAI对AI可能带来的心理健康问题有着清醒的认识。公司最近发布的安全研究详细说明了其计划应对那些对其AI聊天机器人产生不健康依赖的用户。尽管OpenAI声称这种情况"罕见",但公司正在与专家委员会和心理健康临床医生合作,研究AI模型健康互动的标准。

问题的根源在于AI聊天机器人仍然假装是一个人——一个持续存在的实体,能够认识你并随时间学习你的偏好。它承担起人类情感的角色,表现得好像理解你并同情你所经历的一切,这可能导致用户陷入过去反复出现的棘手情况。

OpenAI的处境十分微妙。当公司改变ChatGPT的输出风格过于保守和机械时,会遭到一部分用户的投诉;当模型过于温暖时,又会引发专家对其可能影响弱势用户的担忧。新的个性选择是OpenAI尝试平衡广泛用户需求的一种努力,这些用户以截然不同的用例接近其聊天机器人,从编程协助到成为虚拟挚友。

商业与伦理的平衡艺术

在商业模式上,OpenAI面临着根本性的张力:既要使AI模型足够引人注目以实现广泛采用,又要避免可能变得有害的用户行为。Simo在她的博客文章中 addresses了其中一些担忧:"我们还必须警惕某些人可能对其模型产生依赖,从而损害他们的现实世界关系、健康或义务。"她承认:"随着这项技术的发展和人们以新方式使用它,将会有许多新的挑战。在这个规模上构建意味着永远不要假设我们拥有所有的答案。"

这种坦诚的态度反映了OpenAI对AI技术复杂性的认识。随着AI模型变得越来越强大和个性化,公司需要不断调整其策略,以应对可能出现的新挑战。

用户反馈的深层含义

用户对AI模型反馈的多样性揭示了更深层次的社会心理因素。一方面,人们渴望被理解和接纳,这解释了为什么许多用户喜欢"温暖"、"个性化"的AI互动;另一方面,人们也需要挑战和成长,这解释了为什么另一些用户更喜欢直接、客观的回应。

这种需求多样性反映了人类社会的复杂性。AI模型作为工具,其设计应当能够适应这种多样性,而不是试图将所有人塞进同一个模式中。GPT-5.1的个性系统正是基于这种认识而设计的。

技术实现与用户体验的平衡

从技术角度看,GPT-5.1的个性系统实现了一种巧妙的平衡。通过在系统提示中注入不同的指令,OpenAI能够在不改变模型核心能力的情况下调整输出风格。这种方法既保持了技术的一致性,又为用户提供了个性化的体验。

此外,OpenAI还正在实验从个性化设置调整特定特征的选项,包括回应的简洁程度和模型生成表情符号的频率。ChatGPT还可以在对话中检测到用户请求特定的输出模式时,主动提议更新这些设置。这种动态调整机制进一步增强了用户体验的个性化和适应性。

未来展望:AI个性化的发展方向

GPT-5.1的个性系统代表了AI个性化发展的重要一步。然而,这仅仅是一个开始。随着AI技术的不断进步,我们可以预见更加精细和个性化的AI交互体验。

未来的AI模型可能会更加深入地理解用户的个人偏好、情感状态和认知风格,从而提供更加定制化的服务。同时,AI系统也需要建立更加完善的伦理框架,确保个性化不会导致信息茧房或强化偏见。

OpenAI在这方面的探索将为整个行业提供宝贵的经验。如何在满足用户个性化需求的同时确保AI的安全性和伦理性,将是未来AI发展面临的核心挑战之一。

结论:平衡的艺术

GPT-5.1的推出标志着OpenAI在AI个性化与安全性之间寻找平衡点的又一次尝试。通过引入八种预设个性选项,公司试图满足不同用户群体的需求,同时应对AI可能带来的心理健康风险。

这一举措反映了OpenAI对AI技术复杂性的深刻理解,以及其对用户需求的敏锐洞察。然而,AI个性化与安全性之间的平衡是一个动态的过程,需要随着技术发展和用户反馈不断调整。

随着AI模型变得越来越强大和个性化,OpenAI和整个行业都需要持续探索如何在满足用户需求的同时确保AI的安全性和伦理性。这不仅是一个技术挑战,更是一个社会和伦理挑战,需要技术开发者、政策制定者和社会各界共同努力来解决。