在数字购物体验的持续演变中,Google正通过其AI搜索模式(AI Mode)掀起一场革命性的变革。随着生成式AI技术的快速发展,Google正在将这一前沿技术深度整合到在线购物领域,推出对话式购物、智能结账等一系列创新功能,旨在为消费者提供更个性化、更便捷的购物体验,同时为自身开辟新的收入渠道。

对话式购物:AI搜索模式的购物革新

Google在2025年5月的I/O大会上首次宣布了将对话式购物引入AI搜索模式的计划。根据Google的描述,其庞大的"购物图"(Shopping Graph)或零售商数据使其AI能够提供独特的有用建议。在过去的几个月里,Google一直承诺将生成式AI注入在线购物体验,而现在这一承诺正在变为现实。

AI驱动的购物决策

在接下来的几周内,美国用户将能够向AI搜索模式提出关于购买什么产品的复杂问题,系统将提供建议、指南、表格和其他生成内容来帮助用户做出决策。这种交互式购物体验代表了传统搜索方式的重大转变,从简单的产品列表展示转变为智能对话式购物助手。

Google的AI购物功能不仅仅是简单的产品推荐,而是能够理解复杂的购物需求,提供个性化的购物建议。例如,用户可以询问"我想为喜欢徒步旅行的父亲寻找一款适合60岁人群的防水背包,预算在200美元以内,最好有多个口袋和舒适的背带",AI将能够理解这些具体需求并提供符合条件的产品推荐。

广告模式的整合

一个关键问题是用户将在这些体验中看到赞助的购物内容。Google表示,AI搜索模式中出现的部分内容将是广告,就像在传统搜索中查看购物结果一样。目前这一功能仍在测试阶段,用户可能看不到广告、看到多种风格的广告,或者根本看不到广告。

这种广告整合方式引发了关于AI搜索结果透明度和用户隐私的讨论。Google需要确保广告与有机内容的区分足够明显,同时保持AI推荐的相关性和有用性。平衡商业利益和用户体验将成为Google在这一领域成功的关键。

Gemini应用的购物功能

除了在搜索结果中提供购物功能外,Google还将这些功能引入了Gemini应用。不过,Google表示目前Gemini应用的结果中不会包含赞助内容。这种差异化的策略可能是为了测试不同平台上的用户接受度和广告效果。

智能结账:"代理式结账"功能

Google还发布了一项名为"代理式结账"(agentic checkout)的功能,这一功能在I/O大会上与AI搜索模式购物一同宣布时只是简单提及。现在,Google正在大力推广这一代理式功能。

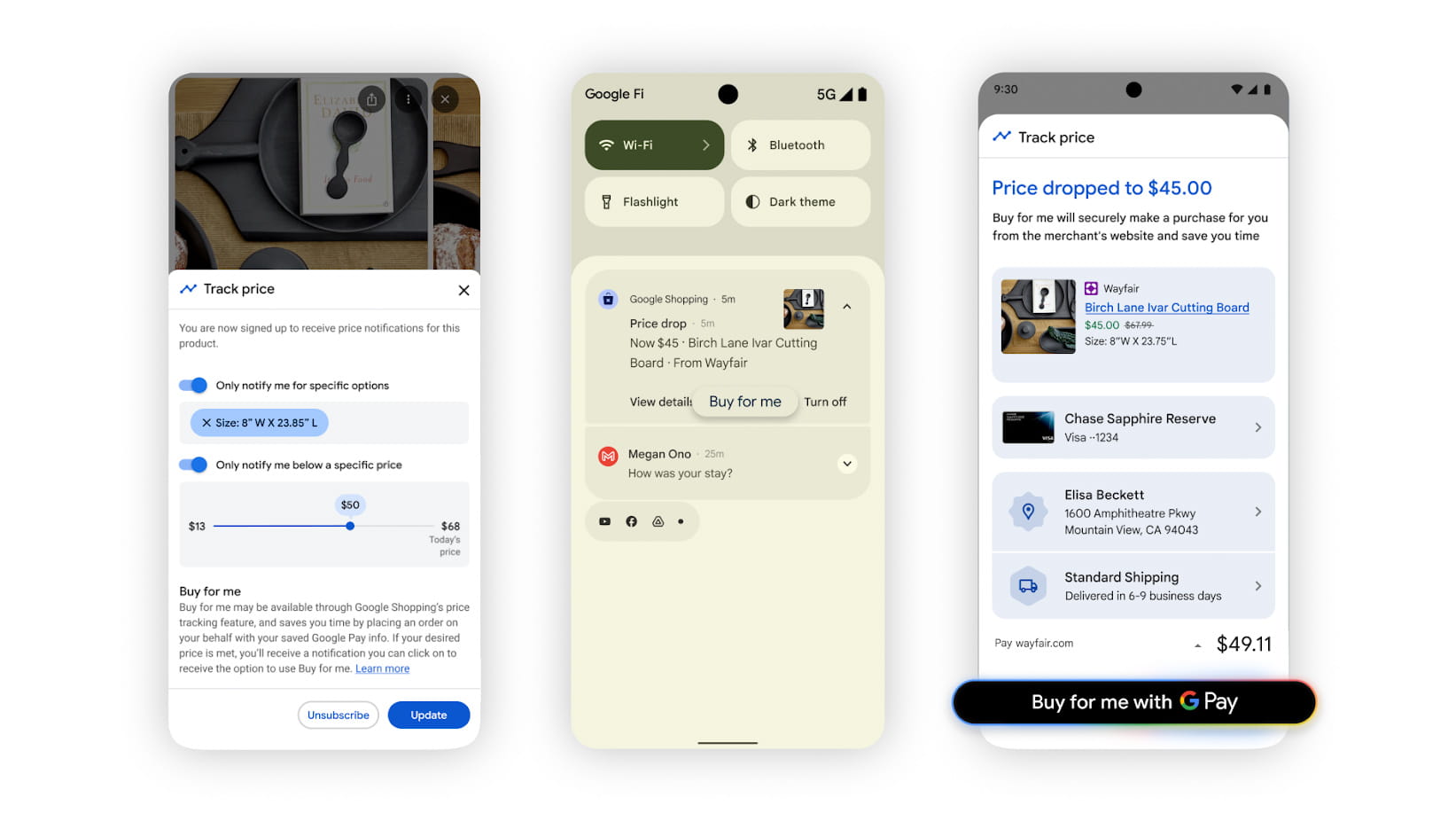

价格监控与自动购买

代理式结账的基本功能是用户可以在搜索中为产品设置价格阈值,Google会在产品达到该价格时通知用户。这一功能本身并不新鲜,但现在加入了AI元素。收到通知后,用户可以使用Google Pay授权自动购买。

目前,这一功能仅得到少数零售商的支持,如Chewy、Wayfair和一些Shopify商家。Google表示,这一功能之所以被称为"代理式",是因为系统能够将网站上的视觉信息转化为行动,如选择正确的款式、尺码和颜色,添加到购物车并完成购买。

技术实现与用户体验

代理式结账的技术实现涉及多个复杂步骤:从识别产品页面上的价格信息,到与用户设置的价格阈值进行比较,再到触发购买决策。这一过程中,AI需要准确理解产品信息、价格变动和用户偏好,同时确保交易的安全性。

对于用户而言,这一功能可以节省大量时间和精力,特别是在价格波动较大的产品类别中。例如,购买电子产品时,用户可以设置理想价格,无需持续监控价格变化,一旦达到目标价格,系统即可自动完成购买。

Duplex的回归:AI电话助手

在当前的AI热潮之前,Google曾热衷于展示Duplex——一款基于Assistant的AI设计,旨在通过电话执行现实世界任务。Google当时认为人们会愿意信任AI来查询营业时间和预约,但这一功能并未获得太多关注。多年来,Duplex的提示逐渐从Assistant中消失。

更新后的Duplex功能

现在,Duplex带着Google所称的"大型Gemini模型升级"回归。它不会再为用户预约,但Google仍计划使用更新后的Duplex允许用户致电商家。这次,Duplex旨在让用户免于打电话给商店检查库存情况。相反,用户可以告诉机器人想要什么,机器人将代为查询。

当用户搜索附近某些产品时,将看到"让Google致电"的选项。用户需要指定想要的具体产品,机器人将开始拨打电话。机器人拨打电话时会表明自己的身份,这些电话仅在工作时间内且在合理的冷却期后才会进行。如果商家感到过于困扰,他们可以选择退出Duplex电话服务,这仍然是一个选项。

购物查询的AI总结

最终,用户将收到包含电话AI摘要的电子邮件或短信,这些摘要可能帮助用户决定去哪里购买。这些消息还可能基于Google的购物图包含来自附近其他商店的本地库存数据。这听起来可能意味着更多的赞助链接,但目前尚不清楚。这一功能今天开始在玩具、化妆品和电子产品等类别中推出,不出所料,这一功能也仅限美国使用。

技术挑战与隐私考虑

Google的AI购物功能虽然前景广阔,但也面临着多项技术挑战和隐私考虑。

数据安全与隐私保护

AI购物功能需要访问大量用户数据和个人购物偏好,这引发了关于数据安全和隐私保护的担忧。Google需要确保用户数据的安全存储和合理使用,同时提供透明的数据使用政策和用户控制选项。

特别是对于代理式结账功能,用户授权系统自动完成购买决策,这意味着系统需要访问用户的支付信息和购物偏好。Google必须建立强大的安全措施来保护这些敏感信息,防止未经授权的访问和滥用。

算法偏见与公平性

AI推荐系统可能存在算法偏见,导致某些产品或商家获得不成比例的曝光。Google需要确保其AI购物算法公平对待所有商家,避免创造新的市场垄断或不公平竞争环境。

此外,AI推荐系统需要考虑用户的多样化需求,避免"过滤气泡"效应,即用户只看到符合其现有偏好的产品,而错失其他可能感兴趣的选择。

对零售业的影响

Google的AI购物功能不仅改变了消费者的购物方式,也对零售业产生了深远影响。

中介角色的转变

传统上,搜索引擎和电商平台在消费者和零售商之间扮演中介角色,提供产品信息和购买渠道。Google的AI购物功能进一步强化了这一中介角色,通过AI直接参与购物决策过程。

对于零售商而言,这意味着需要适应AI驱动的购物环境,优化产品信息和描述以适应AI的理解,同时考虑如何在这一新生态中保持竞争力。

小商家的机遇与挑战

对于小型商家来说,Google的AI购物功能既带来机遇也带来挑战。一方面,AI推荐系统可能帮助小商家获得更多曝光,特别是当他们的产品符合特定用户需求时。另一方面,大型零售商可能利用其规模优势在AI推荐中获得更多青睐。

此外,小商家可能需要投入更多资源来优化其在线存在和产品信息,以适应AI系统的要求。这可能包括改进产品描述、图片质量、价格策略等方面。

未来展望

Google的AI购物功能代表了电子商务和AI技术融合的前沿探索。随着这些功能的不断发展和完善,我们可以预见以下几个趋势:

更个性化的购物体验

未来的AI购物助手将能够更深入地理解用户的个人偏好、购物习惯和生活方式,提供高度个性化的购物建议。这种个性化不仅基于用户的搜索历史和购买记录,还将考虑用户的社交关系、兴趣爱好和价值观等因素。

例如,AI购物助手可能能够理解用户的环保价值观,优先推荐可持续发展的产品;或者根据用户的健身目标,推荐适合的运动装备和营养补充剂。

多模态交互体验

未来的AI购物体验将更加注重多模态交互,结合文本、语音、图像和视频等多种形式,为用户提供更丰富的购物体验。用户可以通过拍照上传产品图片寻找类似商品,或者通过语音描述需求获得AI推荐。

此外,AR(增强现实)技术可能与AI购物功能结合,允许用户在购买前虚拟试穿衣物或家具,进一步提升购物体验的沉浸感和实用性。

跨平台购物生态系统

Google的AI购物功能可能发展成为一个跨平台的购物生态系统,整合搜索、社交媒体、电子商务平台和实体零售等多种渠道。用户可以在不同平台间无缝切换,享受一致的AI驱动的购物体验。

这种生态系统将打破传统购物渠道的界限,创造全新的购物模式。例如,用户在社交媒体上看到朋友推荐的产品,可以直接通过AI助手完成购买,无需跳转到其他平台或网站。

结论

Google推出的AI搜索模式购物功能,包括对话式购物、代理式结账和更新的Duplex技术,代表了电子商务和AI技术融合的重要一步。这些功能不仅为消费者提供了更便捷、更个性化的购物体验,也为Google开辟了新的收入来源。

然而,这些创新功能也面临着技术挑战、隐私考虑和对零售业的深远影响。Google需要在商业利益和用户体验之间找到平衡,确保AI购物功能能够真正为用户创造价值,同时保护用户隐私和数据安全。

随着这些功能的不断发展和完善,我们有理由相信AI将在未来的购物体验中扮演越来越重要的角色,重塑消费者与零售商之间的互动方式,创造全新的购物生态系统。对于消费者而言,这意味着更智能、更便捷的购物体验;对于零售商而言,则需要适应这一变革,重新思考如何在AI驱动的购物环境中保持竞争力。