在科技飞速发展的今天,2025年的产品市场呈现出前所未有的创新活力。从人工智能到可穿戴设备,从智能家居到虚拟现实,每一款产品都代表着技术的前沿突破。本文将深入剖析这些改变生活方式的创新产品,探讨它们如何与时代共振,成为科技爱好者的心头好。

人工智能:重新定义智能交互

2025年,人工智能技术已经从实验室走向日常生活的方方面面。最新一代的AI助手不仅能够理解复杂的指令,还能预测用户需求,提供个性化的服务体验。

这些AI产品采用了先进的自然语言处理技术和深度学习算法,能够进行多轮对话,理解上下文,甚至识别用户的情绪状态。例如,最新的智能家居中枢系统能够根据家庭成员的习惯自动调整家居环境,创造个性化的舒适空间。

AI在医疗领域的突破

在医疗健康领域,AI技术的应用尤为突出。2025年推出的健康监测设备能够实时分析用户的生理数据,预测潜在健康风险,并提供个性化的健康建议。这些设备结合了可穿戴技术和边缘计算,实现了数据的实时处理和分析,大大提高了健康管理的效率和准确性。

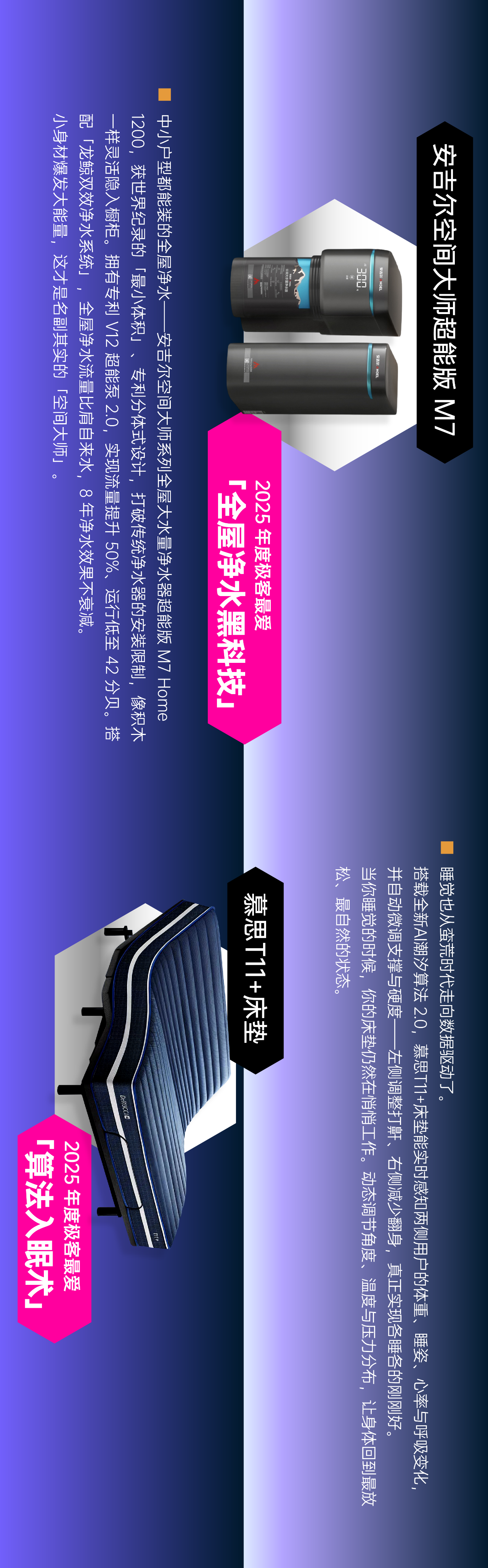

智能家居:无缝连接的生活体验

智能家居系统在2025年迎来了质的飞跃。最新的家居生态系统不再是简单的设备联网,而是真正实现了场景化的智能生活体验。

全屋智能解决方案

2025年的全屋智能解决方案采用了分布式计算和边缘AI技术,使家居设备能够自主协作,无需用户频繁干预。例如,当系统检测到用户回家时,会自动调整灯光、温度、音乐等,创造舒适的环境。

这些系统还整合了能源管理功能,能够根据用电习惯和电价波动,智能调整设备运行时间,实现节能减排。数据显示,采用这类智能系统的家庭平均可减少30%的能源消耗。

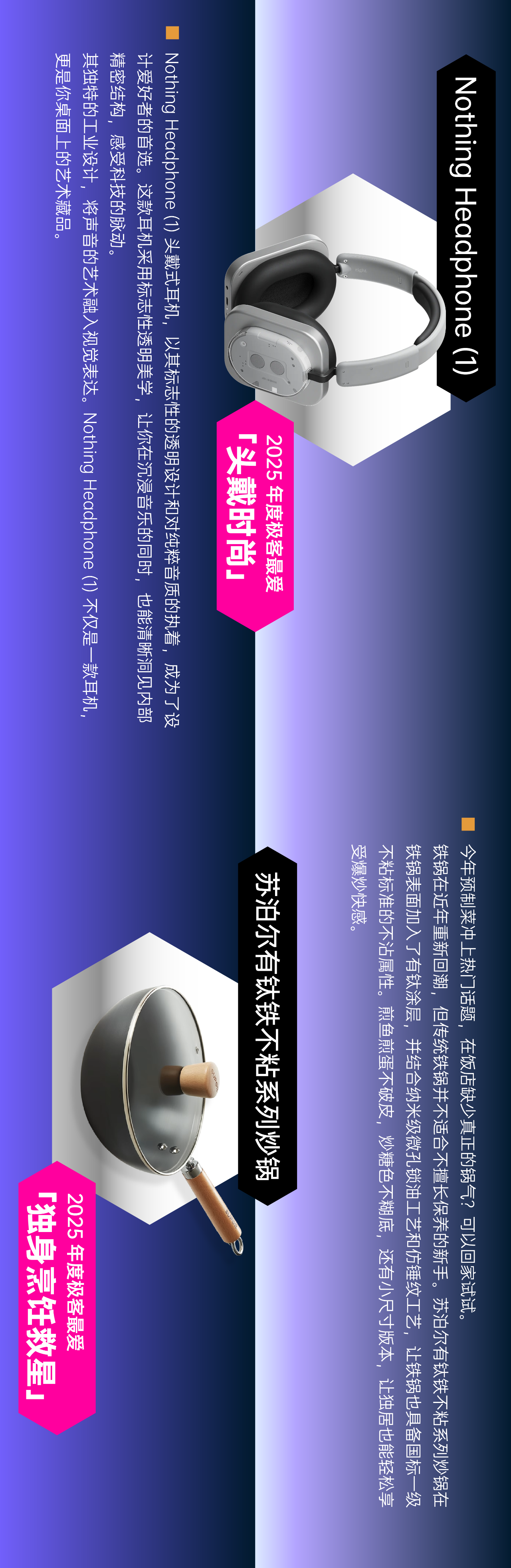

可穿戴设备:健康与时尚的完美结合

2025年的可穿戴设备已经超越了传统的计步器和心率监测功能,成为个人健康管理的综合平台。

健康监测技术的革新

最新的可穿戴设备集成了多种生物传感器,能够监测血糖、血压、血氧饱和度等多项健康指标。这些设备采用无创检测技术,用户只需佩戴即可获得全面的健康数据。

特别值得一提的是,这些设备还具备早期疾病预警功能。通过长期监测生理数据的变化,AI算法能够识别潜在的健康风险,及时提醒用户采取预防措施。据临床数据显示,这类早期预警系统能够将某些疾病的早期发现率提高40%。

虚拟现实与增强现实:开启数字世界新篇章

2025年,虚拟现实(VR)和增强现实(AR)技术已经成熟,为用户带来了前所未有的沉浸式体验。

轻量化与高清晰度的完美平衡

新一代VR头显设备采用了先进的显示技术和光学设计,实现了轻量化与高清晰度的完美平衡。这些设备重量不足200克,却能够提供4K分辨率的清晰画面,大大减轻了长时间佩戴的不适感。

在AR领域,2025年的产品已经实现了真正的虚实融合。通过先进的计算机视觉技术,AR设备能够精确识别环境中的物体,并将虚拟信息无缝融入现实世界。例如,在购物时,AR眼镜可以实时显示产品的详细信息和使用评价,帮助用户做出更明智的购买决策。

电动汽车:智能出行的未来

2025年的电动汽车已经不再是简单的环保交通工具,而是集成了最新科技的智能移动平台。

自动驾驶技术的普及

2025年,L4级自动驾驶技术已经在中高端电动汽车上普及。这些车辆配备了先进的传感器和AI系统,能够在大多数路况下实现自动驾驶,大大减轻了驾驶负担。

此外,电动汽车还与智能家居系统深度整合,形成了完整的智能出行生态。例如,车辆可以根据日程安排自动充电,并在出发前调整车内温度,为用户提供最佳出行体验。

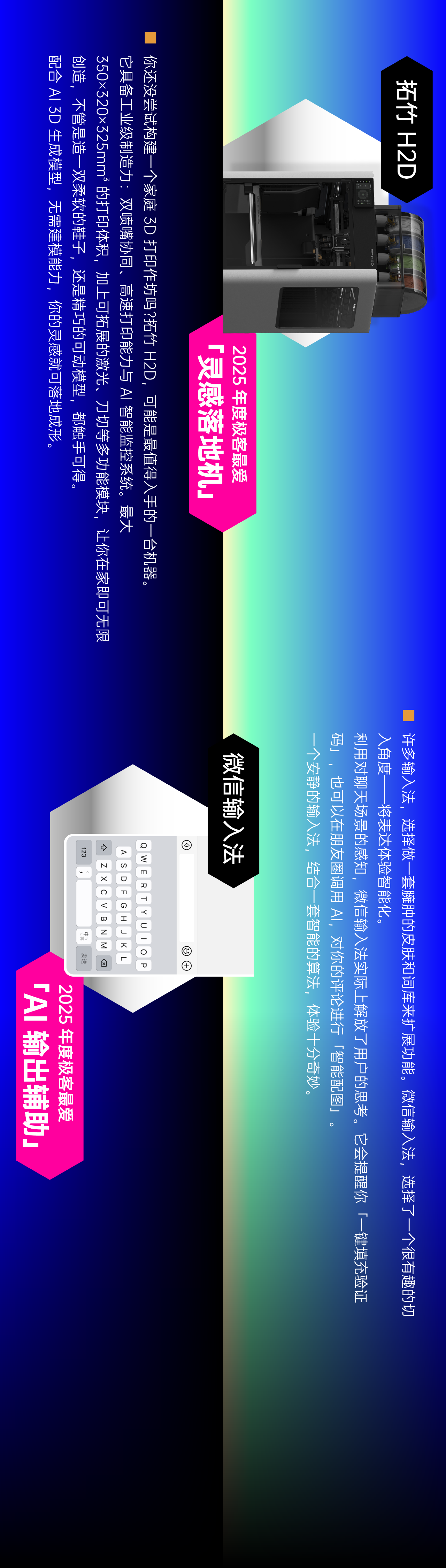

智能办公:提升工作效率的革命

2025年的智能办公设备重新定义了工作方式,为远程办公和团队协作提供了全新解决方案。

AI驱动的办公助手

最新的智能办公系统配备了AI助手,能够自动整理日程、安排会议、处理邮件,甚至提供决策建议。这些系统通过学习用户的工作习惯,不断优化工作流程,显著提高工作效率。

在远程协作方面,2025年的技术实现了近乎真实的虚拟会议体验。通过先进的空间音频和高清视频技术,远程参与者能够感受到如同面对面交流的效果,大大增强了团队协作的效率。

智能娱乐:沉浸式体验的极致追求

2025年的智能娱乐设备为用户带来了前所未有的沉浸式体验,重新定义了娱乐方式。

个性化内容推荐

基于AI的智能娱乐系统能够精准分析用户的喜好,提供个性化的内容推荐。这些系统不仅考虑用户的观看历史,还分析用户的情绪状态和观看环境,推荐最适合的内容。

在游戏领域,2025年的游戏设备实现了真正的物理交互。通过先进的触觉反馈技术和空间感知,玩家能够获得前所未有的沉浸式游戏体验。例如,在赛车游戏中,玩家能够感受到不同路面的细微差异,大大增强了游戏的真实感。

智能厨房:科技与美食的完美融合

2025年的智能厨房设备将科技与烹饪艺术完美结合,为家庭烹饪带来革命性的变化。

精准烹饪控制系统

最新的智能厨房配备了精准的烹饪控制系统,能够精确控制温度、湿度和烹饪时间,确保每一道菜都能达到最佳口感。这些系统还配备了AI食谱推荐功能,能够根据食材库存和用户喜好,推荐最适合的菜谱。

此外,智能厨房还整合了营养分析功能,能够实时计算菜品的营养成分,帮助用户制定健康的饮食计划。对于有特殊饮食需求的人群,如糖尿病患者,这些系统还能提供个性化的饮食建议。

智能安防:全方位的安全保障

2025年的智能安防系统已经从简单的监控设备发展为全方位的安全保障体系。

AI驱动的异常检测

最新的智能安防系统采用AI技术进行异常检测,能够识别潜在的安全威胁。这些系统不仅能够检测入侵行为,还能识别火灾、漏水等紧急情况,并及时发出警报。

此外,智能安防系统还整合了生物识别技术,如人脸识别和指纹识别,提供高级别的安全保障。这些系统还支持远程监控,用户可以通过手机应用随时查看家中的安全状况。

结语:科技与生活的和谐共生

2025年的科技产品已经不再是简单的工具,而是成为人们生活中不可或缺的伙伴。这些产品通过人工智能、物联网、大数据等先进技术,重新定义了人与科技的互动方式,创造了更加智能、便捷、舒适的生活体验。

未来,随着技术的不断进步,我们有理由相信,科技产品将继续深入生活的方方面面,为人类带来更多惊喜和可能。作为科技爱好者,我们应该保持开放的心态,积极拥抱这些创新产品,共同创造美好的未来。