引言:AI语音的可用性革命

2025年,AI语音技术已经悄然完成了从实验室到商业应用的华丽转身。当我们接到AI销售电话时,不再经历过去那种机械僵硬的对话;NotebookLM引领的AI播客产品层出不穷;AI口语陪练App正在创造可观的商业价值;AI虚拟伙伴和虚拟主播已成为数字内容的新生力量。这些现象背后,是一个新兴赛道的崛起——Voice Agent(语音智能体)正在快速渗透各行各业。

这一波渗透浪潮让人们直观感受到AI语音的「可用性」——它不再是遥不可及的未来技术,而是已经能创造商业价值的实用工具。然而,当行业试图将这些Voice Agent从早期尝鲜阶段推向大规模、高标准的商业场景时,问题也随之浮现:AI语音系统已经到达可用的地步,但这并不等于技术已经稳定好用。

Voice Agent:AI时代的交互界面

语音交互的自然优势

Voice Agent本质上是一个「能说话的智能体」——用户开口说话,它理解、回应、执行,一切都像在和人交谈。与文本交互相比,语音的优势是压倒性的:

- 更自然:符合人类本能的交流方式

- 更高效:比文字更快,适合即时沟通

- 更有温度:能传递情感,更容易建立连接

早期AI产品的成功已经证明了这一点。例如AI女友应用Dolores的开发者发现,平台上70%的收入都来自于语音购买,开发者感叹道:「人们真的会为那几句逼真的"我爱你"付费。」

商业场景中的价值

对企业而言,Voice Agent意味着「成本更低、速度更快、更可靠的服务」:

- 24/7在线客服:银行、保险、物流AI客服

- 智能车载助手:导航、空调控制等功能

- 医疗辅助:帮助医生自动生成病例记录

技术突破的推动

Voice Agent的爆发,源于底层技术的突破。自2023年开始,TTS技术被广泛应用于配音、数字分身、语音助手等领域,呈现爆发式增长。这背后是模型架构的革新,尤其是基于AR Transformer等新架构的出现,让语音合成的自然度和表现力达到了新的高度。

硅谷顶级风投a16z近期发文表示,Voice Agent正在成为「AI时代的交互界面」和「下一代SaaS入口」。

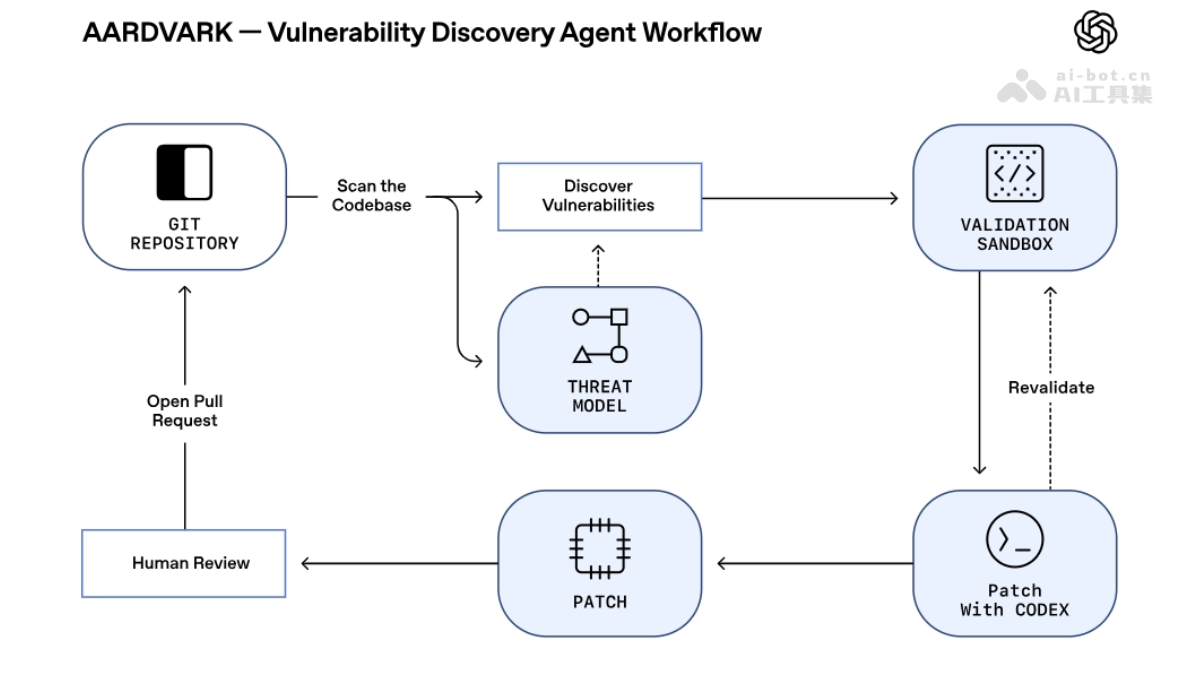

Voice Agent的技术架构

一个完整的Voice Agent交互通常包含三个核心模块:

- 语音识别(ASR):负责「倾听」,将用户语音转换为文本

- 大语言模型(LLM):作为「大脑」,理解文本意图并生成回应

- 语音合成(TTS):作为「嗓音」,将文本答案转换为自然语音

如今,语音识别的准确率已经非常高,大模型的差距也在缩小,真正的竞争已转向交互的「最后一公里」——那副负责「开口说话」的嗓音,也就是TTS模型。

TTS的关键作用

TTS是交互的最后一环,直接决定了用户的主观体验。一个普遍的误解是,TTS只要「清晰可闻」就足够了。但在真实的商业场景中,这远远不够。决定一个Voice Agent成败的,从来不是单纯的清晰度,而是交互是否自然、可信、顺畅。

Voice Agent面临的核心挑战

延迟:交互体验的生死线

语音交互对实时性的要求极高。保险电销的实测数据表明:AI坐席必须在客户说完1秒内接话,否则「机器感」就会瞬间出现。传统语音链路(ASR+LLM+TTS)是串行处理,每一步都要等上一步结束,延迟常常高达2~3秒——在真实对话中几乎不可接受。

拟人感:建立连接的灵魂

一段富有情感的声音,能瞬间建立陪伴感与黏性:

- C端用户:追求沉浸与共鸣,机械音足以让人出戏

- B端企业:依赖语气的自然与可信,才能传递专业形象

拟人感也包括足够聪明——比如,AI客服需要读出max-support@tech.com。一个「笨」的TTS会念成「max减...」,而「聪明」的TTS则会读成「max"杠"...」。这不仅考验模型的语音理解能力,也依赖于丰富的本地语言数据去支撑训练。

细节决定成败

不同的TTS在表面上似乎差别不大,但真正的差异藏在细节里——只有开发者才感受得到,而用户的留存,正是被这些细节一点点改变的。哪怕只是降低一秒延迟,用户也可能因此留下。

为Voice Agent而生:MiniMax Speech 2.6

在语音生成这条赛道上,MiniMax一直是榜单常客——AA、Hugging Face榜单第一已成常态。近期发布的Speech 2.6模型,专为Voice Agent打造,交出了一份更惊艳的答卷。

超低延迟:打破交互瓶颈

Speech 2.6将首包(First-packet)响应时间压缩到了250毫秒。这意味着从AI的LLM大脑「想」完答案,到TTS「开口」说出第一个字,中间的停顿几乎符合人类的生理感知极限。这为实现真正流畅、可打断的实时对话流提供了最关键的技术前提。

据行业测试披露,虽然11Labs官方声称其延迟可达75毫秒,但根据北美客户的实际测试,在真实网络环境下的首包延迟也在200到300毫秒区间。从这个角度看,Speech 2.6的250毫秒,是一个在真实商业环境中可稳定复现的、极具竞争力的低延迟数据。

智能文本解析:提升专业度

Speech 2.6能够正确读出电话、邮箱、网址、数学公式等结构化文本,这对B端开发者来说价值巨大。过去,当LLM需要播报一个邮箱或网址时,开发者必须在TTS上游额外搭建一套繁琐的文本预处理规则库,用正则表达式或硬编码,手动「翻译」文本,否则模型就会出错。

当模型更聪明,B端厂商和开发者的技术栈就被极大简化了,显著降低了文本准备的复杂度和维护成本。

流畅声音复刻:突破素材限制

在声音复刻技术上,Speech 2.6新增的Fluent LoRA模型,能够智能修正不流利的素材(如结巴、口音、非母语),复刻出流利、自然的表达。这极大拓宽了声音复刻的可用素材范围,让B端厂商在追求个性化音色的同时,不必再为素材的「不完美」而妥协。

多语言支持:全球化布局

Speech 2.6支持四十多个语种,为需要构建全球化产品的AI出海团队提供了坚实的底层支持。MiniMax这种为B端落地扫清障碍的思路,不仅体现在「音色流畅度」这种精细的「深度」上,也体现在「多语种覆盖」的「广度」上。

谁掌握声音,谁就掌握下一代AI商业化的钥匙

大模型的技术竞赛已经进入了下半场。如果说过去两年的主题是「炼大脑」——比拼的是谁的LLM更智能、参数更高、跑分更强——那么现在,人们除了关心模型的智能能力,也关注正在谁的商业化能力更强。

当Voice Agent正在成为下一代AI商业化的入口,在这场「Voice-First」浪潮中,LLM负责「想」,TTS负责「说」。AI想得再聪明,也得说得自然,才能被人真正接受。谁能掌握更拟人、更低延迟的语音能力,谁就更有机会拿到商业化的「入场券」。

MiniMax的技术底蕴

MiniMax在「声音」这个关键的技术赛道上,早已是头部玩家。它的技术底蕴来自于对底层架构的自研——基于AR Transformer模型的高质量TTS系统。这种架构选择使其在语音的自然度、表现力和多语种支持上获得了先天优势。

开发者生态布局

在开发者生态上,MiniMax的布局同样稳健。海外多家主流Voice Agent基础设施平台已将其语音能力接入:包括曾为ChatGPT高级语音模式提供工具的LiveKit、GitHub热门开源框架Pipecat,以及YC孵化的语音部署平台Vapi。对这些底层平台而言,接入哪个TTS API,本身就是对其性能与稳定性的认可。

国内商业应用

在国内,MiniMax的语音能力也深度融入多个商业场景:从Rokid Glasses等AR设备,到荣耀、魅族等智能终端,再到AI玩具Bubble Pal;从超级小爱、纳米AI搜索、Key AI、MegaView AI助手到Fuzozo平台;乃至教育与垂直领域的听力熊、精准学——几乎所有语音交互形态,都能听到MiniMax的声音。

从「声音好听」到「声音能落地」

一个值得思考的问题是:一个技术指标早已登顶、同时被海内外「基础设施」和「终端产品」双重验证的语音模型,为什么还要专门为Voice Agent再做优化?

答案或许是——正因为有过大量落地实践,MiniMax比别人更早、更清晰地看到了Voice Agent场景的真正痛点。

Speech 2.6的发布,正标志着MiniMax先于其他公司的关注点转变:从「声音好听」,迈向「声音能落地」。

「好听」是一项技术指标,关乎音质、韵律与自然度,但要真正落地,还要解决更复杂的问题:延迟、智能与拟人。它解决的是开发者在落地时最棘手的问题,是AI Agent能否摆脱「机器感」、实现「专业度」的临门一脚。

通过在底层引擎中内嵌「智能化」和「流利性」,Speech 2.6极大地释放了上层开发者的生产力。开发者不再需要耗费巨额成本去搭建繁琐的文本预处理规则,也不再需要为不完美的复刻素材而苦恼。

通过提供一个更快、更聪明、更流畅、更全面的语音底层,MiniMax正在为整个Voice Agent赛道「减负」——让开发者能更专注于LLM的业务逻辑与场景创新。

结语:语音AI的未来

在大模型竞争的下半场,谁能为下一代交互——Voice Agent提供最无缝、最自然、最智能的声音交互,谁就掌握了商业化的钥匙。而MiniMax看起来,正在握紧这把钥匙。

AI语音技术的未来,不仅是让机器「能说话」,更是让它们「像人说话」。这种看似微妙的转变,将彻底重塑人类与AI的交互方式,开启人机协作的新篇章。从客服到伴侣,从助手到导师,AI的声音将成为数字世界中无处不在的桥梁,连接技术与人性,连接现在与未来。

随着Speech 2.6这样的技术突破,我们正站在AI语音革命的门槛上,一个更加自然、智能、有温度的AI交互时代即将到来。