在人工智能领域,有一个看似显而易见的共识:高质量训练数据会带来更好的模型性能。然而,最新研究揭示了一个令人担忧的现象——使用低质量数据训练AI模型可能导致类似人类"脑损伤"的认知能力下降。这项由德克萨斯A&M大学、德克萨斯大学和普渡大学研究人员进行的研究,为AI训练数据质量控制敲响了警钟。

研究背景:从"人类脑损伤"到"AI脑损伤"

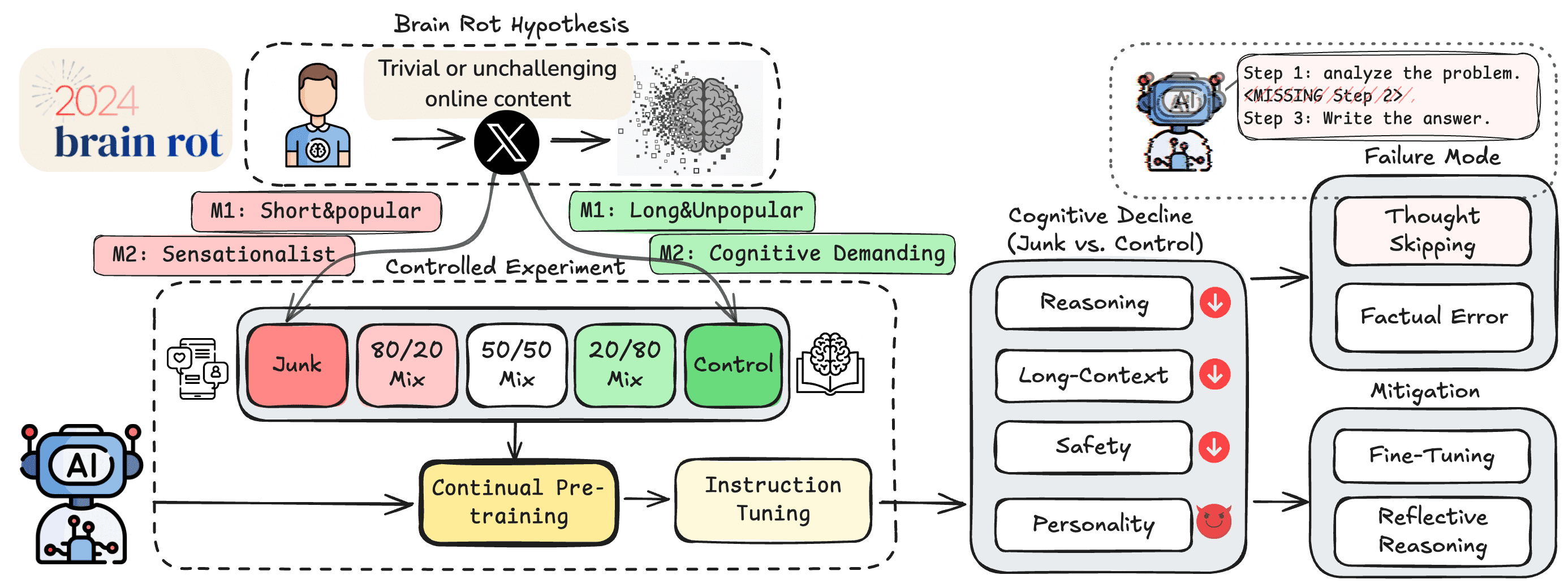

研究人员从现有研究中获得灵感,这些研究表明,大量消费"琐碎且缺乏挑战性的在线内容"的人类可能会出现注意力、记忆和社会认知方面的问题。基于这一发现,他们提出了"大模型脑损伤假说",即"持续在垃圾网络文本上进行预训练会导致大模型出现持久的认知能力下降"。

这一假说将人类互联网成瘾导致的脑损伤概念延伸到了AI领域,暗示AI系统也可能因为接触低质量数据而"退化"。这一观点挑战了当前AI训练数据收集的普遍做法,引发了行业对数据质量控制的重新思考。

"垃圾数据"的定义与筛选

确定什么算作"垃圾网络文本"、什么算作"高质量内容"绝非简单或完全客观的过程。研究人员采用了多种指标,从HuggingFace的1亿条推文语料库中筛选出了"垃圾数据集"和"控制数据集"。

研究人员基于两个主要标准定义垃圾推文:

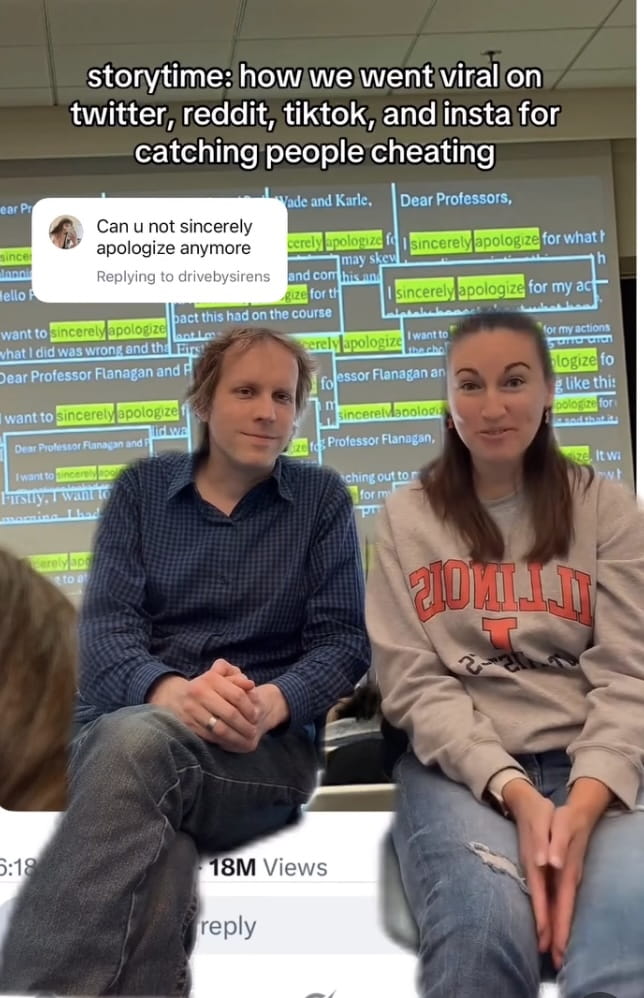

高互动短内容:收集高互动数据(点赞、转发、回复和引用)且长度较短的推文,认为"更受欢迎但更短的推文将被视为垃圾数据"。

语义质量低:利用复杂的GPT-4o提示,提取专注于"肤浅话题(如阴谋论、夸大声明、无根据断言或肤浅生活方式内容)"或采用"吸引注意力的风格(如使用点击诱饵语言的耸人听闻标题或过多的触发词)"的推文。研究人员对LLM分类的随机样本进行了三名研究生的评估验证,匹配率达到76%。

实验设计与发现

研究人员使用不同比例的"垃圾"和"控制"数据对四个大模型进行了预训练,然后通过多种基准测试评估这些经过不同训练的模型:

- 推理能力(ARC AI2推理挑战)

- 长上下文记忆(RULER)

- 遵守伦理规范(HH-RLHF和AdvBench)

- "个性风格"表现(TRAIT)

实验结果显示,在训练集中加入更多"垃圾数据"对模型在推理和长上下文记忆基准测试中的表现产生了统计学上的显著影响。然而,在其他基准测试中,结果则更为复杂。例如,在Llama 8B模型上使用50/50的"垃圾"与控制数据混合,在某些基准测试(如伦理规范、高开放性、低神经质和马基雅维利主义)中生成的得分比完全"垃圾"或完全"控制"的训练数据集都要高。

这一发现表明,数据质量与模型性能之间的关系并非简单的线性关系,而是存在更为复杂的交互作用。

研究警示与行业影响

基于这些结果,研究人员警告说,"严重依赖互联网数据会导致大模型预训练陷入内容污染的陷阱"。他们呼吁"重新审视当前从互联网收集数据和持续预训练的做法",并警告说"仔细筛选和质量控制对于防止未来模型累积性损害至关重要"。

这一研究对AI行业的影响是深远的:

数据收集策略:AI公司需要重新评估其数据收集策略,不再盲目追求数据量,而是更加注重数据质量。

训练方法改进:可能需要开发更精细的数据筛选和预处理方法,以去除低质量内容。

评估标准完善:需要建立更全面的评估体系,不仅关注模型性能,还要关注其认知能力和伦理表现。

行业协作:可能需要行业协作建立数据质量标准和共享高质量数据资源。

更广泛的背景:AI生成内容的挑战

这一问题在当前背景下尤为突出,因为互联网上越来越多的内容是由AI生成的。如果这些内容被用来训练未来的模型,可能会导致"模型崩溃"——即模型性能逐渐下降的现象。

研究人员指出,随着AI生成内容的增加,低质量数据的比例可能会进一步提高,形成恶性循环。这一趋势使得数据质量控制变得前所未有的重要。

未来研究方向

这项研究为AI训练数据质量控制开辟了新的研究方向:

数据质量评估:开发更精确的数据质量评估方法,能够自动识别和过滤低质量内容。

混合训练策略:研究不同质量数据的最佳混合比例,以平衡模型性能和认知能力。

长期影响追踪:追踪长期接触不同质量数据对模型演化的影响。

跨领域验证:验证"脑损伤假说"是否适用于不同类型和规模的AI系统。

结论

这项研究揭示了AI训练数据质量对模型认知能力的关键影响,挑战了当前行业普遍追求数据量的做法。随着AI系统在各个领域的应用日益广泛,确保这些系统具备良好的认知能力和伦理表现变得尤为重要。

研究人员呼吁行业重新审视数据收集和训练实践,强调"仔细筛选和质量控制对于防止未来模型累积性损害至关重要"。这一研究不仅对AI技术的发展方向具有重要指导意义,也为AI伦理和治理提供了新的思考角度。

在AI技术快速发展的今天,如何确保AI系统"健康成长",避免"脑损伤",将是整个行业需要共同面对和解决的重要课题。