最近,谷歌发布的 Gemini 模型在 AI 圈引起了轩然大波。各种关于 Gemini 逆袭的消息铺天盖地,从目前公布的演示和测试结果来看,它确实是一款领先的模型。尤其是在视频识别方面,Gemini 展现出了 GPT-4V 无法企及的能力,这主要是因为 Gemini 的多模态 encoder 和 decoder 支持视频输入,而 GPT-4V 目前还不具备这个功能。

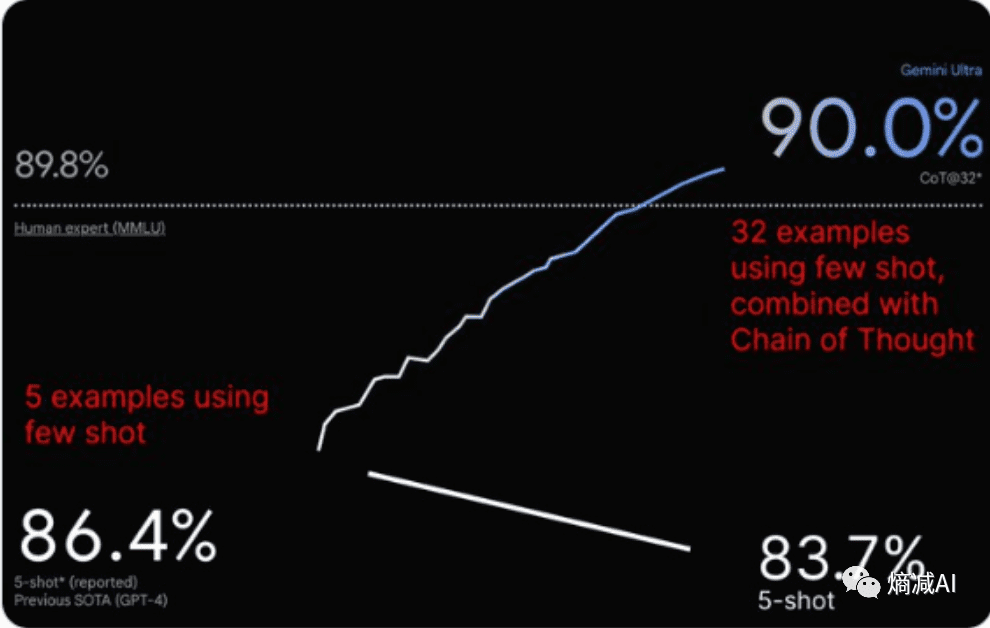

当然,伴随 Gemini 的高光时刻,争议也随之而来。比如,在 MMLU(大规模多任务语言理解)基准测试中,当使用 few_shot COT@32(少样本上下文学习,32 个示例)时,Gemini Ultra 能够超越 GPT-4;但当减少到 few_shot COT@5 时,它的表现反而不如 GPT-4。

对我个人而言,我最感兴趣的是 Gemini 在技术实现上是否有所突破,尤其是在架构上是否与现在流行的 casual-decoder 的 Transformer 有所不同。由于 Gemini 属于前沿技术,目前还没有相关的论文发表(而且考虑到 GPT-4 并没有公布技术细节,我们可能很难看到这类商业化产品的核心内容)。因此,我根据现有信息,自己总结了几个值得关注的点:

1. 真正的多模态:Gemini 将视频能力融入到编解码过程中。虽然目前还没有看到它生成视频的能力,如果无法生成视频,那么严格来说,它还缺少一块重要的拼图。但无论如何,这都是一个不小的提升,相当于将人类世界的几种主要表达方式整合到了一起。目前,Claude 2 只能处理文本,而 GPT-4V 和 GPT-4 严格来说是两个独立的模型,并且不支持视频。

2. Encoder-decoder 模式:Gemini 似乎采用了 encoder-decoder 模式,这不禁让人思考,谷歌是为了证明 T5 及其兄弟模型的价值,还是顶级研究人员发现了 encoder-decoder 模式中尚未被充分挖掘的潜力?根据一些非官方消息,Gemini 并没有采用业界流行的、性能最优的 casual-decoder 架构,而是采用了与 T5 类似的非满秩 encoder-decoder 的传统 Transformer 模型。此外,从之前 Dall-E 3 相关的论文中也可以发现,它也使用了 T5 来实现多模态功能。这部分内容是我个人非常关注的,希望未来能够看到更多相关的信息披露。

3. 模型规模:目前的信息显示,Gemini 的模型规模大约是 GPT-4 的五倍(因为它采用了 encoder-decoder 架构,模型参数量自然会更大)。更大的模型规模通常意味着更强的性能,但这是否意味着 Gemini 在效率方面会付出代价?这还有待进一步观察。

4. 推理加速:考虑到 Transformer 模型推理成本巨大,谷歌在模型加速方面肯定下了不少功夫。从 TPU 到各种量化、蒸馏、剪枝等技术,Gemini 可能会采用多种策略来降低推理成本,从而实现大规模部署。至于具体采用了哪些技术,还需要等待进一步的信息。

5. 数据质量:数据对于大语言模型至关重要。高质量的预训练数据能够显著提升模型的性能。Gemini 的卓越表现,很可能得益于谷歌在数据方面的优势。谷歌拥有大量高质量的文本、图像、视频等数据,这些数据经过清洗、过滤和标注后,可以用于训练出更强大的模型。具体来说,谷歌可能会采用以下策略来提升数据质量:

- 数据增强:通过对现有数据进行变换、组合、生成等操作,增加数据的多样性和规模。

- 数据选择:选择高质量、与任务相关的数据进行训练,过滤掉噪声数据。

- 数据标注:对数据进行准确、一致的标注,提供更丰富的监督信息。

6. 安全性:随着 AI 技术的不断发展,安全性问题也日益凸显。Gemini 作为一款强大的 AI 模型,必须具备足够的安全性,以防止被用于恶意用途。谷歌可能会采取以下措施来增强 Gemini 的安全性:

- 对抗训练:通过引入对抗样本,提高模型对恶意输入的鲁棒性。

- 安全策略:制定明确的安全策略,限制模型生成有害内容。

- 人工审核:对模型生成的内容进行人工审核,及时发现和纠正问题。

7. 伦理道德:AI 技术的伦理道德问题越来越受到关注。Gemini 在设计和开发过程中,必须充分考虑伦理道德因素,确保其行为符合人类的价值观。谷歌可能会采取以下措施来解决伦理道德问题:

- 价值对齐:将模型的行为与人类的价值观对齐,避免产生偏差。

- 透明度:提高模型的透明度,让人们了解其决策过程。

- 可解释性:增强模型的可解释性,使其能够解释自己的行为。

8. 长文本处理能力:随着应用场景的不断拓展,大语言模型需要处理越来越长的文本。Gemini 在长文本处理方面可能采用了以下技术:

- 注意力机制优化:通过优化注意力机制,提高模型处理长文本的效率。

- 记忆机制:引入记忆机制,让模型能够记住长文本中的关键信息。

- 分层处理:将长文本分成多个层次进行处理,降低计算复杂度。

9. 知识图谱:知识图谱是一种结构化的知识表示方法,可以帮助大语言模型更好地理解世界。Gemini 可能会利用知识图谱来增强其知识推理能力:

- 知识融合:将知识图谱中的知识融入到模型中,提高模型的知识储备。

- 知识推理:利用知识图谱进行知识推理,提高模型的逻辑思维能力。

- 知识发现:从知识图谱中发现新的知识,不断扩展模型的知识边界。

10. 持续学习:大语言模型需要不断学习新的知识,才能适应不断变化的世界。Gemini 可能会采用持续学习技术,不断提升自身的能力:

- 在线学习:在实际应用中不断学习新的知识,提高模型的适应性。

- 终身学习:具备终身学习的能力,不断积累知识和经验。

- 迁移学习:将已学到的知识迁移到新的任务中,提高学习效率。

总而言之,Gemini 的出现无疑给 AI 领域带来了新的活力。它在多模态、架构、规模等方面都展现出了强大的实力。当然,Gemini 也面临着诸多挑战,例如推理成本、安全性、伦理道德等。希望在未来的发展中,Gemini 能够不断突破创新,为人类带来更多福祉。