在人工智能技术飞速发展的今天,确保AI系统的安全性和可靠性已成为全球科技界和政府机构共同关注的焦点。随着AI能力的不断提升,潜在的滥用风险和安全威胁也日益凸显。如何有效防范这些风险,构建强大的AI防护体系,成为科技企业和政府机构面临的共同挑战。本文将深入探讨Anthropic与美国CAISI和英国AISI的合作模式,揭示这种公私合作如何在提升AI系统安全性方面发挥关键作用,以及这种合作模式对整个AI安全领域的深远影响。

政府与科技企业的战略合作:AI安全的新范式

过去一年中,Anthropic与美国AI标准与创新中心(CAISI)和英国AI安全研究所(AISI)建立了深入的合作关系。这些政府机构专门负责评估和改进AI系统的安全性。我们的合作始于初步咨询,但逐渐发展为持续性的伙伴关系,CAISI和AISI团队获得了在我们模型开发各个阶段访问我们系统的权限,从而能够对我们的系统进行持续测试。

政府机构在这一合作中发挥着独特作用,特别是在国家安全领域拥有深厚的专业知识,包括网络安全、情报分析和威胁建模。这些专业知识结合他们的机器学习专长,使他们能够评估特定的攻击向量和防御机制。他们的反馈帮助我们改进安全措施,使我们的系统能够抵御最复杂的滥用尝试。

与独立外部专家合作识别AI系统漏洞是Anthropic安全方法的核心部分,对于防止模型可能造成的现实世界危害至关重要。这种合作模式不仅体现了科技企业对安全责任的主动承担,也展示了政府机构在新兴技术监管中的建设性角色。

漏洞发现与安全加固:合作成果初显

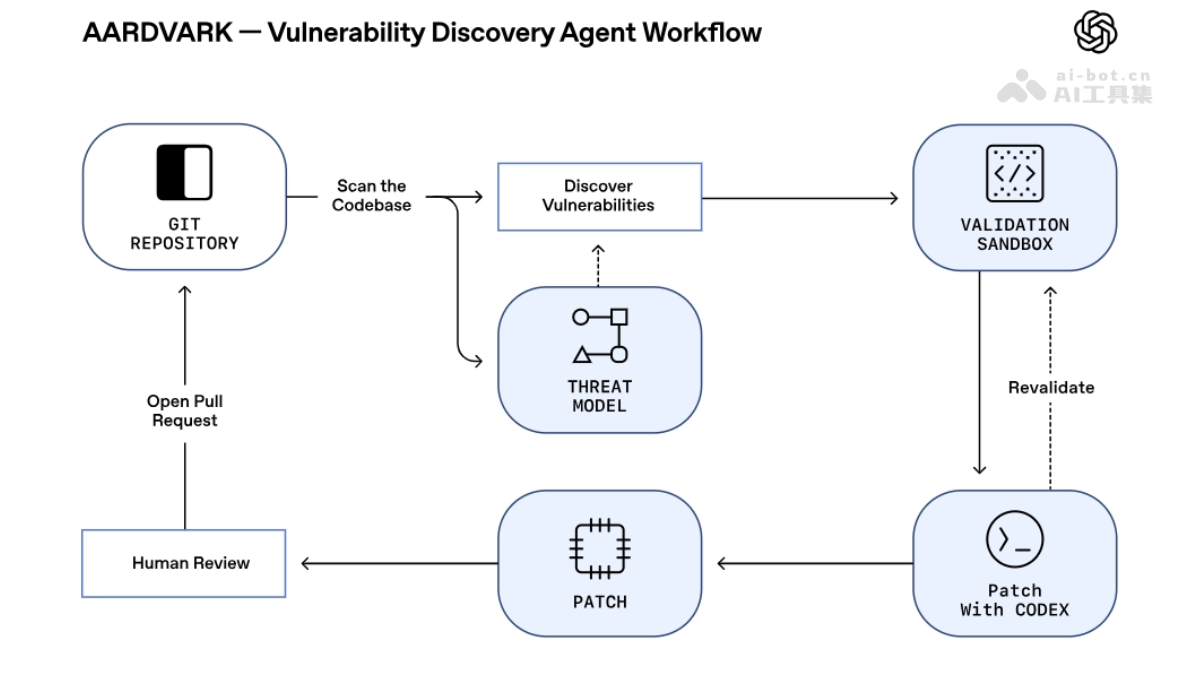

这种合作已经取得了重要成果,帮助我们加强了防止模型恶意使用的工具。根据与CAISI和AISI各自的协议,每个组织在我们部署前评估了我们宪法分类器的多个迭代版本——这是我们用于发现和防止越狱行为的防御系统,包括Claude Opus 4和4.1等模型,以帮助识别漏洞并构建强大的安全措施。

宪法分类器的测试与改进

我们向CAISI和AISI提供了我们宪法分类器的几个早期版本,并在我们改进系统时继续提供最新系统的访问权限。我们共同对这些分类器进行了压力测试,政府红队成员在部署前后都发现了各种漏洞,我们的技术团队利用这些发现加强安全措施。例如,这些漏洞包括:

揭示提示注入漏洞:政府红队成员通过提示注入攻击发现了我们早期分类器的弱点。这类攻击使用隐藏指令来诱骗模型执行系统设计师未 intended 的行为。测试人员发现,特定的标注,如虚假声称已经过人工审核,可以完全绕过分类器检测。我们已经修补了这些漏洞。

压力测试安全架构:他们开发了一种复杂的通用越狱方法,以规避我们的标准检测方式编码有害交互。这一发现促使我们从根本上重构安全架构,以解决潜在的漏洞类别,而不仅仅是修补单个漏洞。

识别基于密码的攻击:使用密码、字符替换和其他混淆技术对有害请求进行编码,以规避我们的分类器。这些发现推动了我们检测系统的改进,使其能够识别和阻止无论使用何种编码方法的伪装有害内容。

输入和输出混淆攻击:发现了针对我们特定防御的复杂混淆方法构建的通用越狱,例如将有害字符串分解为更广泛背景中看似无害的组件。识别这些盲点使我们能够有针对性地改进过滤机制。

自动化攻击优化:构建了新的自动化系统,逐步优化攻击策略。他们最近使用这个系统通过从效果较差的越狱迭代产生了一个有效的通用越狱,我们正在利用这些改进来加强我们的安全措施。

评估与风险方法论

除了识别特定漏洞外,CAISI和AISI团队还帮助我们加强了对安全性的更广泛方法。他们对证据要求、部署监控和快速响应能力的外部视角在压力测试我们的假设和识别可能需要额外证据支持威胁模型的领域方面具有宝贵价值。

有效合作的关键经验

我们的经验教会了我们几个关于如何有效参与政府研究和标准机构以改进模型安全和安全性的重要课程。

全面模型访问增强红队测试效果

我们的经验表明,让政府红队成员更深入地访问我们的系统 enables 更复杂的漏洞发现。我们提供了几个关键资源:

部署前安全原型:测试人员可以在保护系统上线之前评估和迭代,在安全措施部署前识别弱点。

多种系统配置:我们提供了跨越保护范围的模型,从完全不受保护的版本到具有完整安全措施的模型。这种方法让测试人员首先开发针对基础模型的攻击,然后逐步改进技术以绕过日益复杂的防御。仅帮助模型变体还实现了精确的有害输出评分和能力基准测试。

广泛的文档和内部资源:我们向值得信赖的政府红队成员提供了我们的安全架构细节、记录的漏洞、安全报告和细粒度内容政策信息(包括特定的禁止请求和评估标准)。这种透明性帮助团队针对高价值测试区域进行测试,而不是盲目地寻找弱点。

实时安全数据加速漏洞发现:我们让政府红队成员直接访问分类器分数。这使测试人员能够改进攻击策略并进行更有针对性的探索性研究。

迭代测试允许复杂漏洞发现

虽然单一评估具有价值,但持续的合作使外部系统能够开发深入的系统专业知识并发现更复杂的漏洞。在关键阶段,我们与合作伙伴保持每日沟通渠道和频繁的技术深入交流。

互补方法提供更强大的安全

CAISI和AISI评估与我们更广泛的生态系统协同工作。公开的漏洞赏金计划从广泛的人才库中产生大量多样化的漏洞报告,而专业专家团队可以帮助发现需要深厚技术知识才能识别的复杂、微妙的攻击向量。这种多层策略有助于我们确保既能捕获常见漏洞,又能发现复杂的边缘情况。

持续合作:AI安全的未来之路

使强大的AI模型安全且有益不仅需要技术创新,还需要行业和政府之间新的合作形式。我们的经验表明,当技术团队密切合作以识别和解决风险时,公私合作伙伴关系最为有效。

随着AI能力的进步,独立评估缓解措施的作用变得越来越重要。我们欣慰地看到其他AI开发者也在与这些政府机构合作,并鼓励更多公司这样做并更广泛地分享他们的经验。

这种合作模式为AI安全领域树立了新标杆,展示了政府机构与科技企业如何能够超越传统的监管与被监管关系,建立基于共同目标的建设性合作伙伴关系。通过开放系统访问、共享专业知识并共同应对挑战,这种合作不仅提升了单个企业的安全水平,也为整个行业的健康发展奠定了基础。

AI安全治理的全球趋势

Anthropic与CAISI和AISI的合作并非孤例,而是反映了全球AI安全治理的 broader 趋势。随着AI技术的快速发展,各国政府越来越认识到需要在促进创新与确保安全之间取得平衡。这种平衡不仅需要技术解决方案,还需要建立有效的治理框架和国际合作机制。

美国和英国在AI安全领域的先行者角色,为其他国家提供了宝贵的参考。通过建立专门的AI安全研究机构,这些国家不仅能够更好地理解和应对AI带来的风险,还能够与国际合作伙伴共同制定标准和最佳实践。

同时,这种合作也反映了政府在新兴技术治理中的新角色——从传统的监管者转变为积极的参与者和合作者。这种转变有助于建立更加灵活、适应性强的治理模式,能够快速响应技术发展带来的新挑战。

技术与政策的协同进化

AI安全的有效治理需要技术与政策的协同进化。技术发展不断带来新的安全挑战和机遇,而政策框架则需要适应这些变化,为技术创新提供指导和支持。

在Anthropic与政府机构的合作中,我们看到这种协同进化的具体体现。政府机构提供国家安全领域的专业知识和威胁视角,而科技企业则提供技术实现和系统优化的能力。这种互补性使得合作双方能够从不同角度审视安全问题,从而制定更加全面、有效的解决方案。

此外,这种合作还促进了知识和经验的共享,有助于建立更加开放、透明的AI安全研究社区。通过共享漏洞发现、安全评估方法和最佳实践,整个行业能够更快地进步,共同应对AI安全挑战。

面向未来的AI安全合作

展望未来,AI安全合作将面临新的机遇和挑战。随着AI技术的不断发展和应用场景的扩展,安全威胁也将变得更加复杂和多样化。这要求合作双方不断适应和创新,建立更加灵活、高效的合作机制。

首先,合作范围需要进一步扩大。除了技术层面的合作外,还需要在政策制定、标准建立、伦理框架等多个领域展开深入合作。只有建立全方位的合作体系,才能真正应对AI带来的各种安全挑战。

其次,合作模式需要更加多元化。除了政府与科技企业的直接合作外,还需要鼓励学术界、民间组织等多方参与,形成更加开放、包容的AI安全治理生态。这种多元化的合作模式能够带来更加全面、创新的解决方案。

最后,国际合作需要进一步加强。AI安全是全球性挑战,任何单一国家或机构都无法独自应对。加强国际合作,建立全球性的AI安全治理框架,将是未来发展的必然趋势。

结论:共建AI安全的未来

Anthropic与CAISI和AISI的合作经验表明,政府与科技企业的战略合作是提升AI系统安全性的有效途径。通过开放系统访问、共享专业知识、共同应对挑战,这种合作不仅能够发现和修复安全漏洞,还能够建立更加全面、有效的安全体系。

这种合作模式不仅为AI安全领域提供了宝贵经验,也为其他新兴技术领域的治理提供了参考。在技术快速发展的今天,建立开放、透明、多方参与的治理机制,将是确保技术健康发展的关键。

面向未来,我们需要继续深化这种合作,拓展合作范围,创新合作模式,加强国际合作,共同构建安全、可靠、有益的AI系统。只有这样,我们才能确保AI技术真正造福人类社会,实现技术进步与人类福祉的和谐统一。