在人工智能技术飞速发展的今天,音频处理领域正迎来一场革命性变革。Step-Audio-EditX的问世,标志着音频编辑技术正式进入大模型时代。这款由阶跃星辰开源的全球首个LLM级音频编辑大模型,以其独特的三轴细粒度控制能力,为语音生成与处理开辟了全新可能性。本文将深入探讨Step-Audio-EditX的技术原理、核心功能及其在各领域的创新应用,揭示它如何改变我们处理音频的方式。

Step-Audio-EditX:音频处理领域的突破性创新

Step-Audio-EditX不仅仅是一个简单的音频编辑工具,它代表了音频处理技术的重大飞跃。作为全球首个基于大语言模型(LLM)级别的音频编辑系统,它实现了对语音的全方位、精细化控制。传统的音频编辑工具往往局限于简单的剪辑、混音和效果处理,而Step-Audio-EditX则能够从情感、说话风格和副语言三个维度对语音进行深度编辑和重塑。

这一创新技术的核心价值在于,它将大语言模型的理解能力和生成能力引入音频领域,使音频处理从传统的信号处理层面跃升至语义理解层面。用户不再需要专业的音频编辑知识和技能,只需通过简单的标签和指令,就能实现复杂的音频编辑效果。这种"自然语言控制音频"的范式转变,极大地降低了音频处理的门槛,同时提高了编辑的精准度和灵活性。

三轴细粒度控制:重新定义音频编辑的可能性

Step-Audio-EditX最引人注目的特点是其独特的三轴细粒度控制能力,即情感轴、说话风格轴和副语言轴。这三轴控制系统相互独立又相互配合,为用户提供了前所未有的音频编辑自由度。

情感轴:精准控制语音情绪表达

情感是人类交流中不可或缺的元素,而Step-Audio-EditX能够精确地编辑和调整语音中的情感表达。系统内置了愤怒、开心、悲伤、兴奋、恐惧、惊讶、厌恶等几十种情感标签,用户可以根据需要多次迭代增强或减弱这些情感的强度。

例如,一段原本平淡的语音叙述,可以通过增强"开心"情感标签,瞬间转变为充满热情和活力的表达;同样,一段激昂的演讲,通过减弱"愤怒"情感,可以变得更加平和理性。这种情感编辑能力不仅限于简单的情绪切换,还支持情感强度的连续调整,实现了从"略微不满"到"极度愤怒"的精细控制。

说话风格轴:个性化语音表达方式

说话风格是区分不同个体和角色的重要特征,Step-Audio-EditX提供了丰富的说话风格编辑功能。系统支持撒娇、耳语、老人、小孩、严肃、慷慨、夸张等十余种说话风格的叠加与微调。

这一功能为角色配音和个性化语音生成提供了极大便利。用户可以通过叠加多种风格,创造出独特的语音表达方式,如"耳语+撒娇"的组合,或者"老人+严肃"的混合风格。与传统的语音合成相比,这种风格编辑更加灵活,能够满足多样化的创作需求,同时保持了语音的自然度和连贯性。

副语言轴:增强语音的自然表现力

副语言是人类交流中除语义外的非语言元素,包括呼吸、笑声、叹气等,它们在表达情感和增强交流自然性方面起着重要作用。Step-Audio-EditX支持精确插入10类自然副语言token,包括呼吸、笑声、叹气、惊讶(oh/ah)、确认(en)、不满(hnn)、疑问(ei)、嗯(uhm)等。

这些副语言元素可以像字幕一样精确插入到语音的特定位置,极大地增强了语音的表现力和自然度。例如,在一段讲解中插入适当的"嗯"和"uhm",可以使语音更加真实自然;在讲述有趣故事时加入"笑声",能够增强内容的感染力。这种对副语言的精确控制,使生成的语音更加接近人类自然的交流方式。

零样本TTS:无需目标语音的音色克隆技术

传统语音合成技术通常需要目标人物的语音样本进行训练,而Step-Audio-EditX则开创性地实现了零样本TTS(文本到语音)技术,无需目标人语音即可克隆音色。这一突破大大降低了语音合成的门槛,提高了应用的灵活性。

方言切换的便捷实现

零样本TTS技术的另一个显著优势是对方言的支持。用户只需在文本前添加"[四川话]"、"[粤语]"等简单标签,即可实现方言的快速切换。这一功能不仅适用于标准方言,还可能扩展到各种地方方言和口音,为多语言、多地区的应用提供了便利。

音色克隆的高效性

传统音色克隆通常需要大量目标语音数据进行训练,而Step-Audio-EditX的零样本TTS技术则能够在没有目标语音的情况下,仅通过文本描述就生成特定音色的语音。这一特性大大提高了音色克隆的效率,降低了应用成本,使得个性化语音生成变得更加普及。

技术原理:创新架构支撑强大功能

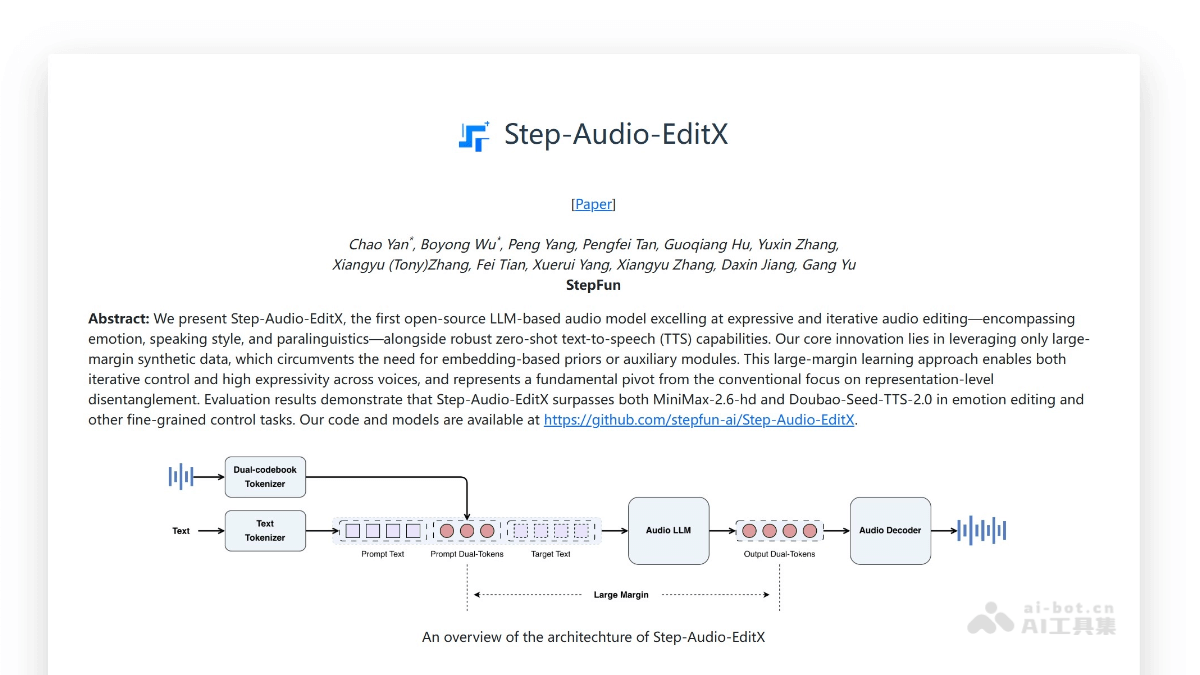

Step-Audio-EditX的强大功能背后,是一套创新的技术架构。这套架构融合了最新的音频处理和机器学习技术,实现了高效、精准的音频编辑和生成。

双码本音频分词技术

Step-Audio-EditX的核心技术之一是双码本音频分词系统。该系统并行使用两个码本:16.7Hz/1024项的"语言码本"和25Hz/4096项的"语义码本"。这两个码本按照2:3的交错切片方式,将任意语音统一转换为离散的token表示。

这种分词方式保留了语音中的情感和韵律信息,为大语言模型直接操作音频提供了"语音词汇"。与传统的音频特征提取相比,双码本分词能够更好地捕捉语音的语义和情感信息,为后续的LLM处理奠定了基础。

3B音频LLM:文本与音频的融合处理

Step-Audio-EditX采用了一个经过文本预训练的3B(30亿参数)大语言模型作为基础。在这个模型中,文本token与双码本音频token按照聊天格式拼接输入,而模型仅输出音频token。这种设计充分利用了已有文本LLM的生态优势,同时实现了对音频的有效处理。

训练数据中,文本与音频的比例为1:1,这种平衡确保了模型能够同时理解文本内容和音频特征。通过这种方式,Step-Audio-EditX实现了文本与音频的深度融合,为后续的音频编辑和生成提供了强大的语义理解能力。

大间隔合成数据驱动

与传统音频处理模型不同,Step-Audio-EditX不引入额外的编码器或adapter,而是仅使用"同文本、异属性(情感/风格/副语言)"的成对数据进行SFT(监督微调)+PPO(近端策略优化)训练。

这种"大间隔合成数据"的训练方式迫使模型学会属性解耦,即不同属性(如情感、风格、副语言)之间的相互独立处理能力。这一特性使得Step-Audio-EditX能够实现迭代式的强度增减与多属性叠加,而不会产生属性间的串扰。

流匹配+BigVGANv2解码

在音频生成阶段,Step-Audio-EditX采用了创新的解码架构。音频LLM输出的双码本token首先经过DiT-流匹配模块生成Mel频谱图,再由BigVGANv2声码器还原为最终的音频波形。

这种解码架构结合了流匹配生成的高效性和BigVGANv2的高质量重建能力,确保了生成音频的自然度和准确性。经过200k小时的高质量训练,Step-Audio-EditX在发音准确度和音色相似度方面都达到了业界领先水平。

统一框架:多任务支持的简化架构

Step-Audio-EditX采用了一套统一的"分词→LLM→解码"管线,这一框架同时支持零样本TTS、情感/风格/副语言编辑、语速调节与降噪等多种任务,无需为每个任务设计专属模块。

这种统一架构显著降低了系统复杂度和推理成本,提高了模型的效率和可扩展性。与传统的多模块音频处理系统相比,Step-Audio-EditX的统一框架更加简洁高效,为实际应用部署提供了便利。

开源轻量:降低应用门槛的技术创新

Step-Audio-EditX不仅功能强大,还在开源和轻量化方面做出了重要创新,这些特性大大降低了技术的应用门槛,促进了技术的普及和创新。

量化版本支持

Step-Audio-EditX提供了8bit量化版本,使得模型可以在单卡8GB显存的硬件上运行。这一特性极大地扩展了可运行硬件的范围,使得更多研究者和开发者能够尝试和应用这一技术。

对于追求更高音质的用户,系统推荐使用4×A800/H800显卡配置,以获得最佳音质效果。这种灵活的硬件配置选择,平衡了性能和可访问性,满足了不同用户的需求。

完整的开源生态

Step-Audio-EditX的开包不仅包括模型本身,还提供了完整的推理/训练代码、Gradio Demo和HF(Hugging Face)Space。这种全方位的开源支持,使得用户能够快速上手应用,同时也为研究者和开发者提供了二次开发的基础。

完整的开源生态促进了技术的透明度和可重复性,加速了社区的反馈和创新。通过分享代码和模型,阶跃星辰鼓励更多的研究者和开发者参与到音频大模型的研究和应用中来,共同推动这一领域的发展。

广泛应用场景:音频大模型的多元价值

Step-Audio-EditX的创新技术为多个领域带来了革命性的应用可能,从内容创作到智能服务,从娱乐到教育,其影响力正在不断扩大。

有声内容升级

在有声书、播客和新闻朗读等领域,Step-Audio-EditX可以一键叠加"开心/悲伤/耳语"等情绪或风格,无需重新录音即可快速生成多版本音频。这一特性大大提高了内容创作的效率,同时增强了内容的沉浸感和表现力。

例如,一部有声书可以通过Step-Audio-EditX生成不同情感基调的版本,满足不同听众的偏好;播客节目可以在保持原有内容不变的情况下,调整主持人的说话风格,以适应不同主题和场合的需求。

视频与广告配音

短视频、动画和广告片的制作通常需要大量配音工作,而Step-Audio-EditX的零样本TTS技术可以显著降低这一成本。制作人员可以零样本克隆角色音色,再通过迭代添加"撒娇、夸张、严肃"等风格,实现低成本、多角色、多情绪的自动配音。

这一技术特别适合需要快速生成大量配音内容的场景,如产品介绍视频、多语言广告等。通过Step-Audio-EditX,制作团队可以在不增加配音演员的情况下,实现多样化的角色和情绪表达。

游戏/虚拟偶像

在游戏和虚拟偶像领域,Step-Audio-EditX可以为NPC、虚拟主播和VTuber提供更加鲜活、可持续互动的角色语音。开发人员只需用一句参考语音克隆角色音色,再实时插入笑声、呼吸、叹气等副语言,就能创造出更加真实自然的角色表现。

这种技术不仅提高了游戏和虚拟互动的真实感,还降低了角色语音的制作和维护成本。通过Step-Audio-EditX,游戏开发者可以轻松实现角色语音的动态调整和个性化定制,增强玩家的沉浸感。

智能客服与语音助手

智能客服和语音助手是Step-Audio-EditX的另一个重要应用场景。传统客服机器人的语音输出往往过于平淡,缺乏情感变化,影响用户体验。而Step-Audio-EditX可以在原有TTS基础上,通过编辑把"平淡答复"转为"热情/安抚"等不同情绪,改善用户体验。

同时,系统支持的方言标签功能,可以使客服机器人根据用户所在地自动切换方言,提供更加地域化的服务。这种情感化和个性化的语音输出,能够显著提升用户满意度和互动质量。

教育/语言学习

在线课程和语言学习应用可以利用Step-Audio-EditX的"老人/小孩/耳语"等风格生成适龄读音,或把标准普通话秒切为粤语、四川话等方言,帮助学生跟读模仿。这一功能不仅丰富了学习资源,还降低了教师录音的成本。

例如,语言学习应用可以生成不同年龄、不同口音的语音样本,帮助学生适应各种语音环境;教育平台可以根据不同年龄段学生的认知特点,调整语音的语速和风格,提高学习内容的吸引力和可理解性。

会议记录与无障碍

在会议记录和无障碍音频处理方面,Step-Audio-EditX也展现出巨大潜力。对于含噪声或过长停顿的会议录音,系统可以先进行"降噪+静音修剪"编辑,再按需求提高语速或加入情感,生成清晰、易读的会议纪要音频。

对于视障人士,Step-Audio-EditX可以将文本内容转换为带有适当情感和风格的语音,提高信息获取的效率和体验。这种应用不仅提高了工作效率,还促进了信息的无障碍传播。

技术局限与未来展望

尽管Step-Audio-EditX在音频编辑领域取得了显著突破,但仍存在一些技术局限和挑战。首先,模型的性能高度依赖于训练数据的质量和多样性,对于罕见语音风格或方言的编辑效果可能有限。其次,当前模型在处理极长文本或复杂对话场景时,可能存在连贯性不足的问题。此外,实时编辑的延迟和计算成本也是需要优化的方向。

未来,Step-Audio-EditX有望在以下几个方面进一步发展:一是扩展支持的语音风格和情感类型,覆盖更多样的表达需求;二是提高模型的长文本处理能力,增强复杂场景下的连贯性;三是优化实时编辑性能,降低计算成本;四是增强跨语言支持,实现多语言环境下的无缝切换。

随着技术的不断进步,Step-Audio-EditX有望在更多领域发挥重要作用,推动音频处理技术的普及和创新。开源特性和轻量化设计将吸引更多开发者和研究者的参与,共同构建更加丰富和完善的音频大模型生态系统。

结论:音频大模型开启的新可能

Step-Audio-EditX的问世标志着音频处理技术正式进入大模型时代。通过情感、说话风格和副语言三轴细粒度控制,它实现了对语音的全方位、精细化编辑和生成,为音频处理带来了前所未有的可能性和灵活性。

零样本TTS技术和方言切换功能,大大降低了语音合成的门槛;创新的双码本音频分词和3B音频LLM架构,为高效、精准的音频处理提供了技术支撑;统一框架和开源轻量化设计,促进了技术的普及和创新。

从有声内容升级到智能客服,从游戏虚拟偶像到教育语言学习,Step-Audio-EditX正在多个领域展现其革命性的应用价值。随着技术的不断进步和完善,我们有理由相信,音频大模型将开启更多创新可能,重塑我们与音频交互的方式,为人类创造更加丰富、自然的听觉体验。