在人工智能领域,文本生成与图像生成已被大模型彻底重塑,然而语音编辑仍是最难以"像写文本那样"直观操作的领域。直到StepFun AI发布了全新开源项目Step-Audio-EditX,这一现状才被彻底改变。基于30亿参数的音频语言模型(Audio LLM),Step-Audio-EditX首次将语音编辑转化为类似文本标记级别的可控操作,而非传统的波形信号处理任务。

从"模仿声音"到"精准控制"

目前大多数零样本TTS(文本到语音)系统仅能从短参考音频中复制情感、口音和音色,虽然听起来自然,但缺乏精确控制能力。在这些系统中,文本中的风格提示往往被忽略,尤其在跨语言、跨风格任务中效果不稳定。

Step-Audio-EditX选择了完全不同的技术路径——它不再依赖复杂的解耦编码器结构,而是通过改变数据结构与训练目标实现可控性。模型通过大量"文本相同、属性差异显著"的语音对和语音三元组进行学习,从而掌握如何在文本内容保持不变的前提下,精准调整语音的情感、风格与副语言信号。

这种方法的革命性在于,它将语音从连续的波形信号转变为可离散标记的序列,使语音编辑能够像文本编辑一样直观和精确。开发者现在可以像修改文字一样,直接调整语音的细微特征,而无需处理复杂的声波信号。

双码本分词与3B音频LLM架构

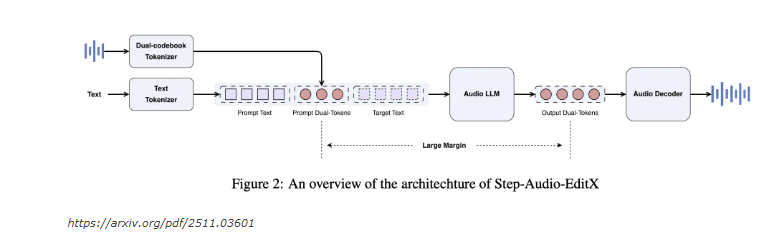

Step-Audio-EditX延续了Step-Audio的双码本分词器(Dual Codebook Tokenizer)架构,这是实现语音标记化的核心技术:

- 语言流:采样率为16.7Hz,包含1024个标记,主要负责捕捉语音的语义内容

- 语义流:采样率为25Hz,包含4096个标记,专注于语音的韵律和情感特征

- 两者以2:3的比例交错排列,完美保留语音中的韵律与情感特征

在此基础上,研究团队构建了一个30亿参数的紧凑型音频LLM。该模型使用文本LLM进行初始化,并在混合语料库上训练(文本与音频标记比例为1:1)。这一设计使模型能够同时读取文本或音频标记,并始终输出双码本标记序列,实现了文本与语音之间的无缝转换。

音频重建由独立解码器完成:扩散变换器流匹配模块预测梅尔频谱图,BigVGANv2声码器将其转为最终波形。整个模块在20万小时高质量语音数据上训练,显著提升了音色与韵律的自然度,使合成语音更加接近人类表达的真实感。

大间隔学习与合成数据策略

Step-Audio-EditX的关键创新是"大间隔学习"(Large Margin Learning)。模型在保持文本不变的前提下,通过三元组和四元组样本训练,学习在"差异明显"的语音属性间进行精确转换。这种方法使模型能够理解并执行更细微的语音调整指令,大大提升了编辑的精确度。

团队使用了覆盖中、英、粤语和四川话的6万名说话人数据集,并构建了合成三元组以强化情感与风格控制。每组样本由专业配音演员录制10秒片段,StepTTS系统生成中性与情感版本,再由人工与模型双重评分筛选质量最高的样本。这种严格的数据筛选机制确保了训练数据的高质量,为模型性能提供了坚实基础。

副语言(如笑声、呼吸、填充停顿)编辑则基于NVSpeech数据集,通过克隆和标注去除实现时域监督,无需额外边距模型。这一创新使Step-Audio-EditX能够全面控制语音的各种非语言元素,大大增强了语音编辑的维度和可能性。

SFT + PPO:让模型学会听懂指令

Step-Audio-EditX的训练过程分为两个精心设计的阶段:

- 监督微调(SFT):模型在统一的聊天格式中同时学习TTS和编辑任务,掌握基本的语音生成和编辑能力

- 强化学习(PPO):通过奖励模型优化对自然语言指令的响应,提升模型的指令理解能力和执行精度

奖励模型基于SFT检查点初始化,使用Bradley-Terry损失在大间隔偏好对上训练,直接在标记级别计算奖励,无需解码波形。这种方法大大提高了训练效率,同时PPO结合KL惩罚项有效平衡了音质与偏差,确保生成语音既符合指令要求又保持自然流畅。

Step-Audio-Edit-Test:AI评测标准

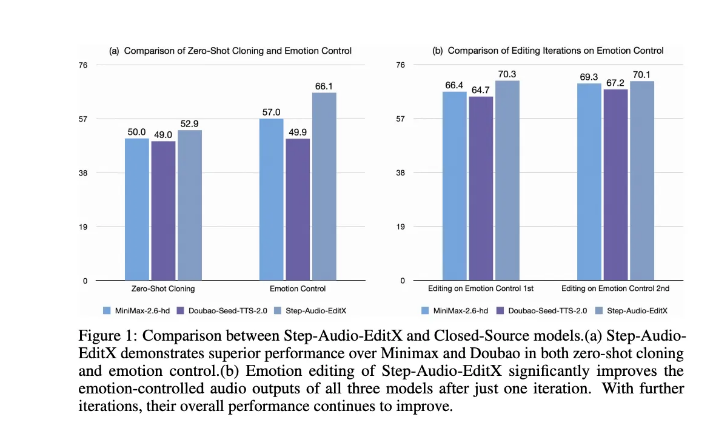

为量化Step-Audio-EditX的控制能力,团队提出了Step-Audio-Edit-Test基准,采用Gemini2.5Pro作为评审模型,从情感、风格、副语言三个维度进行全面评估。

评测结果显示了显著的性能提升:

- 中文情感准确率从57.0%提升至77.7%

- 风格准确率从41.6%提升至69.2%

- 英文结果表现类似

副语言编辑平均得分也从1.91升至2.89,已接近主流商业系统水平。更令人惊讶的是,Step-Audio-EditX对闭源系统如GPT-4o mini TTS、ElevenLabs v2、豆包种子TTS2.0等均能带来显著提升,证明了其技术的普适性和优越性。

技术突破与行业影响

Step-Audio-EditX代表了可控语音合成的一次真正跃迁。它放弃了传统的波形级信号操作方法,转而以离散标记为基础,结合大间隔学习与强化优化,使语音编辑的体验首次接近文本编辑的流畅度。这一突破不仅改变了语音编辑的技术范式,也为语音交互领域带来了新的可能性。

在技术与开放性上,StepFun AI选择了全栈开源(包括模型权重与训练代码),极大地降低了语音编辑研究的门槛。这意味着未来开发者可以像修改文字一样,精准控制语音的情绪、语气与副语言特征,从而创造出更加自然、富有表现力的语音交互体验。

应用前景与未来方向

Step-Audio-EditX的出现为多个领域带来了革命性的应用可能:

- 内容创作:播客、有声书创作者可以轻松调整语音的情感表达,增强内容感染力

- 虚拟助手:智能助手可以根据对话情境调整语音情感,提供更自然的交互体验

- 辅助技术:为语音障碍人士提供更个性化的语音合成解决方案

- 游戏与娱乐:游戏角色可以根据情境实时调整语音表达,增强沉浸感

- 语言学习:创建更自然的语音样本,帮助学习者掌握正确的语调和情感表达

未来,随着技术的进一步发展,Step-Audio-EditX可能会融合更多模态的信息,实现跨模态的语音编辑控制。同时,随着计算效率的提升,这种高质量语音编辑技术可能会在移动设备和边缘计算设备上实现,使其应用范围更加广泛。

结语

Step-Audio-EditX的发布标志着语音编辑技术进入了一个全新的时代。通过将语音转化为可编辑的标记序列,结合强大的30亿参数音频LLM,StepFun AI不仅实现了语音编辑的精确控制,还通过全栈开源的方式推动了整个语音技术的发展。这一突破不仅改变了我们与语音交互的方式,也为人工智能在语音领域的应用开辟了更加广阔的前景。随着更多开发者的参与和创新,我们可以期待未来会出现更加丰富、自然的语音应用,彻底改变人机交互的面貌。