在人工智能技术飞速发展的今天,AI模型的大小和复杂度不断增加,对计算资源的需求也日益增长。同时,数据隐私和安全问题日益突出,许多企业和个人希望能够在本地环境中部署AI应用,而不依赖云端服务。LocalAI应运而生,作为一个开源的本地AI推理框架,它提供了完整的本地化AI解决方案,支持多模态模型,同时保持与OpenAI API的兼容性。

LocalAI概述

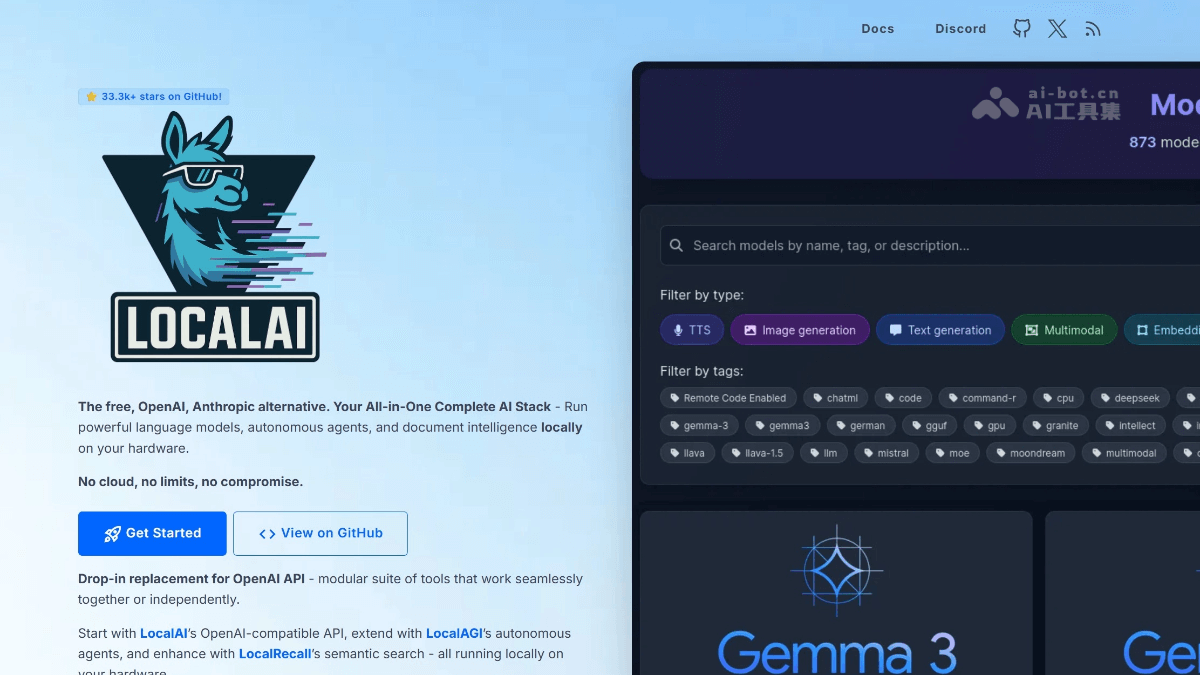

LocalAI是一个强大的开源本地AI推理框架,旨在为用户提供隐私保护的AI解决方案。它支持多种多模态模型,包括文本生成、图像生成、语音转文字、文本转语音等功能。与许多依赖云端的AI服务不同,LocalAI强调所有数据处理均在本地完成,不会上传到云端,从而确保用户数据的隐私和安全。

LocalAI的另一个显著特点是硬件兼容性广泛,它支持多种硬件配置,包括仅使用CPU的场景,也兼容NVIDIA、AMD和Intel的GPU。这种灵活性使得LocalAI可以在各种环境中部署,从个人电脑到企业服务器都能运行良好。此外,LocalAI支持多种模型格式,如GGML、GGUF和GPTQ等,为用户提供了丰富的选择。

LocalAI的核心功能

多模态支持

LocalAI最突出的功能之一是其多模态支持能力。它不仅可以处理文本,还支持图像生成、语音转文字、文本转语音等多种功能。这种多模态能力使得LocalAI能够应用于更广泛的场景。

例如,在科研领域,研究人员可以通过LocalAI的图像生成接口,将实验数据自动转换为可视化图表,从而更直观地展示研究结果。在内容创作领域,创作者可以利用LocalAI同时生成文本和图像,创建丰富的多媒体内容。

OpenAI API兼容性

LocalAI提供与OpenAI API兼容的REST接口,这是其另一个重要优势。这意味着用户可以在本地环境中无缝替换现有的OpenAI服务,而无需修改现有应用的代码。这种兼容性大大降低了迁移成本,使得用户能够轻松地将依赖OpenAI API的应用迁移到本地环境。

本地推理与隐私保护

在数据隐私日益重要的今天,LocalAI的核心优势在于其数据处理完全本地化。所有AI推理过程都在本地完成,确保敏感信息不会通过网络传输到外部服务器。这一点对于处理敏感数据的企业和个人用户来说尤为重要,它提供了更高的数据安全保障。

硬件兼容性

LocalAI支持多种硬件配置,包括仅使用CPU的场景,也兼容NVIDIA、AMD和Intel的GPU。通过量化技术(如ggml/q4_0),LocalAI能够在消费级硬件上高效运行大型模型,这使得它可以在各种环境中部署,不受高端硬件限制。

WebUI支持

LocalAI提供了基于Web的图形用户界面,方便用户进行模型管理、文件处理和实时对话等操作。这种用户友好的界面降低了使用门槛,使得非技术用户也能轻松使用LocalAI的功能。

模型管理与加载

通过gRPC接口,LocalAI支持模型的加载和管理,用户可以提前将常用模型加载到内存中,显著降低首次推理的延迟。这种预加载机制对于需要快速响应的应用场景尤为重要,可以提高用户体验。

工具调用与函数集成

LocalAI支持函数调用和嵌入服务,允许开发者将AI功能集成到现有系统中。这种集成能力使得LocalAI可以成为企业现有系统的一部分,增强系统的智能化水平。

LocalAI的技术原理

基于开源库实现功能

LocalAI使用多种开源库来实现不同功能。例如,使用llama.cpp和gpt4all.cpp进行文本生成,whisper.cpp进行音频转录,以及使用Stable Diffusion进行图像生成。这种基于开源库的设计使得LocalAI能够充分利用社区的力量,不断优化和扩展功能。

兼容OpenAI API规范

LocalAI通过兼容OpenAI的API规范,实现了与现有系统的无缝对接。这使得用户可以将LocalAI作为OpenAI的替代品,无需修改代码即可在本地运行。这种兼容性大大降低了迁移成本,使得用户能够轻松地将依赖OpenAI API的应用迁移到本地环境。

多硬件支持

LocalAI支持多种硬件配置,包括仅使用CPU的场景,也兼容NVIDIA、AMD和Intel的GPU。通过量化技术(如ggml/q4_0),LocalAI能够在消费级硬件上高效运行大型模型。这种硬件兼容性使得LocalAI可以在各种环境中部署,不受高端硬件限制。

分布式推理架构

LocalAI实现了基于P2P网络的分布式推理能力,允许将计算任务拆分到多个节点协同处理。节点发现通过mDNS和DHT协议实现,通信加密采用libp2p协议栈,确保节点间通信安全。这种分布式架构使得LocalAI能够处理更大规模的AI任务,提高系统的可扩展性和可靠性。

动态任务调度

在分布式推理中,LocalAI采用去中心化设计,根据节点的CPU/内存使用率和网络延迟动态分配任务,优先选择负载较轻的节点处理新请求,提高了集群的可用性和容错能力。这种智能调度机制确保了系统的高效运行,即使在节点负载不均衡的情况下也能保持良好的性能。

LocalAI的应用场景

企业内网环境

在企业内网中,LocalAI可以搭建私有的AI助手,用于处理内部文档、代码审查、知识问答等任务。所有数据处理都在本地完成,避免了敏感信息外泄。这对于金融、医疗等对数据安全要求极高的行业尤为重要。

个人开发环境

作为本地的AI编程助手,LocalAI可以快速响应代码相关任务,减少网络延迟,提高开发效率。开发者可以在本地测试AI模型,无需等待网络请求,大大提高了开发效率。

离线AI应用

在无网络环境下,LocalAI可以实现AI功能,支持离线科研、编程和内容创作。这对于在偏远地区或网络不稳定环境下的用户来说尤为重要,它确保了AI功能的可用性。

自主AI Agent

LocalAI支持构建和部署自主Agent,实现任务自动化和复杂工作流,无需依赖云端。这种自主Agent可以应用于各种场景,如智能家居、工业自动化等,提高系统的智能化水平。

语义检索与记忆

通过LocalRecall组件,用户可以构建本地知识库与语义检索,提升AI的上下文感知与持久记忆能力。这对于需要长期记忆和上下文理解的应用场景尤为重要,如个人助手、客户服务等。

多模态内容生成

LocalAI支持本地生成文本、图像和音频,适用于创意项目、市场营销和多媒体制作。创作者可以利用LocalAI同时生成多种媒体内容,提高创作效率和质量。

LocalAI的优势与挑战

优势

- 隐私保护:所有数据处理在本地完成,确保数据安全。

- 离线可用:无需网络连接即可使用AI功能。

- 硬件兼容性:支持多种硬件配置,从CPU到各种GPU。

- 多模态支持:支持文本、图像、语音等多种AI功能。

- OpenAI兼容:与OpenAI API兼容,降低迁移成本。

- 分布式架构:支持分布式推理,提高系统可扩展性。

挑战

- 资源需求:运行大型模型需要足够的计算资源。

- 技术门槛:部署和配置LocalAI需要一定的技术知识。

- 模型兼容性:并非所有模型都与LocalAI兼容。

- 性能优化:在有限硬件上优化模型性能需要专业知识。

- 社区支持:相比商业AI服务,社区支持可能不够及时。

LocalAI的未来发展

LocalAI作为一个新兴的开源项目,其未来发展潜力巨大。随着AI技术的不断进步,LocalAI可能会增加对更多模型的支持,提高硬件兼容性,优化性能,并简化部署流程。

模型支持扩展

未来,LocalAI可能会支持更多类型的AI模型,包括更先进的文本生成模型、图像生成模型、多模态模型等。这将使LocalAI能够应用于更广泛的场景,满足不同用户的需求。

硬件优化

随着硬件技术的进步,LocalAI可能会进一步优化对新型硬件的支持,如量子计算、神经形态计算等。这将使LocalAI能够在未来的计算环境中发挥更大的作用。

易用性提升

为了降低使用门槛,LocalAI可能会进一步简化部署和配置流程,提供更友好的用户界面,以及更完善的文档和教程。这将吸引更多非技术用户使用LocalAI。

社区建设

LocalAI的社区建设也值得关注。随着项目的不断发展,社区可能会形成更完善的生态系统,包括插件、扩展、第三方工具等,这将丰富LocalAI的功能和应用场景。

LocalAI与其他本地AI框架的比较

在本地AI框架领域,除了LocalAI外,还有其他一些优秀的开源项目,如Ollama、LM Studio、Jan AI等。下面将LocalAI与这些框架进行比较,帮助用户了解LocalAI的独特之处。

LocalAI vs Ollama

Ollama是一个流行的本地AI框架,专注于大语言模型的本地运行。与Ollama相比,LocalAI的多模态支持更为全面,不仅支持文本生成,还支持图像生成、语音处理等功能。此外,LocalAI的分布式架构使其能够处理更大规模的AI任务。

LocalAI vs LM Studio

LM Studio是一个用户友好的本地AI框架,提供直观的界面和模型管理功能。LM Studio在易用性方面表现优秀,而LocalAI则在多模态支持和分布式架构方面具有优势。对于需要多种AI功能和可扩展性的用户,LocalAI可能是更好的选择。

LocalAI vs Jan AI

Jan AI是一个注重隐私保护的本地AI框架,提供安全的AI运行环境。与Jan AI相比,LocalAI在功能丰富性和硬件兼容性方面更具优势。LocalAI支持更多类型的AI模型和硬件配置,适用于更广泛的场景。

如何开始使用LocalAI

对于想要开始使用LocalAI的用户,以下是一些基本步骤和建议:

系统要求

在开始之前,确保您的系统满足LocalAI的最低要求:

- 操作系统:Linux、macOS或Windows

- 内存:至少4GB(推荐8GB或更多)

- 存储:足够的磁盘空间用于下载和存储模型

- 硬件:CPU或GPU(NVIDIA、AMD或Intel)

安装步骤

基本配置

LocalAI的配置相对简单,主要通过配置文件进行。您可以根据需要调整模型参数、硬件资源分配、API设置等。详细的配置选项可以参考官方文档。

模型选择

LocalAI支持多种模型格式,如GGML、GGUF和GPTQ等。您可以根据自己的硬件条件和需求选择合适的模型。对于资源有限的系统,建议选择量化后的模型,如GGML/q4_0。

API使用

LocalAI提供与OpenAI API兼容的REST接口,您可以使用现有的OpenAI客户端库与LocalAI交互。只需将API端点指向LocalAI服务,无需修改代码即可使用。

LocalAI的实际应用案例

企业知识库助手

一家金融机构使用LocalAI构建了企业知识库助手,用于回答员工关于公司政策、流程和产品的问题。所有数据处理都在本地完成,确保敏感信息不会外泄。通过LocalAI的多模态支持,助手还可以处理文档和图像,提供更全面的服务。

离线编程助手

一位软件开发者在没有网络连接的环境中使用LocalAI作为编程助手。通过LocalAI的本地推理能力,他可以在离线状态下获得代码建议和错误修复,大大提高了工作效率。

科研数据可视化

一个科研团队使用LocalAI将实验数据自动转换为可视化图表。通过LocalAI的图像生成功能,研究人员可以快速创建高质量的图表,直观地展示研究结果。

多媒体内容创作

一家创意公司使用LocalAI生成文本、图像和音频内容,用于市场营销和多媒体制作。通过LocalAI的多模态支持,创作者可以在本地完成整个创作流程,无需依赖云端服务。

LocalAI的性能优化建议

为了获得最佳性能,以下是一些优化建议:

模型量化

使用量化技术(如GGML/q4_0)可以显著减少模型大小和内存需求,提高推理速度。对于资源有限的系统,量化是一种有效的优化方法。

硬件加速

尽可能使用GPU加速推理,特别是对于大型模型。NVIDIA GPU通常提供最佳性能,但AMD和Intel GPU也支持良好。

模型预加载

将常用模型预加载到内存中,可以显著降低首次推理的延迟。通过LocalAI的模型管理功能,可以实现模型的预加载和缓存。

分布式部署

对于大规模AI任务,可以考虑使用LocalAI的分布式推理架构,将计算任务分配到多个节点,提高系统的可扩展性和性能。

资源监控

定期监控系统资源使用情况,如CPU、内存和GPU利用率,及时发现和解决性能瓶颈。

LocalAI的安全考虑

在使用LocalAI时,安全是一个重要考虑因素。以下是一些安全建议:

模型来源

确保从可信来源下载AI模型,避免使用来源不明的模型,可能包含恶意代码。

访问控制

实施适当的访问控制措施,限制对LocalAI服务的访问,防止未授权使用。

数据加密

对于敏感数据,考虑在本地进行加密处理,确保数据安全。

定期更新

定期更新LocalAI和相关依赖库,修复安全漏洞,提高系统安全性。

LocalAI的社区与支持

LocalAI拥有活跃的社区,为用户提供支持和交流平台。以下是一些获取帮助的途径:

官方文档

LocalAI的官方文档提供了详细的安装指南、配置说明和使用教程,是获取信息的主要来源。

GitHub仓库

LocalAI的GitHub仓库是问题跟踪、功能请求和代码贡献的主要平台。您可以在Issues部分提出问题或建议。

社区论坛

LocalAI的社区论坛是用户交流和经验分享的平台。您可以在这里提问、分享使用心得或参与讨论。

社交媒体

LocalAI在Twitter、Discord等社交媒体平台上也有活跃的社区,您可以关注相关账号获取最新信息。

LocalAI的商业模式与可持续性

作为一个开源项目,LocalAI的可持续性是一个重要考虑因素。目前,LocalAI主要通过以下方式维持发展:

开源赞助

LocalAI接受来自企业和个人的赞助,用于项目开发和维护。您可以通过GitHub Sponsors等方式支持项目。

商业支持

LocalAI可能提供商业支持服务,如企业定制、技术支持等,为项目创造收入。

社区贡献

社区的贡献是LocalAI可持续发展的关键。通过代码贡献、文档改进、问题反馈等方式,社区成员可以帮助项目不断进步。

LocalAI的伦理考量

在使用AI技术时,伦理问题不容忽视。LocalAI作为一个本地AI框架,也面临一些伦理挑战:

数据隐私

LocalAI强调数据本地处理,有助于保护用户隐私。然而,用户仍需注意数据的收集和使用方式,确保符合相关法规和伦理标准。

模型偏见

AI模型可能存在偏见,用户在使用LocalAI时应注意这一点,并采取措施减少偏见的影响。

滥用风险

任何AI技术都可能被滥用,LocalAI也不例外。用户应遵守相关法律法规,避免将LocalAI用于非法或不道德的目的。

LocalAI的未来趋势

随着AI技术的不断发展,LocalAI可能会呈现以下趋势:

更强大的多模态能力

未来,LocalAI可能会支持更复杂的多模态任务,如跨模态理解、多模态生成等,提供更丰富的AI功能。

更高效的硬件利用

随着硬件技术的进步,LocalAI可能会进一步优化对硬件的利用,提高推理效率,降低资源需求。

更广泛的行业应用

LocalAI可能会在更多行业得到应用,如医疗、教育、金融等,为各行业提供本地化的AI解决方案。

更完善的生态系统

随着社区的发展,LocalAI可能会形成一个更完善的生态系统,包括插件、扩展、第三方工具等,丰富其功能和应用场景。

结论

LocalAI作为一个开源的本地AI推理框架,正在改变AI部署的方式。它提供完整的本地化AI解决方案,支持多模态模型,同时保持与OpenAI API的兼容性。LocalAI强调隐私保护,所有数据处理均在本地完成,不会上传到云端,这为用户提供了更高的数据安全保障。

LocalAI的硬件兼容性广泛,支持多种硬件配置,从仅使用CPU到NVIDIA、AMD和Intel的GPU均可运行。这种灵活性使得LocalAI可以在各种环境中部署,从个人电脑到企业服务器都能运行良好。

LocalAI的应用场景广泛,包括企业内网环境、个人开发环境、离线AI应用、自主AI Agent、语义检索与记忆、多模态内容生成等。它可以帮助用户构建本地AI解决方案,满足各种需求。

尽管LocalAI面临一些挑战,如资源需求、技术门槛、模型兼容性等,但随着技术的不断进步和社区的发展,这些问题有望得到解决。LocalAI的未来发展潜力巨大,可能会在AI领域发挥越来越重要的作用。

对于希望部署本地AI解决方案的用户来说,LocalAI是一个值得考虑的选择。它不仅功能丰富,而且开源免费,社区活跃,为用户提供了强大的支持和丰富的资源。通过LocalAI,用户可以在本地环境中享受AI技术带来的便利,同时保护数据隐私和安全。