在人工智能技术飞速发展的今天,音频处理领域正迎来一场革命性的变革。阶跃星辰最新开源的Step-Audio-EditX模型,作为全球首个LLM级音频编辑大模型,正在重新定义我们对音频编辑的认知。这一突破性技术不仅实现了对音频的精细化控制,更开创了无需专业音频知识即可进行高级音频编辑的新时代。

颠覆传统:Step-Audio-EditX的创新定位

传统音频编辑软件往往需要用户具备专业的音频知识和操作技能,且编辑过程复杂耗时。而Step-Audio-EditX的出现,彻底改变了这一现状。作为一款基于大语言模型(LLM)的音频编辑工具,它将自然语言处理技术与音频处理完美结合,使普通用户也能像编辑文本一样轻松编辑音频。

Step-Audio-EditX的核心创新在于其"情感、说话风格、副语言"三轴细粒度迭代控制能力。用户可以像调整文本字体大小一样,对音频中的情绪强度、说话风格和副语言元素进行精确控制,实现前所未有的音频编辑自由度。

核心功能解析:三大编辑维度

情感编辑:精准控制情绪表达

Step-Audio-EditX最引人注目的功能之一是其强大的情感编辑能力。系统内置了愤怒、开心、悲伤、兴奋、恐惧、惊讶、厌恶等数十种情感标签,用户可以通过简单的操作多次迭代增强或减弱这些情感的强度。

这一功能的核心价值在于它打破了传统音频编辑中"情绪固定"的局限。想象一下,一位有声书录制者可以在不重新录音的情况下,将原本平淡的叙述调整为充满紧张感的表达;或者一位播客主播可以轻松调整自己的情绪状态,为不同主题的内容匹配最合适的情感基调。

风格编辑:个性化声音塑造

除了情感控制,Step-Audio-EditX还提供了丰富的风格编辑选项。撒娇、耳语、老人、小孩、严肃、慷慨、夸张等十余种说话风格可以自由叠加与微调,为音频创作提供了无限可能。

这一功能特别适用于角色配音场景。游戏开发者可以为NPC角色快速生成独特的声音风格;动画制作团队可以轻松实现角色在不同场景下的声音变化;教育内容创作者则可以针对不同年龄段的学习者调整语音风格,提高内容的亲和力和接受度。

副语言插入:增强表达自然度

副语言元素(如呼吸、笑声、叹气等)是人类交流中不可或缺的部分,它们能够显著增强语音的自然度和表现力。Step-Audio-EditX支持精确插入10类自然副语言token,包括呼吸、笑声、叹气、惊讶(oh/ah)、确认(en)、不满(hnn)、疑问(ei)、嗯(uhm)等。

这一功能使得AI生成的语音更加接近人类自然表达,消除了传统TTS系统中常见的"机械感"。客服机器人可以在回答中加入适当的"嗯"和"啊",使对话更加自然;有声书可以精确控制角色的呼吸节奏,增强情感表达;教育内容可以通过插入适当的笑声和惊讶声,提高内容的趣味性。

技术突破:创新架构实现高效音频处理

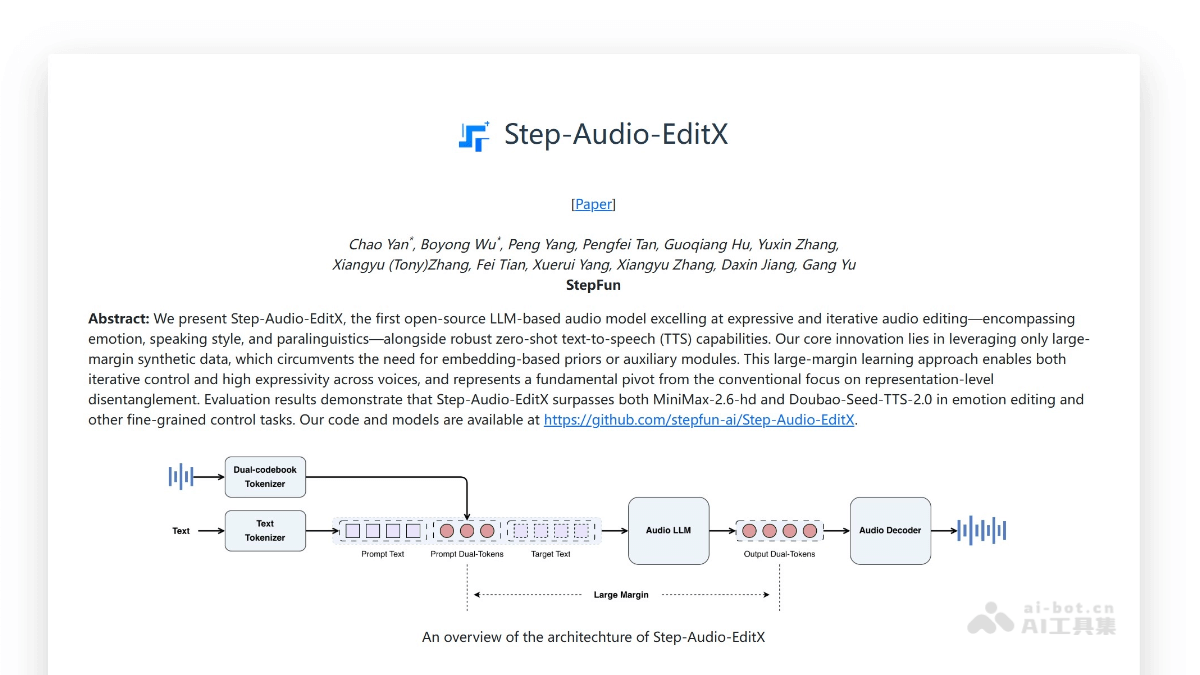

Step-Audio-EditX的卓越性能背后是一系列创新技术的支撑。其技术架构融合了音频处理、自然语言处理和强化学习等多个领域的最新成果,实现了高效、精准的音频编辑能力。

双码本音频分词:统一语音表示

传统音频处理面临的一大挑战是如何将连续的音频信号转化为离散的、可编辑的表示。Step-Audio-EditX采用了创新的"双码本音频分词"技术,通过并行16.7Hz/1024项"语言码本"与25Hz/4096项"语义码本",按2:3交错切片,将任意语音统一转成离散token。

这一设计保留了音频中的情感与韵律信息,为后续LLM直接操作提供了"语音词汇"。就像文本编辑中我们可以选择、修改和重组单词一样,现在我们也可以对音频中的"词汇"进行类似的操作,实现了音频处理的"文本化"。

3B音频LLM:高效音频理解与生成

Step-Audio-EditX的核心是一个经过专门训练的3B参数音频大语言模型。该模型以文本预训练的3B模型为基础,通过热启方式获得初始能力,然后通过文本token与双码本音频token的拼接输入进行进一步训练。

训练过程中,文本与音频的数据比例为1:1,充分利用了已有文本LLM的生态优势。模型仅输出音频token,形成了一个"文本理解→音频生成"的完整流程,实现了对音频内容的高效理解和精准生成。

大间隔合成数据驱动:实现属性解耦

传统音频编辑模型往往难以实现不同属性的独立控制,容易出现"牵一发而动全身"的问题。Step-Audio-EditX通过"大间隔合成数据"的创新方法解决了这一难题。

该模型不引入额外的编码器或adapter,仅使用"同文本、异属性(情感/风格/副语言)"的成对数据进行SFT+PPO训练。"大间隔"的设计迫使模型学会将不同属性解耦,实现了迭代式强度增减与多属性叠加的能力,使用户可以像调整音频均衡器一样精确控制各个音频维度。

流匹配+BigVGANv2解码:高质量音频还原

音频LLM输出的双码本token需要经过解码才能还原为人类可听的音频。Step-Audio-EditX采用了DiT-流匹配模块生成Mel谱,再由BigVGANv2声码器还原波形,实现了高质量音频的生成。

这一解码组合经过200k小时高质量数据的训练,保证了发音准确度与音色相似度。与传统解码方法相比,流匹配+BigVGANv2的组合能够更好地保留音频的细节和情感表达,生成的音频更加自然、清晰。

统一框架:简化系统复杂度

Step-Audio-EditX的另一大优势是其统一的框架设计。同一套"分词→LLM→解码"管线同时支持零样本TTS、情感/风格/副语言编辑、语速调节与降噪等多种功能,无需为不同任务设计专属模块。

这一设计显著降低了系统复杂度与推理成本,使得模型可以在资源受限的环境中高效运行。同时,统一框架也保证了不同功能之间的一致性和兼容性,为用户提供了更加连贯和统一的编辑体验。

实用特性:轻量化设计与易用性

除了强大的技术能力,Step-Audio-EditX在实用性和易用性方面也有诸多创新,使其能够广泛应用于各种场景。

开源轻量:降低使用门槛

Step-Audio-EditX提供了8bit量化版,单卡8GB显存即可运行,大大降低了使用门槛。对于开发者和研究人员来说,这意味着可以在普通消费级GPU上运行这一先进模型,无需昂贵的硬件投入。

对于专业用户,4×A800/H800配置可提供最佳音质,满足高质量音频制作需求。模型同时提供了推理/训练代码、Gradio Demo和HF Space,方便用户快速上手和二次开发。

零样本TTS:无需目标语音即可克隆音色

传统的语音克隆技术通常需要目标人物的大量语音样本作为训练数据,而Step-Audio-EditX的零样本TTS功能彻底改变了这一现状。用户无需提供目标人的语音,即可克隆其音色,大大简化了语音克隆的流程。

这一功能特别适用于需要快速生成多种角色语音的场景,如游戏开发、动画制作和虚拟偶像运营等。创作者只需提供少量参考信息,即可生成高质量的角色语音,大大提高了创作效率。

方言切换:一键实现多语言支持

Step-Audio-EditX支持通过简单的标签切换方言功能。用户只需在文本前添加"[四川话]"、"[粤语]"等标签,即可实现方言的秒级切换。

这一功能为多语言内容创作提供了极大便利。教育应用可以利用它为学生提供不同方言的学习材料;客服系统可以根据用户所在地自动切换方言;有声书制作可以轻松实现角色的地域特色,增强内容的真实感和沉浸感。

迭代控制:反复编辑不串扰

Step-Audio-EditX支持对同一语音进行反复编辑,且不同属性之间不会相互串扰。用户可以先调整情感,再添加风格,最后插入副语言,每一步的编辑都会被准确保留,不会影响之前的设置。

这一特性使得音频编辑过程更加灵活和可控。用户可以像使用图层编辑软件一样,逐步构建理想的音频效果,随时回溯和修改之前的编辑决策,大大提高了创作的自由度和效率。

应用场景:多领域音频创作革新

Step-Audio-EditX的强大功能和易用性使其在多个领域都有广泛的应用前景,正在改变传统音频创作的方式和流程。

有声内容升级:一键多版本生成

有声书、播客、新闻朗读等有声内容制作可以利用Step-Audio-EditX一键叠加"开心/悲伤/耳语"等情绪或风格,无需重新录音即可快速生成多版本音频。

这一功能大大提高了有声内容的生产效率。出版商可以为同一本书生成不同情感基调的有声版本,满足不同读者的偏好;播客主播可以为同一内容制作多种风格版本,测试不同版本的用户接受度;新闻平台可以根据不同新闻类型自动调整朗读风格,增强内容的感染力。

视频与广告配音:低成本多角色实现

短视频、动画、广告片制作可以利用Step-Audio-EditX的零样本克隆功能,快速创建多个角色的音色,然后通过迭代添加"撒娇、夸张、严肃"等风格,实现低成本、多角色、多情绪的自动配音。

这一功能为视频制作团队提供了极大的便利。小型工作室可以凭借有限的人力资源制作出专业级的配音效果;广告公司可以快速为不同产品生成匹配的配音风格;动画制作团队可以实现角色声音的动态变化,增强角色的表现力和真实感。

游戏/虚拟偶像:鲜活角色语音构建

游戏NPC、虚拟主播、VTuber等应用场景中,Step-Audio-EditX可以帮助开发者先用一句参考语音克隆音色,然后实时插入笑声、呼吸、叹气等副语言,打造更鲜活、可持续互动的角色语音。

这一功能正在改变游戏和虚拟偶像行业的声音设计方式。游戏开发者可以为NPC创建更加自然和丰富的对话体验;虚拟主播可以实现更加真实和互动的直播效果;VTuber可以更好地表达情感和个性,增强与粉丝的连接。

智能客服与语音助手:情感化交互体验

智能客服系统和语音助手可以利用Step-Audio-EditX在原有TTS基础上,通过编辑将"平淡答复"转为"热情/安抚"等情绪,改善用户体验。同时支持方言标签,满足地域化服务需求。

这一功能正在提升人机交互的自然度和情感共鸣。客服机器人可以根据用户情绪调整回应语气;语音助手可以识别用户情绪并作出相应调整;智能家居系统可以通过语音表达更加丰富的情感状态,增强用户的情感连接。

教育/语言学习:个性化语音生成

在线课程、语言学习应用可以利用Step-Audio-EditX生成"老人/小孩/耳语"等不同风格的适龄读音,或将标准普通话秒切为粤语、四川话等方言,帮助学生跟读模仿,降低教师录音成本。

这一功能正在革新教育内容的制作方式。语言学习平台可以为学生提供多种口音和语速的学习材料;在线教育机构可以根据不同年龄段学生调整语音风格;特殊教育应用可以为有特殊需求的学生定制适合的语音表达。

会议记录与无障碍:智能音频优化

对于含噪声或过长停顿的会议录音,Step-Audio-EditX可以先进行"降噪+静音修剪"编辑,再按需求提高语速或加入情感,生成清晰、易读的会议纪要音频。

这一功能正在提高会议记录的效率和质量。企业可以自动生成更加专业和易听的会议摘要;远程会议参与者可以获得更加清晰和连贯的会议记录;无障碍服务可以为视障人士提供更加自然和易理解的语音内容。

技术前景:音频AI的发展方向

Step-Audio-EditX的出现不仅展示了当前音频AI技术的最新进展,也预示了未来音频处理技术的发展方向。随着技术的不断进步,我们可以期待更多创新功能的实现和应用场景的拓展。

多模态融合:音频与视频的协同编辑

未来的音频AI技术可能会进一步与视频处理技术融合,实现音频与视频的协同编辑。想象一下,系统可以自动识别视频中的人物情绪和场景氛围,生成匹配的音频效果;或者根据音频的情感变化自动调整视频的剪辑节奏和视觉效果。

实时交互:低延迟音频编辑体验

随着计算效率的提升,实时音频编辑将成为可能。用户可以在直播、视频会议等场景中即时调整音频效果,无需等待处理完成。这将极大提高音频编辑的灵活性和即时性,为内容创作和实时通信带来全新体验。

个性化定制:基于用户偏好的音频生成

未来的音频AI系统可能会学习用户的个人偏好和习惯,生成更加符合用户口味的内容。系统可以根据用户的历史选择推荐最适合的音频风格,或者根据用户的反馈不断优化生成效果,实现真正的个性化音频体验。

跨语言支持:全球化的音频创作

随着多语言处理技术的进步,未来的音频AI系统将能够更好地支持不同语言和方言之间的转换和编辑。这将打破语言障碍,促进全球范围内的音频内容创作和分享,为跨文化交流提供更加便捷的工具。

结语:音频创作的新纪元

Step-Audio-EditX的出现标志着音频处理技术进入了一个新的发展阶段。通过将大语言模型技术与音频处理相结合,这一创新工具不仅提高了音频编辑的效率和精度,也大大降低了专业音频制作的技术门槛。

对于内容创作者来说,Step-Audio-EditX提供了前所未有的创作自由度和可能性;对于开发者而言,这一开源项目为音频AI技术的进一步研究和应用提供了坚实的基础;对于普通用户,它意味着未来可以更加轻松地创建和分享高质量的音频内容。

随着技术的不断进步和应用场景的持续拓展,我们有理由相信,Step-Audio-EditX及其后续技术将继续推动音频创作领域的创新和发展,为人类带来更加丰富、自然和个性化的音频体验。在这个音频AI技术快速发展的时代,掌握和利用这些创新工具,将成为内容创作者和开发者的核心竞争力之一。