在人工智能领域,研究人员一直致力于理解大型语言模型如何存储和处理信息。最近,AI创业公司Goodfire.ai的一项研究提供了首个清晰证据,表明AI模型中的记忆和推理能力实际上通过完全不同的神经路径工作。这一发现不仅挑战了我们对AI如何学习的传统理解,还为未来开发更安全、更可控的AI系统开辟了新途径。

记忆与推理的神经分离

当工程师从训练数据构建AI语言模型(如GPT-5)时,至少会出现两个主要处理特征:记忆(回忆之前见过的确切文本,如著名引言或书籍段落)和推理(使用一般原理解决新问题)。Goodfire.ai的研究人员首次提供了证据,证明这些不同的功能实际上通过模型架构中完全独立的神经路径工作。

研究人员发现,这种分离异常清晰。在10月底发布的预印本论文中,他们描述了当移除记忆路径时,模型失去了97%的逐字回忆训练数据的能力,但保持了几乎全部的"逻辑推理"能力。

以艾伦人工智能研究所的OLMo-7B语言模型第22层为例,底部50%的权重组件在记忆数据上的激活度高23%,而顶部10%在普通非记忆文本上的激活度高26%。这种机制上的分离使研究人员能够"外科手术式"地移除记忆,同时保留其他能力。

算术能力与记忆的意外关联

最令人惊讶的发现是,算术操作似乎与记忆而非逻辑推理共享相同的神经路径。当研究人员移除记忆电路时,数学性能急剧下降到66%,而逻辑任务几乎不受影响。

这一发现可能解释了为什么AI语言模型在没有外部工具的情况下 notoriously struggle with math。研究人员解释说,模型试图从有限的记忆表中回忆算术,而不是像人类那样计算它,就像一个只背了乘法表但从未真正理解乘法如何运作的学生。这一发现表明,在当前规模下,语言模型将"2+2=4"更多地视为记忆事实而非逻辑操作。

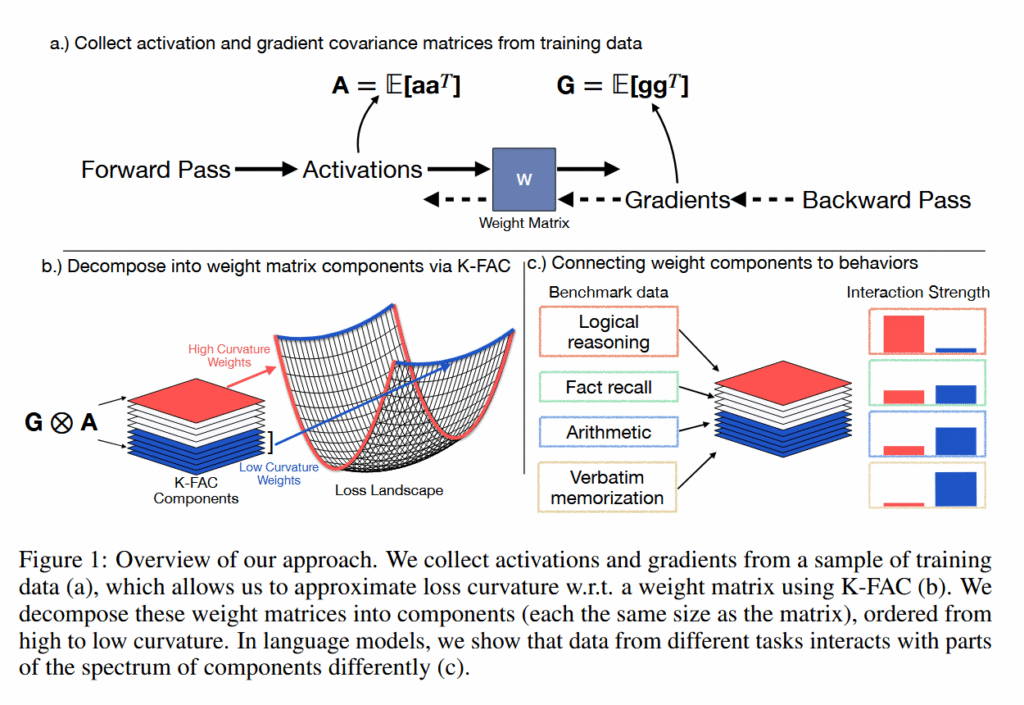

图1:研究方法概述。研究人员从训练数据样本中收集激活和梯度,使用K-FAC近似损失曲率,并将这些权重矩阵分解为组件。他们发现不同任务的数据与组件谱的不同部分相互作用。

损失景观:理解AI学习的新视角

为了理解Goodfire的研究人员如何在这些神经网络中区分记忆和推理,了解AI中称为"损失景观"的概念很有帮助。损失景观是一种可视化方法,展示了在调整AI模型的内部设置(称为"权重")时,其预测的错误程度。

想象一下,你正在调整一个有数百万个旋钮的复杂机器。"损失"衡量机器犯错误的数量。高损失意味着许多错误,低损失意味着错误很少。"景观"就是你能映射出每个旋钮设置组合的错误率时看到的样子。

在训练过程中,AI模型本质上是在这个景观中"滚下山"(梯度下降),调整其权重以找到错误最少的山谷。这个过程提供了AI模型的输出,比如问题的答案。

研究人员分析了特定AI语言模型损失景观的"曲率",测量模型性能对不同神经网络权重微小变化的敏感性。尖锐的峰谷代表高曲率(微小变化导致大效果),而平坦的平原代表低曲率(变化影响最小)。

使用称为K-FAC(Kronecker分解近似曲率)的技术,他们发现单个记忆的事实在这个景观中创造了尖锐的尖峰,但由于每个记忆项目在不同的方向上产生尖峰,当它们平均在一起时,会创造出平坦的轮廓。同时,许多不同输入依赖的推理能力在整个景观中保持一致的适度曲线,就像无论从哪个方向接近都保持大致相同形状的起伏山丘。

不同任务揭示机制光谱

研究人员在多个AI系统上测试了他们的技术,以验证这些发现在不同架构中是否成立。他们主要使用艾伦研究所的OLMo-2开放语言模型家族,特别是70亿和10亿参数版本,因为它们的训练数据是公开可访问的。对于视觉模型,他们在ImageNet上训练了定制的8600万参数Vision Transformer,并故意使用错误标记的数据来创建受控的记忆场景。他们还对照现有的记忆移除方法(如BalancedSubnet)验证了他们的发现,以建立性能基准。

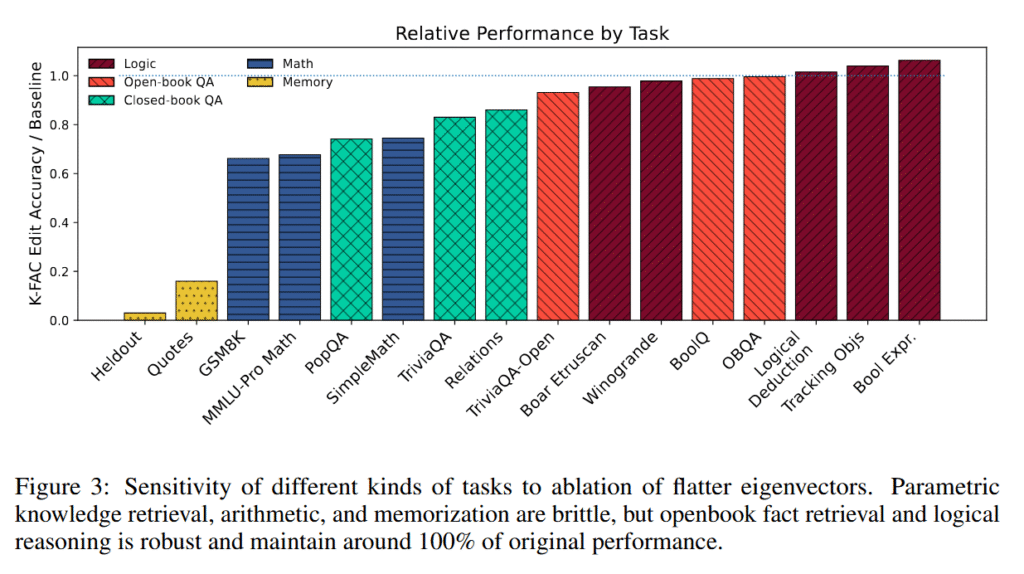

图3:不同类型任务对平坦特征向量去除的敏感性。参数知识检索、算术和记忆是脆弱的,但开放书籍事实检索和逻辑推理是强大的,保持约100%的原始性能。

团队通过有选择地从这些训练过的模型中移除低曲率权重组件来测试他们的发现。记忆内容从近100%的回忆率下降到3.4%。同时,逻辑推理任务保持了95%到106%的基线性能。

这些逻辑任务包括布尔表达式评估、逻辑推理谜题(解决者必须跟踪"如果A比B高"等关系)、通过多次交换跟踪对象,以及基准测试如BoolQ(是/否推理)、Winogrande(常识推理)和OpenBookQA(需要根据提供的事实进行推理的科学问题)。一些任务介于这两个极端之间,揭示了机制的光谱。

数学运算和闭卷事实检索与记忆共享路径,在编辑后性能下降到66%到86%。研究人员发现算术特别脆弱。即使模型生成相同的推理链,在移除低曲率组件后,它们也会在计算步骤失败。

有趣的是,机制分离因信息类型而异。像国家首都这样的常见事实在编辑后几乎没有变化,而像公司首席执行官这样的罕见事实下降了78%。这表明模型根据信息在训练中出现的频率分配不同的神经资源。

K-FAC技术的优势

K-FAC技术在不需要记忆内容的训练示例的情况下,优于现有的记忆移除方法。在未见过的历史引言上,K-FAC实现了16.1%的记忆率,而之前最好的方法BalancedSubnet实现了60%。

视觉变压器显示了类似的模式。当使用故意错误标记的图像训练时,模型为记忆错误标签和学习正确模式发展了不同的路径。移除记忆路径恢复了先前错误标记图像上66.5%的准确性。

记忆移除的局限性

然而,研究人员承认他们的技术并不完美。一旦被移除的记忆可能会在模型接受更多训练时返回,因为其他研究表明,当前的遗忘方法只是抑制信息,而不是从神经网络的权重中完全擦除它。这意味着"被遗忘"的内容可以通过针对这些被抑制区域的几个训练步骤重新激活。

研究人员也无法完全解释为什么某些能力(如数学)在记忆被移除时如此容易崩溃。目前尚不清楚模型是否真的记忆了所有算术,或者数学只是碰巧使用了与记忆相似的神经电路。此外,一些复杂的能力在他们的检测方法中可能看起来像记忆,即使它们实际上是复杂的推理模式。最后,他们用来测量模型"景观"的数学工具在极端情况下可能变得不可靠,尽管这不会影响实际的编辑过程。

未来展望

这项研究为理解AI如何存储和处理信息提供了新视角。如果信息移除技术在未来得到进一步发展,AI公司有一天可能会从神经网络中移除版权内容、私人信息或有害的记忆文本,而不会破坏模型执行转换任务的能力。

然而,由于神经网络以分布式方式存储信息,这些方式仍未被完全理解,研究人员目前表示他们的方法"不能保证敏感信息的完全消除"。这是AI新研究方向中的早期步骤。

对AI安全的潜在影响

这项研究对AI安全和隐私具有重要意义。通过识别和移除记忆路径,开发人员可以减少模型意外泄露训练数据中敏感信息的风险。这对于处理包含个人信息的医疗或法律文本的AI系统尤其重要。

此外,这项研究可能有助于开发"可编辑"的AI模型,这些模型可以针对特定任务进行定制,同时保持其核心推理能力。这可能使AI系统更加高效和专业化,减少不必要的记忆负担。

结论

Goodfire.ai的研究揭示了AI神经网络中记忆和推理能力的惊人分离,特别是算术能力与记忆而非逻辑推理的关联。这一发现不仅挑战了我们对AI如何学习的传统理解,还为未来开发更安全、更可控的AI系统开辟了新途径。

虽然这项技术仍有局限性,但它代表了理解AI内部工作机制的重要一步。随着研究人员继续探索这些发现,我们可能会看到AI系统设计的重大转变,使它们更加透明、安全和有用。随着AI在各个领域的应用不断扩大,这样的研究对于确保这些系统负责任地开发和部署至关重要。