在数字技术日新月异的今天,3D舞蹈生成技术正逐渐成为人工智能领域的一颗璀璨新星。GCDance,作为萨里大学和江南大学联合推出的创新框架,为我们展现了音乐与舞蹈结合的全新可能性。它不仅能够根据音乐的节奏和旋律生成逼真的3D舞蹈,还能通过文本提示实现对舞蹈风格的精准控制,为虚拟现实、游戏开发、舞蹈教学等领域带来了前所未有的创作空间。

GCDance的核心功能与特点

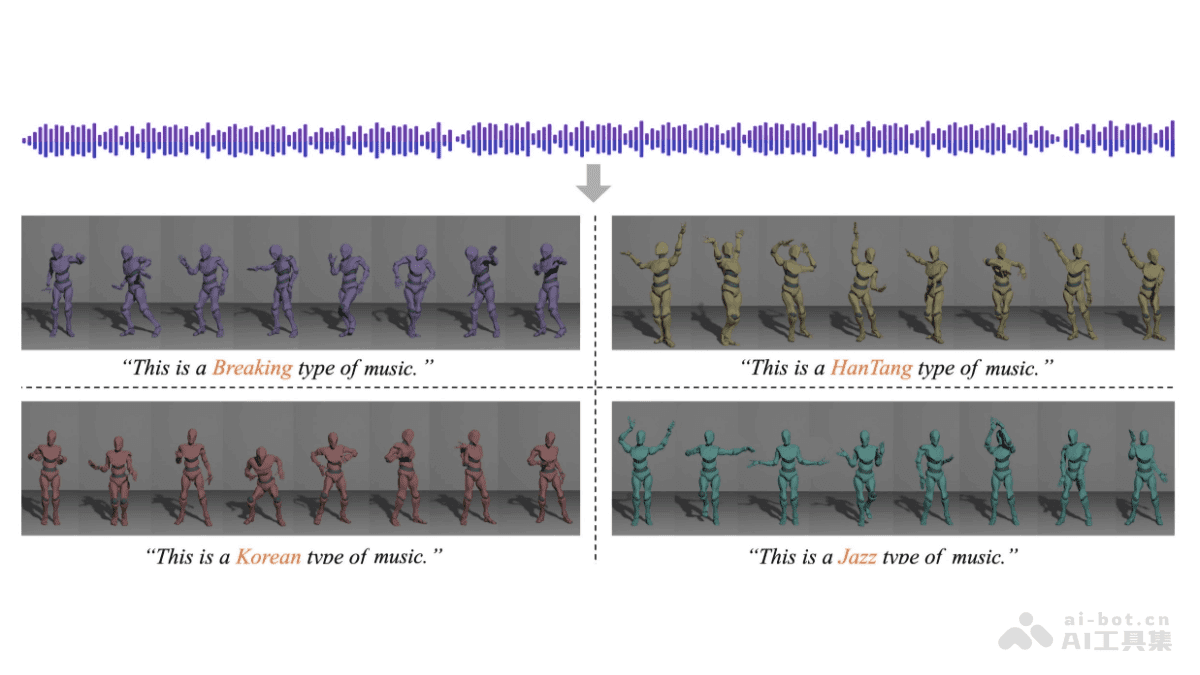

GCDance最引人注目的功能之一就是其风格可控的舞蹈生成能力。用户只需输入简单的文本描述,例如“街舞”、“爵士舞”或“芭蕾舞”,GCDance就能生成符合特定风格的舞蹈动作。这种风格控制不仅极大地提升了舞蹈生成的多样性,也为用户提供了更大的创作自由。

与音乐的精准对齐是GCDance的另一大亮点。通过深入分析音乐的节奏、节拍和旋律,GCDance能够确保生成的舞蹈动作与音乐完美同步。这种高度的同步性使得舞蹈看起来更加自然流畅,富有表现力。

此外,GCDance还支持多样化舞蹈生成。在同一音乐片段下,用户可以尝试生成多种不同风格的舞蹈,从而探索音乐的多种可能性。这种多样性不仅丰富了舞蹈的表现形式,也为用户带来了更多的创作灵感。

局部编辑功能是GCDance的一项创新设计。用户可以对舞蹈的特定部分,如手部动作或特定时间段的动作,进行定制化修改。这种局部编辑功能使得用户能够更加精细地调整舞蹈,使其更好地满足个性化需求。

GCDance生成的舞蹈动作高质量,涵盖了全身52个关节,包括手指关节。这使得生成的舞蹈动作更加自然、逼真,具有更高的物理合理性。这种高质量的动作生成能力为虚拟现实、游戏开发等领域提供了更加逼真的角色动画。

GCDance的技术原理剖析

GCDance的技术核心在于其扩散模型框架。该框架基于无分类器扩散模型,通过逐步去噪的方式从噪声中生成舞蹈序列。这种方法能够生成更加自然流畅的舞蹈动作,避免了传统方法中可能出现的抖动或不自然的过渡。

音乐特征提取是GCDance的关键步骤之一。GCDance结合了预训练的音乐基础模型(如Wav2CLIP)提取的高级语义特征和手工设计的音乐特征(如短时傅里叶变换STFT)捕捉低层次的音乐细节。这种多粒度特征融合的方式能够更好地捕捉音乐与舞蹈之间的复杂关系,确保舞蹈动作与音乐的高度同步。

文本特征嵌入是GCDance实现风格控制的关键技术。GCDance基于CLIP模型将文本提示(如舞蹈风格描述)嵌入到舞蹈生成的每个时间步中,并使用特征适配器(adapter)将其与音乐特征对齐。这种方法使得GCDance能够根据文本提示生成符合特定风格的舞蹈动作。

**特征调制(FiLM)**在GCDance中发挥着重要作用。特征调制层(Feature-wise Linear Modulation, FiLM)根据文本提示动态调整舞蹈生成过程,确保生成的舞蹈符合指定的风格。这种动态调整机制使得GCDance能够生成更加多样化和个性化的舞蹈。

为了生成更细致、更具表现力的全身舞蹈动作,GCDance采用了双流架构。该架构针对身体动作和手部动作分别建模,并使用两个Transformer网络独立处理。这种双流架构能够更好地捕捉身体和手部的细微动作,使得生成的舞蹈更加逼真。

编辑功能是GCDance的一项创新设计。基于扩散模型的编辑机制(如扩散修复),用户可以在生成过程中对舞蹈的特定部分施加约束,实现局部编辑和定制化生成。这种编辑功能为用户提供了更大的创作自由,使得用户能够根据自己的需求调整舞蹈。

GCDance的应用场景展望

GCDance的应用前景十分广阔。在**虚拟现实(VR)和增强现实(AR)**领域,GCDance可以用于生成虚拟角色的舞蹈,增强用户的沉浸感。用户可以与虚拟角色一起跳舞,或者观看虚拟角色的精彩表演。

在游戏开发领域,GCDance可以为游戏角色动态生成舞蹈动作,提升游戏的互动性和趣味性。游戏开发者可以利用GCDance快速生成各种风格的舞蹈动作,丰富游戏的内容。

在舞蹈教学领域,GCDance可以辅助编舞和教学,提供不同风格的舞蹈示例。舞蹈教师可以使用GCDance展示舞蹈动作,或者为学生提供个性化的舞蹈指导。

在音乐视频制作领域,GCDance可以根据音乐自动生成舞蹈,为音乐视频制作提供创意素材。音乐制作人可以利用GCDance快速生成各种风格的舞蹈,丰富音乐视频的内容。

在智能健身领域,GCDance可以结合音乐生成健身舞蹈,增加锻炼的趣味性。用户可以跟随GCDance生成的舞蹈进行锻炼,享受运动的乐趣。

GCDance面临的挑战与未来发展

尽管GCDance取得了显著的进展,但仍然面临着一些挑战。例如,如何进一步提高生成舞蹈的自然性和流畅性,如何更好地控制舞蹈的风格和情感表达,以及如何实现更加智能化的舞蹈编辑和创作等。未来,GCDance可以从以下几个方面进行发展:

- 提高舞蹈的自然性和流畅性:通过引入更加先进的动作捕捉技术和动画生成算法,提高生成舞蹈的自然性和流畅性,使其更加接近真实人类的舞蹈。

- 增强风格和情感控制:通过引入更加细致的风格描述和情感标签,增强对舞蹈风格和情感的控制,使得用户能够更加精确地控制生成的舞蹈。

- 实现智能化编辑和创作:通过引入人工智能技术,实现更加智能化的舞蹈编辑和创作,例如自动生成舞蹈变奏、自动调整舞蹈动作等,从而降低舞蹈创作的门槛。

- 拓展应用领域:将GCDance应用于更多的领域,例如康复训练、虚拟演出等,为人们的生活带来更多的便利和乐趣。

结语

GCDance作为一款创新的3D舞蹈生成框架,为我们展现了人工智能在艺术创作领域的巨大潜力。随着技术的不断发展,我们有理由相信,GCDance将在未来为我们带来更加精彩的舞蹈体验,为虚拟现实、游戏开发、舞蹈教学等领域注入新的活力。