在视频创作领域,音效一直是提升作品质感、增强叙事感染力的关键要素。然而,对于许多创作者来说,寻找合适的音效、进行精细的音效匹配却是一项耗时耗力的任务。如今,字节跳动推出了一项颠覆性的AI技术——SeedFoley音效生成模型,为视频创作带来了前所未有的便捷与高效。这项技术如同为无声的视频注入了灵魂,能够一键生成大片级的音效,让作品瞬间焕发声机。更令人惊喜的是,SeedFoley已正式上线字节跳动旗下的视频创作平台即梦,让每一位创作者都能轻松体验AI音效的魅力。

SeedFoley的出现,无疑是对传统音效制作方式的一次重大革新。它不仅降低了音效制作的门槛,让更多人能够参与到高质量视频创作中来,同时也极大地提升了创作效率,让创作者可以将更多精力投入到内容本身。那么,SeedFoley究竟是如何实现如此出色的音效生成效果的呢?

SeedFoley的核心在于其创新的端到端架构。这种架构使其能够像一位精密的“声音魔术师”,巧妙地将视频的时空特征与强大的扩散生成模型融合在一起,从而实现音效与视频内容的高度同步和完美契合。具体来说,SeedFoley首先会对视频进行逐帧分析,提取每一帧画面的关键信息,就像对视频进行一次“CT扫描”。然后,通过一个视频编码器对视频内容进行深度解读,理解视频中发生的事件和场景。接下来,这些视频理解的信息会被投射到条件空间,为后续的音效生成指明方向。

在音效生成过程中,SeedFoley采用了改进的扩散模型框架,就像一位拥有无限创意的“声音设计师”。它能够根据视频内容,智能生成与之完美匹配的音效方案。为了让AI更好地理解声音的艺术,SeedFoley在训练过程中学习了大量的语音和音乐相关标签,就像为AI配备了一部“声音百科全书”,使其能够区分音效和非音效,从而实现更精准的音效生成。

更值得一提的是,SeedFoley还是一位“全能选手”,能够处理各种长度的视频输入。无论是几秒钟的精彩瞬间,还是几分钟的完整故事,它都能轻松应对,并在音效的准确性、同步性以及与视频内容的匹配度上,达到行业领先水平。这意味着,无论你创作的是短视频还是长视频,SeedFoley都能为你提供高质量的音效解决方案。

SeedFoley的视频编码器也蕴含着独特的技术。它采用了快慢特征组合的方法,在高帧率下捕捉视频中细微的局部运动信息,就像鹰眼一样精准捕捉动作细节;而在低帧率下,则着重提取视频的语义信息,理解视频的故事内核。这种快慢特征双剑合璧的方式,既保留了关键的运动特征,又有效降低了计算成本,实现了低功耗、高性能的完美平衡。

这种快慢结合的方式,使得SeedFoley能够在低计算资源下,实现惊人的8fps帧级别视频特征提取,精准定位视频中的每一个细微动作。最终,通过Transformer结构融合快慢特征,深度挖掘视频的时空奥秘。为了进一步提升训练效果和效率,SeedFoley还巧妙地在一个批次中引入多个困难样本,就像给AI设置了进阶挑战,显著提升了语义对齐效果。同时,使用了sigmoidloss而非softmaxloss,在更低的资源消耗下,实现了媲美大批次训练的惊人效果。

在音频表征模型方面,SeedFoley同样别出心裁。与传统的VAE模型通常采用梅尔频谱(mel-spectrum)作为音频特征编码不同,SeedFoley大胆采用了原始波形(rawwaveform)作为输入,就像直接聆听声音的原始形态,经过编码后得到1D的音频表征。这种方式相比传统的mel-VAE模型,在音频的重构和生成建模上更具优势。为了确保高频信息的完整保留,SeedFoley的音频采样率高达32k,每秒钟的音频能够提取到32个音频潜在表征,有效提升了音频在时序上的分辨率,让生成的音效更加细腻逼真,如同天籁之音。

SeedFoley的音频表征模型还采用了两阶段联合训练策略,如同双管齐下。在第一阶段,使用掩码策略,剥离音频表征中的相位信息,将去相位后的潜在表征作为扩散模型的优化目标,就像先解构声音的结构,再进行重塑;在第二阶段,则使用音频解码器从去相位表征中重建相位信息,如同妙手回春,将声音还原到最真实的状态。这种分步走的策略,有效降低了扩散模型对表征的预测难度,最终实现了高质量音频潜在表征的生成和还原。

在扩散模型方面,SeedFoley选择了DiffusionTransformer框架,通过优化概率路径上的连续映射关系,实现了从高斯噪声分布到目标音频表征空间的概率精准匹配,如同在茫茫噪声中找到目标声音的正确路径。相较于传统扩散模型依赖马尔可夫链式采样的特性,SeedFoley通过构建连续变换路径,有效减少了推理步数,大幅降低了推理成本,让音效生成速度更快,效率更高。

在训练阶段,SeedFoley将视频特征与音频语义标签分别编码为隐空间向量,如同将视频和音频信息翻译成AI能够理解的语言,再通过通道维度拼接(Channel-wiseConcatenation)将二者与时间编码(TimeEmbedding)及噪声信号进行混合,形成联合条件输入,就像将视频、音频和时间信息融合在一起,让AI能够更全面地理解视频内容,生成更精准的音效。

这种巧妙的设计,通过显式建模跨模态时序相关性,有效提升了音效和视频画面在时序上的一致性以及内容的理解能力。在推理阶段,用户还可以通过调整CFG系数,灵活调整视觉信息的控制强度以及生成质量之间的平衡,就像拥有了音效调音台,可以根据需求自由调整音效风格。通过迭代式优化噪声分布,SeedFoley将噪声逐步转换为目标数据分布,最终生成高质量的音效音频。

为了避免音效中混入不必要的人声或背景音乐,SeedFoley还能够通过将人声以及音乐标签进行强制设定,如同给音效划定界限,有效提升音效的清晰度和质感。最后,将音频表征输入到音频解码器中,就能得到最终的完美音效。

总而言之,SeedFoley的诞生,标志着视频内容与音频生成实现了深度融合。它能够精准提取视频帧级视觉信息,通过洞察多帧画面信息,精准识别视频中的发声主体及动作场景。无论是节奏感强烈的音乐瞬间,还是电影中的紧张情节,SeedFoley都能精准卡点,营造出身临其境的逼真体验。更令人惊喜的是,SeedFoley还能智能区分动作音效和环境音效,如同声音界的艺术家,显著提升视频的叙事张力和情感传递效率,让你的视频作品更具感染力。

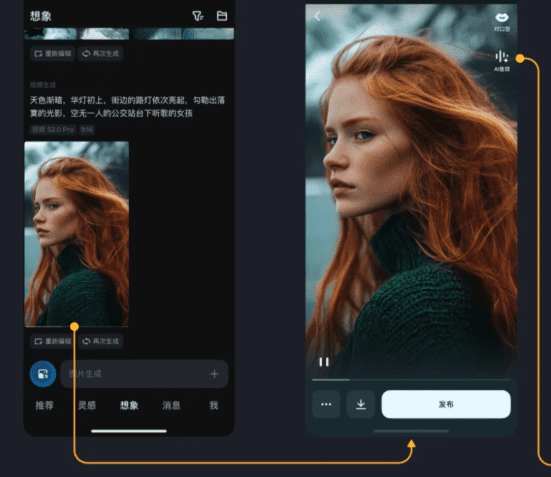

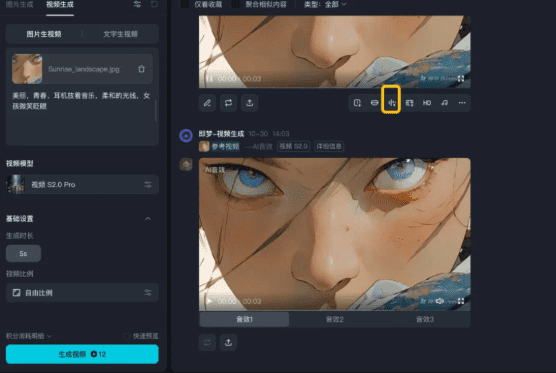

现在,AI音效功能已正式上线即梦平台,用户只需使用即梦生成视频后,选择AI音效功能,即可一键生成3个专业级音效方案,轻松摆脱AI视频的无声尴尬。在AI视频创作、生活Vlog、短片制作和游戏制作等高频场景中,都能便捷地制作出配有专业音效的高质量视频,让你的视频作品瞬间声动起来!

SeedFoley的出现,不仅为视频创作者带来了福音,也为整个AI音效领域注入了新的活力。随着技术的不断发展,我们有理由相信,未来的AI音效将更加智能、更加个性化,为视频创作带来更多可能性。