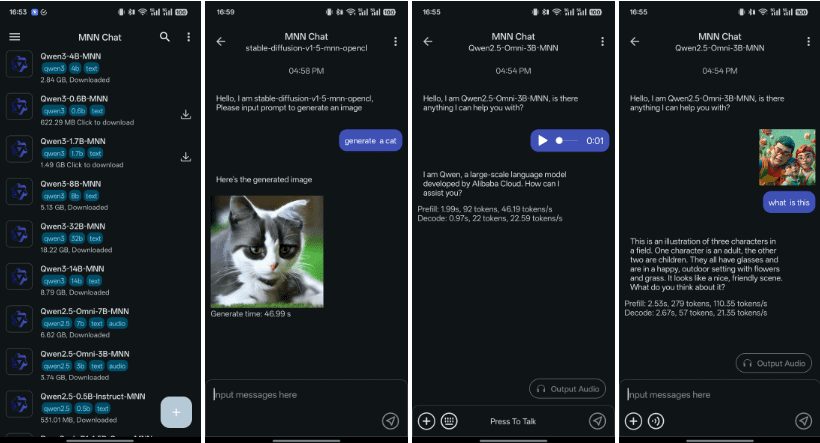

在移动端AI领域,阿里巴巴的MNN(Mobile Neural Network)开源项目迎来了一次重要的更新。MNN发布了其移动端多模态大模型应用MnnLlmApp的最新版本,该版本现在支持Qwen-2.5-Omni-3B和7B模型。这一举措使得开发者能够在移动设备上本地运行多模态AI应用,涵盖了文本到文本、图像到文本、音频到文本以及文本到图像生成等多种任务。由于其高效的性能和低资源占用,MNN的这一更新受到了广泛关注,并有望推动多模态AI在移动端的普及。

多模态能力:全面增强

新版的MnnLlmApp通过集成Qwen-2.5-Omni-3B和7B模型,并依托阿里云Qwen团队的Thinker-Talker架构,实现了对多种模态信息的综合处理能力。具体来说,该应用支持以下功能:

- 文本到文本:能够生成高质量的对话、报告或代码,其效果可以与云端模型相媲美。这意味着用户可以在本地设备上进行复杂的文本生成任务,而无需依赖网络连接。

- 图像到文本:可以识别图像中的文字或描述场景内容,适用于文档扫描和视觉问答等应用场景。例如,用户可以使用该功能快速提取图片中的文字信息,或者让AI描述图片的内容。

- 音频到文本:能够高效地转录语音,支持多语言语音识别。这对于需要处理大量语音数据的用户来说非常有用,例如记者可以利用该功能快速整理采访录音。

- 文本到图像:可以通过扩散模型生成高质量的图像,满足创意设计需求。这为设计师和艺术家提供了一个新的创作工具,他们可以通过简单的文本描述来生成各种图像。

社交媒体上的反馈显示,开发者对Qwen-2.5-Omni-3B在24GB GPU上的运行表现非常满意。该模型在OmniBench基准测试中保留了7B模型90%以上的多模态性能,同时内存占用降低超过50%(从60.2GB降至28.2GB)。这意味着开发者可以在资源有限的移动设备上运行更强大的AI模型。

技术优势:本地推理与极致优化

MNN框架以其轻量化和高性能而闻名,专为移动端和边缘设备优化。新版MnnLlmApp在CPU推理上表现卓越,预填充速度比llama.cpp快8.6倍,解码速度快2.3倍。这种性能提升使得在移动设备上运行复杂的AI模型成为可能。

该应用完全本地运行,无需联网即可处理多模态任务,确保数据隐私不会被上传至外部服务器。对于注重数据安全的用户来说,这是一个重要的优势。此外,MNN支持的模型范围广泛,涵盖Qwen、Gemma、Llama、Baichuan等主流开源模型,开发者可以通过GitHub直接下载并构建应用。MNN还提供FlashAttention-2支持,进一步提升长上下文处理的效率。FlashAttention-2是一种优化的注意力机制,可以减少计算量和内存占用,从而提高模型的运行速度。

应用场景:从开发到生产

MnnLlmApp的多模态能力使其在多种场景中展现出巨大的潜力:

- 教育与办公:通过图像到文本功能扫描文档,或用音频到文本转录会议记录。这可以大大提高工作效率,例如学生可以使用该功能快速整理课堂笔记,或者上班族可以使用该功能快速记录会议内容。

- 创意设计:利用文本到图像生成宣传素材或艺术作品。这为设计师和艺术家提供了一个新的创作工具,他们可以通过简单的文本描述来生成各种图像。

- 智能助手:构建本地化语音交互应用,如离线导航或客服助手。这意味着用户可以在没有网络连接的情况下使用语音助手,例如在偏远地区进行导航,或者在飞机上使用客服助手。

- 开发者学习:开源代码和详细文档为移动端大模型开发提供了参考范例。这为开发者提供了一个学习和实践移动端AI技术的平台,他们可以通过研究MnnLlmApp的源代码来了解如何开发自己的移动端AI应用。

MNN的开源属性和对Qwen-2.5-Omni的支持,使其成为开发者探索移动端多模态AI的理想平台。开发者表示,MnnLlmApp的推理速度(Llama3.18B预填充28tokens/s)虽然尚未达到顶尖水平,但其多模态集成和易用性足以满足原型开发需求。这意味着开发者可以使用MnnLlmApp快速构建和测试他们的AI应用。

行业背景:移动端AI的开源热潮

MNN的更新正值移动端AI竞争升温之际。DeepSeek的R1模型和Baichuan-Omni近期也推出了开源多模态解决方案,强调本地化部署和低成本。这些开源项目的出现,反映了移动端AI领域的一个重要趋势,即越来越多的开发者开始关注本地化部署和低成本解决方案。

然而,MNN凭借阿里生态支持和硬件优化(如对Android设备的深度适配)在性能与兼容性上占据优势。阿里云已开源超过200个生成式AI模型,Qwen系列在Hugging Face的下载量突破8000万,显示出其全球影响力。MnnLlmApp的iOS版本也已发布,进一步扩大了其跨平台覆盖。

移动端多模态的未来

MnnLlmApp的此次更新标志着多模态AI从云端向边缘设备的加速迁移。随着Qwen-2.5-Omni模型的持续优化(如支持更长视频或更低延迟语音生成),MNN将在智能家居、车载系统和离线助手领域发挥更大作用。例如,在智能家居领域,MNN可以用于控制家电设备,或者提供个性化的推荐服务。在车载系统领域,MNN可以用于提供导航、语音控制和驾驶辅助等功能。在离线助手领域,MNN可以用于提供本地化的信息查询和任务执行等服务。

然而,社交媒体也指出,应用的模型加载流程(需要从源码构建外部模型)仍需简化,以提升用户友好性。这意味着MNN需要在用户体验方面进行改进,以便吸引更多的开发者和用户。

MNN在多模态AI领域的持续演进

阿里巴巴MNN开源项目在移动端多模态AI领域的最新进展,不仅为开发者社区带来了强大的工具,也预示着AI技术应用的新方向。通过对Qwen-2.5-Omni模型的支持,MNN进一步巩固了其在移动设备上处理复杂AI任务的能力,为各种应用场景打开了新的可能性。以下将从技术、应用和未来发展三个方面,更深入地探讨MNN的价值和潜力。

技术解析:MNN如何实现高效多模态处理

MNN之所以能在移动端实现高效的多模态处理,得益于其独特的技术架构和优化策略。首先,MNN采用了轻量级的神经网络设计,减少了模型在移动设备上的计算负担。其次,MNN针对不同的硬件平台进行了深度优化,充分利用设备的计算资源。此外,MNN还支持多种模型格式,方便开发者集成不同的AI模型。

- 量化技术:MNN采用了量化技术,将模型的权重和激活值从浮点数转换为整数,从而减少了模型的存储空间和计算量。这对于在资源有限的移动设备上运行大型AI模型至关重要。

- 模型裁剪:MNN支持模型裁剪,可以去除模型中不重要的部分,从而减少模型的复杂度和计算量。这可以进一步提高模型的运行速度和效率。

- 硬件加速:MNN针对不同的硬件平台进行了深度优化,例如利用GPU进行并行计算,或者利用NPU进行神经网络加速。这可以充分利用设备的计算资源,提高模型的运行速度。

应用拓展:MNN在各行业的创新应用

MNN的多模态能力为各行各业带来了创新应用的可能性。在教育领域,MNN可以用于开发智能辅导系统,根据学生的学习情况提供个性化的学习内容。在医疗领域,MNN可以用于辅助医生进行疾病诊断,例如通过分析医学影像来识别病灶。在金融领域,MNN可以用于风险评估和欺诈检测,例如通过分析用户的交易行为来识别异常交易。

- 智能客服:MNN可以用于构建智能客服系统,通过语音识别和自然语言处理技术,实现人机对话,解答用户的问题。这种智能客服系统可以大大提高客户服务的效率和质量。

- 智能安防:MNN可以用于构建智能安防系统,通过图像识别和行为分析技术,实现对监控区域的实时监控,及时发现异常情况。这种智能安防系统可以大大提高安全防范的能力。

- 智能零售:MNN可以用于构建智能零售系统,通过图像识别和用户行为分析技术,实现对商品的自动识别和推荐,提高购物体验和销售额。

未来展望:MNN在多模态AI领域的持续发展

随着AI技术的不断发展,MNN在多模态AI领域仍有巨大的发展潜力。未来,MNN将继续优化其技术架构,提高模型的运行效率和精度。同时,MNN还将积极拓展其应用领域,为各行各业带来更多的创新应用。例如,MNN可以用于开发更智能的机器人,实现更复杂的人机交互。MNN还可以用于开发更强大的虚拟现实和增强现实应用,为用户带来更沉浸式的体验。

- 模型压缩:未来,MNN将继续探索模型压缩技术,例如知识蒸馏和模型剪枝,以进一步减少模型的存储空间和计算量。这将使得在资源有限的移动设备上运行更大型的AI模型成为可能。

- 异构计算:未来,MNN将更加注重异构计算,充分利用CPU、GPU和NPU等不同的计算资源,以提高模型的运行效率。这将使得MNN能够在不同的硬件平台上实现最佳的性能。

- 联邦学习:未来,MNN将探索联邦学习技术,使得多个设备可以在不共享数据的情况下协同训练模型,从而保护用户的数据隐私。这将使得MNN能够在更多的应用场景中使用。

MNN的持续演进不仅将推动移动端AI技术的发展,也将为开发者提供更广阔的创新空间,共同塑造多模态AI的美好未来。