Stream-Omni:新一代多模态人工智能模型深度解析

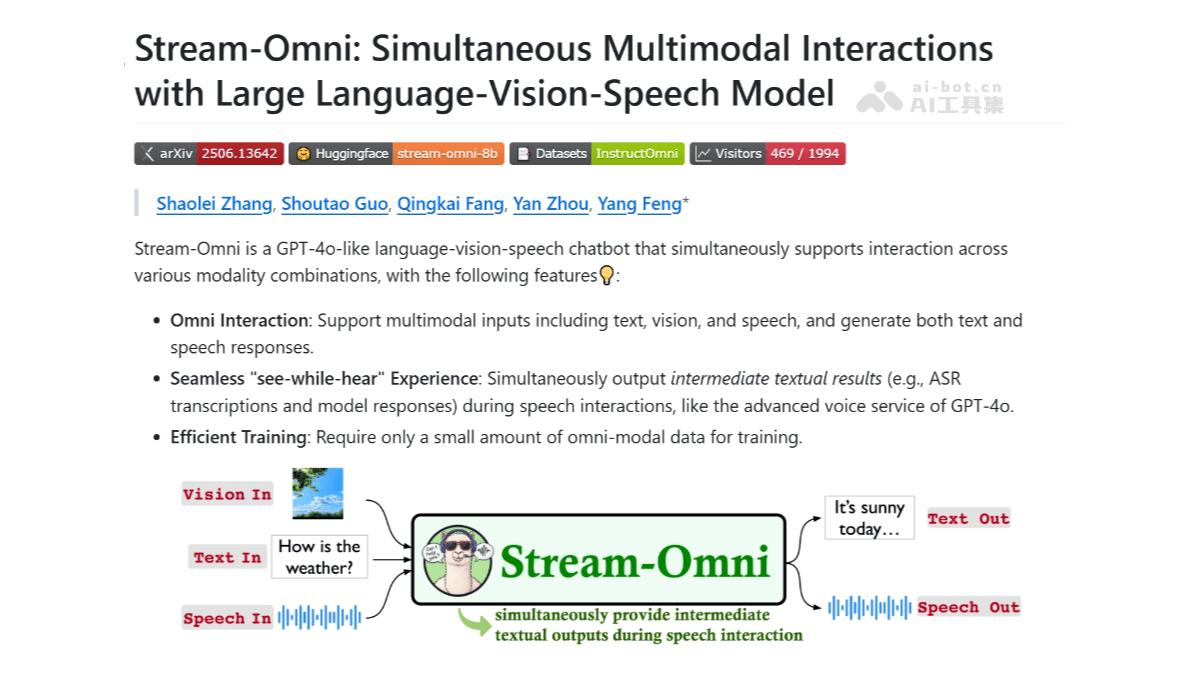

在人工智能领域,多模态交互正成为研究和应用的热点。中国科学院计算技术研究所、人工智能安全重点实验室及中国科学院大学联合推出的Stream-Omni模型,无疑是这一领域的又一力作。该模型以其强大的多模态处理能力,特别是对视觉、语言和语音的融合,引起了业界的广泛关注。

Stream-Omni的核心功能

Stream-Omni模型的核心在于其对多模态信息的综合处理能力。具体来说,它具备以下几个方面的关键功能:

- 多模态输入与输出: Stream-Omni支持文本、视觉(图像)和语音等多种模态的输入,并且能够同时生成文本和语音响应。这种能力使得人机交互更加自然和高效。

- 无缝“边听边看”体验: 在语音交互过程中,Stream-Omni能够实时输出中间文本结果,例如自动语音识别(ASR)转录和模型响应。这种实时反馈机制极大地提升了用户的交互体验。

- 高效训练: 相比于其他大型多模态模型,Stream-Omni仅需少量全模态数据即可进行训练。例如,仅使用23000小时的语音数据,就能达到出色的性能,这大大降低了训练成本和数据需求。

- 灵活的交互模式: Stream-Omni支持多种模态组合的交互,包括文本+视觉→文本、文本+视觉→语音、语音+视觉→文本、语音+视觉→语音等。这种灵活性使得该模型能够适应各种不同的应用场景。

- 视觉理解与语音交互: Stream-Omni在视觉理解和语音交互任务上表现出色,能够准确理解和生成与视觉内容相关的文本和语音信息。这为开发更智能的视觉辅助应用提供了可能。

技术原理的深入剖析

Stream-Omni之所以能够实现如此强大的功能,得益于其独特的技术架构和设计理念。以下是其关键技术原理的详细解析:

- 基于LLM的骨干架构: Stream-Omni以大型语言模型(LLM)为核心,利用LLM强大的语言理解和生成能力,为多模态交互提供基础支持。LLM的选择对于模型的整体性能至关重要,通常需要根据具体应用场景进行优化。

- 视觉文本对齐: Stream-Omni采用基于序列维度拼接的方式,将视觉编码器提取的视觉特征与文本输入进行拼接,然后共同输入到LLM中,实现视觉和文本模态的对齐。这种方法简单而有效,能够充分利用LLM的跨模态理解能力。

- 语音文本对齐: 为了实现语音模态的融合,Stream-Omni引入了基于CTC(Connectionist Temporal Classification)的层维度映射。通过在LLM的底部和顶部添加语音层,实现语音到文本的映射和文本到语音的生成,从而将语音模态与文本模态对齐。CTC是一种常用的语音识别技术,能够有效地处理语音序列中的时间对齐问题。

- 多任务学习: Stream-Omni采用多任务学习策略,同时训练视觉文本、语音文本及全模态(视觉+文本+语音)的任务。这种方法能够让模型更好地理解和生成多模态内容,提高模型的泛化能力和鲁棒性。

- 实时语音生成: Stream-Omni基于特殊的语音层设计和层维度映射,在生成文本的同时,实时生成对应的语音输出,实现流畅的语音交互。这种实时性对于提升用户体验至关重要,特别是在需要快速反馈的场景中。

- 数据驱动与监督学习结合: Stream-Omni依赖少量多模态数据进行训练,并基于精心设计的对齐机制和多任务学习,在有限的数据上实现高效的模态对齐和交互能力。这种方法降低了对大规模数据的依赖,使得模型更易于训练和部署。

Stream-Omni的应用场景展望

Stream-Omni的多模态交互能力使其在众多领域具有广泛的应用前景。以下是一些典型的应用场景:

- 智能车载系统: 在智能车载系统中,司机可以通过语音指令查询路线、获取路况信息。系统结合视觉信息(如导航地图、路况摄像头图像),实时显示文本提示和语音反馈,从而提升驾驶安全性和交互效率。例如,当司机询问前方路况时,系统不仅可以通过语音播报路况信息,还可以在导航地图上显示拥堵情况,提供更直观的信息。

- 教育辅助工具: 在教育领域,学生可以用语音提问,系统依据教材视觉内容(如图表、图片)给出详细文本解释和语音回答,帮助学生更好地理解和学习知识。例如,当学生询问某个数学公式时,系统不仅可以通过语音解释公式的含义,还可以显示相关的图表和例题,帮助学生更深入地理解。

- 智能家居控制: 作为智能家居助手,用户可以通过语音指令控制家电设备,系统结合视觉输入(如摄像头捕捉的环境信息)提供文本或语音反馈,实现更智能、便捷的家居控制。例如,用户可以通过语音指令打开客厅的灯,系统可以通过摄像头识别客厅的亮度,并自动调节灯的亮度,提供更舒适的照明环境。

- 医疗辅助诊断: 医生在查看患者病历时,可以通过语音指令查询关键信息,系统结合视觉报告(如X光片、CT图像)提供详细的文本分析和语音解释,辅助医生更准确地做出诊断。例如,当医生查看X光片时,系统可以通过图像识别技术自动标注出可疑区域,并提供相关的医学文献,帮助医生更准确地判断病情。

- 智能客服服务: 在客服领域,客服人员可以通过语音与客户交流,系统实时显示相关文本信息和视觉提示(如产品图片、操作流程图),帮助客服人员快速理解客户需求并提供准确解答,提升服务质量和效率。例如,当客户咨询某个产品的使用方法时,系统可以自动显示该产品的操作流程图,并提供相关的语音提示,帮助客服人员更高效地解决问题。

Stream-Omni与GPT-4o的对比分析

Stream-Omni常被拿来与OpenAI的GPT-4o进行比较,两者都是旨在实现更自然、更高效的人机交互的多模态模型。虽然两者都具有强大的多模态处理能力,但在技术实现和应用场景上存在一些差异。

GPT-4o在多模态融合方面采用了更为复杂的Transformer架构,能够更好地捕捉不同模态之间的细微关联。然而,这种复杂性也带来了更高的计算成本和数据需求。相比之下,Stream-Omni采用的基于序列维度拼接和CTC的层维度映射方法,在保证性能的同时,降低了计算复杂度和数据需求,使其更易于训练和部署。

此外,两者在应用场景上也各有侧重。GPT-4o更侧重于通用型的多模态交互,例如智能助手、内容创作等。而Stream-Omni则更侧重于特定领域的多模态应用,例如智能车载系统、教育辅助工具等。这种差异也反映了两者的设计理念和目标。

项目地址及资源

对于希望深入了解Stream-Omni的读者,以下是一些有用的资源:

- GitHub仓库:https://github.com/ictnlp/Stream-Omni

- HuggingFace模型库:https://huggingface.co/ICTNLP/stream-omni-8b

- arXiv技术论文:https://arxiv.org/pdf/2506.13642

通过这些资源,可以获取Stream-Omni的源代码、预训练模型和技术文档,从而更好地了解和使用该模型。

结论与展望

Stream-Omni作为一种新型的多模态人工智能模型,在视觉理解、语音交互及视觉引导的语音交互任务上表现出色。其独特的技术架构和高效的训练方法,使其在众多领域具有广泛的应用前景。随着多模态交互技术的不断发展,Stream-Omni有望在未来的智能应用中发挥更大的作用。

尽管Stream-Omni已经取得了显著的成果,但仍然存在一些挑战。例如,如何进一步提高模型的多模态融合能力,如何降低模型的计算成本和数据需求,以及如何更好地应对复杂场景下的噪声干扰等。这些问题需要在未来的研究中不断探索和解决。

总的来说,Stream-Omni的出现为多模态人工智能领域注入了新的活力。我们有理由相信,在不久的将来,多模态交互技术将成为人工智能发展的重要方向,为人类带来更智能、更便捷的生活体验。