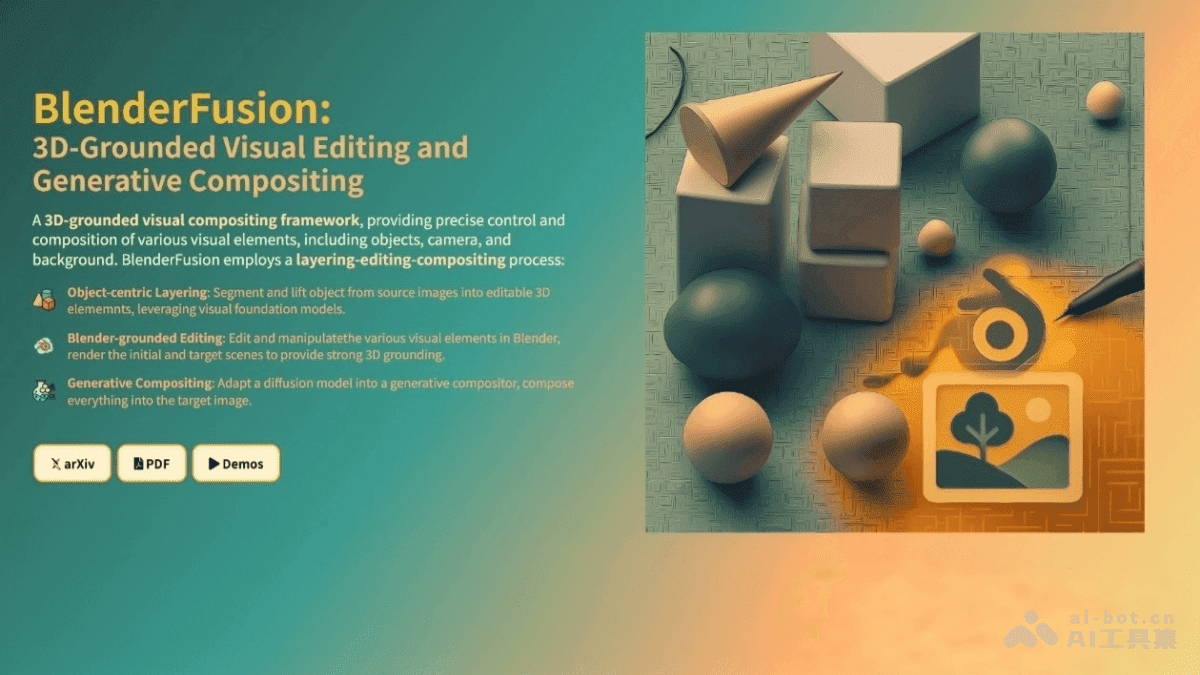

BlenderFusion:谷歌DeepMind的生成式视觉合成框架深度解析

在人工智能领域,生成式模型正以前所未有的速度发展,深刻地改变着各个行业。其中,谷歌DeepMind推出的BlenderFusion框架,无疑是视觉合成领域的一项重大突破。它巧妙地将传统的3D编辑软件Blender与先进的AI模型相结合,实现了前所未有的精确几何编辑和多样化视觉合成能力。本文将深入剖析BlenderFusion的技术原理、核心功能以及潜在的应用场景,带您领略这一创新框架的强大之处。

BlenderFusion:重塑视觉合成的未来

BlenderFusion的核心在于其独特的三步流程,这使得它在复杂的视觉合成任务中表现出色,能够实现对对象、相机和背景进行灵活、解耦且具有3D感知能力的操控:

对象中心化分层:该步骤从源图像中提取出感兴趣的对象,并将其转换为可编辑的3D元素。这为后续的编辑和合成奠定了基础。利用视觉基础模型,如SAM进行分割,以及Depth Pro进行深度估计,可以精确地从图像中分离出目标对象,并构建其3D表示。

基于Blender的编辑:在这一步骤中,提取出的3D对象被导入到Blender中,利用Blender强大的功能进行多样化的编辑操作。这包括对象的基本变换(如位置、旋转、缩放)、属性修改(如颜色、材质、形状)以及非刚性变形等。此外,BlenderFusion还支持相机控制和背景替换,为生成合成步骤提供精确的3D控制信号。

生成合成:最后,生成合成器将编辑后的元素与背景无缝融合,生成最终的逼真图像。该合成器基于扩散模型,并采用双流架构,同时处理原始场景(编辑前)和目标场景(编辑后)的信息。通过交叉视图注意力机制,将两者的信息进行融合,从而实现高质量的图像合成。

BlenderFusion的核心功能:创造力的无限延伸

BlenderFusion之所以能够在视觉合成领域脱颖而出,离不开其强大的核心功能:

精确的3D几何控制:BlenderFusion允许用户基于Blender对对象进行精确的3D编辑,包括位置、旋转、缩放等变换,以及颜色、材质、形状等属性的修改。这种精细的控制能力使得用户能够创造出高度逼真的视觉效果。

灵活的相机控制:BlenderFusion支持独立于对象操作调整相机视角,实现复杂的视角变化。这为用户提供了更大的创作自由,可以从不同的角度展示对象,从而增强视觉冲击力。

复杂的场景合成:BlenderFusion能够将编辑后的对象和背景无缝融合,生成逼真的最终图像,并且支持多对象操作和复杂的场景编辑。这使得用户能够创建出复杂的、细节丰富的场景,从而满足各种视觉需求。

解耦的对象和相机控制:BlenderFusion允许用户在保持相机固定的情况下操作对象,或者在保持对象固定的情况下调整相机,实现高度解耦的控制。这种解耦的控制方式使得用户能够更加灵活地调整场景,从而获得最佳的视觉效果。

强大的泛化能力:BlenderFusion不仅能够处理已知的场景和对象,还支持应用在未见过的场景和对象上。此外,它还支持从简单到复杂的编辑任务,包括渐进式多步编辑。这种强大的泛化能力使得BlenderFusion能够适应各种不同的应用场景。

技术原理:三大核心模块协同运作

BlenderFusion的强大功能背后,是其精妙的技术原理。它主要由三个核心模块组成,分别是对象中心化分层、基于Blender的编辑和生成合成。这三个模块协同运作,共同实现了BlenderFusion的视觉合成能力。

1. 对象中心化分层(Object-centric Layering)

对象中心化分层是BlenderFusion的第一步,也是至关重要的一步。该模块负责从输入图像中提取对象,并将其转换为可编辑的3D元素。为了实现这一目标,BlenderFusion采用了多种先进的技术:

视觉基础模型:BlenderFusion利用视觉基础模型(如SAM)进行分割,从而将图像中的对象精确地分离出来。这些模型经过大量的训练,能够识别各种不同的对象,并将其准确地分割出来。

深度估计:为了获得对象的3D信息,BlenderFusion使用Depth Pro进行深度估计。深度估计技术可以从2D图像中推断出场景的深度信息,从而帮助构建对象的3D表示。

图像到3D模型(可选):为了生成完整的3D网格,BlenderFusion还可以选择使用图像到3D模型(如Rodin、Hunyuan3D)。这些模型可以将2D图像转换为完整的3D模型,从而为后续的编辑提供更丰富的信息。生成的完整3D网格会与2.5D表面网格对齐,以便在测试时进行更灵活的编辑。

通过对象中心化分层,BlenderFusion能够将图像中的对象转换为可编辑的3D元素,为后续的编辑和合成奠定坚实的基础。

2. 基于Blender的编辑(Blender-grounded Editing)

基于Blender的编辑是BlenderFusion的核心模块之一。该模块利用Blender强大的功能,对提取出的3D对象进行多样化的编辑操作。Blender是一款专业的3D建模和动画软件,拥有丰富的功能和工具,可以实现各种复杂的编辑操作。

基本变换:BlenderFusion允许用户对对象进行基本变换,包括位置、旋转、缩放等。这些变换可以改变对象在场景中的位置和姿态,从而实现不同的视觉效果。

属性修改:BlenderFusion还允许用户修改对象的属性,包括颜色、材质、形状等。这些属性的修改可以改变对象的外观,从而创造出不同的视觉效果。

非刚性变形:除了基本变换和属性修改之外,BlenderFusion还支持非刚性变形。非刚性变形可以改变对象的形状,从而实现更复杂的编辑效果。

相机控制和背景替换:BlenderFusion还支持相机控制和背景替换。用户可以调整相机视角,从不同的角度展示对象。此外,用户还可以替换背景,从而改变场景的整体氛围。

通过基于Blender的编辑,BlenderFusion能够对3D对象进行各种复杂的编辑操作,为生成合成步骤提供精确的3D控制信号。

3. 生成合成(Generative Compositing)

生成合成是BlenderFusion的最后一个模块,也是实现最终视觉效果的关键。该模块基于扩散模型,将Blender的渲染结果与背景融合,生成最终的逼真图像。扩散模型是一种强大的生成模型,可以生成高质量的图像。

双流架构:生成合成器基于双流架构,同时处理原始场景(编辑前)和目标场景(编辑后)的信息。这种双流架构可以更好地保留原始场景的信息,并将其与编辑后的场景进行融合。

交叉视图注意力机制:为了更好地融合原始场景和编辑后的场景的信息,生成合成器采用了交叉视图注意力机制。该机制可以学习到两个场景之间的关联,并将它们的信息进行融合。

源遮罩(source masking)和模拟对象抖动(simulated object jittering):为了提高模型在复杂编辑任务中的灵活性和解耦能力,BlenderFusion采用了源遮罩和模拟对象抖动两种训练策略。源遮罩可以防止模型过度依赖原始场景的信息,而模拟对象抖动可以提高模型的鲁棒性。

通过生成合成,BlenderFusion能够将Blender的渲染结果与背景无缝融合,生成最终的逼真图像。

应用场景:无限可能性的探索

BlenderFusion的强大功能使其在各种不同的应用场景中都有着广泛的应用前景:

影视制作:BlenderFusion可以用于电影、电视剧的视觉效果(VFX)制作,例如添加虚拟对象、调整场景布局、改变背景等,从而创建逼真的合成场景。

游戏开发:BlenderFusion可以助力游戏开发者快速设计和编辑游戏场景,例如添加和调整游戏中的对象、改变相机视角等,从而创造逼真的游戏环境。

广告:BlenderFusion可以帮助广告设计师制作高质量的产品展示图,突出产品特点,从而吸引消费者的眼球。

建筑设计:BlenderFusion可以帮助建筑师和室内设计师进行室内设计可视化,例如添加和调整家具、装饰品等,从而生成逼真的室内效果图。

艺术创作:艺术家可以借助BlenderFusion的3D编辑和生成合成能力创作独特的数字艺术作品,实现创意可视化。

总结与展望

BlenderFusion作为谷歌DeepMind推出的生成式视觉合成框架,凭借其精确的3D几何控制、灵活的相机控制、复杂的场景合成、解耦的对象和相机控制以及强大的泛化能力,在视觉合成领域取得了显著的突破。它的出现,不仅为视觉内容的创作提供了新的工具和方法,也为人工智能技术在视觉领域的应用开辟了新的道路。随着技术的不断发展,我们有理由相信,BlenderFusion将在未来发挥更大的作用,为各行各业带来更多的创新和价值。

BlenderFusion的开源项目地址:

- 项目官网:https://blenderfusion.github.io/

- arXiv技术论文:https://arxiv.org/pdf/2506.17450