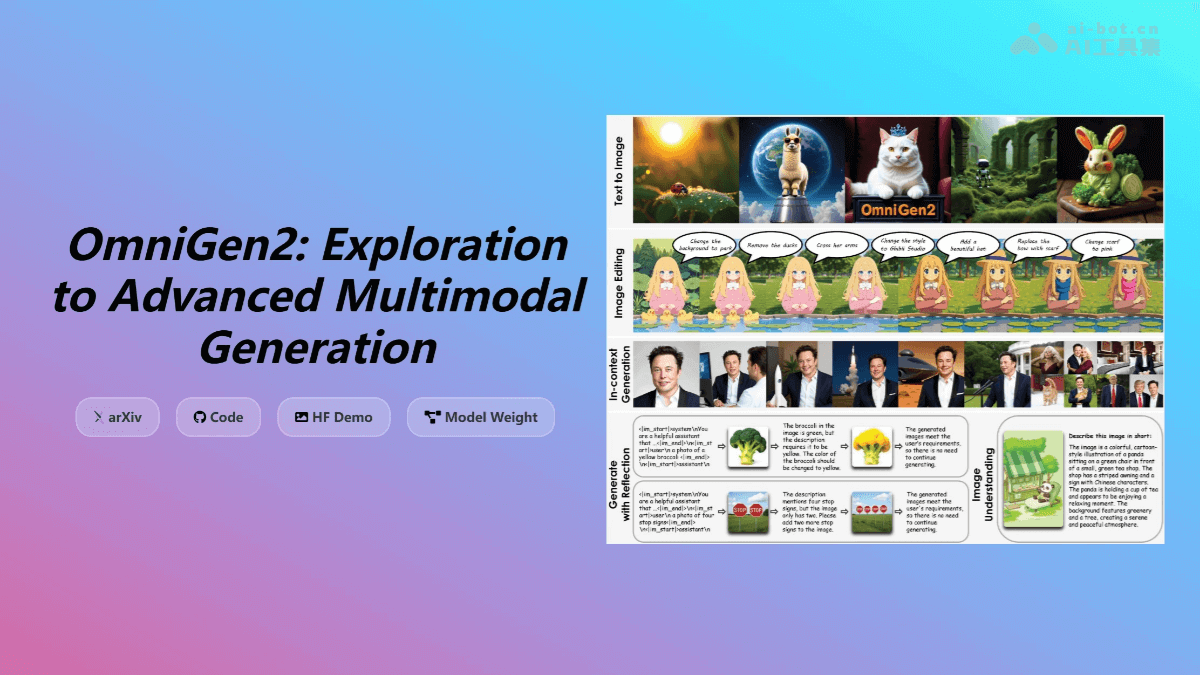

OmniGen2是由北京智源人工智能研究院开源的多模态生成模型,它代表了当前AI技术在图像生成领域的前沿水平。该模型不仅能够根据文本提示生成高质量的图像,还支持指令引导的图像编辑,例如修改图像的背景或人物特征。这种强大的功能为商业设计、创意产业以及学术研究等多个领域带来了新的可能性。

OmniGen2的核心功能

OmniGen2的功能集合十分强大,主要包括以下几个核心方面:

文本到图像生成:

OmniGen2能够将文本描述转化为逼真且美观的图像。模型在多个基准测试中表现卓越,例如在GenEval和DPG-Bench上的得分分别高达0.86和83.57,充分验证了其卓越的图像生成能力。这一功能使得用户可以通过简单的文本指令,快速生成符合需求的图像内容。

指令引导的图像编辑:

该模型支持通过指令驱动的图像修改,用户可以根据具体需求对图像进行局部或整体的调整。例如,改变图像中人物的服装颜色,或者将照片转换为动漫风格。OmniGen2在图像编辑任务中实现了编辑准确性与图像保真度的平衡,确保修改后的图像既符合指令要求,又能保持高质量的视觉效果。

上下文生成:

OmniGen2能够处理和整合多种输入信息,例如人物、参考物体和场景描述,从而生成新颖且连贯的视觉输出。在OmniContext基准测试中,OmniGen2在视觉一致性指标上超越了现有开源模型15%以上。这一功能使得模型在处理复杂场景和多对象交互时,能够保持高度的视觉连贯性。

视觉理解:

OmniGen2继承了Qwen-VL-2.5基础模型强大的图像内容解析和分析能力。这意味着模型不仅能够生成图像,还能理解图像中的内容,并根据用户的指令进行相应的操作。这种视觉理解能力使得OmniGen2在图像生成和编辑任务中更加智能和高效。

OmniGen2的技术原理

OmniGen2的技术架构和实现方法是其强大功能的基础。以下是该模型的一些关键技术特点:

双路径架构:

OmniGen2采用了独立的文本和图像解码路径,分别处理文本和图像模态。文本生成部分基于Qwen2.5-VL-3B多模态语言模型(MLLM),图像生成则通过一个独立的扩散Transformer模块完成。这种双路径架构避免了文本生成对图像质量的负面影响,确保了图像生成的高质量和高效率。

扩散Transformer:

图像生成部分采用了一个32层的扩散Transformer,隐藏维度为2520,总参数量约为40亿。该模块使用修正流(Rectified Flow)方法进行高效图像生成。扩散Transformer能够逐步将随机噪声转化为清晰的图像,从而实现高质量的图像生成。

Omni-RoPE位置编码:

OmniGen2引入了一种新颖的多模态旋转位置嵌入(Omni-RoPE),将位置信息分解为序列和模态标识符、二维高度坐标和宽度坐标。这种位置编码方法能够精确编码图像中每个位置的信息,同时支持多图像空间定位和身份区分。Omni-RoPE使得模型能够更好地理解和处理图像中的空间关系。

反思机制:

为了提升生成图像的质量和一致性,OmniGen2设计了专门的反思机制。模型能够自我评估生成结果,并在多个轮次中进行改进。这种反思机制使得模型能够不断优化生成结果,提高图像的质量和逼真度。

训练策略:

OmniGen2采用分阶段训练方法,首先在文字转图像任务上预训练扩散模型,然后引入混合任务训练,最后进行反思能力的端到端训练。这种分阶段训练方法能够有效地提高模型的性能和泛化能力。

数据处理:

训练数据从视频中提取,经过多重过滤,包括DINO相似性过滤和VLM一致性检查,确保数据质量。高质量的训练数据是模型性能的重要保障。

OmniGen2的应用场景分析

OmniGen2作为一种强大的多模态生成模型,具有广泛的应用前景。以下是一些典型的应用场景:

设计概念生成:

设计师可以通过简单的文本描述,快速生成设计概念图和草图。OmniGen2可以帮助设计师快速可视化他们的想法,并为设计过程提供灵感。例如,设计师可以输入“现代简约风格的客厅设计”,模型即可生成多张符合描述的设计草图。

故事创作辅助:

内容创作者可以根据故事的情节和角色描述,生成相应的场景和角色图像。这可以帮助创作者更好地呈现他们的故事,并吸引读者的注意力。例如,作家可以输入“一个年轻的魔法师在古老的森林中探险”,模型即可生成符合描述的场景和角色图像。

视频制作素材生成:

创作者可以生成各种场景、角色动作和特效图像,然后将其导入到视频编辑软件中,用于制作动画、特效视频或实拍视频的补充素材。OmniGen2可以大大降低视频制作的成本和难度,并提高制作效率。例如,视频制作者可以生成一段爆炸特效的图像序列,然后将其添加到实拍视频中。

游戏场景和角色生成:

开发者可以通过文本描述快速生成游戏中的场景和角色。OmniGen2可以帮助游戏开发者快速构建游戏世界,并为玩家提供更加丰富的游戏体验。例如,游戏开发者可以输入“一个未来都市的街道”,模型即可生成符合描述的游戏场景。

教学资源生成:

教育工作者可以根据教学内容生成相关的图像和示意图。例如在讲解历史事件时,生成与之相关的古代战争场景或历史人物图像。OmniGen2可以帮助教育工作者更好地呈现教学内容,并提高学生的学习兴趣。

案例分析:OmniGen2在创意设计中的应用

以一个室内设计师为例,假设设计师需要为一个客户设计一个现代风格的客厅。设计师可以使用OmniGen2来快速生成设计概念图。设计师只需输入以下文本描述:

“一个现代简约风格的客厅,拥有落地窗、白色沙发、木质地板和绿色植物。”

OmniGen2可以根据这个描述生成多个不同的设计方案,每个方案都符合现代简约风格,并包含了落地窗、白色沙发、木质地板和绿色植物等元素。设计师可以从中选择最符合客户需求的设计方案,并进行进一步的修改和完善。

这个案例展示了OmniGen2在创意设计中的应用价值。通过使用OmniGen2,设计师可以快速生成设计概念图,并为客户提供更多选择。这不仅提高了设计效率,还能够帮助设计师更好地满足客户的需求。

OmniGen2的未来发展趋势

随着人工智能技术的不断发展,OmniGen2在未来将会有更多的发展机会。以下是一些可能的发展趋势:

- 更高的图像质量:随着算法的不断优化,OmniGen2生成的图像质量将会越来越高,甚至可以达到照片级的逼真度。

- 更强的可控性:未来的OmniGen2将能够更好地理解用户的指令,并根据用户的具体需求生成更加精确的图像。

- 更广泛的应用领域:随着技术的不断成熟,OmniGen2将会被应用到更多的领域,例如虚拟现实、增强现实和元宇宙等。

结论

OmniGen2作为一种强大的多模态生成模型,具有广泛的应用前景。它不仅能够生成高质量的图像,还支持指令引导的图像编辑,并具有强大的上下文生成和视觉理解能力。随着人工智能技术的不断发展,OmniGen2将会成为创意设计、内容创作、视频制作、游戏开发和教育等领域的重要工具。