大模型在2025高考中的表现:智力跃升与局限并存

人工智能(AI)技术在过去一年中取得了显著进展,特别是在大型语言模型(LLM)领域。为了更精准地评估AI的能力,我们再次将国内外主流大模型置于中国高考的语境下进行测试,以此衡量其智能化水平。本次测评不仅延续了去年的传统,更旨在探索AI在教育领域的潜力与局限。

参与测评的大模型包括:

- 豆包

- DeepSeek(R1-0528版)

- ChatGPT(o3)

- 元宝(Hunyuan t1)

- Kimi(k1.5)

- 文心一言

- 通义千问

为了确保测评的公正性与贴近用户体验,所有测试均在各模型公开的PC端进行,并采取多次采样取平均分的方式。DeepSeek-R1由于不支持图片识别作答,仅测试了纯文字题目,因此其最终成绩仅供参考。

测试细节如下:

- 试卷选择: 选用2025年新高考山东卷,因其获取速度快且难度较高,能有效检验大模型的能力上限。

- 联网限制: 在可关闭联网功能的产品中,统一关闭联网功能,以避免“搜题”行为。对于无法关闭联网的o3和文心,虽有检查,但文心未发现搜题情形,o3虽有少量搜题,但未带来明显收益。

- 评分标准: 非选择题由两位专业人士打分,差异较大时引入第三方讨论定分,并邀请高中老师抽检,确保评分标准的统一。

特殊处理:

- 特邀资深教师对AI作文进行匿名评审,保证客观公正。

- 英语听力部分因无法获取试题,所有模型均计为满分。

总体表现:一本到顶尖大学的跨越

今年的测评结果显示,各大模型在文理科成绩上均实现了显著飞跃。其中,总分最高的模型有望进入山东省前1000名,具备冲击顶尖学府的潜力。

大模型不再严重偏科,理科进步尤为迅速。文科总分平均增长115.6分,理科总分平均增长147.4分。虽然理科增速更快,但平均总分(181.75分)仍低于文科(228.33分)。

数学能力的显著提升

数学是本次测评中进步最显著的科目,平均分较去年提升了84.25分。AI在数学上的表现甚至超越了语文和英语,预示着其更擅长处理逻辑性强和有标准化解题路径的题目。

多模态能力成为关键

与去年相比,模型的视觉理解能力显著提升,这一点在包含大量图像题的学科中尤为突出。物理和地理的平均分提升了约20分,生物提升了15分。化学科目整体表现稍弱,但平均分也比去年提高了12.6分。

数学:逼近满分,却败于基础

在数学科目中,AI的表现令人瞩目。即便表现最差的模型,也能拿下128.75分的高分,远超去年最佳模型的70分。

然而,所有数学学霸AI却在同一道选择题上栽了跟头。

这道题的数学原理非常简单,是一道基础的向量加减法题。只需在图上连接 (0,2) 与 (2,0) 两点,即可得到目标向量,模长 2 倍根号 2。

核心问题在于,AI对图像的识别存在偏差。对于大模型而言,这张图的视觉信息极其混乱,虚线、实线、坐标轴、数字、文字相互交织,甚至文字与关键线段存在多处重叠。这种视觉上的“脏数据”,成为了AI精准识别的噩梦。

语文:擅长举例,不擅长升华

作为大语言模型,语文和英语一向是AI的传统强项。然而,在大模型的数理逻辑大幅进步后,语文和英语能力反而显得有点不够看了。

在选择题部分,除豆包和DeepSeek-R1以外,其余模型的错误率均在20%以上。这或许揭示了AI与人类不同的一个困境:对于AI,要读一段长材料,在一组高度迷惑性的选项中,精准辨析每一个细微的语义差别和逻辑陷阱,难度可能反而更高。

在作文题上,AI的平均分高于人类,但难有真正的佳作。AI作文大多属于稳妥的“二类文”,很少偏题,但因其深刻性、丰富性、创造性不足,难以产生动人心弦的“一类文”,其结尾部分的升华更是套路化明显。

以下为元宝生成的AI作文,在人类阅卷老师处获得了53.5分的高分:

AI作文的语言不可谓不华丽,引经据典也自然十分丰富充满细节,但逻辑上像不像你的家长对你说,你看看谁谁谁都怎么样了,你是不是也该怎么样?

AI的自主创作更像是在执行一个固化的写作模板:用排比式的案例填充框架,最终导向一个略显生硬的僵化升华。它能写出看似优秀的段落,却难以织就一篇真正动人的文章。

英语:作文成拖累

与语文相似,AI在英语上的表现也进入了一个平台期。所有参评模型的平均分仅比去年提高了3.2分,进步幅度远小于数学。而模型的整体分数,也落在了130-140分的区间,并未到达人类学霸的水平。

AI的英文水平是有目共睹的,或许比不少英文专业的学生讲出的英语更正宗。然而,AI考生并未在此表现出更强的统治力。

瓶颈可能在于作文题。在有限的篇幅内,人类考生会有意识地使用更高级句式、时态来“炫技”以博取高分。而AI的目标通常是清晰、完整地传达信息,它不会刻意为了得分而优化句式复杂度,因此在评分细则上可能吃了暗亏。

理综:有进步,仍需努力

AI在理综三科上的表现更像是一次“破冰启航”。相较于去年,理综三科有一定进步,但整体成绩依旧挣扎在及格线附近,清晰地标示出AI与顶尖人类考生之间的能力鸿沟。

今年,读图能力的解锁,加上模型推理能力的增强,共同带动了理综能力的进步。不过正如绊住AI的数学题所展现的一样,能“看见”,不代表AI能“看懂”。

分科来看:

- 物理: 进步最快的“排头兵”,平均分提升了20.25分。

- 化学: 被复杂图形拖累的“重灾区”,整体得分偏低,仅有豆包勉强及格。

- 生物: 折戟于遗传计算的逻辑关,得分最高的ChatGPT也仅拿到9分。

总的来说,顶尖AI的理综成绩大致相当于中上游的人类考生水平,但远未达到“学霸”级别。正所谓“卷子越难,差距越显”,在综合性与深度并存的理综试卷上,AI尚未具备稳定碾压人类考生的实力。

文综:AI的舒适区

今年的AI高考评测中,一个清晰的趋势得以延续:文科综合依然是AI的高分舒适区。相比去年,文强理弱的偏科问题虽有缓解,但基本格局并未改变。

今年的分数增长,主要由地理科目贡献。得益于多模态能力的飞跃,AI在地理图题上的理解力显著增强,使得该科目平均分激增了20.3分,成为进步的火车头。

AI眼镜作弊?科幻情节

AI眼镜等“视觉AI硬件”无疑是科技界最炙手可热的焦点。我们尝试让ChatGPT与元宝“观看”试卷并作答,结果发现:

- 严重的幻觉问题: 模型非常容易自行想象。

- 被动的交互模式: 需要测试人员不断提示、引导,距离“全自动解题”相去甚远。

- 混乱的结果: 翻页速度、镜头晃动等都会导致模型给出截然不同的答案。

今天的视频大模型,像极了去年的图像大模型,仍处于非常早期的阶段。想在目前阶段,单纯依靠它在考场作弊,基本属于科幻情节。

AI有审美偏好吗?

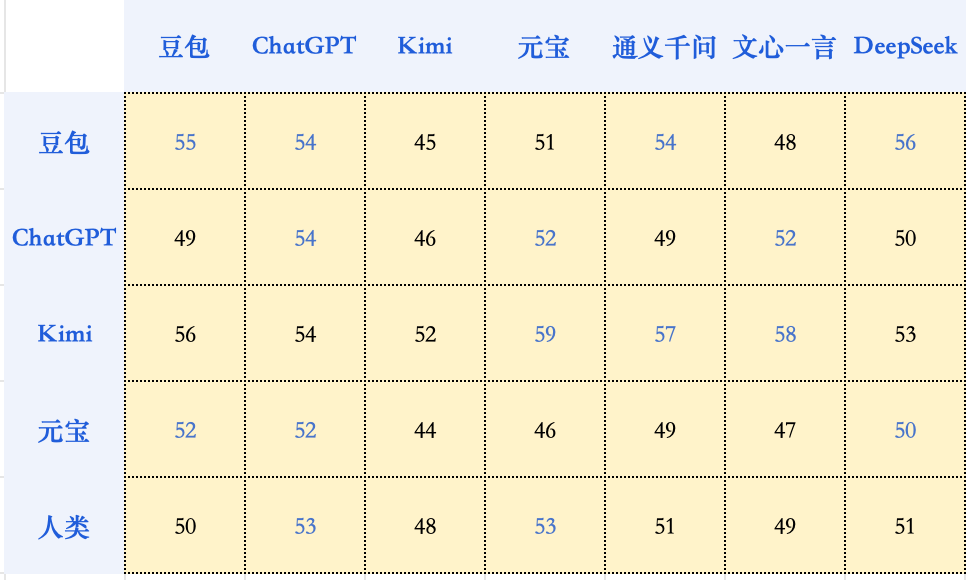

我们让参与本次评测的大模型们,对彼此生成的作文进行交叉打分和排序。结果显示,模型并没有表现出对自家作品的特殊偏爱,AI与人类判分员的审美,大方向仍然是一致的。

总结

本次高考测试,不仅是一场对人类智慧与AI智慧的对比,也是我们观察AI智能发展的一个刻度表。AI正加速逼近甚至超越普通人的能力边界,但它的发展并非线性。

高考,这个完美融合了知识掌握、逻辑推理与应试策略的综合场景,让AI展现出了它最迷人而矛盾的一面:它时而展现出顶尖人类的才华,轻而易举地攻克难题;时而又暴露出孩童般的认知盲区,在基础问题上犯下令人啼笑皆非的错误。

感谢高考。它用一种我们最熟悉的方式,为AI的通用智能水平提供了一张刻度清晰、极具参考价值的“快照”。