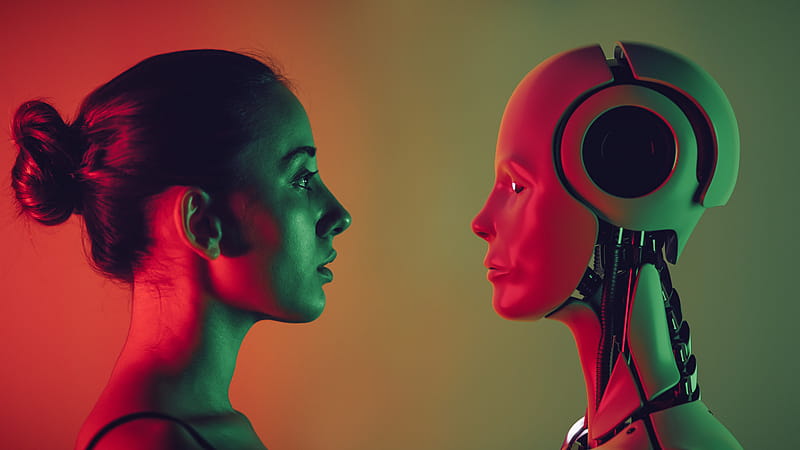

AI语音技术爆发的背后逻辑:从“Voice”到“Sound”的演进

在过去半年里,AI语音领域迎来了前所未有的爆发,多家初创公司获得了巨额融资,科技巨头也纷纷发布自己的语音模型和产品。苹果Siri的相对落后,与涌现出的一批又一批“AI Siri”形成了鲜明对比。这不禁让人思考,为何AI语音技术会在此时迎来集中爆发?

大模型驱动语音交互的进化

声智副总裁黄赟贺认为,语音对话已经从App中的一个功能模块,迅速进化为AI时代的入口。而这背后,大模型的加持是关键因素。

大模型使得声音这项基础能力首次实现了“可编程化”。这意味着,声音可以像文字、图像、视频一样,通过清晰的接口和逻辑,被代码自由地调用、组合、修改和控制。过去,声音更多的是一种“输入”或“输出”的介质,其内部的复杂结构和信息很难被软件直接“编程”和“理解”。

传统的语音识别,更多的是把声音转换成文字,然后对文字进行处理。而现在,大模型可以直接对声学信号进行更细致的解析,使得声音本身携带的文字信息之外的更多信息,开始被AI系统直接捕捉、理解和“编程”。这种可编程化,意味着AI可以像处理数据一样处理声音,它可以分析声音的频率、振幅、波形,提取出情绪特征、识别不同的声源、声源距离,甚至预测你的意图。

从“Voice”到“Sound”:语音交互的真正内涵

很多人认为,语音交互就是“Voice”(语音),但真正的语音交互,核心不是“Voice”,而是“Sound”(声音)。“Sound”包含了更丰富的元素,如语调、音色、节奏、情绪,以及环境音。环境音中可能包含了各种非语音信息,如背景音乐、环境噪音、物体发出的声音,以及人类语音中包含的非语义信息。

例如,当你咳嗽的时候,AI可能会识别出咳嗽,然后提醒你多喝水;当你在咖啡馆说“帮我找个安静的地方”,AI不仅要理解你的指令,还要从背景音中判断出你当前的环境嘈杂,从而推荐附近的图书馆。

真正的语音交互,不仅仅是“听懂”字面意思,更是“听懂”你的“言外之意”和“心声”。

语音交互的“卡点”:声学技术的挑战

尽管大模型带来了语音交互的巨大飞跃,但语音交互当下依然存在一个核心的“卡点”,那就是声学技术。我们常说“听清、听懂、会说”,而“听清”这个最基础的环节,却受到物理层面的制约。

例如,具身智能机器人动起来的时候,噪声很大,尤其在室外,更难听清楚人的指令。这方面,就需要对声学层面的突破,如环境噪声的抑制、电路底噪的抑制、啸叫的抑制、混响回响的抑制等等。而这些就是物理学科的逻辑,它需要数据样本,需要know-how的壁垒,不仅是技术问题,而是时间的问题,需要时间去采集声音、做训练。

语音交互的未来:实现“共情”

现在很多AI应用的日活、留存不高,一个很大的原因就是普通人本身是不会提问的,让人向大模型提问,这本身就是一个非常高的交互门槛。好的提问还需要学识、表达等基础,所以停留在文字层面的问答,本身就是一种门槛限制。

而语音带来的一种可能性是,它正在开启一个全新的阶段——人机交互的“共情模式”。如果把语音交互比作一个“UI界面”,那这个界面会长什么样?它的构成要素可能会有:情绪识别、意图理解、声纹识别、情绪生成。

这些要素的背后,是AI从“功能导向”到“情感导向”的转变,AI会与人实现共情。这种交互,能显著提升长时间交互的质量和亲密感。

当AI能接收到的不仅仅是用户的指令,而是整个物理世界的实时反馈时,我们可以构建一个“声学世界模型”。这个模型可以理解声音在物理世界中产生、传播和交互的根本规律,它不仅要“听清”和“听懂”,更要具备“声学常识”和“声学推理”的能力。未来,当这样一个声学世界模型与视觉、语言大模型深度融合时,具身智能机器人将不再“失聪”和冰冷。

AI语音市场爆发逻辑深度剖析

AI语音技术在近期的爆发式增长,绝非偶然。本文深入探讨了这一现象背后的驱动因素,从技术、应用和未来趋势三个维度,揭示了AI语音市场爆发的深层逻辑,并分析了其对未来人机交互的潜在影响。

技术突破:大模型赋能语音交互

过去,语音识别技术主要依赖于将语音转换为文本,再对文本进行处理。这种方式存在诸多局限,例如对语音中的情感、语境等信息的理解不足。而大模型的出现,为语音交互带来了革命性的突破。

大模型能够直接对声学信号进行分析,提取出语音中的各种特征,包括情感、意图、身份等。这意味着AI不仅能“听懂”你说什么,还能理解你“如何”说,甚至预测你的意图。例如,AI可以通过分析你的语调和语速,判断你是否感到紧张或兴奋,并根据你的情绪状态提供相应的服务。

这种“可编程化”的声音,为AI语音应用带来了无限可能。开发者可以利用大模型提供的接口,轻松地构建各种语音交互应用,例如智能助手、语音搜索、语音控制等。

应用创新:从“Voice”到“Sound”的拓展

传统的语音交互主要关注“Voice”,即语音本身。但随着技术的发展,AI语音交互正在向“Sound”拓展,即声音的更广阔的领域。这意味着AI不仅要理解你说的话,还要理解你所处的环境、你的情感状态,以及你的意图。

例如,当你在嘈杂的咖啡馆中说“帮我找个安静的地方”时,AI不仅要理解你的指令,还要识别出你所处的环境,并推荐附近的图书馆。这种基于“Sound”的语音交互,能够提供更加个性化、智能化的服务。

挑战与机遇:声学技术的突破

尽管大模型为语音交互带来了巨大的进步,但语音交互仍然面临着一个核心挑战,即声学技术的突破。我们常说“听清、听懂、会说”,而“听清”这个最基础的环节,仍然受到物理层面的限制。

例如,在嘈杂的环境中,AI很难准确地识别用户的语音指令。为了解决这个问题,需要对声学技术进行深入研究,例如环境噪声抑制、回声消除等。只有解决了“听清”的问题,AI才能真正理解用户的意图,并提供相应的服务。

尽管声学技术面临着诸多挑战,但也蕴藏着巨大的机遇。随着技术的不断发展,我们有理由相信,未来的AI语音交互将更加智能化、个性化,并为我们的生活带来更多便利。

未来趋势:情感化的语音交互

未来的AI语音交互将更加注重情感化。这意味着AI不仅要理解你的语言,还要理解你的情感,并根据你的情感状态提供相应的服务。

例如,当AI检测到你感到悲伤时,它可以播放一些舒缓的音乐,或者给你讲一些笑话。这种情感化的语音交互,能够让AI更加贴近人类,并为我们的生活带来更多温暖。

为了实现情感化的语音交互,AI需要具备以下能力:

- 情感识别:能够准确地识别用户的情感状态。

- 意图理解:能够理解用户的意图,并根据用户的意图提供相应的服务。

- 声纹识别:能够识别用户的身份,并根据用户的身份提供个性化的服务。

- 情感生成:能够以情感化的方式回应用户。

随着技术的不断发展,我们有理由相信,未来的AI语音交互将更加智能化、个性化、情感化,并为我们的生活带来更多便利。

AI语音技术的未来充满无限可能。随着技术的不断进步,AI语音将会在更多领域得到应用,并为我们的生活带来更多惊喜。

AI语音交互:从技术奇点到情感共鸣

近半年来,AI语音领域异军突起,融资消息不断,技术突破层出。从Wispr Flow的“默念输入”到ElevenLabs的语音合成,再到科技巨头们纷纷入局,AI语音正以前所未有的速度改变着人机交互的方式。这股浪潮并非凭空而来,而是多种因素共同作用的结果。本文将深入剖析AI语音爆发的底层逻辑,探讨其面临的挑战,并展望其未来发展趋势。

大模型:AI语音的“引擎”

大模型是AI语音爆发的核心驱动力。它赋予了声音“可编程化”的能力,使得AI能够像处理文字、图像一样处理声音。这意味着AI不仅能够识别语音中的文字信息,还能提取出情感、意图、环境等更丰富的信息。

过去,语音识别主要依赖于将语音转换为文本,再对文本进行处理。这种方式存在诸多局限,例如对语音中的情感、语境等信息的理解不足。而大模型可以直接对声学信号进行分析,提取出语音中的各种特征,包括情感、意图、身份等。

这种“可编程化”的声音,为AI语音应用带来了无限可能。开发者可以利用大模型提供的接口,轻松地构建各种语音交互应用,例如智能助手、语音搜索、语音控制等。

从“Voice”到“Sound”:交互方式的变革

AI语音交互正在经历一场从“Voice”到“Sound”的变革。传统的语音交互主要关注“Voice”,即语音本身。但随着技术的发展,AI语音交互正在向“Sound”拓展,即声音的更广阔的领域。这意味着AI不仅要理解你说的话,还要理解你所处的环境、你的情感状态,以及你的意图。

例如,当你在嘈杂的咖啡馆中说“帮我找个安静的地方”时,AI不仅要理解你的指令,还要识别出你所处的环境,并推荐附近的图书馆。这种基于“Sound”的语音交互,能够提供更加个性化、智能化的服务。

声学技术:AI语音的“基石”

尽管大模型为语音交互带来了巨大的进步,但语音交互仍然面临着一个核心挑战,即声学技术的突破。我们常说“听清、听懂、会说”,而“听清”这个最基础的环节,仍然受到物理层面的限制。

例如,在嘈杂的环境中,AI很难准确地识别用户的语音指令。为了解决这个问题,需要对声学技术进行深入研究,例如环境噪声抑制、回声消除等。只有解决了“听清”的问题,AI才能真正理解用户的意图,并提供相应的服务。

未来:情感共鸣的人机交互

未来的AI语音交互将更加注重情感化。这意味着AI不仅要理解你的语言,还要理解你的情感,并根据你的情感状态提供相应的服务。

例如,当AI检测到你感到悲伤时,它可以播放一些舒缓的音乐,或者给你讲一些笑话。这种情感化的语音交互,能够让AI更加贴近人类,并为我们的生活带来更多温暖。

为了实现情感化的语音交互,AI需要具备以下能力:

- 情感识别:能够准确地识别用户的情感状态。

- 意图理解:能够理解用户的意图,并根据用户的意图提供相应的服务。

- 声纹识别:能够识别用户的身份,并根据用户的身份提供个性化的服务。

- 情感生成:能够以情感化的方式回应用户。

结论:AI语音的未来之路

AI语音技术正在经历一场深刻的变革,从技术突破到应用创新,再到未来趋势,AI语音的未来充满无限可能。随着技术的不断进步,AI语音将会在更多领域得到应用,并为我们的生活带来更多惊喜。

然而,AI语音的发展也面临着诸多挑战,例如声学技术的突破、情感化的实现等。只有克服这些挑战,AI语音才能真正实现其潜力,并为人类创造更美好的未来。