人工通用智能(AGI):定义之争与未来迷局

在人工智能领域,人工通用智能(AGI)一直是一个备受关注但又极具争议的概念。AGI 被视为 AI 发展的终极目标,即创造出一种能够在各种任务中表现出与人类相当甚至超越人类智能的 AI 系统。然而,AGI 的定义至今未能达成共识,这不仅引发了学术界的争论,也对产业界的发展和监管带来了挑战。本文将深入探讨 AGI 定义的困境,分析其对 AI 发展的影响,并展望 AGI 的未来。

AGI 定义的混乱现状

AGI 的定义之争由来已久。正如 Google DeepMind 在一篇论文中所指出的,如果向 100 位 AI 专家询问 AGI 的定义,你可能会得到 100 个相关但不同的答案。这种定义上的不确定性使得衡量 AGI 的进展变得异常困难,也给那些声称即将实现 AGI 的公司带来了质疑。

事实上,AGI 的定义问题已经对现实产生了影响。例如,微软和 OpenAI 之间的合作关系就因为对 AGI 定义的理解不同而出现了裂痕。尽管两家公司在价值超过 130 亿美元的合同中使用了 AGI 这一术语,但它们对于 AGI 的具体含义却存在分歧。这表明,在没有明确定义的情况下,将 AGI 纳入商业协议可能会导致严重的法律纠纷。

AGI 定义的历史演变

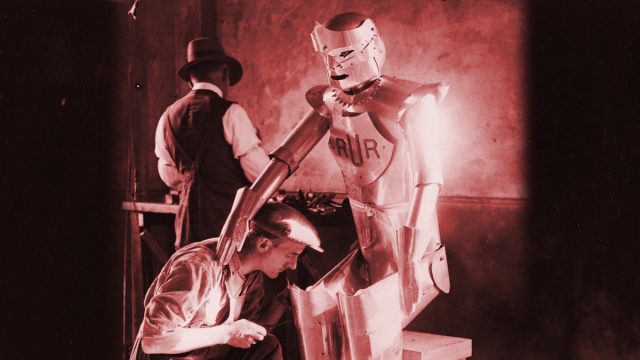

AGI 概念的起源可以追溯到 20 世纪 50 年代人工智能的早期。当时,研究人员设想创造出一种能够像人类一样在所有领域都表现出色的 AI 系统。然而,随着 AI 技术的发展,最初的 AGI 愿景逐渐缩小。由于机器人技术的发展滞后于计算能力的进步,AGI 的定义从“完成人类能做的所有工作”转变为“完成最具经济价值的任务”,再到如今更加模糊的标准。

长期以来,图灵测试一直被视为衡量机器智能的标准。如果一台计算机能够通过文本对话欺骗人类,使其相信它是人类,那么它就被认为达到了人类智能的水平。然而,现代语言模型已经能够在一定程度上通过图灵测试,但这并不意味着它们真的像人类一样思考,而是因为它们擅长生成听起来很像人类的输出。

AGI 定义的多种视角

目前,对于 AGI 的定义存在多种不同的视角。OpenAI 的章程将 AGI 定义为“在大多数具有经济价值的工作中表现优于人类的高度自主系统”。这种定义强调经济效益,而不是对认知能力的具体衡量。Meta 的 CEO 马克·扎克伯格承认,他对 AGI 并没有一个“简洁明了的定义”。OpenAI 的 CEO Sam Altman 则认为,他的公司现在知道如何构建“我们传统上理解的”AGI。与此同时,OpenAI 的前首席科学家 Ilya Sutskever 似乎将 AGI 视为一种神秘的事物,他甚至会带领员工吟唱“感受 AGI!”,将 AGI 视为一种精神追求而非技术里程碑。

Anthropic 的 CEO Dario Amodei 对 AGI 术语持更为怀疑的态度。他认为 AGI 是一个“不精确的术语,带有很多科幻色彩和炒作”。他更喜欢使用“强大的 AI”或“专家级科学和工程”等术语,认为这些术语更能准确地描述 AI 的能力,而不会引起过多的炒作。Amodei 将 AGI 描述为“比大多数相关领域的诺贝尔奖得主更聪明”的 AI 系统,它可以在数小时、数天或数周内自主完成任务,本质上是“数据中心里的一群天才”。

Google DeepMind 提出了一个更为系统的 AGI 评估框架,将 AGI 的性能分为五个级别:新兴、胜任、专家、大师和超人。DeepMind 的研究人员认为,当时还没有任何 AI 系统达到“新兴 AGI”以上的水平。根据他们的评估,目前最先进的 LLM 和模拟推理模型仍然只能被归类为“新兴 AGI”,相当于或略优于在各种任务中表现不佳的人类。

AGI 基准测试的局限性

为了更客观地衡量 AGI 的进展,研究人员一直在努力创建更好的基准测试。抽象和推理语料库(ARC-AGI)就是其中一个例子。ARC-AGI 旨在测试 AI 系统解决需要深度分析推理的新型视觉谜题的能力。然而,即使是像 ARC-AGI 这样复杂的基准测试也面临着一个根本问题:它们仍然试图将智能简化为一个分数。虽然改进基准测试对于衡量科学框架内的经验进展至关重要,但智能并不是一个可以像身高或体重一样衡量的单一事物,而是一个在不同背景下以不同方式表现出来的复杂能力。

AGI 的未来展望

尽管业界对 AGI 的发展前景看法不一,但 AI 研究人员普遍认为,通过扩展当前的方法不太可能实现 AGI。然而,专家预测也应谨慎对待,因为 AI 能力的快速发展常常出人意料。AI 研究人员的调查显示,在 2022 年至 2023 年 AI 技术取得重大进展后,他们大大缩短了 AI 里程碑的时间表。

随着技术的发展,AGI 的目标也在不断变化。最近,越来越多的研究表明模拟推理模型存在局限性,一些业内专家已经开始逐渐放弃对即将实现 AGI 的说法。例如,AI 播客主持人 Dwarkesh Patel 认为,AGI 的发展仍然面临着重大瓶颈,特别是在持续学习方面,并预测我们距离 AI 能够像人类一样无缝地在工作中学习还需要七年时间。

AGI 定义的重要性

AGI 定义的混乱不仅仅是哲学上的争论。公司利用对 AGI 即将到来的承诺来吸引投资、人才和客户。政府根据 AGI 的时间表制定政策。公众对 AI 对就业和社会的影响形成了可能不切实际的期望。缺乏明确的定义,将难以就 AI 的误用、监管或发展重点进行有意义的对话。乐观主义者和悲观主义者最终会使用相同的词语来表达根本不同的含义。

或许现在是时候超越 AGI 这一术语了。与其追求一个定义不清、不断后退的目标,不如专注于具体的能力:这个系统能否在不需要大量重新训练的情况下学习新任务?它能否解释其输出结果?它能否产生不会伤害或误导人们的安全输出?这些问题比任何关于 AGI 的猜测都能更好地告诉我们 AI 的进展。最有效的方法可能是将 AI 的进展视为一个没有特定成就阈值的多维频谱。但要绘制该频谱,就需要新的基准测试——以及对“智能”的坚定、经验性的定义,而这仍然难以捉摸。

模糊逻辑

模糊逻辑是一种处理不确定性和模糊性的数学方法,它允许计算机以类似于人类的方式进行推理和决策。在 AGI 的背景下,模糊逻辑可以帮助 AI 系统处理不完整或不精确的信息,从而提高其在现实世界中的适应性和鲁棒性。例如,模糊逻辑可以用于处理自然语言,理解人类的意图和情感,或者在不确定的环境中进行导航和规划。

结论

AGI 仍然是一个遥远的目标,但我们已经看到了令人难以置信的进步。我们已经看到了 AI 在各个领域的快速发展,包括计算机视觉、蛋白质折叠和翻译。我们需要对炒作持谨慎态度,不要过早地夸大 AI 的能力。清晰地了解 AGI 及其局限性对于引导其发展方向至关重要。通过避免炒作并专注于具体的能力,我们可以确保 AI 被用于改善人类生活并为社会带来利益。