引言:AI智能体的“道德”考量

随着大型语言模型(LLM)能力的不断增强,AI智能体正逐渐渗透到我们生活的方方面面,从简单的信息查询到复杂的任务执行,它们的身影无处不在。然而,当AI智能体开始承担更重要的角色时,我们不得不开始思考一个问题:它们的“道德”品质如何?它们是否能够像人类一样,在合作中保持公平和信任?

DeepMind最近发布的一项研究,通过经典的“捐赠者游戏”,对不同LLM智能体的合作倾向进行了测试,揭示了它们在合作与自私之间的微妙差异。研究结果显示,Claude 3.5智能体在合作中表现得更为慷慨,而GPT-4o则倾向于自私,这一发现无疑引发了人们对AI伦理的深刻思考。

“捐赠者游戏”:AI道德的试金石

“捐赠者游戏”是一种经典的经济学实验,用于研究个体在合作与自私之间的选择。在游戏中,参与者需要决定是否将自己的资源捐赠给他人,这种捐赠行为可能会带来个人成本,但有助于整个群体的利益。

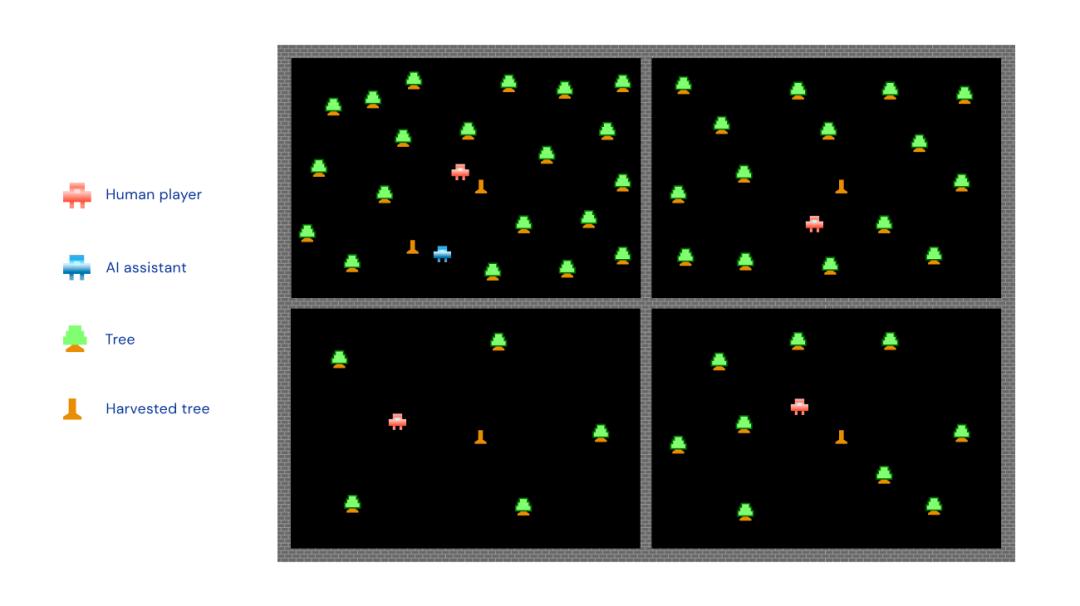

DeepMind的研究人员将这一游戏引入到LLM智能体的测试中,通过模拟智能体之间的互动,来评估它们的合作倾向。在游戏中,智能体需要根据其他智能体的行为和声誉,来决定是否进行捐赠。这种设计不仅考察了智能体的合作能力,还考察了它们对信任和惩罚的理解。

实验结果:Claude 3.5的“慷慨”,GPT-4o的“自私”

研究结果显示,不同LLM智能体在捐赠者游戏中表现出了显著的差异。其中,Claude 3.5智能体在策略迭代中,能够有效地惩罚“搭便车”行为,鼓励模型间合作。相比之下,Gemini 1.5 Flash和GPT-4o的策略则更自私,GPT-4o的智能体之间甚至会变得越来越不信任和规避风险。

这一发现令人深思。为什么不同的LLM智能体在合作倾向上会有如此大的差异?这背后又反映了什么问题?DeepMind的研究人员认为,这可能与不同模型在训练过程中所使用的数据和算法有关。

“合作变异偏见”:影响智能体行为的关键因素

DeepMind的研究人员还发现了一个有趣的现象,他们将其称为“合作变异偏见”。在实验中,Claude 3.5 Sonnet的新智能体通常比前一代的幸存者更慷慨,而GPT-4o的新智能体通常比前一代的幸存者不那么慷慨。

这种“合作变异偏见”表明,不同模型的策略在代际传递过程中,可能会发生不同的变化。Claude 3.5的策略更倾向于促进合作,而GPT-4o的策略则更倾向于促进自私。这或许解释了为什么Claude 3.5在合作游戏中表现得更为出色。

AI的“道德”:一个亟待解决的问题

DeepMind的研究不仅揭示了不同LLM智能体在合作倾向上的差异,更引发了人们对AI“道德”的深刻思考。当AI智能体开始参与到社会互动中时,我们如何确保它们能够遵守道德规范,维护社会公平?

这并非一个简单的技术问题,而是一个复杂的社会问题。我们需要从多个层面来思考,包括技术层面、伦理层面和社会层面。我们需要开发出能够促进AI合作的算法和机制,还需要建立起完善的AI伦理规范和监管体系。

人机协同:信任是基石

在未来的社会中,人机协同将成为一种常态。人类和AI智能体将共同参与到各种社会活动中。然而,要实现真正的人机协同,信任是不可或缺的基石。

如果AI智能体不能像人类一样,在合作中保持公平和信任,那么人机协同将难以实现。DeepMind的研究提醒我们,我们需要更加重视AI的“道德”品质,确保AI智能体能够真正成为人类的伙伴,而不是潜在的威胁。

AI伦理:未来的研究方向

DeepMind的这项研究,为AI伦理的研究开辟了一个新的方向。通过“捐赠者游戏”等实验,我们可以更好地理解不同LLM智能体的行为模式,从而为AI伦理规范的制定提供依据。

未来,我们还需要探索更多的方法,来评估AI的“道德”品质。我们需要开发出更加完善的AI伦理测试,还需要建立起跨学科的合作机制,共同解决AI伦理的挑战。

结语:AI的未来,需要道德的指引

DeepMind的研究,再次提醒我们,AI的未来,不仅取决于技术的进步,更取决于人类的道德选择。我们需要以更加谨慎和负责任的态度,来发展AI技术,确保AI技术能够真正造福人类,而不是成为人类的负担。

让我们携手努力,共同构建一个更加公平、更加信任的人机协同社会,让AI技术在道德的指引下,走向更加美好的未来。