OpenAI近期发布了备受瞩目的gpt-oss-120b和gpt-oss-20b两款开放权重AI模型,这标志着该公司自2019年GPT-2后首次在这一领域采取开放策略。这一举动,无疑为人工智能行业带来了深刻影响,预示着AI部署模式的重大变革。长期以来,顶级AI模型主要通过云端服务以API形式提供,使得数据处理和模型运行高度依赖远程服务器。然而,gpt-oss系列的推出,打破了这种单一模式,为企业和开发者提供了在本地硬件上运行大型AI模型的全新选项,从而在数据隐私、操作延迟和模型定制化方面开辟了更广阔的空间。

gpt-oss模型的核心魅力在于其“开放权重”的特性,这意味着用户可以合法下载模型的完整权重文件,并在自己的服务器或计算设备上进行部署、微调乃至二次开发。这一设计理念彻底突破了传统云计算服务的藩篱,赋予了使用者前所未有的自主权与灵活性。两个模型均基于当下最先进的Transformer架构,并创造性地引入了可配置的链式思考(Chain of Thought, CoT)机制。CoT允许用户根据具体任务需求,灵活调整模型的推理深度与复杂性,从快速响应的低CoT设置,到追求更精细、更准确输出的高CoT模式,仅需在系统提示中加入一行简单的指令即可实现切换。这种高度的灵活性与适应性,使得gpt-oss系列能够更好地融入各种复杂应用场景。

OpenAI为不同硬件配置优化了两个版本:gpt-oss-20b和gpt-oss-120b。较小的gpt-oss-20b拥有210亿总参数,但通过混合专家模型(Mixture-of-Experts, MoE)技术,每次推理的激活参数量显著降低至36亿,这意味着它可以在消费级设备(如配备16GB内存或更高配置的PC)上高效运行。而大型的gpt-oss-120b则拥有1170亿参数,其MoE优化后的激活参数量为51亿。尽管120b版本需要80GB内存,超出了普通消费级设备范畴,但它能完美适配专业的AI加速GPU,如Nvidia H100,使其在企业级部署中具备极高的实用价值。两款模型都提供了高达128,000个Token的超大上下文窗口,为处理复杂和长篇任务奠定了坚实基础。

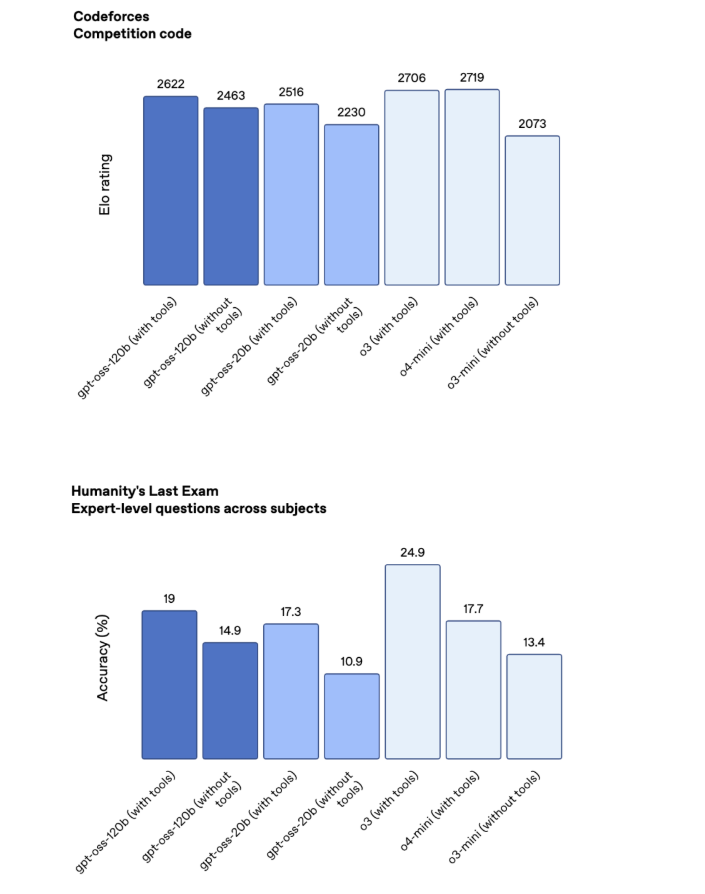

在性能表现上,OpenAI对gpt-oss系列寄予厚望,并声称其能力可与自家的云端旗舰模型相媲美。具体而言,gpt-oss-120b在多数基准测试中表现介于其专有模型O3和O4-mini之间,而gpt-oss-20b则紧随其后。特别是在数学和编程任务上,gpt-oss模型的表现尤为出色,展现了其在逻辑推理和代码生成方面的强大潜力。然而,在一些需要广泛知识储备的测试中,如“人类的最后一次考试”(Humanity's Last Exam),gpt-oss-120b的得分(19%)仍与O3(24.9%)及谷歌领先的Gemini Deep Think(34.8%)存在一定差距。这表明尽管性能卓越,但开放模型在某些通用知识领域仍有提升空间。

(图:OpenAI gpt-oss模型与竞品及自家专有模型的性能对比,展示了其在不同基准测试中的表现,尤其是在数学与编码领域的优势。)

OpenAI明确指出,发布gpt-oss系列并非意在完全取代其专有云端模型。相反,这些开放模型旨在弥补云端服务在某些特定场景下的不足。例如,本地部署的AI模型能够提供显著更低的延迟,这对于需要实时响应的应用至关重要。此外,用户对本地模型的深度定制化能力远超云端API,可以根据独特的业务需求进行精细调优。最关键的是,在本地运行模型可以确保敏感数据不出网,从而有效保障企业和用户的隐私与数据安全,这在合规性要求日益严格的当下显得尤为重要。

OpenAI深知,许多其专有模型用户同时也在利用开源模型来满足本地AI需求。为此,gpt-oss系列的设计初衷便是与OpenAI现有的GPT模型无缝集成。这意味着企业现在可以构建一个端到端的OpenAI生态系统,即使部分数据需要在本地处理,也能保持技术栈的统一性。这种策略有助于OpenAI巩固其在整个AI解决方案链条中的领导地位,同时满足市场对混合AI部署模式日益增长的需求。

作为完全开放且遵循Apache 2.0许可协议的模型,gpt-oss系列赋予了开发者极大的自由度。然而,这种自由也伴随着对滥用的担忧。自2019年GPT-2发布以来,AI模型的能力已今非昔比,其潜在影响更为深远。OpenAI在发布前进行了严格的安全测试,甚至尝试通过恶意调优来“教唆”模型产生有害内容。然而,测试结果令人欣慰:即便经过刻意引导,gpt-oss模型也未能达到公司《准备框架》(Preparedness Framework)中定义的高水平恶意质量。OpenAI将此归因于其在模型设计中融入的深思熟虑的对齐(deliberative alignment)和指令层级(instruction hierarchy)机制,这些内置的安全措施旨在有效预防开放模型的严重滥用。

目前,gpt-oss-120b和gpt-oss-20b模型已正式在HuggingFace平台上线,供全球开发者和研究者免费下载使用。同时,OpenAI也在GitHub上建立了专门的代码仓库,详细展示了模型的架构、使用范例以及潜在的扩展方向,极大地便利了社区的协作与创新。此外,为了方便用户进行初步测试和功能验证,OpenAI还提供了这些模型的标准版本托管服务。对于渴望深入探究模型技术细节的专业人士,OpenAI官方同步发布了详尽的模型卡(Model Card)和一系列研究博客文章,系统阐述了其设计哲学、训练过程以及安全保障措施。这些资源的全面开放,预示着AI社区将在开放权重模型的驱动下,迎来一个更加去中心化、更具可控性和创新活力的发展阶段。