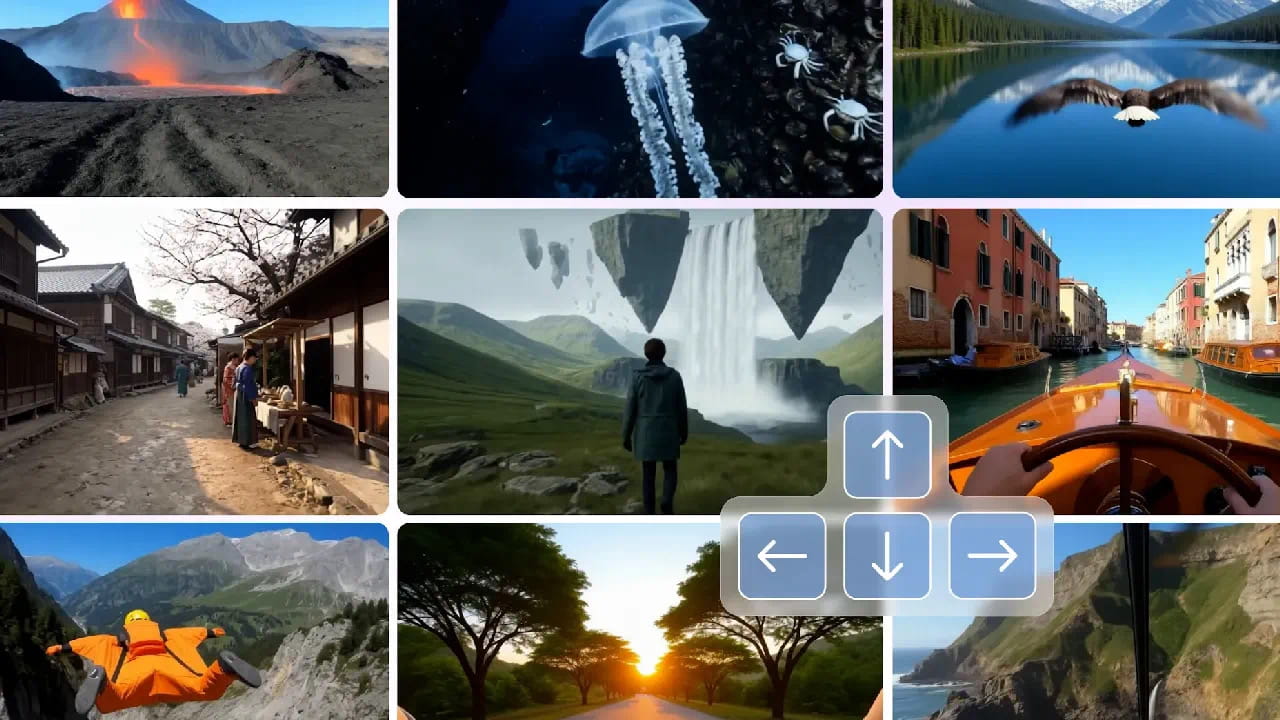

生成式人工智能(AI)在过去几年间展现了惊人的演进速度,从文本生成、图像创作到视频制作,不断拓展人类的数字想象力。然而,当前多数生成模型仍停留在静态内容的创造,或仅能输出有限交互的片段。谷歌DeepMind最新推出的Genie 3模型,则在这一领域迈出了革命性的一步,将其定义为“通用世界模型”,预示着AI从内容生成迈向可交互、可探索的虚拟世界构建新时代。

Genie 3的核心突破在于其对“世界一致性”的深刻理解与实现。传统的文本到视频模型,如OpenAI的Sora,虽然能生成高逼真的视频,但其本质是封闭的、不可交互的线性片段。一旦视角改变或时间推移,场景中的物体可能会凭空消失或位置错乱,缺乏对物理定律和环境逻辑的长期记忆。而Genie 3则彻底改变了这一局面。它能够依据用户输入的文本指令,在数秒内构建出一个连续、持久且物理逻辑一致的3D虚拟场景,用户可以在其中自由漫步、实时交互,并观察到环境中光影、物体状态的动态变化。

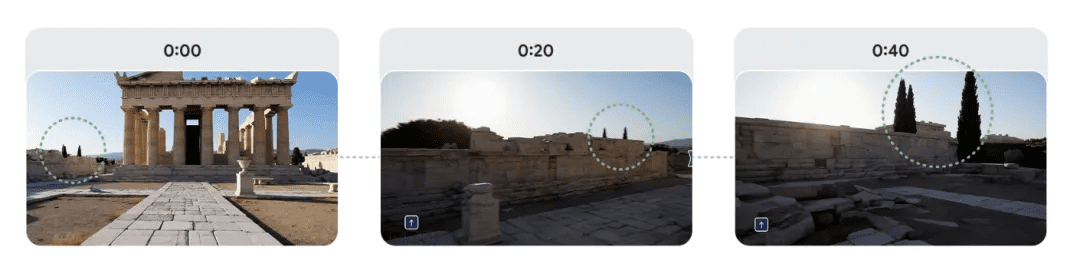

DeepMind此前的Genie 2模型虽已初具生成简单3D环境的能力,但其场景持续时间短(仅10-20秒)、细节粗糙且一致性欠佳。短短七个月,Genie 3实现了显著的飞跃。首先是视觉质量的提升,从360p跃升至720p分辨率,并支持24帧每秒的流畅画面输出。更重要的是,Genie 3能够维持连续数分钟的模拟,而不仅仅是短暂的动画片段。其场景中的树叶随风摆动、角色的阴影随着光源移动、物体碰撞后产生符合物理规律的反馈,这些细节都印证了模型对“世界一致性”的突破性掌握。

实现这一突破的关键在于Genie 3引入的创新“视觉记忆机制”。该机制使模型在生成每一帧画面时,都能参照并维护前一帧甚至整个环境的状态与布局。这意味着用户在虚拟世界中走过的路不会在回头时凭空消失,建筑、地貌等元素都能稳定地保持在原地,仿佛真的存在于一个连续的时空之中。简而言之,Genie 3学会了“记住”它所创造的世界,从而消除了传统生成模型中常见的突兀跳变和逻辑断裂。

这种能力让Genie 3超越了单纯的“视频生成器”,被DeepMind冠以“世界模型”之名。它不仅能生成一个连续的世界,还能在用户探索过程中动态调整场景,同时确保逻辑不崩坏。这一特性被称为“可提示世界事件”(Promptable World Events),意味着文本指令即是世界的实时响应。例如,当用户在一个湖面上输入“水面出现一辆摩托艇”,Genie 3不会重新生成整个画面,而是直接“空降”一艘摩托艇滑过水面,溅起逼真的水花。这种即时可塑性让用户不再仅仅是旁观者,更是虚拟世界的“导演”和“造物主”。

DeepMind透露,Genie 3在训练过程中大量使用了游戏引擎生成的数据集和视频预测任务,这使得模型具备了更强的“因果感”和“持久性”。换言之,Genie 3学会了理解世界是连续的,并且用户的动作会带来相应的后果。此外,Genie 3还支持视角的自由移动,并能动态重绘不同视角下的内容,这在生成模型中是极其困难的,因为它要求模型具备强大的3D推理能力。因此,Genie 3的目标不仅是生成视频,更是实现基于世界的交互式生成。

颠覆创意行业与更广阔的应用前景

Genie 3的问世,无疑将对多个创意产业产生深远影响。在电子游戏领域,3D场景构建一直是开发中最昂贵、最耗时的环节。对于独立开发者而言,这往往是其创意落地的一大障碍。Genie 3的出现,彻底打破了这一限制。以往需要数周甚至数月进行建模、贴图、调光的工作,如今只需几句话即可快速搭建一个动态可交互的场景。这意味着,即使是资源有限的团队,也能像拼乐高一样,用文本指令快速构建出开放世界地图或复杂关卡原型。大型工作室也可以利用其进行概念验证和快速迭代,大幅缩短开发周期。

在影视制作行业,Genie 3的应用同样充满想象空间。导演和美术可以在开拍前通过文本指令实时预览场景风格、调整光影、添加角色,甚至让演员在虚拟空间中进行走位排练,实现“沉浸式分镜头”和可视化预演。这不仅能提高制作效率,还能降低实景拍摄的成本和风险。教育领域也将受益匪浅。课本中描绘的历史古迹、地理现象、甚至复杂的科学实验过程,都可能通过Genie 3生成可交互、可探索的虚拟场景,为学生提供前所未有的沉浸式学习体验,将抽象概念具象化。

艺术与设计领域同样将迎来新的表达方式。数字艺术家可以利用Genie 3构建复杂的交互式装置或体验,将观众带入其想象的艺术空间中。而对于扎克伯格所倡导的“元宇宙”愿景,Genie 3更是提供了实现其核心——构建动态、可定制虚拟世界——的关键技术基础。当每个人都能拥有“构建虚拟空间”的能力时,一个真正由用户驱动的、充满活力的元宇宙才可能得以实现。

AI的“认知训练场”:通向通用智能的基石

DeepMind将Genie 3称为“世界模型”的更大野心,在于其作为AI智能体(Agent)的“认知训练场”。在追求通用人工智能(AGI)的道路上,智能体不仅需要理解世界,更需要在世界中做出决策并采取行动。Genie 3提供了一个可以无限生成、即时修改、逻辑连贯的虚拟环境,使得AI Agent能够在其中学习因果关系、空间感知和行动规划,而无需直接在复杂且高成本的真实世界中进行试错。

例如,训练一台仓储机器人,过去需要搭建昂贵的物理场景或依赖传统游戏引擎模拟。但这些方法都存在局限性。而在Genie 3构建的虚拟世界中,机器人可以无限制地练习避障、搬运、协作,甚至模拟现实中极难复现的极端情况,如自动驾驶汽车应对行人突然冲出马路的情景。这种训练模式大大降低了成本,提高了效率,并能覆盖更广泛的场景。DeepMind直言,Genie 3将促使AI Agent从自身经验中学习,这与人类在现实世界中学习的方式有着异曲同工之妙,是推动AI Agent能力极限的重要一步。

挑战与展望

尽管Genie 3展现出惊人的潜力,但作为一项新兴技术,它仍面临诸多限制。目前,场景分辨率仅为720p,帧率24fps,虽然对AI生成而言已属不易,但距离4K高帧率的游戏画面标准仍有差距。此外,Genie 3生成的场景持久性虽有提升,但官方演示多控制在1分钟以内,更长时间的持续性仍有待验证。场景中的文字渲染效果尚不理想,复杂物理交互(如大批量生物动态、雪崩模拟)也可能露出“AI异常”的破绽。

目前,Genie 3仅在研究和合作项目中使用,尚未面向公众开放API,也未提供在线体验入口。但这不妨碍我们对其未来潜力的展望。Genie 3并非孤立的技术创新,它反映了AI技术从2D到3D、从静态到交互式、从片段到连续空间智能的发展大趋势。从李飞飞创建的World Labs,到英伟达推出的Cosmos世界基础模型,再到DeepMind的Genie 3,都指向一条清晰的AI空间智能技术路径:实现场景物理一致、时空连贯、交互有变化和因果反馈的虚拟世界构建。

ChatGPT让我们意识到语言可以是操作系统,Sora让我们看到视频可以是创作界面,而Genie 3则更进一步,将文字变成“可操作”的空间。未来,无论是游戏、影视、教育、科研,构建虚拟世界将变成一种即时表达方式,真正实现“一话一世界”的宏大愿景,彻底改变人类与数字内容的交互方式。