前言:前沿AI崛起下的透明度新范式

当前,人工智能技术正以惊人的速度迭代演进,特别是“前沿AI模型”的横空出世,在展现出前所未有的智能涌现能力的同时,也悄然带来了深远的安全与伦理挑战。这些大模型在医疗、金融、国防等关键领域的广泛应用前景,既令人振奋,又引发了关于潜在风险的深刻反思。如何在最大化AI效益与确保公共安全、维护社会稳定之间找到平衡点,已成为全球社会面临的紧迫议题。我的观点是,实现这一平衡的关键在于构建一套健全、灵活且具前瞻性的透明度框架。这不仅仅是技术治理的需要,更是赢得社会信任、推动AI健康可持续发展的基石。

应对挑战:为何传统监管模式难以适用前沿AI?

AI技术的快速发展,使得传统的、自上而下的、僵化的监管模式显得捉襟见肘。一方面,AI模型评估方法和安全标准本身也在持续演进,可能数月内便告过时;另一方面,过于严苛的规定可能扼杀创新,阻碍AI在药物发现、公共服务优化、国家安全等领域的潜在突破。因此,我们不能简单地将旧有的监管思维套用到新生的AI领域。我们需要的是一种既能确保AI安全负责地开发,又能保持行业创新活力的动态平衡机制。这意味着,任何有效的透明度框架都必须具备高度的适应性和灵活性,能够与技术进步同频共振,而非成为其发展的桎梏。

前沿AI透明度的核心支柱

我认为,一个有效的AI透明度框架应立足于以下六大核心原则,共同构筑起AI治理的坚固防线:

1. 明确适用范围:聚焦高风险模型与大型开发者

透明度要求不应“一刀切”,而应精准施策。我的看法是,应将透明度义务主要限定于那些开发最强大、最具潜在影响的前沿AI模型的机构。这些模型往往需要巨大的计算资源投入、承担高昂的研发成本,并在评估性能上达到前所未有的水平。通过设定明确的计算能力、研发投入、年度营收等阈值(例如,年营收数亿美元或年研发投入数十亿美元),可以有效区分出那些真正可能带来系统性风险的“巨头”。这样做的好处在于,既能集中有限的监管资源,又能避免对蓬勃发展的初创企业和小型开发者施加过重负担,确保AI生态系统的多元化发展。

2. 建立安全开发框架(SDF):风险管理的前瞻性指南

核心AI开发者必须建立并遵循一套严谨的“安全开发框架”(Secure Development Framework, SDF)。这套框架是指导其评估和缓解模型潜在“不合理风险”的路线图。这些风险远不止技术故障,更包括模型被用于制造化学、生物、放射性及核能危害(CBRN)的可能性,以及模型自主性失控所带来的风险。SDF应详细阐述从概念设计到部署、再到持续监测的全生命周期安全措施。鉴于SDF本身也是一个不断完善的工具,框架设计上应强调其灵活性和可迭代性,鼓励开发者在实践中持续优化其安全策略和流程。

3. 公开安全开发框架:透明化与外部监督

将SDF向公众披露是提升透明度的关键一步。我的观点是,除极少数涉及核心商业秘密或可能被恶意利用的敏感信息外,SDF的大部分内容应在其官方网站上公开。此举的意义在于多方面:它允许独立的AI安全研究者、政府机构乃至普通公众,能够及时了解当前部署AI模型的安全实践,形成有效的外部监督力量。同时,开发者应自我声明其已遵守所公布的SDF条款,这不仅是一种承诺,更是对其负责任态度的宣示。这种公开机制将促使AI实验室更加审慎地对待安全问题,因为他们的安全实践将置于聚光灯下。

4. 发布系统卡片:模型的“体检报告”

如同任何复杂产品都需要一份详细的技术说明书,“系统卡片”或类似文档应作为AI模型的“体检报告”向公众披露。这份卡片应精炼总结模型的测试与评估过程、关键测试结果以及已采取的风险缓解措施。同样,涉及可能危及公共安全或模型自身安全的信息可进行适当删减。系统卡片的公开应与模型部署同步进行,且在模型发生重大修改时及时更新。这为用户、研究者和政策制定者提供了理解模型能力、限制和安全状态的标准化视图,是实现信息对称、理性决策的重要工具。

5. 强化吹哨人保护:内部监督的最后一道防线

为了确保SDF和系统卡片的真实性和有效性,必须明确规定:AI实验室就其遵守SDF情况作出虚假陈述,将构成违法行为。我的看法是,这一明确的法律界定,将有效激活现有的吹哨人保护机制。这意味着,任何发现实验室存在故意不当行为的内部人员,都可以更安全地揭露真相,从而确保执法资源能够精准打击那些蓄意违规、将公众安全置于风险之中的行为。内部的监督机制,配合外部的披露要求,构成了坚不可摧的透明度保障体系。

6. 设立适应性标准:拥抱AI安全实践的演进

AI安全与治理实践仍处于早期探索阶段。因此,一个可行的透明度框架必须具备最小化的、可适应的标准。这些标准不应是静态的,而应设计为轻量级且灵活的要求,能够随着行业共识、最佳实践以及新研究成果的出现而动态调整。这需要产业界、政府和学术界等多方利益相关者的持续对话与协作,共同推动AI安全实践的成熟。这种迭代和进化的设计理念,确保了透明度框架能够始终与技术前沿保持同步,避免被快速发展的AI甩在身后。

实践与展望:以透明度驱动AI负责任创新

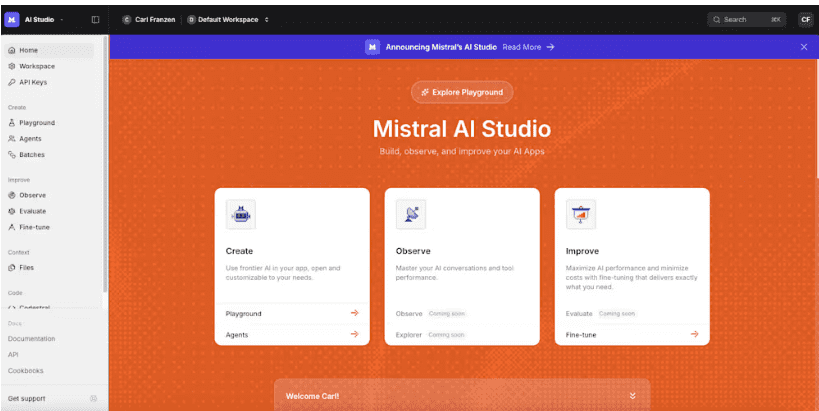

我坚信,上述透明度方法为AI行业的安全实践提供了宝贵的启发,并能为负责任的AI实验室设定一个基础准则。例如,业界领先的一些实验室(如部分知名的AI研究机构)已经主动采纳了类似的安全开发策略和准备框架。将这些自愿的、行业内部的最佳实践提升为具有法律效力的透明度要求,不仅能实现行业标准的统一化,更重要的是,能够确保这些披露不会随着模型能力的增强或市场环境的变化而被随意撤销。这为AI的长期安全发展提供了更强有力的制度保障。

对于AI模型是否以及何时可能带来灾难性风险,各方观点不一。而安全开发框架和系统卡片的透明度要求,恰恰能为政策制定者提供所需的实证数据,以判断是否需要进一步的监管干预,同时也能为公众提供关于这项强大新技术的关键信息。面对前沿AI带来的空前机遇,我们有机会加速科学发现、提升医疗水平并促进经济增长。然而,若缺乏安全、负责任的开发,一次重大的灾难性失败可能会让进步停滞数十年。因此,我提出的这份透明度框架,不仅是一项务实的首要举措,更是通过保障公共安全和私营部门的敏捷性,以实现AI变革性潜力的关键一步。透明度并非创新的绊脚石,而是其腾飞的助推器,是构建信任、引领AI走向光明的必由之路。