本地AI算力新突破:AMD与高通如何推动大型语言模型边缘部署

人工智能技术正以前所未有的速度渗透到我们生活的方方面面,从云端大型数据中心的复杂运算到智能手机、个人电脑等边缘设备的日常应用。长期以来,运行大型语言模型(LLMs)等复杂的AI应用主要依赖于强大的云端算力。然而,随着对实时性、隐私保护及网络带宽效率要求的不断提升,将AI模型部署到边缘设备,即“边缘AI”,已成为业界关注的焦点和重要趋势。这一转变不仅能够显著降低延迟,提升用户体验,还能在数据隐私和离线可用性方面带来革命性的进步。

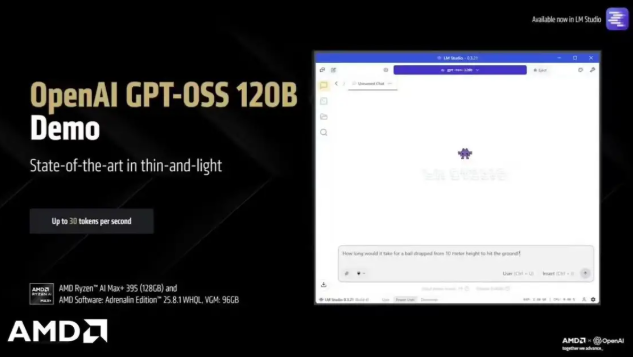

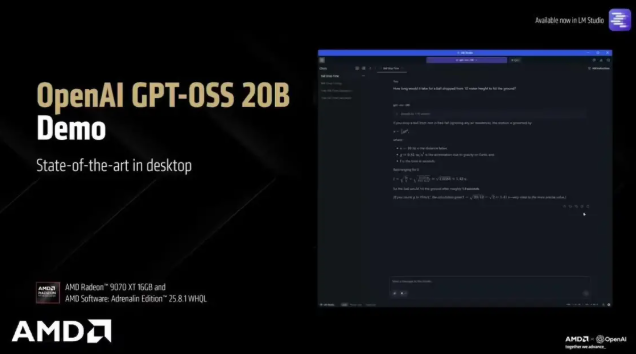

近期,半导体行业的两大巨头——AMD与高通,联合宣布其最新硬件平台将正式支持OpenAI研发的gpt-oss系列开放推理模型,这无疑是边缘计算领域的一大里程碑事件。此举标志着高性能AI模型不再是云端专属,而是正逐步迈向个人电脑和移动设备,为本地智能应用开启了全新的可能性。gpt-oss系列模型包含参数规模相对较小的gpt-oss-20b(200亿参数)和更为复杂的gpt-oss-120b(1200亿参数),旨在适配不同硬件配置下的AI推理需求。

AMD的先锋实践:锐龙AI Max+395赋能消费级AI PC

AMD在此次边缘AI浪潮中展现了其领先的技术实力。其最新的锐龙AI Max+395处理器,凭借其卓越的集成AI算力,被AMD自豪地宣布为全球首款能够直接在消费级AI PC上流畅运行gpt-oss-120b大型模型的处理器。这在技术上是一项重大突破,因为gpt-oss-120b拥有高达1200亿参数,对计算资源和内存带宽有着极高的要求。

为了实现这一目标,AMD采用了多项创新技术。首先是GGML(Georgi Gergiev Machine Learning)框架的应用。GGML是一个轻量级、高效的机器学习推理库,专为在CPU或低功耗设备上运行大型模型而设计,通过优化的量化技术,显著降低了模型的内存占用和计算需求。其次,AMD利用了MXFP4格式进行模型推理。MXFP4是一种极低精度浮点格式,能够在保持较高推理精度的同时,进一步将模型的存储和计算量压缩到极致,使得原本需要巨大显存的模型也能在有限的设备内存中运行。

在实际运行中,gpt-oss-120b模型在使用约61GB显存的情况下,得以在锐龙AI Max+395处理器上顺畅运行。这意味着即便没有专业级AI加速卡,普通消费者也能体验到接近云端大型模型的本地推理能力。更令人瞩目的是,AMD的“Strix Halo”平台,凭借其128GB的统一内存架构,能够为GPU分配高达96GB的内存,这为未来更大型或更复杂的AI模型在本地设备上的运行奠定了坚实基础。

性能方面,锐龙AI Max+395在运行gpt-oss-120b时,可以实现每秒30个Token的输出速度。这个速度对于实时交互式应用而言至关重要,它确保了用户在进行文本生成、代码辅助、语言翻译等任务时能够获得流畅、低延迟的体验。同时,该处理器还支持MCP(Model Context Protocol)模型上下文协议,这意味着在处理复杂、长上下文的任务时,系统能够更高效地管理和利用模型上下文信息,进一步提升推理的准确性和连贯性。

高通的移动创新:骁龙平台赋能边缘AI的普及

与AMD在PC端的深耕不同,高通作为移动芯片领域的领导者,则专注于将gpt-oss模型引入更广泛的移动和物联网设备。高通宣布,经过早期的严谨测试,gpt-oss-20b模型在其骁龙平台上展现出了出色的思维链(Chain-of-Thought)推理能力。思维链推理是大型语言模型一种高级推理范式,它允许模型通过模拟人类解决问题的思考过程,逐步分解复杂问题,从而提高多步骤推理任务的准确性和可靠性。

骁龙平台能够高效运行gpt-oss-20b模型,对于移动设备用户和开发者而言具有极其重要的意义。这意味着未来的智能手机、平板电脑乃至智能家居设备,将能够原生支持更复杂的AI应用,如高级语音助手、本地化内容创作、智能推荐系统等,而无需频繁依赖云端连接。

为了促进开发者生态的繁荣,高通还特别强调,开发者可以通过Hugging Face和Ollama等知名AI模型分发和运行平台,轻松访问和部署gpt-oss-20b模型到搭载骁龙芯片的设备上。这种开放性和便捷性将大大降低开发者进入边缘AI领域的门槛,加速创新应用的孵化和普及,形成一个充满活力的本地AI应用生态系统。

边缘AI的战略意义与技术前景

AMD和高通此次对gpt-oss系列模型的支持,不仅仅是硬件性能的简单提升,更是AI发展战略上的一次深远布局。它深刻地改变了AI模型的部署模式,从传统的“云优先”向“云边协同”乃至“边缘优先”演进。

1. 提升用户体验与服务效率

将大型AI模型部署到边缘设备,最直接的好处便是大幅降低推理延迟。数据无需上传至云端处理,响应时间几乎是即时的,这对于实时交互式应用(如语音识别、视频分析、游戏AI)至关重要。例如,本地运行的AI助手可以更快地理解并执行指令,而无需等待网络传输和云端计算的结果。这种即时反馈机制将极大地提升用户体验,使得智能设备真正变得“聪明”且“灵敏”。

2. 强化数据隐私与安全

在数据隐私日益受到关注的今天,本地AI推理提供了一个天然的解决方案。用户的数据(如语音输入、图片、个人偏好)可以在设备本地进行处理,而无需传输到云端。这显著降低了数据泄露的风险,也使得AI应用能够更好地符合GDPR等日益严格的全球数据隐私法规。对于医疗、金融等对数据敏感的行业,本地AI部署的优势尤为突出。

3. 优化网络带宽与运营成本

大规模的AI模型在云端运行时,会产生巨大的数据传输量,对网络带宽造成压力。将部分或全部推理任务转移到边缘,可以有效减轻云服务器的负载和网络拥堵,从而降低云服务提供商的运营成本,并为用户节约数据流量费用。特别是在网络连接不稳定或无网络的场景下,本地AI也能确保应用的正常运行,提高了系统的鲁棒性。

4. 推动AI应用范式革新

硬件对本地AI模型的支持,将催生一系列全新的应用场景。我们有望看到更智能的个人助理能够学习并适应用户的独特习惯,生成高度个性化的内容;智能家居设备能够更自主地运行复杂任务,无需云端指令;增强现实(AR)和虚拟现实(VR)设备将能实现更复杂的场景理解和实时渲染,带来更沉浸式的体验。此外,对于工业物联网(IIoT)和智能制造领域,边缘AI能实现设备故障的预测性维护、生产线优化和质量控制,提高整体运营效率。

挑战与未来展望

尽管边缘AI前景广阔,但其发展仍面临一些挑战。能耗管理是一个关键问题,尤其对于电池供电的移动设备而言,如何在提供强大AI算力的同时,控制功耗、延长续航是核心考量。散热同样重要,高性能芯片在持续运行LLMs时会产生大量热量,需要高效的散热解决方案。

此外,模型优化和框架标准化也是持续努力的方向。尽管GGML和MXFP4等技术取得了显著进展,但如何进一步压缩模型大小、提高推理效率,同时又不牺牲模型性能,仍是研究的重点。同时,建立统一的开发框架和工具链,让开发者能够更便捷地在不同硬件平台上部署和优化AI模型,对于加速边缘AI生态的成熟至关重要。

展望未来,随着AMD、高通等硬件厂商的持续投入,以及OpenAI等模型开发者的开放合作,我们有理由相信,大型语言模型在边缘设备上的普及将成为现实。这将不仅仅是一次技术升级,更是一场深刻的智能革命,它将重新定义人机交互的方式,催生无数创新的应用,最终构建一个更智能、更高效、更普惠的数字世界。通过不断的硬件创新、算法优化和生态建设,边缘AI的潜力将得到充分释放,为我们的生活和工作带来深远的影响。