人工智能对话平台的隐私挑战:ChatGPT用户数据意外曝光事件深度分析

近期,全球范围内对人工智能(AI)技术伦理和数据隐私的关注日益升温。一项关于领先AI对话模型ChatGPT的最新披露,再次将这一议题推向风口浪尖。数千条原本被视为私密的ChatGPT用户对话记录,竟然意外地出现在主流搜索引擎的公开结果中,引发了用户群体的广泛震惊与对AI平台数据安全实践的深刻质疑。

事件回顾:私密对话如何“现身”公共视野

此次隐私泄露事件的核心,源于ChatGPT平台内一个名为“分享聊天”(Share Chat)的功能。表面上看,这是一个旨在方便用户共享特定对话内容的实用工具,然而,其设计细节中潜藏的缺陷,却让无数用户在不知情的情况下,将其高度个人化乃至极其敏感的对话内容,暴露给了全球互联网。

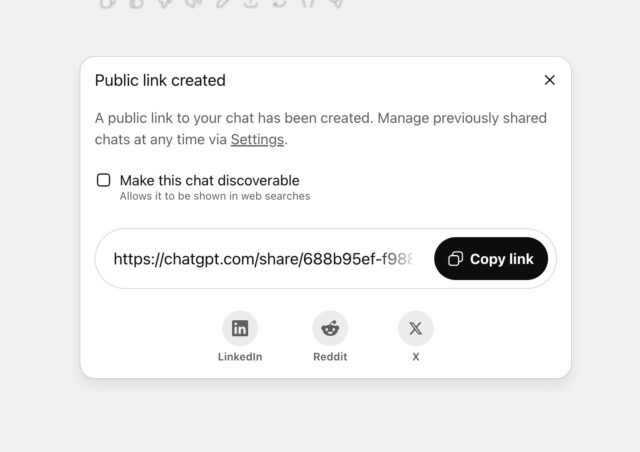

根据最初的调查报告,该功能在用户点击“分享”后,会弹出一个选项框,其中包含一个勾选“使此聊天可被发现”(Make this chat discoverable)的选项。在该选项下方,以更小、更浅的字体标注着一行附注:“此聊天随后可能出现在搜索引擎结果中。”正是这种隐晦的提示方式,被普遍认为是导致用户误操作的关键症结。许多用户可能习惯性地勾选以便生成分享链接,却未能充分理解其深远的隐私含义,以为仅是生成一个供特定对象访问的私密链接,而非将内容开放给公共搜索引擎索引。

这些被意外公开的对话内容范围之广,令人不安。其中不乏用户对个人人际关系、心理健康状况、甚至药物使用和创伤经历等极其敏感话题的深入探讨。尽管曝光的聊天记录未直接包含用户的身份信息,但鉴于内容的具体性和细节性,外界不排除通过交叉比对等方式,间接识别出特定用户的可能性,这无疑加剧了受影响用户的担忧。

OpenAI的应对策略与行业反思

面对舆论的巨大压力,ChatGPT的开发商OpenAI迅速采取了行动。其首席信息安全官证实,公司已决定移除这一引发争议的“使此聊天可被发现”功能。最初,OpenAI曾辩称该功能标签已经“足够清晰”,但在深入评估后,他们承认这一设计确实“为人们意外分享其不愿公开的内容提供了太多机会”。此次调整体现了OpenAI对用户反馈的重视,以及对产品隐私缺陷的修正意愿。

值得注意的是,此次事件被OpenAI定性为一次“短暂的实验”,旨在探索“帮助人们发现有用的对话”的新途径。然而,即便是一个“短暂”的尝试,其对用户隐私造成的潜在损害也不容忽视。公司已承诺将积极与相关搜索引擎合作,移除受影响的索引内容,尽管这一过程可能需要时间,且在不同搜索引擎间的同步速度会有差异。

在此次事件中,谷歌方面澄清,搜索引擎本身并不控制网页的公开性,内容的索引与否完全取决于发布方。这意味着,ChatGPT内容的索引责任完全在于OpenAI。这再次强调了内容发布者在数据治理和隐私保护方面不可推卸的主体责任。

AI伦理与用户信任的构建:深层剖析与未来展望

此次ChatGPT隐私泄露事件,不仅是一次技术失误,更是对当前AI发展模式和伦理框架的严峻考验。牛津大学AI伦理学家卡丽莎·韦利兹(Carissa Veliz)对此事件的评论直指核心:“科技公司将普通民众当作‘小白鼠’,推出新的AI产品,然后坐等看它们会因为侵入性设计选择而面临怎样的后果。”这种“先发布再修补”的策略,尽管在快速迭代的科技领域屡见不鲜,但在涉及个人数据和隐私的核心领域,无疑会极大损害用户信任,并可能引发严重的法律和道德后果。

数据保留与用户权利的博弈

此次事件的背景更为复杂,它发生在OpenAI正面临一场关于用户数据保留的法律诉讼之际。此前,OpenAI曾表示反对一项法院命令,该命令要求其“无限期”保存所有已删除的ChatGPT聊天记录。OpenAI首席执行官萨姆·奥特曼(Sam Altman)曾公开表示,用户最私密的聊天记录可能被搜索是“一团糟”的情况。然而,批评者指出,尽管奥特曼对外部力量可能导致数据曝光表达了担忧,但他对OpenAI自身产品设计可能导致隐私泄露的风险,似乎并未表现出同样的透明度或批判性。这场围绕数据保留的法律战役,与此次意外泄露事件相互映照,共同揭示了AI公司在面对用户数据权时所面临的巨大挑战和内在矛盾。

强化隐私保护与透明度建设的路径

要重建并维护用户对AI平台的信任,行业需要从以下几个方面进行深层次的变革:

- 设计原则中的隐私考量: 产品设计之初就应将隐私保护作为核心原则,而非事后补救。用户界面和功能提示应极其清晰、直观,确保用户在进行任何涉及数据共享的操作前,能够充分理解其影响。复杂的法律术语和晦涩难懂的隐私声明应被简洁明了的语言所替代。

- 用户知情权与控制权: 赋予用户对其数据更强的控制权。例如,提供易于访问和管理的隐私设置,允许用户随时查看、修改或删除其数据,并明确告知数据的使用目的、存储期限以及可能的共享范围。

- 第三方审计与合规性: 定期进行独立的第三方安全和隐私审计,确保AI系统符合最新的数据保护法规(如GDPR、CCPA等)。同时,建立健全的内部数据治理流程,严格限制对用户数据的访问和处理。

- 伦理委员会的建立: 设立独立的AI伦理委员会,由多学科专家组成,对新功能、新产品的隐私风险进行前瞻性评估,并在出现问题时提供独立的审查和建议。

- 危机响应与透明沟通: 在数据泄露或隐私事件发生时,企业应以最快的速度、最大的透明度向用户通报情况,解释原因,并提供明确的补救措施和风险缓解方案。

此次ChatGPT私密对话泄露事件,是人工智能发展道路上的一个重要警示。它提醒所有AI开发者和用户,在享受AI带来便利的同时,必须高度重视其背后的隐私风险。唯有通过持续的技术创新、严谨的伦理考量和用户为中心的设计理念,才能真正实现AI的可持续发展,构建一个既智能又安全、值得信赖的数字未来。