OpenAI开源战略新里程碑:GPT-OSS系列引领AI本地化部署浪潮

近年来,人工智能技术以前所未有的速度渗透到各个行业,而模型的部署方式一直是业界关注的焦点。传统的云端大模型虽然强大,但在数据隐私、计算延迟及定制化需求方面存在固有局限。在这一背景下,OpenAI于近期发布了两款划时代的开源AI模型——gpt-oss-120b与gpt-oss-20b,这标志着自2019年GPT-2问世以来,OpenAI再次向全球开发者社区开放了其核心模型的权重。此举不仅为AI的本地化部署提供了坚实基础,更预示着一个更加开放、可控的智能时代正在加速到来。

技术架构深度解析:GPT-OSS的混合专家模式与硬件需求

OpenAI此次推出的gpt-oss系列,并非简单地将云端模型“下放”,而是经过精心设计,以适应更广泛的硬件环境。这两款模型均基于先进的Transformer架构,并引入了“混合专家”(Mixture-of-Experts, MoE)技术,显著优化了参数效率与推理成本。

gpt-oss-20b:这款模型拥有210亿总参数量,但在实际运行中,MoE机制使其每令牌激活参数量降至约36亿。这意味着它对硬件资源的需求相对较低,仅需16GB或更高容量的内存即可在消费级设备上流畅运行,极大降低了本地部署的门槛,使得个人开发者和小型团队也能体验到强大AI的魅力。

gpt-oss-120b:作为系列中的旗舰模型,gpt-oss-120b的总参数量高达1170亿,通过MoE技术,每令牌激活参数量控制在51亿左右。尽管其对内存的需求提升至80GB,超出了多数消费级设备的承受范围,但它能完美适配如Nvidia H100这类专业级AI加速卡,从而在企业级服务器或数据中心环境中发挥其卓越性能。

两款模型均具备128,000令牌的超长上下文窗口,使其在处理复杂文档、代码或长篇对话时游刃有余。此外,OpenAI还为gpt-oss系列设计了可配置的“思维链”(Chain of Thought, CoT)功能,用户可以通过系统提示语简单调整CoT的级别(低、中、高),以平衡推理速度与输出质量,为不同应用场景提供了灵活的优化空间。

性能指标与应用潜力:迈向多领域智能突破

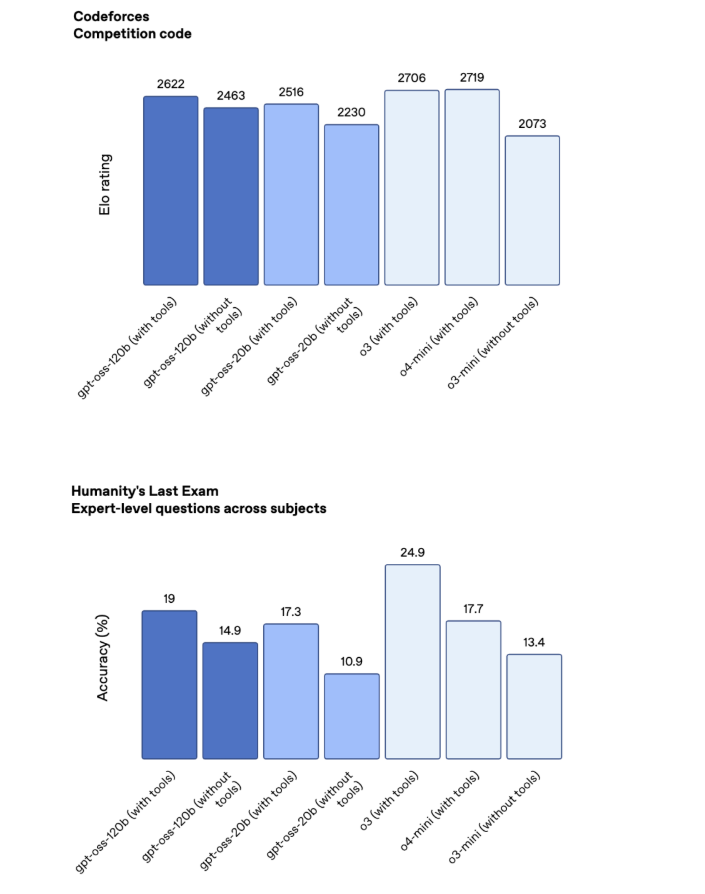

OpenAI官方基准测试数据显示,gpt-oss系列展现出与OpenAI内部领先专有模型相媲美的强大性能。特别是gpt-oss-120b,在多数测试项目中,其表现介于o3和o4-mini私有模型之间,显示出其卓越的通用能力。在特定领域,如数学推理和编程任务,gpt-oss模型的表现尤为突出,这预示着其在科学计算、软件开发辅助等领域具有广阔的应用前景。

然而,模型也存在一定的局限性。例如,在“人类终极考试”(Humanity's Last Exam)等知识密集型测试中,gpt-oss-120b(19%)仍与顶级云端模型如Google的Gemini Deep Think(34.8%)存在差距,这表明在需要深层知识关联与复杂推理的场景,仍有提升空间。此外,当前发布的gpt-oss模型仅支持文本处理,尚不具备原生多模态能力。但OpenAI明确指出,开源特性允许开发者基于这些模型进行二次开发和微调,未来通过社区的力量实现多模态扩展并非不可能。

本地化部署的战略价值:安全、低延迟与深度定制

OpenAI此次开源的核心考量,并非旨在让gpt-oss完全取代其强大的云端专有模型,而是作为一种互补策略,填补特定市场空白。企业和个人在面临以下需求时,本地化部署AI模型显得尤为重要:

数据安全与隐私保护:对于处理敏感数据或受严格法规约束的行业(如金融、医疗),将AI模型部署在本地服务器上,可以确保数据始终不离开企业内部网络,从而最大程度地保障数据安全和隐私。

低延迟与实时响应:本地模型避免了网络传输带来的延迟,尤其适用于需要毫秒级响应的应用,如实时交互、边缘设备上的智能处理等。

深度定制与集成:开源模型的权重开放,意味着开发者可以根据特定业务场景的需求,对模型进行深度微调(Fine-tuning),使其更好地理解行业术语、适应特定数据模式,从而提供更精准、更专业的智能服务。这种灵活性是封闭云端模型难以比拟的。

OpenAI认识到,许多用户已经在利用非OpenAI的开源模型来满足这些本地化需求。通过发布gpt-oss系列,OpenAI旨在为这些用户提供一种端到端的解决方案,实现私有化部署的AI与云端GPT模型的无缝集成,从而构建更强大、更灵活的AI生态系统。

AI伦理与安全承诺:“不善作恶”的设计理念

随着AI能力的飞速提升,其潜在的风险与误用问题也日益受到关注。OpenAI深知开源模型在带来巨大便利的同时,也可能被不当利用。因此,在gpt-oss系列的开发过程中,OpenAI投入了大量资源进行严格的安全测试。他们甚至尝试对模型进行“恶意调教”,测试其在执行有害任务时的表现。结果显示,即使经过这种极端测试,gpt-oss模型也未能达到OpenAI“准备框架”(Preparedness Framework)所定义的高水平“作恶”能力。

这一成果得益于OpenAI在模型设计中融入的“审慎对齐”(deliberative alignment)和“指令层级”(instruction hierarchy)等安全机制。这些机制旨在从底层结构上限制模型的潜在滥用行为,确保其在开放环境中也能维持较高的安全性。这体现了OpenAI在推动AI技术普及的同时,对负责任AI发展的坚定承诺,为开源AI社区树立了新的安全标准。

获取与展望:拥抱AI自主新时代

目前,gpt-oss-120b和gpt-oss-20b模型已在HuggingFace平台开放下载,同时OpenAI也在GitHub上提供了相关的代码仓库,方便开发者查阅和贡献。此外,OpenAI还在其官方基础设施上托管了模型的标准版本,供用户进行测试和评估,并提供了详细的模型卡片和研究博客文章,以满足技术爱好者的深入探索需求。

OpenAI的开源策略,无疑将加速AI技术的普及和创新。gpt-oss系列模型的发布,不仅赋予了企业和开发者在本地环境中部署高级AI的能力,更通过开放的模式,鼓励全球社区共同参与到AI的优化和安全治理中。这标志着AI自主、安全和普惠的新篇章正式开启,我们有理由期待,在不久的将来,基于这些开源模型将涌现出更多富有创意和实际价值的本地化AI应用。