人工智能时代下的隐私悖论:ChatGPT聊天记录泄露事件深度解析

近年来,人工智能技术的飞速发展深刻改变了我们的生活方式,特别是大型语言模型如ChatGPT,已成为无数用户日常交流、内容创作乃至专业咨询的重要工具。然而,伴随其强大能力而来的,是对个人隐私和数据安全日益增长的担忧。最近,ChatGPT用户群体中爆发的一起大规模隐私泄露事件,再次将人工智能应用中的数据边界问题推向风口浪尖,引发了行业内外对AI伦理和用户信任的深刻反思。

事件的导火索在于,部分ChatGPT用户的私人对话记录竟被Google搜索引擎意外收录,导致原本私密的交流内容公之于众。据披露,这些被索引的对话数量庞大,可能仅是冰山一角,其中不乏用户主动分享的、高度个人化甚至敏感的细节,例如亲友关系、心理健康状况、药物使用史以及创伤经历等。尽管搜索引擎并未直接关联用户身份信息,但内容的极度特定性,使得通过聊天内容反向推断用户身份的可能性大大增加,无疑对涉事用户的个人安全构成了潜在威胁。

隐私泄露机制的解析与用户心理

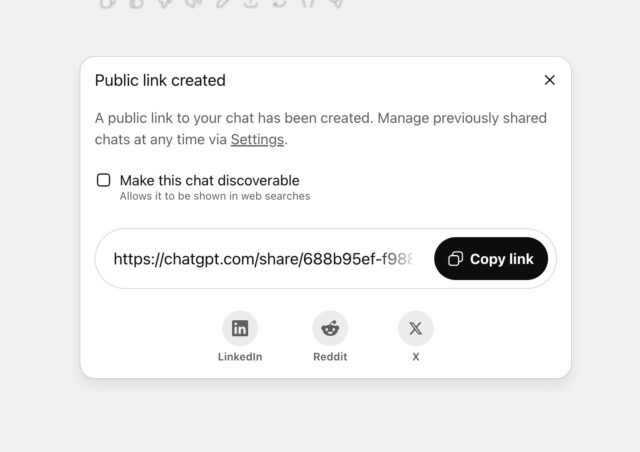

此次事件的核心症结在于OpenAI在共享功能设计上的一个关键细节。当用户选择“分享”聊天时,界面上会出现一个选项框,标明“将此聊天设置为可发现”。在其下方,以更小、更浅的字体提示:“聊天内容可能出现在搜索引擎结果中。”从技术角度看,OpenAI首席信息安全官戴恩·斯塔基解释称,所有被曝光的聊天记录,其用户都曾主动勾选了此选项。OpenAI最初辩称,这种提示方式已“足够清晰”。

然而,实际的用户体验往往复杂得多。在便捷性与隐私权之间,用户决策往往受到界面设计、提示语清晰度以及自身注意力水平的影响。许多用户可能习惯性地点击“分享”以获取链接,用于WhatsApp分享或稍后查阅,却未能充分理解勾选“可发现”选项背后蕴含的重大隐私风险。这种“同意疲劳”或“默认偏误”在数字产品中屡见不鲜,即用户在快速操作中忽视了细微的隐私条款,最终导致意料之外的数据暴露。此次事件恰恰暴露了在用户体验设计中,如何在提供功能便利性的同时,以最直观、最无歧义的方式确保用户对隐私设置的完全理解和自主控制。

OpenAI的应对与责任边界

面对舆论的巨大压力和用户信任危机,OpenAI迅速采取行动,称该功能为一个“短期实验”,旨在“帮助人们发现有用的对话”。公司决定移除这一争议性功能,并承诺将通过周五上午前的努力,从相关搜索引擎中清除已被索引的内容。这一举动,虽然及时止损,但也引发了关于AI公司在产品设计初期对潜在风险评估不足的质疑。

值得注意的是,在事件处理过程中,Google方面的回应模糊了其在此次数据暴露中的具体角色。Google发言人表示,搜索引擎并不控制网页的公开性,内容发布者拥有完全的索引控制权。这似乎将责任完全归咎于OpenAI。理论上,OpenAI可以利用Google提供的工具来阻止页面出现在搜索结果中,但这并不保证能从所有搜索引擎中迅速清除。这一互动再次凸显了在多方技术平台协同运作下,数据隐私责任链条的复杂性。

伦理与信任:科技公司的“小白鼠”论

牛津大学人工智能伦理学家卡丽莎·维利兹对此事件表达了“震惊”,并指出,即使是“短期实验”也“令人不安”,因为“科技公司正在把大众当作小白鼠”。她认为,许多科技企业倾向于推出新的人工智能产品,吸引大量用户,然后“做一些事情,在人群中试用一下,看看是否有人抱怨”,以此来衡量其侵入性设计选择可能带来的后果。这种“先发布后修复”的模式,在快速迭代的AI领域尤为普遍,但当涉及用户核心隐私时,其潜在的破坏性不容忽视。它不仅侵蚀了用户对平台的信任,也可能引发严重的法律和道德争议。

维利兹的观点直指当前AI发展中的一个深层伦理困境:在追求创新和市场占有率的过程中,企业是否充分权衡了技术进步可能带来的社会影响和个人风险?用户并非被动的数据来源,而是数字公民,其隐私权应得到最严格的保障。这意味着,在产品设计之初就应融入“隐私按设计”(Privacy by Design)的理念,而非在出现问题后才进行补救。

持续的隐私挑战:与法律诉讼的交织

此次搜索结果泄露事件并非OpenAI首次面临的隐私挑战。此前,OpenAI曾极力反对一项法院命令,该命令要求其无限期保存所有已删除的ChatGPT聊天记录。这一举动曾让用户感到不安,因为他们原以为临时或已删除的对话不会被永久存储。尽管OpenAI首席执行官萨姆·奥特曼曾承认,用户最私密的聊天记录可能被搜索是“搞砸了”,但他在公开场合似乎并未对OpenAI自身可能导致用户隐私暴露于Google或其他搜索引擎的实践表现出同等程度的透明批评。

这一系列的事件相互交织,共同描绘了AI巨头在数据处理和隐私保护方面的复杂局面。一方面,为了模型的训练和优化,以及提供更好的用户体验,大量用户数据被收集和处理;另一方面,用户对于个人信息被滥用、泄露的担忧日益加剧。如何在数据利用的最大化与用户隐私的最小化侵犯之间找到平衡点,是所有AI企业必须直面的长期挑战。这不仅仅是技术问题,更是关乎企业社会责任和行业健康发展的伦理命题。

重建信任与未来展望

此次ChatGPT隐私泄露事件,为整个AI行业敲响了警钟。它提醒我们,技术创新固然重要,但用户信任才是任何技术长期发展的基石。要重建并维护这种信任,AI企业需要采取更加积极、透明和负责任的姿态。

首先,强化用户教育与透明度至关重要。产品设计应以用户为中心,确保所有隐私选项的表述清晰、易懂,避免任何可能误导用户的模糊措辞或默认设置。用户应在充分知情的前提下,明确、主动地做出关于数据共享的决策。

其次,推行“隐私按设计”原则。在AI系统和产品开发的早期阶段,就应将隐私保护作为核心考虑因素,而非事后修补。这包括实施严格的数据匿名化、最小化数据收集、强化访问控制以及定期进行安全审计。

第三,建立健全的数据治理框架。AI企业应建立内部数据治理委员会,制定清晰的数据收集、存储、处理和销毁政策,并接受独立的第三方审计。同时,积极配合监管机构,共同探索适应AI时代特点的数据保护法规,为用户隐私提供更坚实的法律保障。

最后,提升企业社会责任感。正如事件中AI伦理学家所指出的,将用户当作“实验品”的短期行为,最终将损害企业的长期声誉和用户忠诚度。AI公司需要认识到,每一次数据泄露或隐私侵犯事件,都会削弱公众对新兴技术的信心,阻碍AI的健康可持续发展。

总而言之,ChatGPT聊天记录泄露事件是一次深刻的教训。它不仅揭示了AI产品在隐私保护方面的潜在漏洞,更凸显了在技术高速发展的同时,伦理与责任必须同步前行的重要性。未来的AI,不应只是能力的代名词,更应是信任与安全的象征。唯有如此,人工智能才能真正实现其造福人类的巨大潜力。