引言:大型语言模型推理能力的深度审视

近年来,大型语言模型(LLMs)在处理复杂问题方面展现出惊人的进展,尤其是在“链式思考”(Chain-of-Thought, CoT)方法的加持下,它们似乎能够通过多步骤逻辑推导得出答案。这种能力被广泛视为AI迈向更高级认知的里程碑。然而,随着研究的深入,一个核心问题日益浮现:这些看似强大的推理能力,究竟是模型对世界和逻辑的真实理解,抑或仅仅是对训练数据中模式的一种高超模拟?亚利桑那州立大学的最新研究,为我们揭示了LLM“模拟推理”能力的深层边界,指出其表现可能只是一种“脆弱的海市蜃楼”。这促使我们必须重新审视当前AI模型评估的范式,并对它们在高风险领域的应用保持审慎。

链式思考:表象之下的深层挑战

“链式思考”通过模拟人类的逐步推理过程,允许模型在解决复杂任务时分解问题,并展示中间步骤,从而提高了其解决多步推理问题的能力。这使得LLMs在诸如数学计算、编程逻辑或常识推理等任务上取得了显著进步。业内普遍认为,这是LLMs从单纯的“语言鹦鹉学舌”向更深层次“认知”迈进的关键一步。然而,多项独立研究,包括近期来自Apple和其他机构的发现,开始对这种“推理”的真实性提出质疑。这些研究表明,当问题中包含不相关的信息,或者稍微偏离了模型训练数据中常见的模板时,即使是那些被认为具备“推理”能力的模型,也可能迅速陷入逻辑不连贯或毫无意义的回答。这种现象强烈暗示,CoT的成功,可能更多是源于对特定训练模式的精确复刻,而非真正意义上的泛化推理。

DataAlchemy实验:量化“域外”泛化失效

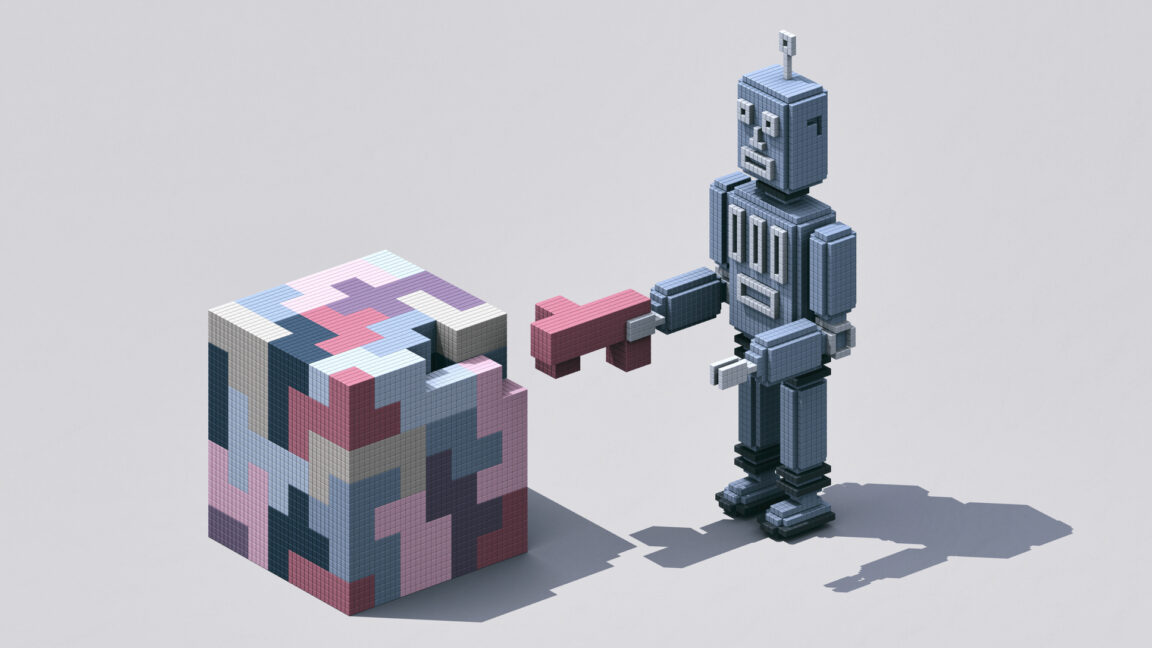

为了系统性地量化并验证LLMs在“域外”(out-of-domain)逻辑问题上的表现,亚利桑那州立大学的研究团队构建了一个名为“DataAlchemy”的受控训练环境。这个精心设计的实验平台,旨在剥离LLMs的复杂性,将其核心推理机制暴露在简单而可控的测试条件下。在DataAlchemy中,研究人员构建了小型化的LLMs,并用极其简单的文本转换示例对其进行训练,例如“ROT密码”(一种简单的替换密码)和“循环移位”(将文本字符进行顺序移动)。随后,模型会接受额外的训练,以学习这些基本功能以不同顺序和组合方式执行时的表现。

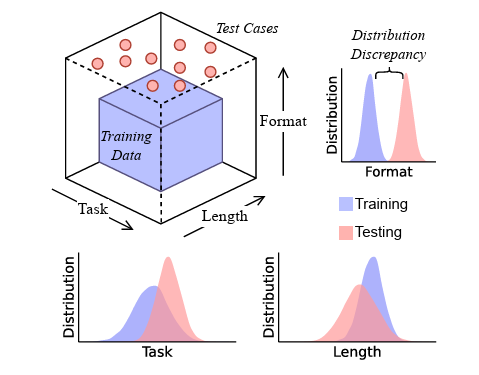

这种受控环境的核心价值在于,它能够精确控制模型所见的训练数据分布。研究人员可以通过调整测试任务,使其与训练数据中的逻辑模式存在精确匹配、部分匹配,或者完全“域外”。例如,一个模型可能只被训练来执行两次循环移位,但在测试时却被要求执行两次ROT移位,尽管模型对单个ROT移位有基础认知。通过这种方式,研究团队能够系统性地探测模型在面对新颖或未曾直接见过的组合逻辑时的表现。为了客观评估模型的准确性,研究人员采用了BLEU分数(用于衡量生成文本与参考文本的相似度)和Levenshtein距离(用于衡量两个序列之间差异的距离)作为量化指标,以精确评估最终答案和推理步骤的正确性。

实证揭示:泛化能力的脆弱性

DataAlchemy的实验结果有力地支持了研究团队的假设:这些基础模型在被要求泛化执行训练数据中未直接演示的新颖转换组合时,其性能出现了灾难性的下降。这并非偶然,而是系统性的失败,揭示了LLMs链式思考能力的内在脆弱性。

研究发现,模型常常会尝试基于训练数据中相似的模式来泛化新的逻辑规则。然而,这种“泛化”往往是表面化的,导致一个令人困惑的现象:模型能够推导出“正确”的推理路径,但最终却给出“不正确”的答案。这表明模型可能掌握了某种形式的逻辑步骤排列能力,但其对这些步骤背后含义的理解却是缺失的。更甚者,在另一些情况下,LLM可能“偶然”得到一个正确的答案,其推理路径却是“不忠实”的,即逻辑链条本身存在谬误或不连贯之处。这两种情况都指向一个核心问题:模型并非真正理解任务的逻辑,而是擅长复制或组合其学习到的文本模式。

这种脆弱性不仅体现在逻辑转换的组合上。研究人员还测试了输入文本字符串的长度变化,以及所需的函数链长度与训练数据不一致的情况。结果显示,随着长度差异的增加,模型的准确性“显著下降”,明确指示了模型泛化能力的失效。这意味着,即使是文本长度这种看似微不足道的变量,也足以使模型性能大打折扣。此外,测试任务格式上的细微、模型不熟悉的差异(例如引入训练数据中未曾出现的字母或符号),也会导致性能“急剧退化”,严重“影响”模型响应的正确性。这些发现共同描绘了一幅清晰的图景:LLMs的链式思考能力,更像是对训练过程中习得模式的一种精细复制,而非对文本的真正理解或对逻辑概念的抽象掌握。

图示:随着请求任务与训练分布的距离增加(红色点越深),所提供答案与预期答案的偏差越大(图表右下角)。

“修补”的局限性:监督微调并非万能药

面对LLMs在“域外”任务上的性能缺陷,一种常见的“修补”策略是采用“监督微调”(Supervised Fine-Tuning, SFT),即引入少量相关的域外数据对模型进行额外训练。通过SFT,模型在特定新任务上的表现往往能得到显著提升。然而,研究人员对此类“补丁”式解决方案提出了严厉警告。他们认为,这种做法不应被误认为是实现了真正的泛化能力。

监督微调虽然能解决特定的域外失败案例,但这是一种不可持续的、被动式的策略,未能从根本上解决核心问题——即模型缺乏抽象推理能力。每一次出现新的域外场景,都需要额外的数据和微调,这不仅耗费资源,也未能触及模型对未知逻辑的适应性问题。SFT的本质是让模型学习新的模式,而不是使其获得举一反三的抽象能力。因此,这种方法虽然在短期内有效,却掩盖了LLMs在复杂、多变现实世界中泛化能力不足的深层缺陷。

理解与模拟:AI认知本质的辨析

这项研究的核心论断是:链式思考模型并非真正意义上的逻辑推理者,而是一种高度复杂的“结构化模式匹配器”。当它被推离其训练分布哪怕仅仅一小步,其性能就会“显著下降”。更具误导性的是,这些模型生成“流畅的胡言乱语”(fluent nonsense)的能力,为它们创造了“一种虚假的可信度光环”。这种流畅性往往能掩盖其逻辑上的缺陷,使得非专业人士难以辨别其回答的真实有效性。这种“假象”尤其危险,因为它可能导致用户对其能力产生过高的期望和依赖,尤其是在关键任务场景下。

我们必须清醒地认识到,当前LLMs的“智能”表现,更多地是基于其强大的数据拟合能力和模式识别能力,而非人类意义上的因果推理或抽象思维。它们可以模仿推理的语言形式和步骤,但并不意味着它们理解这些形式和步骤背后的逻辑关系和世界模型。这种“模拟”与“理解”之间的本质差异,是当前AI研究和应用中必须深刻思考的核心问题。

高风险领域警示:AI决策的边界

鉴于LLMs在泛化能力上的内在局限性,研究人员强烈警告,不要将“链式思考”的输出与人类思维画等号,尤其是在那些“高风险领域”,如医疗诊断、金融分析或法律判决。在这些领域,错误的推理可能导致灾难性的后果,例如错误的医疗建议、错误的投资决策或不公正的法律判决。

在这些对准确性和可靠性有极高要求的场景中,对LLM输出的盲目信任无疑是危险的。模型可能会生成看似合理但逻辑不成立的“推理”,这在关键时刻可能导致无法挽回的损失。因此,在将LLMs部署到这些高风险应用之前,必须对模型的真实能力进行更为严苛和全面的评估,特别是其在处理未见过或部分偏离训练分布的任务时的鲁棒性。

未来展望:超越模式识别,迈向深层推断

这项研究为大型语言模型的发展指明了清晰的方向。未来的模型开发和评估基准,应当优先考虑那些能够探查模型“域外”错误的任务,而非仅仅在训练数据内的表现上寻求优化。这意味着我们需要设计更具挑战性、更能考验模型泛化和抽象推理能力的测试集。

为了实现真正的“深度推断能力”,而不仅仅是“表面模式识别”,未来的AI模型需要从根本上改变其学习机制。这可能涉及开发新的架构、训练范式,或者融入更深层次的符号逻辑和因果推理机制。只有当LLMs能够超越现有模式匹配的范畴,真正理解并泛化抽象逻辑时,它们才能在复杂且不可预测的现实世界中提供真正可靠的智能支持。这需要科研界、产业界乃至整个社会共同努力,以确保人工智能的每一步发展都建立在坚实而透明的认知基础之上。