AI技术自诞生以来,其发展路径始终伴随着对算力与模型规模的追求。然而,随着人工智能应用场景的日益泛化,尤其是向边缘设备渗透,业界对AI模型轻量化、高效化的需求变得前所未有地迫切。在这一趋势下,欧洲AI初创公司Multiverse Computing的最新突破,无疑为边缘AI领域带来了颠覆性的解决方案,其发布的“鸡脑”和“蝇脑”模型,以超小的体积和卓越的离线运行能力,重新定义了AI在资源受限环境下的可能性。

Multiverse Computing的创新愿景与技术基石

Multiverse Computing并非凭空崛起,其深厚的量子计算与物理学背景,赋予了公司在AI模型压缩领域独特的视角和优势。这家总部位于西班牙的公司,由量子计算专家和前银行高管共同创立,旨在将前沿的量子启发算法应用于现实世界的计算挑战。他们深刻理解到,尽管大型模型在云端表现出色,但要将AI的智能普及到数十亿计的物联网设备、智能手机乃至可穿戴设备上,模型的体积和能耗必须得到根本性的优化。

公司在2019年成立以来,便将目光聚焦于此。其成功融资高达2.5亿美元,其中最新一轮1.89亿欧元的融资更是直接肯定了其核心技术CompactifAI的巨大潜力。这笔资金不仅彰显了投资者对Multiverse Computing技术路线的信心,也为公司进一步研发和市场扩张提供了坚实支撑。

核心技术:CompactifAI的量子启发式压缩范式

Multiverse Computing的核心竞争力在于其独有的CompactifAI压缩算法。不同于传统计算机科学或机器学习领域常用的剪枝、量化等模型压缩技术,CompactifAI借鉴了量子物理学的深刻原理,采取了一种更为精妙和精细的压缩策略。这种“量子启发式”的方法,使得模型在大幅缩小的同时,能够最大程度地保持甚至优化其原始性能。

具体而言,CompactifAI并非简单地移除冗余参数,而是通过对模型内部结构进行更深层次的重构和优化,从而实现极致的压缩比。这意味着,通过这项技术处理过的模型,不仅体积显著减小,其推理速度和能效比也得到了显著提升,为在功耗敏感和计算能力有限的边缘设备上部署复杂AI功能提供了可能。这项技术的突破性在于,它打破了传统认知中模型尺寸与性能之间的强绑定关系,为AI的普惠化打开了新的大门。

Multiverse Computing已经将其CompactifAI技术应用于多个流行的开源模型,包括Llama4Scout、Mistral Small3.1,以及OpenAI最新发布的开源模型和DeepSeek R1Slim等大型模型,成功推出了它们的压缩版本。这不仅验证了CompactifAI的普适性,也为广大开发者社区提供了更多轻量级的AI模型选择,加速了边缘AI应用的开发与落地。

“动物脑”模型系列:深度剖析SuperFly与ChickBrain

Multiverse Computing将旗下超小型模型幽默地命名为“模型动物园”,以动物大脑尺寸进行比喻,生动形象地展示了其模型的极致轻量化。其中,SuperFly和ChickBrain是两大代表作,各自针对不同的应用场景和性能需求进行了优化。

SuperFly模型:设备端智能的“蝇脑”典范

SuperFly模型是Hugging Face的SmolLM2-135模型的压缩版本。原始模型拥有1.35亿个参数,已是为设备端使用而优化的模型。而Multiverse Computing通过CompactifAI技术,将其进一步压缩至仅9400万个参数,达到了“蝇脑”般的微小体积。

SuperFly的设计初衷是能够在极其有限的数据上进行训练,例如智能设备的日常操作数据。其核心应用场景在于为家用电器等物联网设备赋能,实现离线、本地化的语音命令交互。例如,用户可以直接对洗衣机发出“开始快洗”的指令,或询问故障排除方法,而无需依赖云端连接。Multiverse Computing已成功在处理能力极其有限的Arduino等微控制器上进行了现场演示,证明了SuperFly在超低功耗和低算力环境下的卓越表现。这种能力对于提升用户体验、保障数据隐私以及降低设备运行成本具有里程碑意义。

ChickBrain模型:超越原始性能的“鸡脑”力量

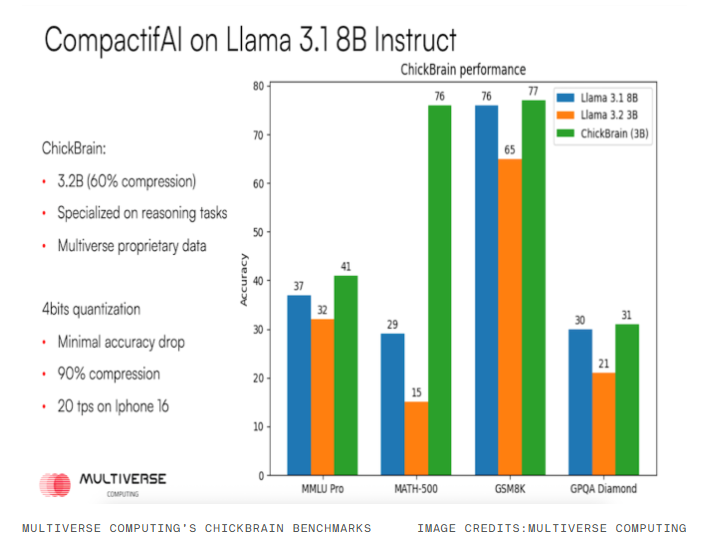

相较于SuperFly,ChickBrain模型拥有32亿个参数,体积更大,但其功能也更为强大,具备了更复杂的推理能力。ChickBrain是Meta Llama3.18B模型的压缩版本。令人惊叹的是,尽管经过大幅压缩,奥鲁斯表示ChickBrain在多个标准基准测试中,如语言技能基准MMLU-Pro、数学技能基准Math500和GSM8K,以及通用知识基准GPQA Diamond中,其性能甚至略微超越了原始的Llama3.18B模型。

这意味着Multiverse Computing不仅实现了模型的显著小型化,更在某些关键能力上实现了“负损失”甚至“正收益”的优化。ChickBrain的成功,预示着未来AI模型的发展不再是简单地追求参数规模的膨胀,而更可能转向在有限资源下如何通过创新技术,释放出更高效、更强大、更普适的智能潜力。ChickBrain能够在MacBook等个人电脑上实现离线运行,无需互联网连接,这为本地AI应用开发者提供了前所未有的便利和可能性。

边缘计算的未来图景与模型部署新范式

Multiverse Computing的“动物脑”模型系列,为边缘计算领域描绘了一幅令人振奋的未来图景。传统的云计算模式虽然强大,但在处理实时性要求高、数据隐私敏感或网络连接不稳定的场景时,常常力不从心。边缘AI的兴起,正是为了解决这些痛点。

随着AI模型被压缩到足以在设备本地运行,其优势变得显而易见:

- 极致的低延迟:所有计算都在本地完成,无需数据往返云端,响应速度大幅提升,尤其适用于自动驾驶、工业自动化等对实时性要求极高的场景。

- 增强的数据隐私与安全性:用户数据无需上传至云端,直接在设备本地处理,有效避免了数据泄露风险,满足了日益严格的数据保护法规要求。

- 摆脱网络依赖:设备可以在没有互联网连接的环境下独立运行,这对于偏远地区、移动设备或特定工业应用至关重要。

- 降低运营成本:减少对云端算力的依赖,进而降低了企业的长期运营成本和能耗。

Multiverse Computing的技术突破,使得这些优势不再是遥远的愿景,而是触手可及的现实。从智能家居设备(如无需联网即可进行语音交互的智能音箱、洗衣机),到可穿戴设备(如Apple Watch上运行的离线AI助手),再到工业物联网中的传感器和控制器,其应用潜力无限广阔。

市场战略与生态合作:构建普惠AI生态

Multiverse Computing深知,要将革命性的技术推向市场,构建强大的生态合作网络至关重要。该公司已积极与全球领先的设备制造商和科技巨头展开深入洽谈,其中包括苹果、三星、索尼以及投资者惠普、东芝等。这些战略合作不仅能加速其模型在各类终端设备上的集成,也为其技术标准的推广奠定了基础。

此外,Multiverse Computing还采取了双轨制市场策略。除了直接向大型设备制造商提供定制化的模型压缩服务外,公司还在AWS上搭建了API服务,面向全球开发者开放其压缩模型。这种模式允许任何规模的开发者以更低的token费用使用其高性能的轻量级AI模型,从而极大地降低了AI开发的门槛,促进了创新应用的繁荣。在过去的六年里,公司已经积累了巴斯夫、Ally、穆迪、博世等一系列重量级客户,这充分证明了其技术的商业价值和市场认可度。

行业影响与未来展望

Multiverse Computing的超小型AI模型,不仅仅是技术上的进步,更是对未来AI发展方向的深刻洞察。它预示着AI将从“大而全”的集中式云端模式,逐步走向“小而精”的分布式边缘模式。这种转变将使得人工智能更加普惠化、个性化和高效化,真正融入到我们生活的每一个角落。

随着CompactifAI等技术的不断成熟,我们可以预见,未来将有更多具备强大AI能力的设备无需昂贵的硬件或持续的网络连接,便能提供智能服务。这不仅会催生全新的产品形态和商业模式,也将极大地提升现有智能设备的性能和用户体验。Multiverse Computing的创新实践,无疑为全球AI产业提供了一个极具价值的参考范本,推动着人工智能从实验室走向更广阔的真实世界,开启一个智能无处不在的新时代。