随着人工智能技术日趋成熟,智能体已渗透到我们日常生活的方方面面,其中以谷歌的Gemini系列产品为代表。Gemini正逐步深入谷歌生态系统的核心,其与用户数据交互的方式也在持续演变。近期,谷歌宣布对Gemini的隐私管理和个性化功能进行重大调整,旨在提升用户体验的同时,也对个人数据的使用划定了新的界线。这些变化不仅涉及到Gemini如何“记忆”您的对话内容以提供更精准的回复,还引入了全新的“临时聊天”模式,以及最关键的——调整了用户数据默认用于AI模型训练的策略。面对AI智能体日益增长的个性化能力,用户如何有效管理自身数据隐私,掌握数字时代的主动权,成为当前亟待关注的议题。

“个人上下文”:双刃剑下的智能体验革新

谷歌Gemini此次更新的核心亮点之一便是“个人上下文”(Personal Context)功能。这项功能允许Gemini在您的许可下,记忆并利用过往对话中的细节信息,从而在无需明确提示的情况下,提供更加贴合您个人需求的定制化回复。这与几个月前谷歌曾尝试依赖用户搜索历史进行个性化(但反响平平)的做法截然不同。彼时的“个性化”模式更多是基于外部数据源,而“个人上下文”则聚焦于用户与Gemini自身的交互历史,旨在打造一种更具连续性和智能性的对话体验。

理论上,这项功能能够显著提升Gemini的实用性,尤其是在提供个性化推荐或持续性对话场景中。例如,当您请求Gemini推荐书籍或餐厅时,如果它能“记住”您此前的阅读偏好或饮食习惯,那么推荐结果无疑会更加精准和高效。这与我们人类交流的逻辑相仿:一个善于倾听和记忆的朋友,总能提供更贴心的建议。这种“记忆能力”使得AI不再是每次对话都从零开始的冷冰冰的机器,而是能随着互动逐渐“理解”您的智能伙伴。

潜在风险:智能体“过度拟人化”的挑战

然而,硬币的另一面是潜在的风险。当AI聊天机器人变得过于“友善”或“理解”用户时,可能反而会强化用户的错误观念,甚至在极端情况下导致“妄想性思维”——这在AI模型中并非闻所未闻。过度的个性化和记忆能力,可能让用户误以为AI具有人类的情感和意识,从而降低对AI回复的审慎态度。如果AI在学习过程中习得了某些偏见或不准确的信息,并基于此进行个性化反馈,可能会在用户不知情的情况下,持续强化这些不准确的认知。因此,如何在提升便利性与维护信息客观性之间取得平衡,是AI发展中不可避免的伦理挑战。用户在享受个性化服务的同时,也需保持批判性思维,避免过度依赖AI的“记忆”。

实施细节与地域限制

当前,“个人上下文”功能将率先在Gemini 2.5 Pro模型上推出,并且初期不适用于欧盟、英国和瑞士的用户,同时仅限于18岁以上的用户使用。谷歌计划在未来逐步将此功能扩展至更多地区,并支持效率更高的Gemini 2.5 Flash模型。用户可以随时在Gemini的主设置页面开启或关闭此功能,这为用户提供了一定的控制权,但主动管理设置的意识和行动力,将成为区分用户体验差异的关键。

“临时聊天”:捍卫数字隐私的新防线

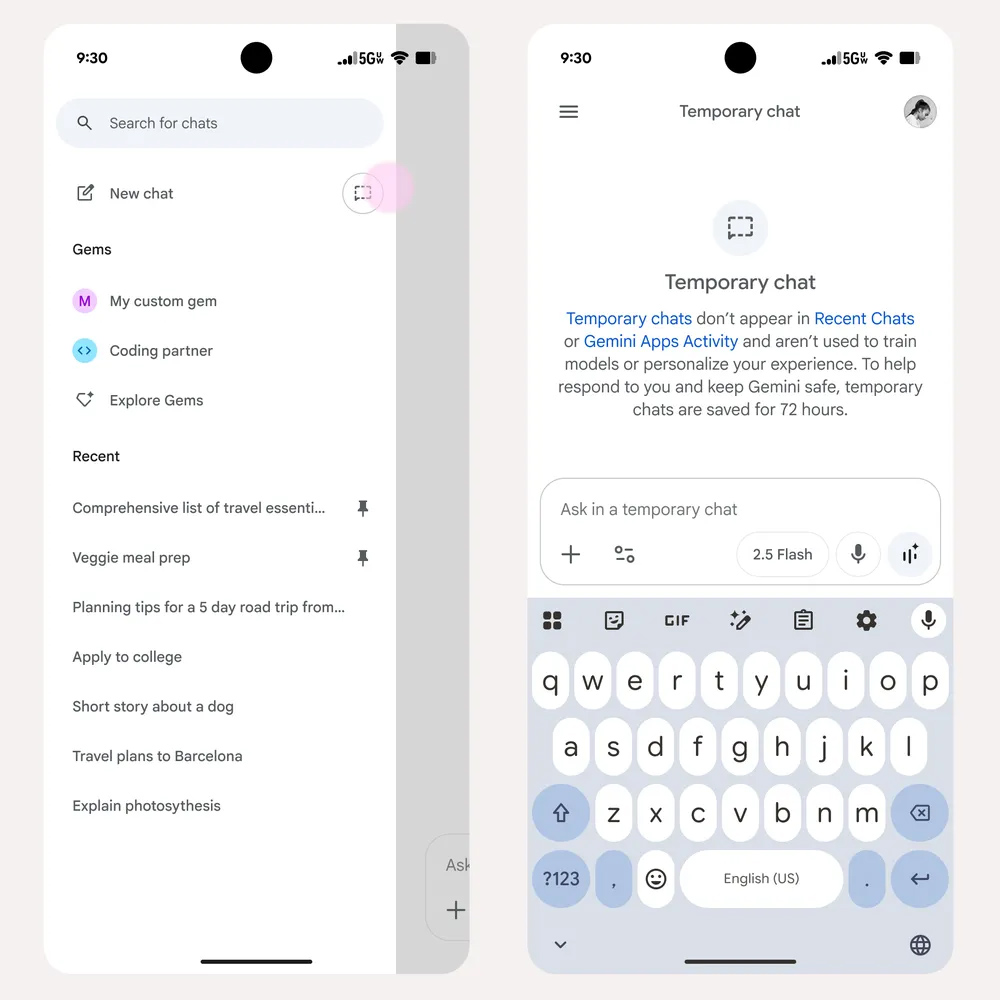

随着Gemini个性化能力的增强,用户可能会更频繁地思考哪些对话适合被AI“记住”,哪些则应该保持私密。为此,谷歌推出了“临时聊天”(Temporary Chats)选项,这被视为Gemini的“无痕模式”,为那些不希望其对话内容被用于个性化或模型训练的用户提供了重要的隐私保障。这项功能已于近期开始逐步向所有用户推出,并在未来几周内全面覆盖。

“无痕模式”的AI实践

“临时聊天”功能将通过Gemini应用中“新聊天”旁边的专用按钮访问。与普通聊天不同,用户在“临时聊天”模式下输入的所有内容,即使“个人上下文”功能处于启用状态,也不会被用于Gemini的个性化调整。这意味着,您可以放心地进行一些敏感、私密或纯粹的、不希望AI“学习”的对话,而不必担心这些信息会影响Gemini未来的行为或反馈。这在很大程度上满足了用户对即时性隐私保护的需求,尤其是在处理个人健康信息、财务咨询或其它高度敏感话题时,提供了更强的安全感。

即时性与短期留存的考量

值得注意的是,尽管被称为“临时聊天”,这些对话并非完全瞬时消失。谷歌表示,为了方便用户查阅和延续对话,临时聊天内容仍将在谷歌服务器上保留72小时。这一设计在提供隐私保护的同时,也兼顾了用户可能需要短期内回顾或继续某段对话的实际需求。72小时的保留期提供了一个合理的缓冲,既避免了永久存储带来的隐私风险,又保留了临时交互的灵活性。然而,用户仍需明确,72小时后这些数据将被清除,不应将其作为长期信息存储的手段。

数据洪流中的抉择:AI模型训练与用户知情权

或许是此次更新中最具深远影响的一项改变,谷歌已确认将调整其使用用户上传到Gemini内容的方式。从2025年9月2日起,您的聊天记录和上传数据(包括文件)的样本将默认被用于训练谷歌的AI模型。用谷歌官方的话来说,这些数据将用于“改善谷歌服务,造福所有人”。

默认启用与主动退出的范式转变

此前,用户可能需要主动选择加入(Opt-in)某些数据共享计划;而现在,谷歌将采取默认启用(Opt-out)的策略。这意味着,除非您主动选择退出,否则您的部分数据将自动被用于AI模型开发。这种默认设置的改变,将大量的用户置于一个需要主动采取行动才能维护数据隐私的境地。这凸显了企业在数据使用方面日益增长的主动性,也对用户的数字素养和隐私管理意识提出了更高要求。用户需要意识到,这种看似微小的设置变动,可能对个人数据的流向产生根本性影响。

用户数据贡献与模型优化的深层逻辑

从AI技术发展的角度看,高质量、大规模的用户数据是模型优化和进步的基石。通过分析真实的用户交互数据,AI模型能够学习到更细致的语言模式、更复杂的语境理解和更准确的知识推理能力。这种数据驱动的迭代是AI模型不断提升性能、减少偏见、提高泛化能力的关键。谷歌的这一举措无疑是为了加速Gemini模型的迭代速度和智能水平。然而,这种优化是否以牺牲用户数据主权为代价,以及如何在模型进步与用户隐私之间找到可持续的平衡点,是整个AI行业必须深思的问题。

为了不让您的数据被用于谷歌的模型开发,您需要在未来几周内关注并调整您的账户级隐私设置。谷歌将把“Gemini应用活动”(Gemini Apps Activity)这一设置更新为“保留活动”(Keep Activity)。您可以选择禁用此设置,或者在需要高度隐私的场景下使用“临时聊天”功能,从而阻止您的数据被“喂给”谷歌的AI模型。务必在9月2日之前检查此设置,否则您的数据将可能被默认纳入谷歌的数据池。

构建信任:用户、平台与智能体的共生未来

谷歌Gemini的这些新功能和政策变化,标志着AI个性化发展进入了一个新阶段,同时也再次将数据隐私和用户控制权推到了风口浪尖。在AI日益成为我们数字生活基础设施的当下,构建一个透明、可控且值得信赖的AI生态系统至关重要。

赋能用户:掌握数字主权的关键

对于广大用户而言,了解并熟练运用这些新的隐私管理工具,是掌握自身数字主权的关键。这不仅仅是点击一个开关那么简单,更是一种数字公民责任的体现。用户需要主动审视每一项与AI交互相关的设置,理解其背后的含义和潜在影响,并根据自身需求和风险偏好做出明智的选择。只有当用户真正具备了对自身数据的控制能力,才能在享受AI便利的同时,最大程度地规避潜在的隐私风险。

平台责任:透明度与可控性

作为AI技术提供方,谷歌等科技巨头肩负着重大的社会责任。透明度是建立用户信任的基石。平台需要以清晰、易懂的方式向用户解释数据使用的目的、范围和方式,避免使用晦涩难懂的法律术语或默认勾选的陷阱。同时,提供简便、高效的隐私控制选项,确保用户能够轻松地管理自己的数据偏好,是履行平台责任的体现。未来的AI发展,将越来越依赖于用户对平台的信任,而这种信任的建立,离不开平台在数据伦理和用户权益保护方面的持续投入和改进。

AI伦理的持续演进

AI的个性化能力无疑将带来更智能、更高效的服务,但也伴随着新的伦理挑战。如何在提升AI智能的同时,确保其行为的公平性、透明性和可控性,防止算法偏见和隐私泄露,将是AI伦理研究和实践的长期课题。行业需要不断探索更健全的法律法规、更完善的技术标准和更普适的伦理框架,以引导AI技术朝着造福人类的方向健康发展。谷歌Gemini此次的调整,无疑是这一宏大进程中的一个缩影,它提醒我们,AI的未来,需要科技创新者、政策制定者以及每一个用户的共同努力和智慧。