OpenAI近期宣布推出两款名为gpt-oss-120b和gpt-oss-20b的全新开放权重人工智能模型,这标志着自2019年GPT-2发布以来,OpenAI首次再次将其核心模型技术向公众开放。这些模型不再局限于云端运行,而是允许用户直接在本地硬件上部署和操作,为AI应用的部署和定制化带来了革命性的转变。

本地部署的优势与技术细节

传统的云端AI模型依赖于强大的服务器基础设施,这对于许多企业和个人用户而言,意味着高昂的运行成本和潜在的数据隐私风险。gpt-oss系列模型的推出,旨在打破这一局限,使用户能够在自有设备上实现高级AI能力。这种本地化的部署模式不仅显著降低了推理延迟,更重要的是,它赋予了用户对敏感数据更强的控制权,确保数据在本地环境中处理,提升了安全性。

新模型分为两个主要版本:gpt-oss-120b和gpt-oss-20b。其中,gpt-oss-20b拥有210亿参数,通过专家混合(MoE)架构,每个令牌的有效参数量可降至36亿。而更大规模的gpt-oss-120b则包含1170亿参数,MoE架构使其每令牌有效参数量为51亿。这种设计使得模型在保持高性能的同时,也兼顾了资源效率。

对于硬件要求,gpt-oss-20b对消费级设备相对友好,最低仅需16GB内存即可运行。而gpt-oss-120b则需要更高的配置,建议配备80GB或以上内存,例如一块Nvidia H100这样的专业AI加速GPU。尽管参数规模庞大,但MoE架构的引入有效地优化了计算负载。值得一提的是,这两款模型都具备高达128,000令牌的上下文窗口,这意味着它们能够处理和理解更长篇幅的文本输入,从而在复杂任务中展现出卓越的理解和生成能力。

性能基准与应用潜力

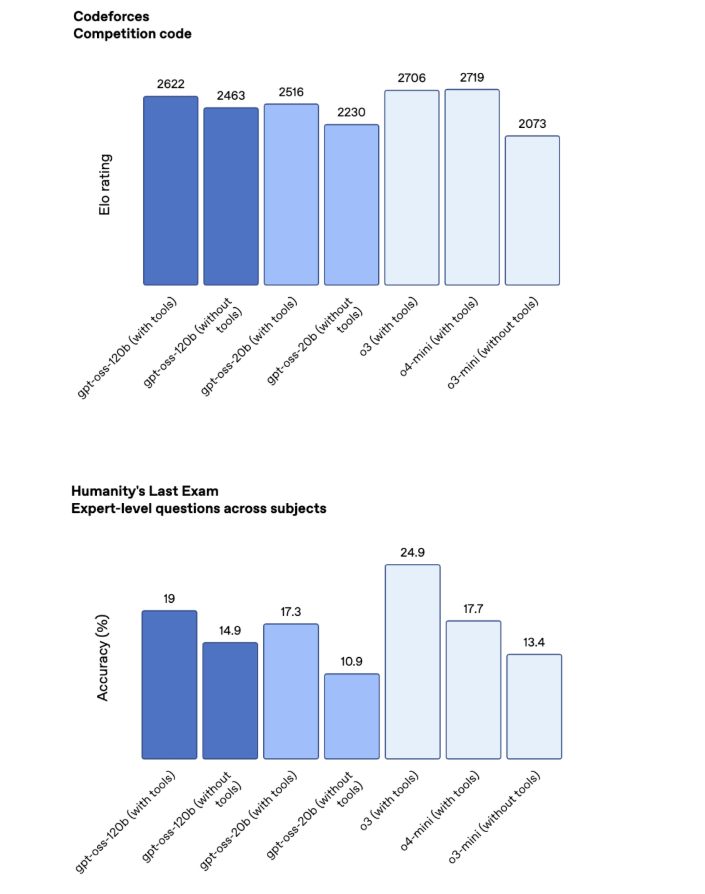

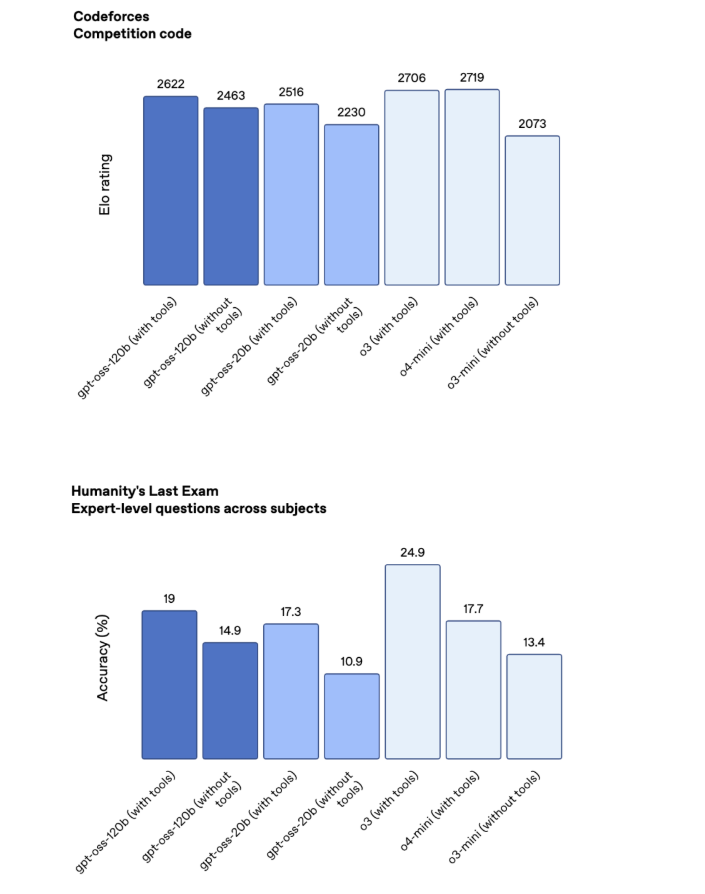

OpenAI团队表示,gpt-oss系列模型的性能表现可与其领先的云端专有模型相媲美。在多项基准测试中,gpt-oss-120b的性能介于o3和o4-mini专有模型之间,而gpt-oss-20b则稍逊一筹。特别是在数学和编程任务中,gpt-oss模型展现出与其云端兄弟模型相近的卓越表现。然而,在某些专业知识密集型测试,如“人类最后的考试”(Humanity's Last Exam)中,虽然gpt-oss-120b仍能达到19%的正确率(有工具辅助),但相较于Google的Gemini Deep Think在同一测试中取得的34.8%仍有差距。这表明在特定领域,开放模型与顶尖的闭源模型之间仍存在一定的性能鸿沟,但其在通用能力上的表现足以应对绝大多数复杂应用场景。

虽然OpenAI并不期望gpt-oss模型完全取代其专有模型,但它们无疑提供了一个强有力的补充。在那些不适合将数据传输到云端,或者需要极低延迟的应用场景下,本地化部署的gpt-oss模型展现出无可比拟的优势。例如,在需要处理高度敏感的企业数据、构建离线语音助手或开发定制化内容生成工具时,gpt-oss模型提供了前所未有的灵活性和控制力。

安全考量与开放生态

OpenAI深知开放模型可能带来的潜在风险。因此,在开发gpt-oss模型时,公司投入了大量精力确保其安全性。通过采用“审慎对齐”(deliberative alignment)和“指令层级”(instruction hierarchy)等先进技术,模型在设计之初就被赋予了抵制恶意行为的能力。OpenAI甚至进行了一系列“最坏情况”测试,尝试将gpt-oss模型引向不当用途。测试结果表明,即使经过恶意调优,模型在生成“邪恶”内容方面的质量仍然不高,这从侧面验证了其内置安全机制的有效性。

gpt-oss模型遵循Apache 2.0开源许可证,这意味着开发者可以自由地下载、修改和分发这些模型,为其特定应用场景进行深度定制。这种开放性不仅鼓励了社区协作,也极大地加速了基于这些模型的新应用和研究的诞生。OpenAI已将gpt-oss-120b和gpt-oss-20b模型上传至HuggingFace平台供下载,并提供了相应的GitHub代码库。此外,OpenAI也将在其基础设施上托管这些模型的标准版本,方便用户进行测试和评估。

总而言之,OpenAI此次开放权重模型的举动,不仅是对开源社区的一次重大贡献,更是对未来AI部署模式的一次深刻探索。它预示着AI技术将更加普及,赋能更多个人和企业在本地环境中实现智能化转型。随着这些模型的广泛应用,我们有理由期待一个更加开放、安全和可定制的AI新时代。