NVIDIA Nemotron Nano 2:高效推理模型的创新实践与深度解析

近年来,随着人工智能技术的飞速发展,大型语言模型(LLMs)在各行各业展现出巨大潜力。然而,如何平衡模型性能与推理效率,尤其是针对边缘设备和资源受限环境,一直是业界关注的焦点。英伟达(NVIDIA)最新推出的Nemotron Nano 2模型,正是在这一背景下应运而生,它以其独特的混合架构和卓越的性能表现,为高效AI推理树立了新的标杆。

Nemotron Nano 2 的核心定位与技术亮点

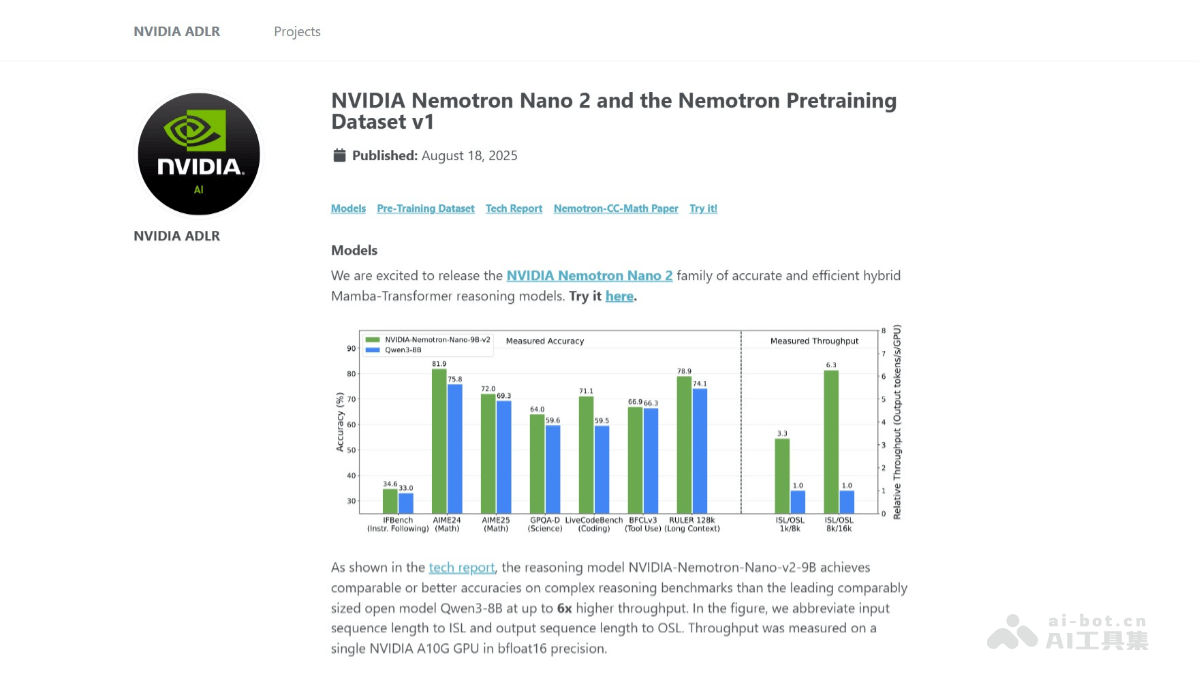

NVIDIA Nemotron Nano 2是一款参数量为90亿(9B)的高效推理模型。其最为显著的创新在于采用了混合Mamba-Transformer架构,这一设计巧妙地融合了Mamba模型的长序列处理优势与Transformer模型的强大并行能力。在高达20万亿个标记(tokens)的庞大数据集上进行预训练,并支持惊人的128k上下文长度,这意味着模型能够处理极其冗长和复杂的输入信息,而无需牺牲效率。与同类领先模型Qwen3-8B相比,Nemotron Nano 2在推理速度上实现了高达6倍的提升,同时保持了相当甚至更优的准确率,这无疑是AI部署领域的一大突破。此外,模型还引入了独特的“思考预算”(Reasoning Budget)控制功能,允许用户根据实际需求指定推理过程中消耗的token数量,从而实现计算资源的精细化管理和优化。英伟达的开放策略,将基础模型和大部分预训练数据集开源,也极大地促进了开发者社区的进一步研究和应用创新。

卓越功能与广泛应用潜力

NVIDIA Nemotron Nano 2凭借其一系列核心功能,展现出在复杂推理任务中的强大实力和广泛适应性:

- 高吞吐量与性能飞跃:在执行复杂的逻辑推理和文本生成任务时,Nemotron Nano 2的吞吐量比Qwen3-8B高出六倍,这使得它在处理大规模并发请求或需要快速响应的场景中表现卓越,显著降低了推理延迟并提升了系统整体效能。

- 无与伦比的长上下文支持:该模型支持高达128k的上下文长度,并且能够在单个NVIDIA A10G GPU上进行推理。这一能力对于处理长篇文档分析、代码库理解、多轮复杂对话以及详细报告生成等任务至关重要,极大地拓宽了模型的应用边界。

- 可控的推理过程:Nemotron Nano 2能够在生成最终答案之前,先生成详细的推理过程(reasoning trace)。用户可以灵活指定模型的“思考”预算,例如限制生成中间推理步骤的token数量,这为用户提供了前所未有的控制力,便于理解模型的决策路径,进行调试和优化。

- 灵活的输出模式选项:为了适应不同的应用需求,用户可以选择跳过中间推理步骤,直接获取最终答案。这种灵活性使得模型既能满足需要透明化推理过程的科研和调试场景,也能高效地服务于仅需最终结果的商业应用。

- 强大的多语言能力:模型在预训练阶段融合了多种语言的数据,使其具备了出色的多语言理解和生成能力,能够无缝支持全球范围内的跨语言应用和交互,打破了语言障碍。

- 多领域知识覆盖:Nemotron Nano 2的预训练数据集广泛覆盖了数学、代码、学术、STEM(科学、技术、工程、数学)等多个领域,确保了模型在不同专业领域内的知识广度和深度,使其成为跨学科任务的理想选择。

Nemotron Nano 2的深层技术剖析

Nemotron Nano 2之所以能实现性能与效率的完美结合,得益于其精妙的技术架构和优化策略:

- 混合Mamba-Transformer架构的协同效应:此架构创新性地用Mamba-2层替代了传统Transformer模型中的大部分自注意力层。Mamba-2层在处理长序列数据时具有卓越的效率和线性缩放能力,显著提升了推理速度,尤其是在生成冗长的推理链时。同时,模型保留了部分Transformer层中的自注意力机制,以确保其保持原有的强大表征能力和处理复杂关联的灵活性,有效平衡了速度与准确性。

- 大规模预训练与上下文扩展:模型在20万亿个token上进行了预训练,这一庞大的数据集确保了其基础知识的广度和深度。预训练过程中,英伟达采用了FP8精度和Warmup-Stable-Decay学习率调度策略,以优化训练效率和模型收敛。更重要的是,通过持续预训练的长上下文扩展阶段,模型在不牺牲其他基准测试性能的前提下,成功实现了对128k上下文长度的有效支持,这对于处理极端长文本的应用具有革命性意义。

- 多阶段后训练优化:为了进一步提升模型的实际应用表现,Nemotron Nano 2经历了精细的后训练流程:

- 监督微调(SFT):通过高质量的监督数据对模型进行微调,使其在特定任务上的表现更符合预期,提升了指令遵循能力和特定任务的精准度。

- 策略优化与偏好学习:模型通过策略优化进一步提升了指令遵循能力,确保其能够准确理解并执行用户的复杂指令。同时,通过偏好优化,使模型的输出更加符合人类的审美和判断,提高了用户满意度。

- 人类反馈强化学习(RLHF):借助人类反馈的强化学习机制,模型不断从真实用户交互中学习和迭代,显著提升了对话能力、安全性以及对用户意图的理解和响应质量。

- 高效的模型压缩技术:为了实现轻量化部署和成本优化,英伟达利用剪枝(pruning)和知识蒸馏(knowledge distillation)技术,将12B参数的基础模型成功压缩至9B参数,同时几乎没有损失模型性能。这一优化使得Nemotron Nano 2能够在单个NVIDIA A10G GPU上高效进行128k token的上下文推理,极大地降低了硬件门槛和推理成本,使其更易于广泛部署。

- 智能推理预算控制:基于独特的截断训练(truncated training)方法,Nemotron Nano 2能够根据用户指定的“思考”预算进行推理,从而避免不必要的计算。用户可以灵活控制是否展示中间推理过程或直接获取最终答案,这不仅提升了用户体验,也为模型在不同场景下的资源消耗管理提供了精细化的手段。

深度应用场景分析与未来展望

Nemotron Nano 2的发布,无疑将为多个行业带来深远影响:

- 教育领域革新:在教育领域,Nemotron Nano 2可以帮助学生解决复杂的数学和科学问题。通过逐步生成推理过程,模型能够详细解释复杂的数学公式、物理定律或化学反应机制,使抽象概念具象化,从而帮助学生更深入地理解和掌握知识,甚至可以作为个性化导师,辅助学生进行定制化学习。

- 加速学术研究进程:对于研究人员而言,Nemotron Nano 2能够辅助进行学术研究,例如生成详细的实验设计报告、综述现有文献、辅助假设生成,甚至是分析复杂的实验数据并提供洞察。其长上下文能力尤其适用于处理大量研究论文和数据集,加速科研发现。

- 软件开发效率飞跃:开发者可以利用Nemotron Nano 2生成高质量的代码片段、进行代码重构、自动化测试用例生成、甚至辅助调试复杂系统。模型的推理能力使其能够理解代码逻辑,提供智能建议,极大地提升开发效率和代码质量。

- 编程教育智能化:在编程教育中,Nemotron Nano 2可以作为智能辅导工具,提供实时的代码示例和详细解释,帮助初学者更好地理解编程语言的语法、算法原理和数据结构。它还能根据学生的学习进度和错误,提供个性化的学习路径和反馈。

- 客户服务体验升级:在客户服务领域,Nemotron Nano 2可以作为多语言聊天机器人,处理复杂的客户查询,提供高效且准确的客户支持。其长上下文和推理能力使其能够理解多轮对话的上下文,提供更连贯和个性化的服务体验,同时也能辅助人工客服提升效率。

NVIDIA Nemotron Nano 2的推出,标志着AI模型在推理效率和部署灵活性方面迈出了重要一步。其混合架构、卓越性能以及对长上下文和可控推理的支持,预示着AI技术将更加深入地融入各类应用场景,为边缘计算、设备端AI以及资源受限环境下的智能应用开发带来新的机遇。随着开源社区的积极参与和模型的持续迭代,Nemotron Nano 2有望进一步推动高效、普惠的AI解决方案的普及与发展,引领智能时代的新篇章。