人工智能个性化浪潮下的隐私新范式:深度解析Google Gemini的数据策略

随着人工智能技术以前所未有的速度融入我们生活的方方面面,AI模型与用户数据的交互方式正成为焦点。Google Gemini作为当前最具影响力的大型语言模型之一,近期对其数据处理策略进行了重要调整,这些变化不仅旨在提升AI的个性化服务能力,也对用户的数字隐私提出了新的考量。理解这些变化,以及如何有效地管理个人数据在AI系统中的流动,对于每一位AI用户而言都至关重要。

个性化上下文:双刃剑下的AI记忆

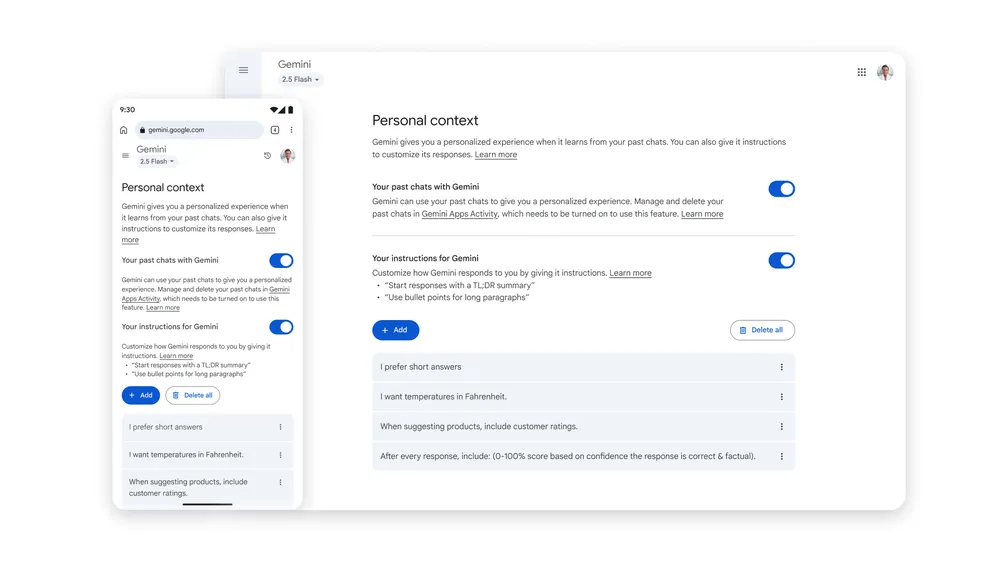

Google Gemini此次更新的核心之一是引入了“个性化上下文”(Personal Context)功能。此项功能旨在让Gemini能够“记住”用户在过去对话中的具体细节,从而在后续交互中提供更具相关性和连贯性的回应。例如,当你寻求推荐时,Gemini可能会基于你此前的兴趣表达或偏好,给出更精准的建议,这无疑提升了用户体验的流畅度与实用性。

然而,这种增强的“记忆力”并非没有代价。AI模型若过度沉浸于用户提供的信息,可能在无意中形成一种“信息茧房”,即只强化用户已有的观点或偏好,限制了新信息的获取和认知拓展。此外,当AI系统被赋予过度的“个性化”或“情感化”特征时,用户可能更容易对其产生过度的信任,甚至导致对AI输出内容的批判性思维减弱,这在某些情况下可能引发误判或认知偏差。这种风险尤其需要被谨慎评估和管理,以确保AI的辅助作用是积极而非引导性的。

此功能最初将在Gemini 2.5 Pro模型上推出,并受限于部分区域(欧盟、英国和瑞士除外)及18岁以上用户。这表明Google在推广此类深度个性化功能时,仍在审慎评估其在全球不同隐私法规环境下的合规性与用户接受度。值得注意的是,“个性化上下文”与此前已有的“已保存指令”功能不同,后者是用户主动设定的明确指令,而前者则是一种更深层次、更隐性的基于对话历史的学习机制。

临时聊天:为隐私保驾护航的“隐身模式”

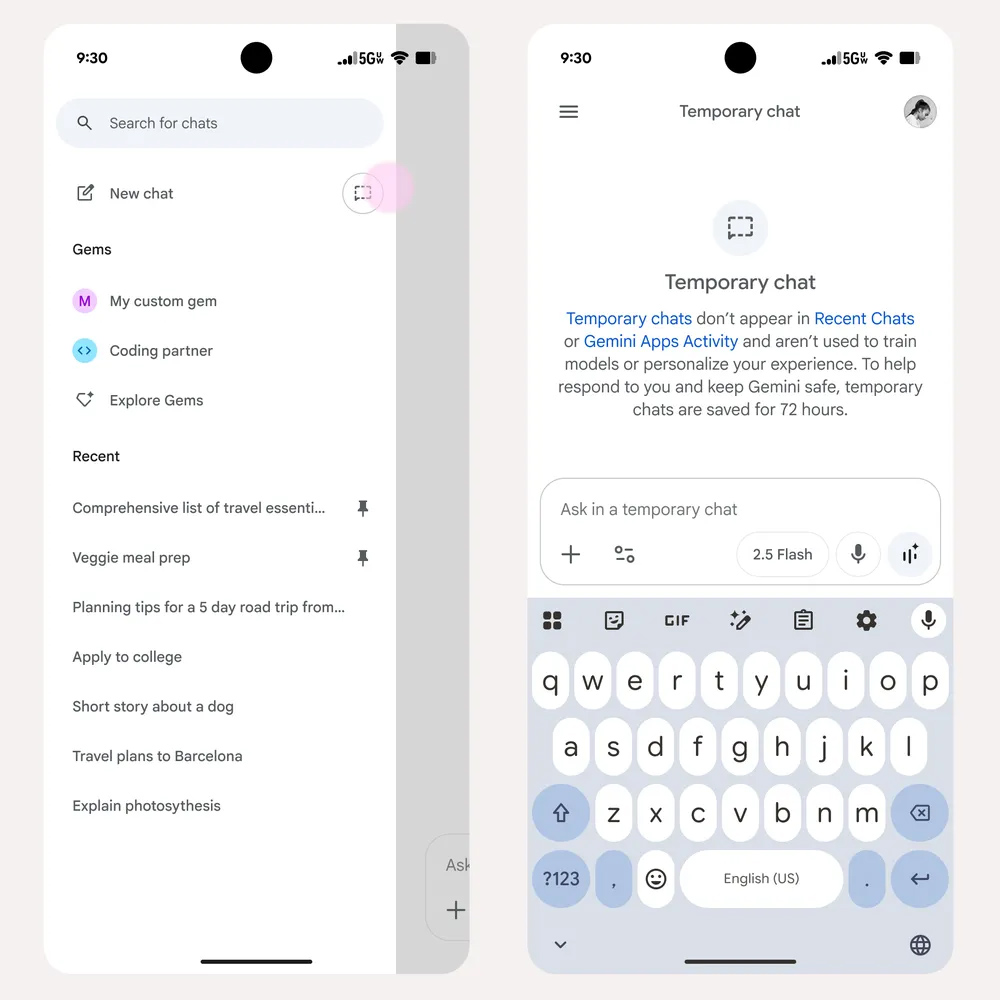

为了平衡个性化与隐私保护之间的关系,Google同步推出了“临时聊天”(Temporary Chats)选项。这一功能相当于Gemini的“隐身模式”,用户在此模式下进行的所有对话内容,都不会被用于构建个性化上下文,也不会影响Gemini对用户的“记忆”或训练模型。这为用户提供了一个安全港,可以在不留下任何长期痕迹的情况下,就敏感或私密话题与AI进行交流。

尽管被标记为“临时”,但这些对话并非即时消失。Google表示,临时聊天内容将在服务器上保留72小时,以便用户在短时间内回顾或继续此前的对话。这一设计既兼顾了用户可能需要临时回顾的需求,又确保了对话内容不会被长期存储和用于个性化训练。对于那些对数据隐私高度敏感的用户,或是需要讨论临时性、非持久性信息的用户而言,临时聊天提供了一个非常有价值的选项。

数据训练新规:用户活动成为模型养分

更为广泛且深远的影响是,Google已确认自2025年9月2日起,将更改其使用Gemini用户上传内容的方式。届时,用户的聊天内容和上传数据(包括文件上传)的样本将被用于训练Google的AI模型,以“改善谷歌服务”。这意味着,如果用户不主动采取行动,其与Gemini的互动将默认成为AI模型学习和进化的“养料”。

这一默认行为的改变,标志着科技公司在用户数据使用策略上的又一次演进。虽然企业声称是为了提升服务质量和用户体验,但对于用户而言,这意味着需要更积极地参与到个人数据管理的决策中来。此前,许多服务在数据用于模型训练时会采取选择加入(opt-in)策略,而Google此次则转向了选择退出(opt-out)策略,将主动权抛给了用户。

数字主权时代的隐私策略与用户赋能

面对Google Gemini数据策略的这些重大调整,用户拥有明确的选择权来管理自己的数据流向。核心的控制点在于“Gemini应用活动”设置,该设置将更新为“保留活动”(Keep Activity)。用户可以随时暂停此设置,从而阻止其数据被用于AI模型训练。此外,积极利用“临时聊天”功能,也能在进行特定对话时有效规避数据被长期记录和利用的风险。

这些变化不仅是技术层面的更新,更是数字时代用户隐私权和数据主权的一次集中体现。在追求AI智能化的同时,如何确保用户的隐私不被牺牲,成为摆在科技公司、监管机构和用户面前的共同挑战。用户需要培养更强的数字素养,主动了解并管理自己的隐私设置,而非被动接受默认条款。

一个负责任的AI生态系统,应在提供强大功能的同时,充分尊重并保障用户的数据隐私。这需要AI开发商在透明度上做得更好,清晰地告知用户数据的使用方式和目的;在可控性上提供更灵活的选项,让用户能够真正掌握自己的数据;在伦理上坚持底线,避免数据滥用和潜在的社会风险。用户作为数据的主体,也应积极行使其数字权利,通过选择和反馈,共同塑造一个更加平衡和健康的AI未来。