深度伪造(Deepfake)技术,尤其在语音克隆领域的飞速发展,正将传统的网络诈骗推向一个前所未有的复杂高度。过往的“钓鱼”和“短信诈骗”已令人防不胜防,而今,利用人工智能克隆出的亲友或同事的声音,以“紧急”事务为由诱骗受害者转账、泄露敏感信息或访问恶意网站的“声纹诈骗”(Vishing),正成为数字世界中最具迷惑性的威胁之一。这种新型攻击因其高度的仿真度和情感冲击力,使得受害者在瞬间难以辨别真伪,从而导致严重损失。

多年来,研究人员和政府机构持续对深度伪造的威胁发出警告。例如,美国网络安全和基础设施安全局(CISA)在2023年就指出,来自深度伪造及其他合成媒体的威胁呈现“指数级增长”。谷歌的Mandiant安全部门也报告,此类攻击正以“令人毛骨悚骨的精确度”执行,制造出远比以往更加逼真的诈骗场景。这不仅是对个人财产的威胁,更是对企业组织信任机制的严峻考验。

深度伪造声纹诈骗的运作机制揭秘

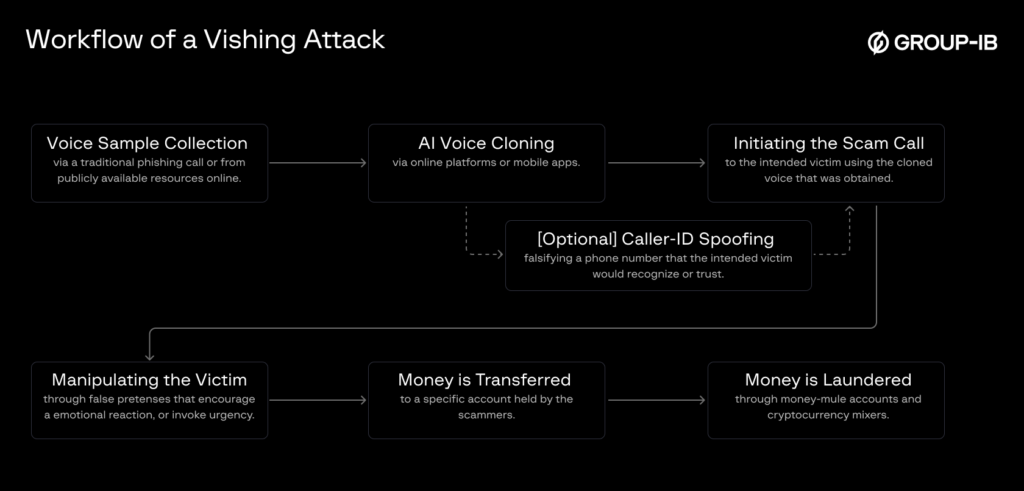

声纹诈骗的核心在于利用AI技术模拟特定个体的声音特征,从而在电话沟通中建立虚假的信任。安全公司Group-IB曾详细剖析了这类攻击的基本步骤,其关键在于实现规模化复制且难以被检测或有效阻止。其基本流程可以概括为以下几个关键环节:

语音样本的收集与预处理:攻击者首先需要获取被模仿对象的语音样本。这些样本来源广泛,可能包括公开的视频、在线会议录音,甚至是过去的通话记录。令人震惊的是,有时短短三秒钟的音频就足以供AI模型学习和克隆。这凸显了在数字时代保护个人语音信息的难度和重要性。对语音数据的持续挖掘,为攻击者提供了源源不断的“素材库”。

AI语音合成技术的应用:获取样本后,攻击者会将这些语音数据输入到基于人工智能的语音合成引擎中。目前市面上有多种成熟的AI模型和商业服务可供选择,如谷歌的Tacotron 2、微软的Vall-E,以及像ElevenLabs和Resemble AI这样的商业平台。这些引擎能够将输入的文本转化为模仿目标人物音色、语调甚至口头禅的语音。尽管多数服务明文禁止将技术用于非法深度伪造,但根据消费者报告在2025年3月的调查发现,这些公司为阻止滥用而设置的防护措施,有时仅需最低限度的努力即可绕过。这暴露出AI技术在快速发展过程中,伦理与安全规范滞后于技术进步的困境。

可选的增强步骤:号码欺骗:为了进一步增强诈骗的可信度,攻击者通常会采取“号码欺骗”(Caller ID Spoofing)技术,即将呼叫显示为被模仿者或其所属组织的电话号码。这种技术已存在数十年,但与深度伪造语音结合时,其欺骗性会指数级上升。当受害者看到熟悉的来电号码,同时听到熟悉的声音时,其警惕性会大幅下降,为诈骗的成功创造了有利条件。

发起诈骗电话与实时互动:完成上述准备后,攻击者便会发起诈骗电话。在一些相对简单的攻击中,克隆语音会按照预设的脚本进行播放。然而,更高级的攻击会采用实时语音伪装或转换软件,这意味着攻击者可以根据受害者的提问进行实时应答。这种实时交互能力极大地提升了诈骗的逼真度,因为受害者提出的任何怀疑或反问都能得到即时回应,从而使其更难察觉出异常。Group-IB指出,尽管目前野外实时深度伪造声纹诈骗仍然有限,但考虑到处理速度和模型效率的持续进步,预计未来实时应用将变得越来越普遍。

构建紧急情景并诱导行动:无论是预设脚本还是实时交互,攻击者都会为受害者编织一个紧急且看似合理的情景,促使其立即采取行动。常见的诈骗叙事包括:

- 冒充孙辈身陷囹圄,急需保释金;

- 冒充CEO指令财务部门紧急电汇款项,以支付即将逾期的费用;

- 冒充IT人员要求员工重置密码,声称发生了数据泄露。 这些情景往往利用了人类的同情心、对权威的服从以及对潜在损失的恐惧心理,通过制造时间紧迫感,剥夺受害者冷静思考和核实信息的机会。

收集非法所得:一旦受害者被成功诱导采取行动,无论是转账、泄露凭证还是其他资产,这些行为往往是不可逆转的。金钱一旦汇出,追回极其困难;敏感信息一旦泄露,可能导致后续更严重的网络攻击或身份盗窃。整个链条环环相扣,使得这种新型诈骗的危害性远超传统形式。

防线洞穿:模拟攻击案例深度剖析

谷歌Mandiant团队曾进行了一次模拟红队演练,旨在测试企业防御能力并培训安全人员。该演练充分展示了AI声纹诈骗的相对便捷性。红队成员首先收集了目标组织内部某位高级管理人员的公开语音样本,该高管有下属员工直接向其汇报。随后,利用公开信息识别出最可能直接受该高管领导的员工,并对其发起电话攻击。

为了使诈骗电话更具说服力,攻击者利用了当时正在发生的一次真实VPN服务中断作为借口,要求员工立即采取行动。演练结果令人警醒:“由于对电话中声音的信任,受害者绕过了Microsoft Edge和Windows Defender SmartScreen的安全提示,在不知情的情况下下载并执行了预先准备好的恶意负载到其工作站。”恶意负载的成功执行标志着演练的完成,充分揭示了AI声纹欺骗在攻破组织防御方面的惊人便捷性。

这个案例不仅说明了技术的强大,更暴露了人类在面对高仿真社会工程攻击时的脆弱性。即使有技术防护措施,一旦受害者被情感或权威所操控,这些防护也可能被轻易绕过。这强调了在技术防御之外,加强人员安全意识培训的重要性。

抵御智能声纹诈骗:多维度防范策略

面对日益复杂的AI声纹诈骗威胁,个人和组织需要建立多层次、多维度的防御体系。单一的技术或流程都难以彻底阻断这类攻击,唯有综合施策,方能有效提升抵御能力。

1. 技术层面强化防御:

- 多因素认证(MFA)的普及与强制:对于任何涉及资金转移、敏感信息访问或密码重置的关键操作,务必强制要求多因素认证。即使攻击者成功克隆了声音,没有第二重验证(如手机验证码、生物识别等),也难以得逞。

- AI驱动的通话分析工具:开发或部署能够实时分析通话语音异常的AI系统。这些系统可以识别出非自然语调、重复短语模式或与已知目标声音细微差异的特征,从而在诈骗初期发出警报。

- 安全通信渠道的推广:对于涉及关键指令或财务操作的请求,应强制使用预先设定的安全通信渠道,例如企业内部加密聊天工具,或要求面对面确认,而非依赖于电话。

2. 组织层面策略部署:

- 建立严格的内部验证协议:这是最直接也最有效的防范措施之一。组织内部应明确规定,任何通过电话发出的敏感指令(尤其是涉及资金流向或账户权限的),必须通过第二种已知且安全的方式进行独立验证。例如,可以设定一个“秘密词”或“安全短语”,要求来电者在提出关键请求前必须提供;或者要求接听者挂断电话后,通过官方已知号码回拨来电者进行二次确认。理想情况下,应同时采纳“秘密词”和“回拨验证”两种方式,以最大程度地降低风险。

- 持续的网络安全意识培训:定期为员工提供关于社会工程学、深度伪造威胁以及最新诈骗手法的培训。通过模拟演练、案例分析和互动讨论,提升员工识别诈骗的能力和警惕性。强调在面对紧急且不寻常的请求时,保持冷静并严格遵守验证流程的重要性。

- 建立深度伪造事件响应机制:组织应预先制定针对深度伪造攻击的事件响应计划。明确一旦员工发现或怀疑自己遭遇声纹诈骗时,应如何报告、如何止损、以及如何进行事后调查和补救。

3. 个人层面提升警惕性:

- 保持高度怀疑态度:面对任何声称紧急、要求立即行动且涉及资金或敏感信息的电话,即便声音再熟悉,也要保持高度怀疑。问自己:“这听起来像真的吗?是否符合TA平时的行事风格?”

- 主动进行身份核实:不要被电话中的紧急气氛所迷惑。应立即结束通话,然后通过已知的、可靠的联系方式(如对方的办公室座机、通过公司内部通讯录查找的手机号、或面对面交流)主动回拨给对方进行核实。切勿回拨诈骗电话中提供的号码。

- 管理个人信息暴露风险:警惕在社交媒体或其他公开平台上过度分享个人语音、视频或详细的生活信息,这些都可能成为攻击者获取语音样本和进行背景调查的素材。

- 认识到疲劳和压力下的脆弱性:当个人处于疲劳、压力大或情绪不佳的状态时,判断力会下降,更容易落入社会工程陷阱。因此,在这种状态下接到紧急电话时,更要格外警惕,并强制自己进行核实。

未来展望与持续挑战

随着人工智能技术的不断迭代和普及,深度伪造的生成质量将越来越高,制作成本将持续降低,这无疑将使声纹诈骗的威胁变得更为普遍和隐蔽。未来的挑战在于,防御方必须在技术、策略和人员意识培训上进行持续的投入和创新,以应对攻击者不断演进的手段。一场关于智能攻防的“军备竞赛”已然开启,唯有不断适应、学习和进化,才能在这场无声的较量中占据主动,保护我们的数字生活和财产安全。