本地部署的AI新纪元:OpenAI开源模型如何重塑企业与个人应用格局

OpenAI近期推出gpt-oss-120b和gpt-oss-20b两款开创性的开源模型,标志着自2019年GPT-2发布以来,该公司首次回归“开放”策略的核心。这一举措颠覆了此前业界普遍认为其将全面转向闭源云服务的预期。gpt-oss系列模型并非为了取代现有的GPT云端API,而是旨在赋能用户在本地硬件上运行强大的AI能力,开启了人工智能部署的新篇章,特别是在数据安全、低延迟及高度定制化需求日益增长的背景下,其战略意义不容小觑。

技术架构与效率突破:混合专家模型与链式思考

gpt-oss系列模型的发布,展现了OpenAI在模型架构优化上的深厚实力。这两款模型均基于Transformer架构,并创造性地引入了“混合专家”(Mixture-of-Experts, MoE)技术。MoE架构使得模型虽然拥有庞大的总参数量,但在每次推理时仅激活其中一部分专家网络,从而大幅降低了实际所需的计算资源和内存占用。

- gpt-oss-20b:总参数量为210亿,通过MoE技术,每次处理Token时仅需激活36亿参数。这使得该模型能够在配备16GB或更多内存的消费级机器上流畅运行,极大地降低了个人开发者和小型团队部署高性能AI的门槛。

- gpt-oss-120b:拥有惊人的1170亿总参数量,得益于MoE,每次Token处理的激活参数量仅为51亿。尽管其对内存的要求达到80GB,通常需要专业级AI加速卡如Nvidia H100来支持,但相比于完整运行千亿级参数模型所需的巨大资源,这无疑是一项显著的效率提升。它在单个专业级AI加速GPU上的可行性,使其成为企业级本地部署的理想选择。

此外,gpt-oss模型还支持可配置的“链式思考”(Chain of Thought, CoT)功能,用户可以通过简单的系统指令调整CoT的级别(低、中、高)。较低的CoT设置可以实现更快的推理速度和更低的资源消耗,而较高的设置则能产出质量更优、逻辑更复杂的输出,为不同应用场景提供了灵活的性能与质量权衡选项。两款模型均具备128,000Token的超大上下文窗口,确保了处理长文本和复杂对话任务时的连贯性和深度。

性能基准与应用潜力分析

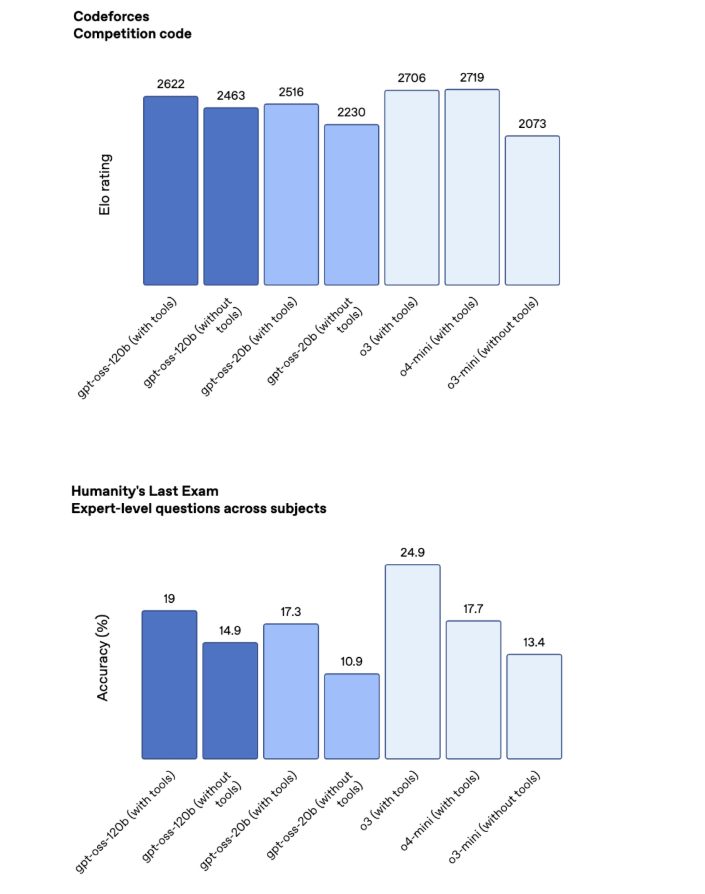

OpenAI对gpt-oss系列模型的性能充满信心,声称其在多个测试中表现出接近甚至媲美领先云端专有模型的实力。通过公开的基准测试数据,我们可以清晰地看到gpt-oss-120b模型在多数场景下,性能介于OpenAI自家的o3和o4-mini专有模型之间,尤其在数学和编程任务上展现出强大的能力。这表明它在处理结构化数据、执行复杂逻辑推理方面的潜力。

然而,在“人类终极考试”(Humanity's Last Exam)这类更侧重于通用知识和理解的测试中,尽管有工具辅助,gpt-oss-120b(19%)仍与o3(24.9%)及Google的Gemini Deep Think(34.8%)存在一定差距。这反映出开源模型在某些需要广泛世界知识和深度语义理解的领域,可能仍需进一步的优化和训练。但考虑到其本地部署的特性以及Apache 2.0的开放许可证,开发者完全可以通过领域特定的微调和私有数据集的注入,弥补这些不足,甚至在特定行业应用中超越通用模型的表现。

这些模型目前仅支持文本模态,这意味着它们无法开箱即用地处理图像、音频等多种数据类型。然而,这并非不可逾越的障碍。通过与其他模态处理工具的集成,或者未来社区的拓展与开发,gpt-oss模型有望构建起更加丰富的多模态应用生态。

本地化部署的深层考量:安全、定制与混合AI策略

OpenAI深知,尽管其云端模型功能强大,但许多企业和开发者出于特定的业务需求,对本地部署的AI解决方案有着强烈的诉求。这些需求主要集中在以下几个方面:

- 低延迟:对于需要实时响应的应用场景,如语音助手、智能客服、实时内容生成等,本地部署能够显著降低数据传输和处理的延迟,提供更流畅的用户体验。

- 高度定制化:开源模型允许开发者对模型进行深度微调,使其能够完美适应特定行业、特定任务的需求。企业可以利用自身积累的独特数据,训练出具备行业专有知识和技能的AI模型,从而构建出更具竞争力的产品和服务。

- 数据安全与隐私:将敏感或专有数据留在企业内部进行处理,可以最大程度地保障数据安全和隐私合规性。这对于金融、医疗、法律等对数据保密性要求极高的行业尤为重要,避免了数据上传至第三方云服务可能带来的风险。

OpenAI推出gpt-oss系列,正是为了满足这些本地化需求。它使得企业能够在不放弃OpenAI生态系统的前提下,实现端到端的AI解决方案。这意味着,客户可以根据数据敏感度和实时性要求,灵活选择将部分AI任务在本地使用gpt-oss处理,而将另一些需要更强大通用能力或大规模算力的任务通过API调用云端GPT模型,从而构建出兼具效率、安全与成本效益的混合AI部署策略。这种模式将为企业带来前所未有的灵活性和控制力。

开放性与负责任的AI发展:安全防护与伦理考量

作为开放权重模型,gpt-oss系列将遵循Apache 2.0许可证,这意味着开发者拥有极大的自由度来使用、修改和分发这些模型。这种开放性无疑将极大促进AI创新和应用生态的繁荣。然而,随着模型能力的提升,其潜在的误用风险也随之增加。

OpenAI作为AI领域的领导者,对此保持着高度警惕。他们在gpt-oss模型的开发过程中,融入了严格的“审慎对齐”(deliberative alignment)和“指令层级”(instruction hierarchy)等安全机制,旨在从模型底层架构上限制其生成有害或不当内容的能力。为了验证这些安全措施的有效性,OpenAI团队甚至进行了“恶意调优”实验,尝试将模型引导向不良行为。

实验结果表明,即使在有意识的恶意调优下,gpt-oss模型在生成“邪恶”内容方面的质量也未能达到高水平。OpenAI认为,这证明了其在模型设计中嵌入的防护机制能够有效预防严重的滥用行为,符合其“准备框架”(Preparedness Framework)的要求。这一结果为开源AI模型的负责任发展提供了重要的实践案例和信心支撑,表明在推动技术开放的同时,安全和伦理问题并非不可控。

生态共建与未来展望

gpt-oss-120b和gpt-oss-20b模型已通过HuggingFace平台开放下载,同时,OpenAI也在GitHub上提供了相关的代码仓库,并将在其自有基础设施上托管官方版本供用户测试。这一系列举措无疑将极大加速模型的普及和社区的创新。

OpenAI的这一战略转变,不仅仅是发布了两款新模型,更是对AI发展模式的一次深刻思考和实践。它承认了开源社区和本地部署在AI生态系统中的关键作用,并积极探索如何将最先进的AI能力以更普惠、更安全的方式提供给全球用户。未来,我们可以预见,随着更多高性能开源模型的涌现,AI的边界将进一步拓展,在边缘计算、个人助理、智能制造等更多领域实现深度融合与创新。这种开放与协作的精神,将是推动人工智能迈向更广阔未来的核心动力。