英伟达Nemotron Nano 2:革新AI推理效能与长上下文处理的新范式

当前,人工智能领域正经历着前所未有的发展浪潮,大型语言模型(LLMs)的参数量与日俱增,随之而来的是模型推理效率与长上下文处理能力的严峻挑战。如何在有限的计算资源下,实现更快的推理速度、更长的上下文理解以及更高的精度,成为了行业关注的焦点。正是在这样的背景下,英伟达(NVIDIA)推出了一款旨在重新定义高效AI推理的革新性模型——Nemotron Nano 2。

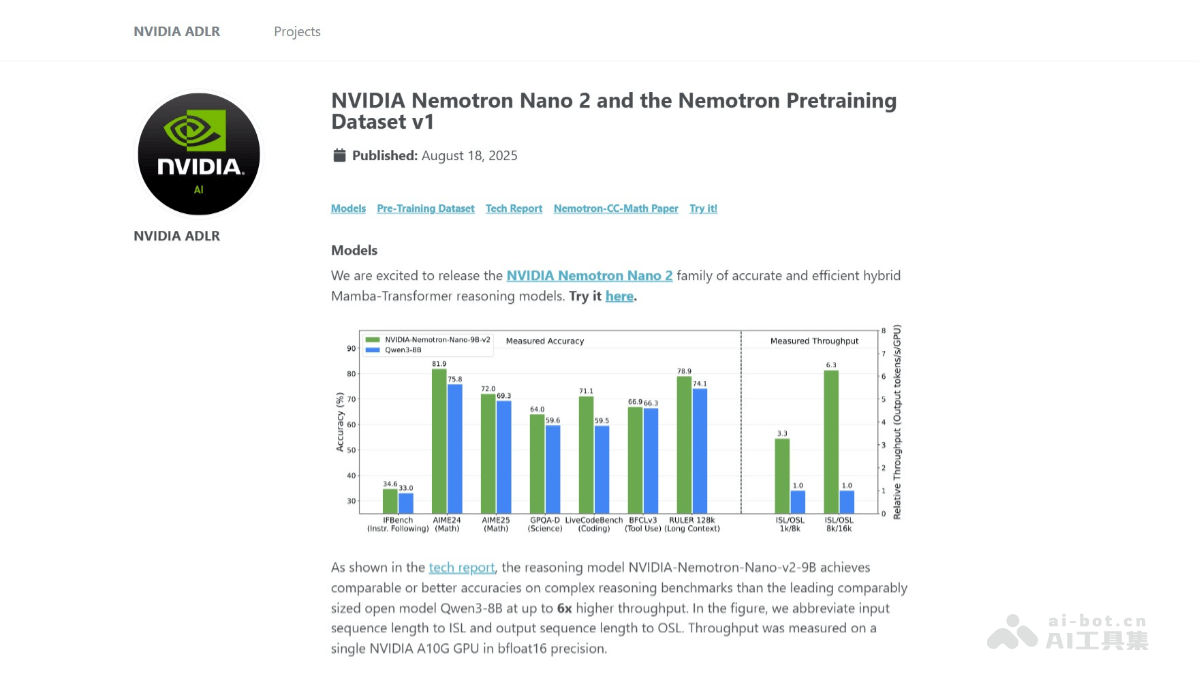

Nemotron Nano 2以其9B的参数规模脱颖而出,其核心亮点在于采用了突破性的混合Mamba-Transformer架构。这一创新设计使得模型在处理复杂推理任务时,能够展现出高达6倍于传统Qwen3-8B模型的吞吐量,同时保持甚至超越其准确性。更值得注意的是,Nemotron Nano 2在20万亿个token的庞大数据集上进行预训练,并支持惊人的128k上下文长度,这意味着它能处理极其庞大且复杂的文本信息流,为AI应用的深度与广度提供了新的可能。

混合Mamba-Transformer架构的深度解析

Nemotron Nano 2的核心竞争力源于其独树一帜的混合Mamba-Transformer架构。传统Transformer模型在处理长序列时,自注意力机制的计算复杂度呈平方级增长,这严重限制了其在长上下文场景下的效率。为了克服这一瓶颈,Nemotron Nano 2创造性地用Mamba-2层替代了Transformer中的大部分自注意力层。Mamba-2是一种状态空间模型,以其线性复杂度在处理长序列时展现出卓越的效率和速度,尤其适用于生成连贯、冗长的推理链。

然而,模型并非完全抛弃了Transformer的优势。部分自注意力层被策略性地保留下来,以维持Transformer架构在特定任务上的灵活性和强大的表征学习能力。这种巧妙的融合使得Nemotron Nano 2能够兼顾速度与精度,在保持高吞吐量的同时,确保模型在复杂任务中的准确性不受影响。通过这种混合设计,英伟达有效地平衡了计算效率和模型性能,为新一代AI模型的架构设计提供了宝贵的启示。

精益求精的预训练与后训练策略

Nemotron Nano 2的卓越性能并非偶然,而是英伟达在模型预训练与后训练阶段投入巨大资源与精妙策略的结晶。模型在高达20万亿个token的庞大数据集上进行了预训练,这一规模确保了其具备了广泛的知识储备和强大的泛化能力。在训练过程中,采用了先进的FP8精度计算和Warmup-Stable-Decay学习率调度方案,这些技术协同作用,极大地提升了训练效率和模型的收敛速度。更值得称道的是,Nemotron Nano 2通过持续的预训练长上下文扩展阶段,成功地将其上下文长度扩展至128k,且在这一过程中,并未牺牲模型在其他基准测试上的性能,展现了其在处理超长文本方面的强大鲁棒性。

模型的后训练优化同样功不可没。首先,通过监督微调(SFT),模型被精准地调优以提升其在特定下游任务上的表现,确保了指令遵循和响应质量。其次,策略优化(Policy Optimization)进一步强化了模型的指令遵循能力,使其能够更准确地理解和执行用户意图。最后,通过人类反馈强化学习(RLHF),Nemotron Nano 2被引导以更好地符合人类的偏好和价值观,使得生成内容更加自然、有益且安全,从而提升了用户体验。这些多层次的优化策略共同铸就了Nemotron Nano 2在实际应用中的优异表现。

突破性的模型压缩与推理预算控制

为了将高性能模型带入更广泛的应用场景,模型压缩是不可或缺的一环。Nemotron Nano 2在这一方面也取得了显著进展。通过运用剪枝(Pruning)和知识蒸馏(Knowledge Distillation)等先进技术,英伟达成功地将一个12B参数的基础模型压缩至9B参数,同时几乎没有损失其核心性能。这种精巧的压缩技术使得Nemotron Nano 2能够轻松部署在单个NVIDIA A10G GPU上,并支持128k token的上下文推理。这不仅显著降低了推理成本和硬件门槛,也为边缘计算和设备端AI应用提供了更多可能性,极大地拓宽了模型的部署范围。

Nemotron Nano 2还引入了一项独特且实用的功能——推理预算控制。基于截断训练(Truncation Training),该模型能够根据用户指定的“思考”预算进行推理。这意味着用户可以灵活控制模型在生成最终答案前进行“思考”或生成推理过程的token数量。例如,在需要快速响应的场景下,可以直接跳过中间推理步骤,直接获取最终答案;而在需要详细解释或审计的场景下,则可以要求模型展现完整的推理链。这项功能赋予了用户前所未有的控制力,不仅优化了计算资源的使用,也增强了AI决策过程的透明度和可解释性,对于对AI行为可控性有高要求的专业领域尤其重要。

广泛且深远的行业应用前景

Nemotron Nano 2凭借其独特的架构和强大的功能,展现出在多个行业领域中革新现有工作流程的巨大潜力:

教育领域: Nemotron Nano 2能够作为高级智能辅导系统,帮助学生解决复杂的数学、物理或化学问题。其逐步推理(reasoning trace)的能力,可以详细解释解题过程中的每一个步骤和公式原理,将抽象的概念具象化,从而显著提升学生的理解和学习效率。例如,在面对一道复杂的微积分题目时,模型不仅给出答案,更能逐步推导,指出关键的公式运用和逻辑转换,如同一个耐心且专业的私人教师。

学术研究: 对于研究人员而言,Nemotron Nano 2能够极大地加速知识探索和论文撰写。它能帮助研究人员梳理海量的文献资料,生成详细的实验设计方案,甚至辅助进行数据分析和假设生成。例如,在医学研究中,模型可以根据最新的研究进展,结合病理数据,生成潜在的治疗方案或药物靶点分析报告,为科研提供新的思路。

软件开发与编程教育: 在软件开发流程中,Nemotron Nano 2可生成高质量、高效率的代码片段,甚至能协助代码重构和优化,大幅提升开发效率。在编程教育中,模型可以根据学生的疑问,提供多语言的代码示例和深入的解释,帮助初学者更好地掌握编程语言的语法、算法逻辑和设计模式,例如为特定的编程问题提供多种实现方式的对比分析。

客户服务与智能交互: Nemotron Nano 2的多语言能力使其成为理想的全球客户服务解决方案。作为高效且准确的智能聊天机器人,它能处理复杂的客户咨询,提供个性化的解决方案,并能通过理解用户上下文和意图,实现更自然、流畅的多轮对话。例如,面对一个涉及产品故障排除的复杂咨询,模型可以引导客户一步步诊断问题,甚至提供基于其使用历史的个性化解决方案,显著提升客户满意度。

法律与金融: Nemotron Nano 2的长上下文处理能力在处理法律合同、财务报表等复杂文档时具有天然优势。它可以快速识别关键条款、分析风险,甚至生成初步的法律意见或财务分析报告,极大提升专业服务效率。

展望:高效AI推理的未来图景

英伟达Nemotron Nano 2的推出,不仅仅是一个参数为9B的AI模型,更是英伟达在推动AI民主化和高性能计算普惠化道路上的一个重要里程碑。它通过融合最前沿的架构创新、大规模的预训练数据以及精细的优化策略,有效地解决了当前大型语言模型面临的效率与成本挑战。

这一模型预示着AI推理将变得更加高效、经济且普及,无论是云端大规模部署还是边缘设备上的轻量级运行,Nemotron Nano 2都提供了强大的支持。随着更多开发者和研究人员基于其开源的基础模型和预训练数据集进行创新,我们可以预见,Nemotron Nano 2将不仅驱动AI应用在现有领域的深度发展,更将催生出全新的、过去因计算或成本限制而无法实现的应用场景,共同描绘人工智能未来发展的新篇章。