AI Agent的里程碑:智谱AutoGLM 2.0重塑人机协作新范式

近年来,人工智能(AI)在各个领域展现出颠覆性潜力,尤其在自动化任务执行方面,AI Agent正逐步从概念走向实践。然而,传统AI Agent在手机等移动设备上的应用,长期面临“抢屏”操作的固有局限,即AI执行任务时,用户无法同时进行其他操作,导致整体效率提升有限。智谱科技于近期发布了AutoGLM 2.0版本,其核心创新在于引入云端原生Agent架构,彻底解决了这一瓶颈,标志着AI Agent发展进入了一个全新的异步并行阶段。此举不仅将人机协作模式从同步的“你盯着我干”升级为异步的“你忙你的,我干我的”,更为构建由智能体驱动的并行数字世界奠定了坚实基础。

一、突破“抢屏”桎梏:云端分身的战略抉择

过往的AI Agent实现方式,无论是在AutoGLM的早期迭代中,还是其他市场先行者,普遍采用在用户本地设备上实时模拟操作的模式。这种“抢屏”机制带来了多重效率与体验挑战:

- 效率瓶颈:当AI Agent执行复杂任务时,用户本地屏幕被完全占用,无法并行处理其他事务。这种人机互斥的关系,使得AI带来的效率增益被限制在一个较低的水平,远未能实现生产力的指数级跃升。

- 任务中断风险:手机锁屏、网络波动、应用切换乃至其他用户操作,都可能导致AI Agent的长流程任务意外中断。这使得AI难以在用户非关注时段(如夜间休息或娱乐时)持续工作,其潜在价值大打折扣。

- 适配性难题:安卓生态的碎片化特性,使得本地Agent的适配成本居高不下。不同手机品牌、系统版本之间的差异,往往严重影响Agent的稳定运行与泛化能力。

AutoGLM 2.0的解决方案是划时代的,它以“云端原生”取代了传统的“本地镜像”。具体而言,AutoGLM为每位用户在云端部署了一个完整的安卓操作系统环境(即云手机)以及一个Linux操作系统环境(未来将支持Windows)。当用户发出指令,例如“在美团App上预订20杯附近的奶茶,并确保使用所有可用优惠券”,整个任务流程——包括打开应用、跳过广告、搜索店铺、选择商品、批量增加数量,直至智能匹配优惠券——都将在云端的专属环境中独立完成。用户本地设备则完全不受影响,可以自由地进行社交、娱乐或将手机息屏。AI Agent的工作与用户的本地操作实现了物理层面的完全解耦,用户只需在任务列表中实时查看进度,并在支付确认、信息发布等关键环节进行授权或介入。这种模式极大地提升了用户体验与整体效率。

二、多场景实践:验证与优化并行

在智谱的内部交流会上,产品负责人刘潇曾生动演示了AutoGLM 2.0的核心能力。他通过一部iPhone向AutoGLM下达指令,要求其完成一项小红书运营任务:“制作并发布一段介绍AutoGLM的视频,风格需贴合自媒体传播特性。”在云端,Agent随即展开了高效工作:高并发地检索数十个相关关键词、快速浏览多个网页以收集信息、撰写文案,并自动启动视频制作流程。值得注意的是,在Agent执行上述任务的同时,刘潇还能够在云手机上同步演示点奶茶和“在抖音刷到小猫视频为止”的娱乐任务,充分展现了云端并行作业的强大优势。

官方数据显示,AutoGLM目前已能高效操作包括抖音、小红书、美团、京东在内的逾40款高频移动应用,覆盖了用户日常生活的诸多场景。

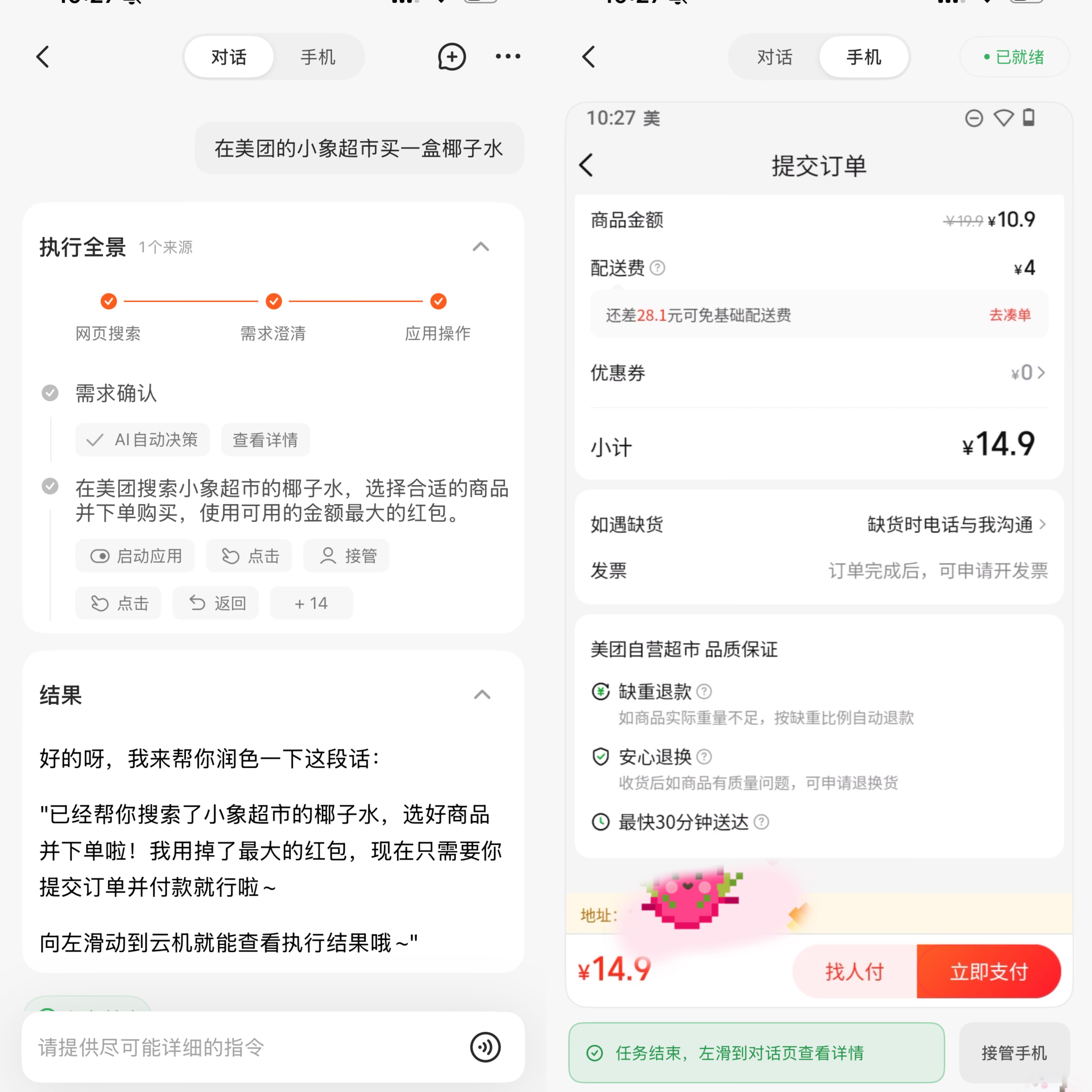

在实际测试中,使用AutoGLM在美团小象超市购买椰子水,任务启动前确实需要用户手动接管云机、登录相关App账号,并在支付环节进行确认。但在这些前置和关键步骤之外,Agent能够实现自动操作,甚至会根据用户指令智能润色需求,如自动添加“用掉红包”等操作。尽管目前在某些场景下,任务执行速度仍有提升空间,甚至可能不如手动操作快捷,但这体现了Agent在理解和执行复杂指令方面的初步能力。

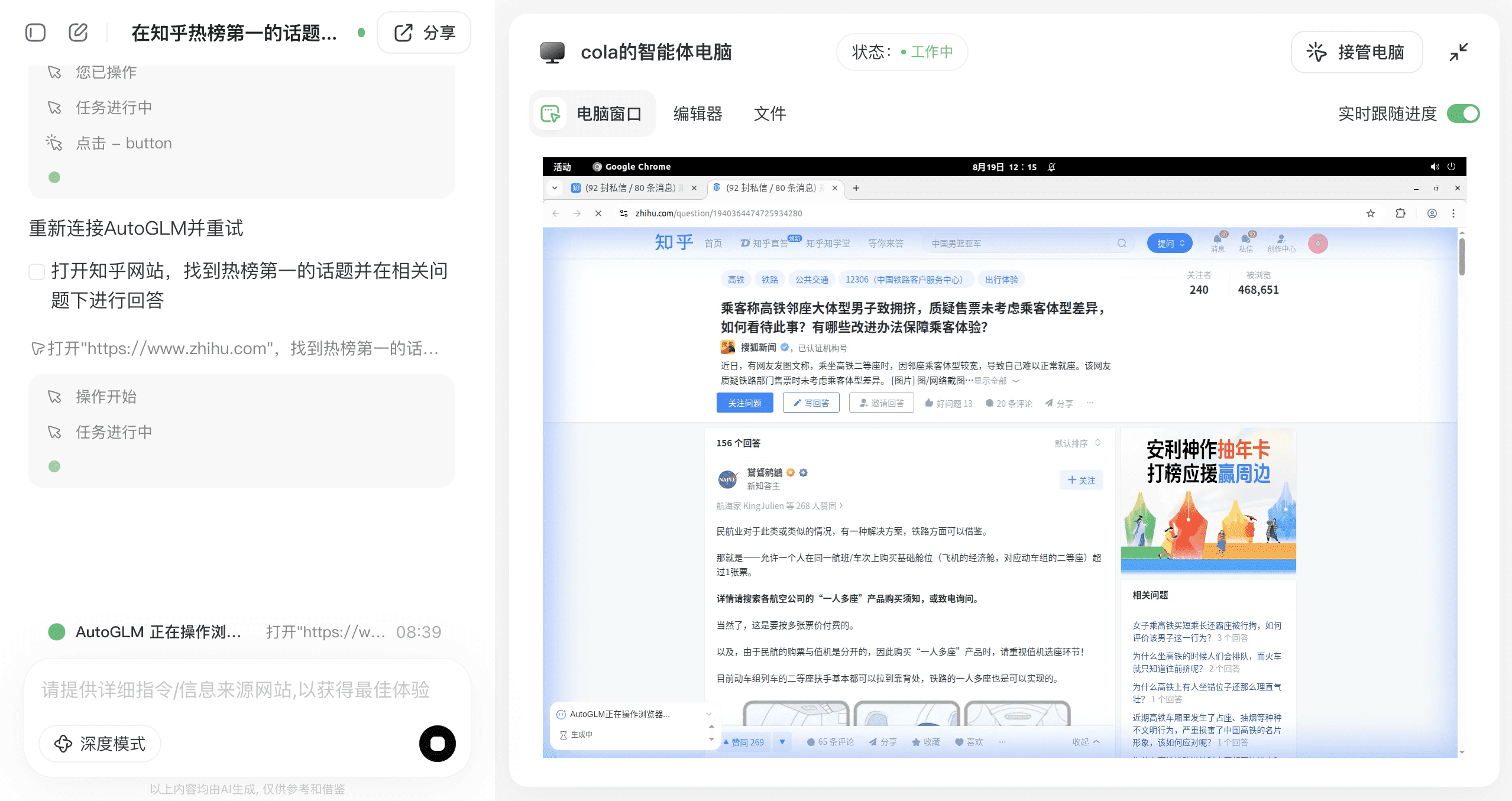

进一步在桌面端测试“在知乎热榜第一的话题下回答问题”的任务时,早期尝试曾因确认点未及时响应而导致任务自动重启。这说明当前Agent在处理具有用户交互确认点的任务时,仍需用户适时介入。在手动确认后,Agent的执行日志清晰地展示了其操作流程:打开知乎、识别热榜第一话题、进入详情页,并提示已准备好回答功能。然而,初次尝试并未直接生成并发布回答,而是停留在回答界面,这可能意味着初始指令的粒度不够精细。

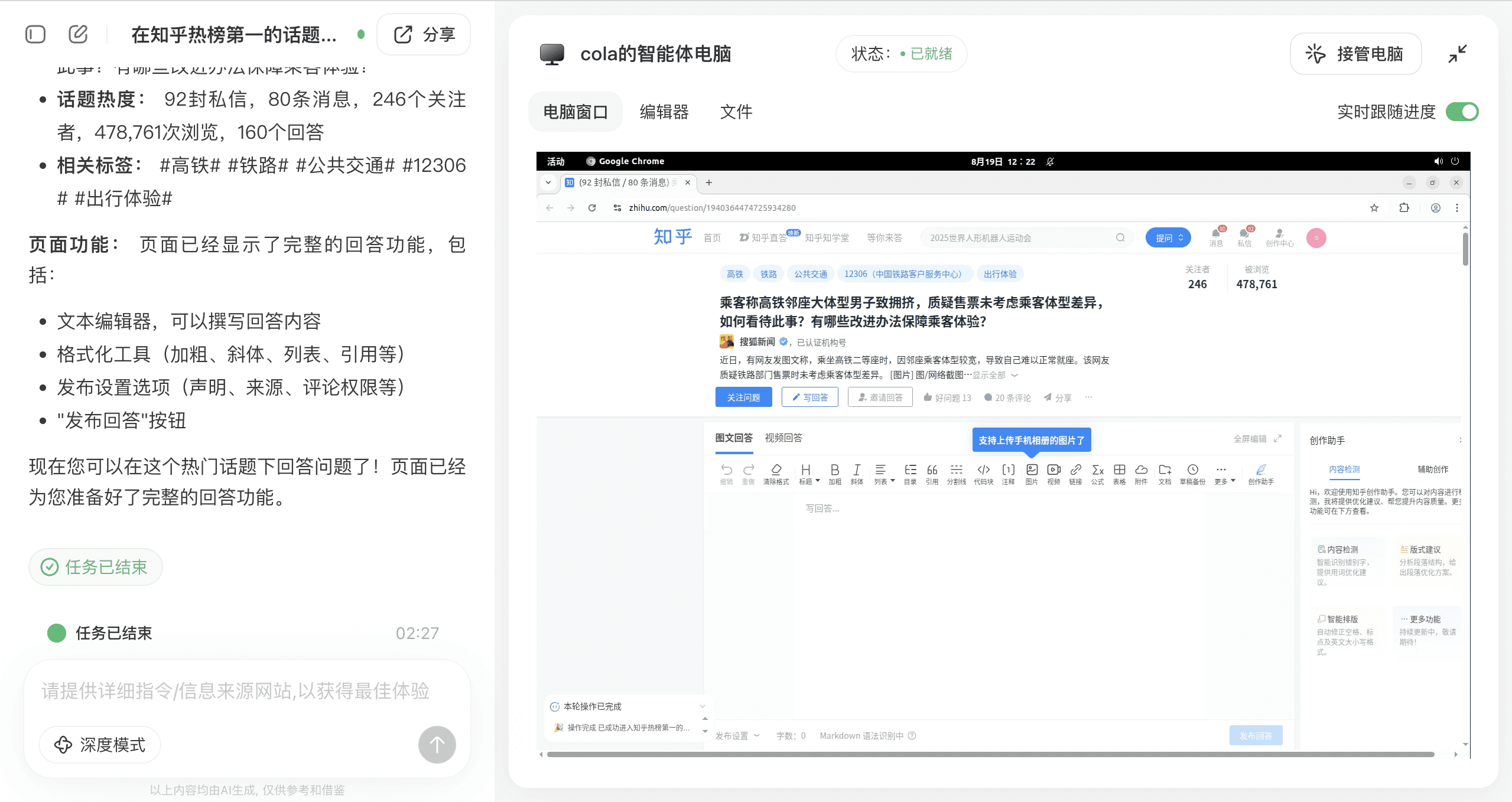

针对这一情况,优化指令为“找到知乎热榜第一的话题,并针对问题写200字的回答,写完之后直接发布”后,Agent成功生成了一段200字的回答内容。尽管由于系统连接限制,最终的发布仍需用户手动点击确认,但Agent在内容生成和部分自动化操作方面的能力已得到验证。

生成的回答内容体现了Agent对复杂社会议题的理解和分析能力,例如针对高铁邻座体型差异问题,Agent能够从公共服务精细化、购票系统优化、多座服务模式、列车工作人员介入以及社会理解等多个维度给出建议,并展望制度创新和技术改进对实现效率、公平和个体需求平衡的重要性。

三、Agent核心驱动力:3A原则与在线强化学习

如果说“云手机/云电脑”为AutoGLM 2.0提供了全新的“躯体”,那么其背后先进的模型、创新的训练方法论和严谨的产品原则,则是驱动这具躯体高效运转的“大脑”与“灵魂”。智谱团队将AutoGLM的产品哲学提炼为“3A原则”,这三项原则共同定义了一个成熟Agent的理想形态:

- Around-the-clock (全时):AI Agent必须能够全天候(24小时)待命并持续执行任务,无论用户处于何种状态(工作、睡眠或娱乐),AI都应在云端持续创造价值,实现时间维度的最大化利用。

- Autonomy without interference (自运转、零干扰):亦称Asynchronous(异步)。其核心在于Agent在云端设备的独立运行,完全不占用用户的本地屏幕和计算资源。这确保了人与AI的并行工作能力,实现真正意义上的互不干扰。

- Affinity (全域连接):Agent的能力不应局限于单一的浏览器对话框或特定应用,而是必须能够无缝连接手机、电脑、智能手表、AR/VR眼镜等多种智能设备与服务,全面打通数字世界与物理世界之间的鸿沟。

这三大原则不仅指导了AutoGLM的产品架构设计,也深刻反映了其对未来人机协作关系的前瞻性洞察。智谱CEO张鹏曾指出,未来个人竞争力的核心将是“自身能力 + N个AI智能体”的总和。每个人都将从传统的“打工者”角色转变为“领导者”,核心竞争力不再是事必躬亲地执行具体任务,而是高效的“沟通、安排任务和指挥”能力。AutoGLM的云端架构正是这一理念的产品化落地,它使得AI真正成为一个可以7x24小时并行工作的“数字员工”,彻底打破了“AI必须在你视线内操作”的传统障碍,让用户能够将耗时、重复乃至超出自身能力范围的任务,“外包”给这个高效的云端分身。

在技术层面,过去许多Agent的训练主要依赖于监督微调(SFT),即模仿人类专家的操作轨迹。然而,这种方法的固有缺陷是“泛化能力差”——AI只能复刻其见过的操作模式,对于全新的场景或界面改动,往往表现得手足无措。为使Agent在复杂多变的真实环境中(例如数千个并发的手机、电脑、浏览器环境)真正具备独立完成任务的能力,AutoGLM团队创新性地采用了端到端在线强化学习(Online Reinforcement Learning)的技术路线。

该技术的核心思想在于:在经过少量专家数据进行“冷启动”后,模型在数千个并行的真实云环境中,能够像人类一样进行“试错”与探索。系统不再被动地告知模型“下一步应该点击何处”,而是仅在任务最终成功完成时,给予一个明确的“成功”奖励信号(Reward)。模型必须通过自主探索,逐步发现最优的决策路径,从而实现从模仿到自主决策的质变。这对工程系统构成了巨大挑战,需要一套能够同时调度和监控数千台云电脑与云手机的庞大且稳定的基础设施。

智谱在强化学习方面取得了一系列突破性成果:在电脑端,提出了API-GUI协同范式(ComputerRL),旨在提升数据多样性与Agent的泛化能力;在移动端,创新了难度自适应强化学习方法(MobileRL),以确保复杂任务的执行稳定性;同时,通过交叉采样等机制,有效解决了多任务训练中普遍存在的不稳定问题(AgenRL)。这些具体的技术创新共同构成了AutoGLM在复杂多变环境下实现高任务成功率的底层技术保障。

智谱披露的数据显示,通过在线强化学习,AutoGLM的任务成功率相较于冷启动阶段提升了165%,其中超过66%的成功率增益直接来源于这一先进的训练机制。这验证了“只要能提供足够好的‘环境(Environment)’和‘奖励(Reward)’,现有算法几乎可以优化任何任务”的观点,其核心瓶颈已转向如何构建可规模化的验证与反馈环境。这种“模型即Agent”的理念,也体现在其底座模型上。GLM-4.5和GLM-4.5V从预训练阶段即针对Agent任务进行了深度优化,被誉为“Agentic Language Model”。

原生设计使得AutoGLM在多个公开基准测试中表现卓越。例如,在考察电脑操作能力的OSWorld Benchmark中,AutoGLM取得了48.1分,超越了包括ChatGPT Agent和Anthropic在内的诸多模型。技术路线的先进性,不仅带来了性能上的飞跃,更在商业可行性上实现了重大突破——大幅度降低了运营成本。传统依赖第三方大模型API构建的Agent,执行一次复杂任务(如深度研究)的成本可能高达3-5美元。而AutoGLM凭借自研模型和一体化架构,将包含模型调用和虚拟机资源的单次任务成本,压缩至约0.2美元(约1.5元人民币),这一成本已与谷歌单次搜索约0.02美元的成本相差不到一个数量级。这种数量级的成本降低,为AutoGLM向所有C端用户开放奠定了坚实基础,并为其成为“超级应用”提供了广阔潜力。

四、超越工具范畴:Agent生态的未来愿景

通过为Agent提供独立的云端运行环境和基于GLM-4.5/4.5V的强大模型能力,AutoGLM的定位已超越了单一的效率工具,开始构建一个连接多设备和多服务的广阔生态系统。其未来发展潜力体现在以下几个方面:

- 产品能力的深度拓展:除了已演示的跨应用操作,AutoGLM的云电脑未来目标是支持Office、Photoshop等更专业的生产力工具,从而覆盖更广泛的办公与创意场景。即将上线的“定时任务”功能,更是AI Agent从“被动响应”迈向“半主动规划”的关键一步。想象一下,Agent可以自动在每天早晨总结老板的未读邮件并发送摘要到您的微信,或在工作日上午10点自动在多个平台比价并下单您常喝的咖啡,这相当于拥有一位全天候的虚拟秘书。

- 赋能硬件生态的革新:当前诸多创新型AI硬件,如智能眼镜、Pin类设备等,普遍面临算力、续航和交互的“不可能三角”困境。在微型设备上堆叠重系统与大电池,往往导致用户体验不佳。AutoGLM提出的解决方案是让这些端侧硬件实现“轻量化”,仅负责感知和指令发起,而将复杂的应用操作和任务执行全部交由强大的云端Agent完成。例如,当智能体重秤检测到用户体重超标时,云端Agent会自动触发下单代餐;当气体传感器检测到鞋柜中氨气或硫化氢浓度超标时,Agent则会自动下单除臭脚垫。这勾勒出了一条相对完整的“物理传感器 → 云端Agent → 现实世界服务”的闭环链路,使Agent真正实现了对物理世界的连接与操控,极大地拓展了AI硬件的应用边界。

- 重塑互联网流量形态:传统互联网的流量增长受限于用户的“注意力上限”——一天只有24小时,用户使用一个App就意味着减少了使用另一个App的时间。Agent的出现创造了一种全新的流量形态:并行且由需求驱动。当用户只有一个单线程的注意力时,可以派遣无数个并行的Agent,帮助研究旅行攻略、对比全网商品价格、筛选工作资料等。这种由AI代理人类去使用服务的模式,有望极大扩充整个互联网的有效流量池。更重要的是,这种流量往往是带有明确“成交意图”的高质量流量,其商业价值相对更高。

五、展望AGI:人机协作的无限可能

在分享会的尾声,刘潇提出了一个关于AGI(通用人工智能)的阶段性定义,他称之为“AGI的下限”:当一个Agent能够自主稳定地运行一整天(24小时),作为您的同事或秘书,协同完成工作与生活中的各项任务,使您的综合效率提升超过2倍时,AGI的曙光便已初步显现。AutoGLM 2.0的此次迭代,尽管距离这个“下限”尚有一定距离,仍处于其早期发展阶段,对指令的理解可能仍显初级,且存在部分待优化的细节,但通过构建“云端分身”这一核心架构,它无疑正在为Agent实现“独立行走”铺平道路。

从同步操作转向异步委托,不仅是人机协作范式的一次深刻转变,更是未来个人竞争力重构的起点。未来的个体将不再是孤立的劳动者,而是“自身能力+N个AI智能体”的复合体。用户只需通过简单的指令,即可指挥多个AI Agent并行完成海量任务,从而从根本上改变个人处理日常事务和工作的方式。可以预见,一个只需动动嘴,便有无数数字分身为我们打理数字世界的未来,正加速向我们走来,展现出人机协作的无限可能。